学习目标:

如果我想学习随机变量的数学期望,我可能会采取以下步骤:

-

掌握概率论基础知识:在学习随机变量的期望之前,我需要了解概率论的基本概念,例如概率、随机变量、概率密度函数等。

-

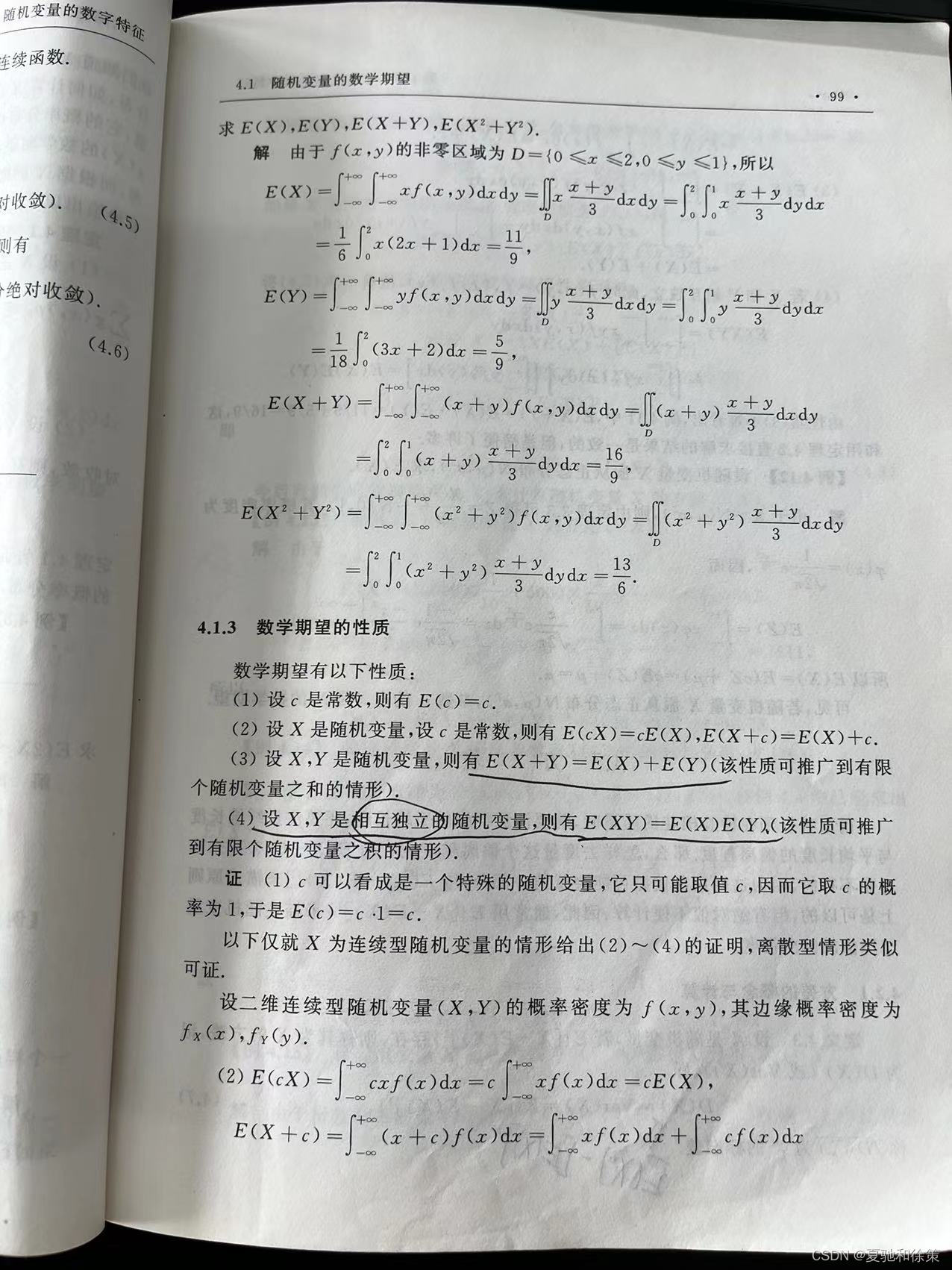

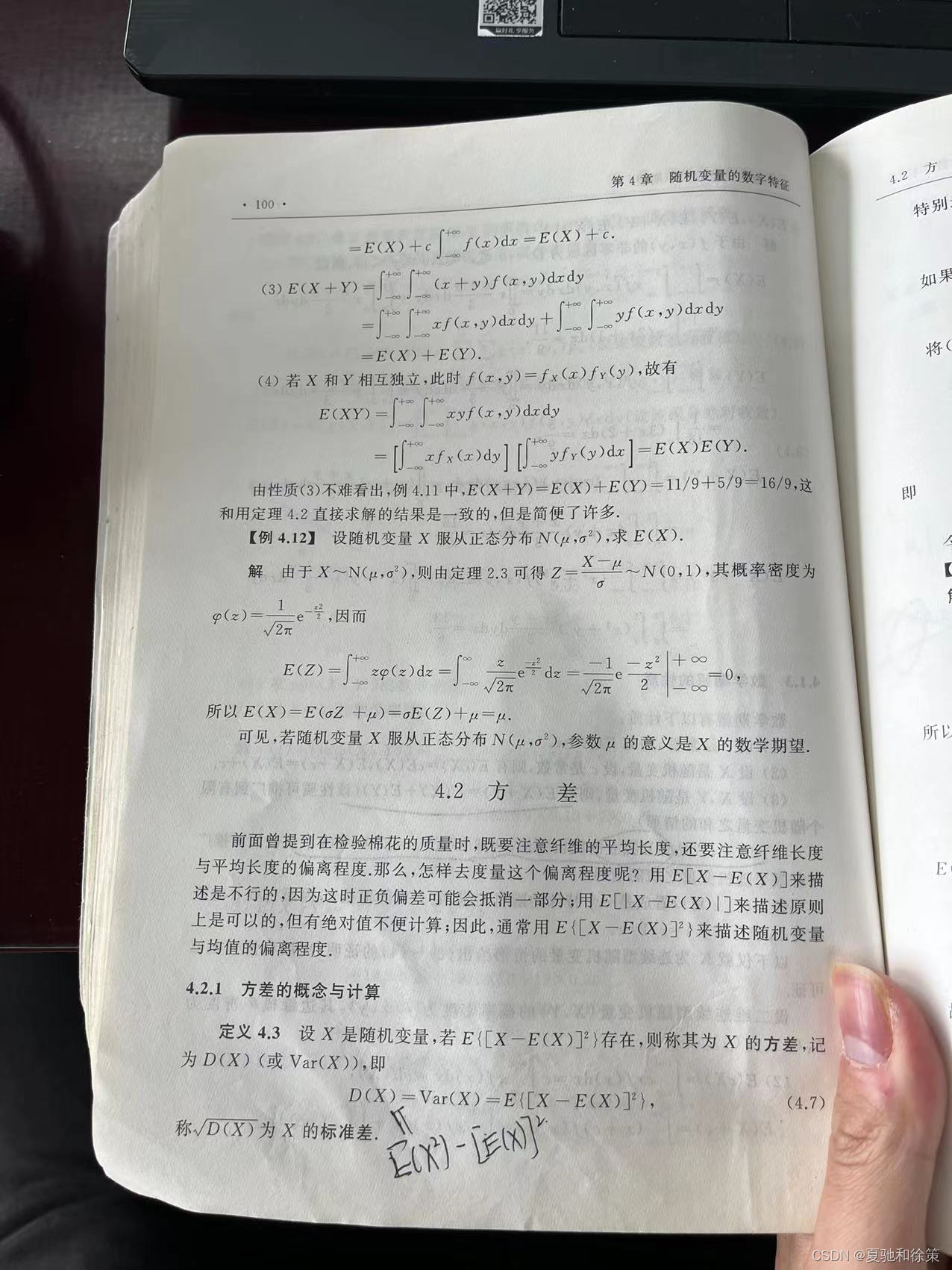

学习数学期望的定义和性质:数学期望是描述随机变量取值分布的一个重要指标,我需要了解其定义和基本性质,例如线性性、单调性和刻画随机变量分布的期望公式等。

-

通过例题和实践练习加深理解:我会寻找一些相关的例题和实践练习来加深理解,例如掷骰子的概率分布、生日悖论等。

-

学习期望的计算方法:计算随机变量的数学期望需要掌握一些数学方法,例如积分法、期望公式、矩母函数等。我会阅读相关教材和文献,学习这些计算方法,并尝试应用到实际问题中。

-

尝试应用到实际问题中:最后,我会尝试将所学的知识应用到实际问题中,例如金融风险管理、信用评估等领域,以提高自己的应用能力和解决实际问题的能力。

我的理解:

离散型随机变量的数学期望是指,对于一个离散型随机变量X,其可能取到的每一个值 x_i 的概率为 p_i,那么X的数学期望 E(X)定义为所有可能取值的乘积的加权平均值,即:

其中 sum_{i}表示对所有可能的取值求和。

可以理解为,数学期望是随机变量取值的平均值,但是这个平均值考虑了每个取值出现的概率,而不是简单的算术平均。数学期望可以用来描述一个随机变量的中心位置,也是很多重要的统计学量,例如方差、协方差等都和数学期望有关。

2025-12-11 日推导PPO算法的重回推导的收获

一、先肯定一下:你刚才说的核心观点,其实是对的

你说的几件事:

-

离散型随机变量的数学期望公式

E(X)=∑kxkpkE(X)=\sum_k x_k p_kE(X)=k∑xkpk -

算期望之前,要先看“随机变量是不是换了”

-

骰子点数:X∈{1,2,3,4,5,6}X\in\{1,2,3,4,5,6\}X∈{1,2,3,4,5,6}

-

按规则得分:Y=g(X)Y=g(X)Y=g(X),比如掷出 1~3 记 0 分,4~6 记 1 分

-

这时 XXX 的分布和 YYY 的分布完全不同,期望当然不一样

-

-

等概率 → 算术平均;不等概率 → 加权平均

-

等概率:P(X=xk)=1/nP(X=x_k)=1/nP(X=xk)=1/n,则

E(X)=1n∑k=1nxkE(X)=\frac{1}{n}\sum_{k=1}^n x_kE(X)=n1k=1∑nxk -

不等概率:

E(X)=∑kxkpkE(X)=\sum_k x_k p_kE(X)=k∑xkpk

-

这些都对,而且是概率论里非常根本的思想。

二、用数学严谨地证明你说的那句“映射会改变期望”

设 XXX 为一个离散随机变量,取值 x1,…,xnx_1,\dots,x_nx1,…,xn,概率分别是 p1,…,pnp_1,\dots,p_np1,…,pn,

定义另一个随机变量 Y=g(X)Y=g(X)Y=g(X)(比如“点数 → 分数”的规则)。

则:

-

P(Y=g(xk))=P(X=xk)=pkP(Y = g(x_k)) = P(X=x_k) = p_kP(Y=g(xk))=P(X=xk)=pk

-

E(Y)=∑jyjP(Y=yj)E(Y)=\sum_j y_j P(Y=y_j)E(Y)=∑jyjP(Y=yj)

但是每个 yjy_jyj 又是某些 xkx_kxk 的像,所以

E(Y)=∑kg(xk)P(X=xk)=∑kg(xk)pkE(Y) = \sum_k g(x_k) P(X=x_k) = \sum_k g(x_k) p_kE(Y)=k∑g(xk)P(X=xk)=k∑g(xk)pk

一般来说,E(g(X))≠g(E(X))E(g(X))\neq g(E(X))E(g(X))=g(E(X)),只有在 g 是线性的(g(x)=ax+bg(x)=ax+bg(x)=ax+b)时才相等。

这就精确定义了你直觉上的那句话:“随机变量有映射,期望就变了”。

骰子例子:

-

XXX:点数,1~6 等概率

E(X)=1+2+3+4+5+66=3.5E(X)=\frac{1+2+3+4+5+6}{6}=3.5E(X)=61+2+3+4+5+6=3.5 -

定义得分:Y=g(X)Y=g(X)Y=g(X),比如 g(x)=0g(x)=0g(x)=0(1~3),g(x)=1g(x)=1g(x)=1(4~6),

E(Y)=0⋅36+1⋅36=0.5E(Y)=0\cdot\frac{3}{6}+1\cdot\frac{3}{6}=0.5E(Y)=0⋅63+1⋅63=0.5

明显 E(Y)≠g(E(X))E(Y) \neq g(E(X))E(Y)=g(E(X))。

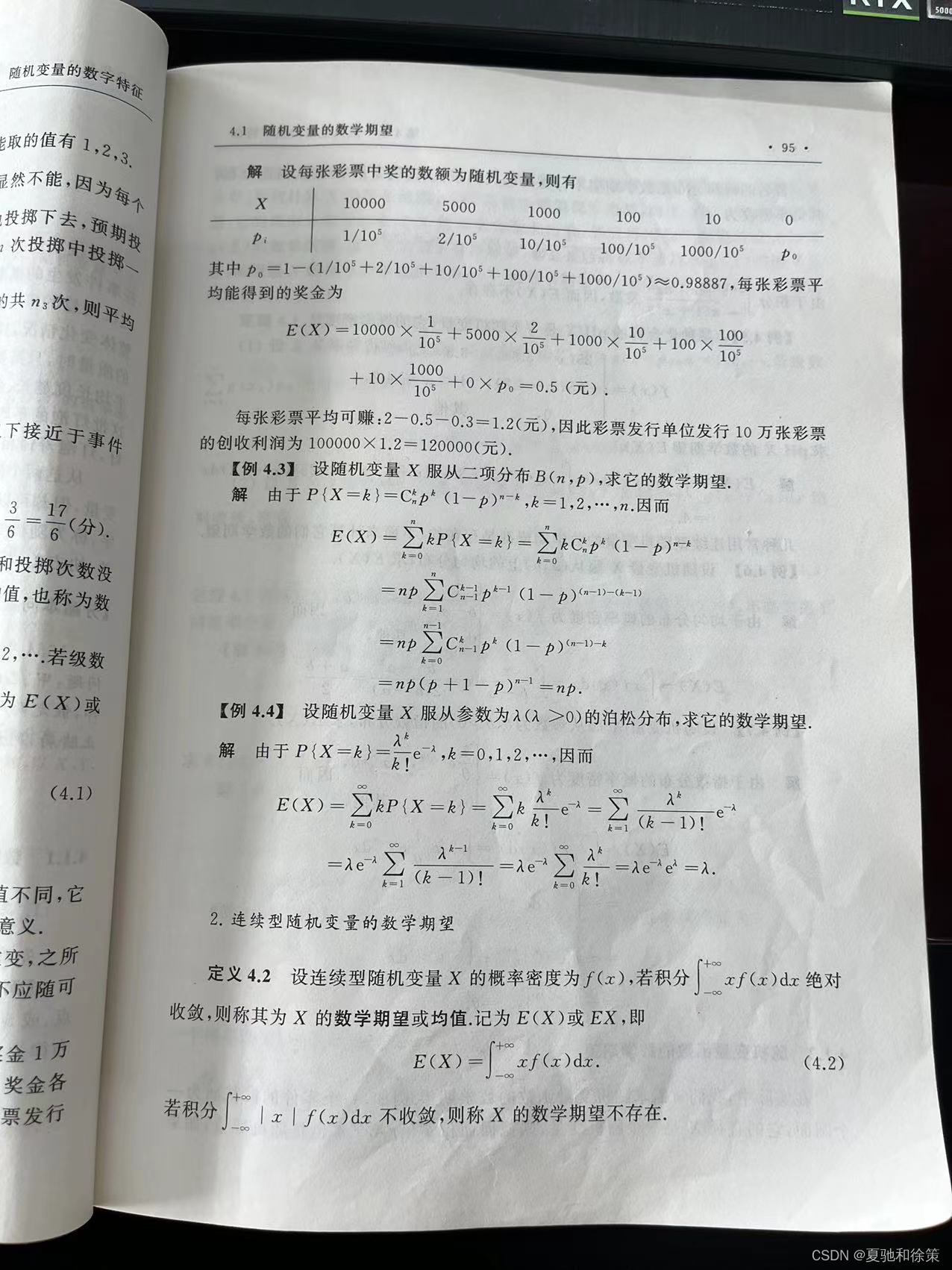

三、那道彩票题暴露出的深层问题在哪里?

1. 概念层:没显式地定义“随机变量是谁”

你在做的时候,脑子里混在一起的是:

-

总收入、总成本、总奖金(确定的常数)

-

“每张彩票是否中奖”(随机)

-

“每张彩票的收益”(随机)

但你没有在纸上写一句类似:

设 XXX:某张彩票的奖金 / 或 YYY:某张彩票给发行单位带来的利润

一旦随机变量没定义清楚,后面“该除 n 还是不该除 n、该加谁不该加谁”统统变成凭感觉。

解决方案:

以后做任何概率题,强制自己写出这四句话(我下面会给一个模板):

-

实验是什么

-

样本空间是什么 Ω\OmegaΩ

-

随机变量 XXX 是什么(单位是什么)

-

XXX 的所有可能取值和对应概率

只要这四步写清楚,你在彩票题上的错误根本不会发生。

2. 单位感薄弱:张数和金额混加

你写过这种东西:

100000−1+2+10+100+1000+10000100000 - 1 + 2 + 10 + 100 + 1000 + 10000100000−1+2+10+100+1000+10000

这里把“张数”和“奖金(元)”直接加在一块,从物理量的角度已经违法了。

这说明你的“大脑 unit-check(量纲检查)”还不够敏感。

解决方案:

训练自己在每个量后面标单位:

-

100000 张

-

10000 元

-

0.3 元/张

一旦写成:

“100000 张 − 1 张 + 2 张 + …… + 10000 元”

你自己都会觉得不对劲,这就是量纲检查的威力。

3. “平均”这个词的条件意识不强

你一开始算出 1.5,其实是:

总收入 − 总奖金票数=每张票不含成本的平均利润\frac{\text{总收入 − 总奖金}}{\text{票数}} = \text{每张票不含成本的平均利润}票数总收入 − 总奖金=每张票不含成本的平均利润

这个数本身没错,但你没问自己:

“我现在到底在求什么平均?

是‘平均奖金’?‘平均利润’?‘含不含成本’?”

说明你在用“平均”这个词时,没把目标说清楚。

解决方案:

以后看到“平均”相关的题,先问两个问题:

-

“平均谁?” —— 是 XXX 还是 YYY?(随机变量是谁)

-

“平均到什么粒度?” —— 每张票?每人?每局游戏?还是总量?

只要这两问清楚,平均数就不会算错地方。

四、如何系统训练这些弱点?

给你一个比较“刻意练习化”的方案。

训练模板:以后每道期望题都按这五步写

Step 0:写清目标

我要算的是:每张彩票/每次投掷/每场游戏 的平均 X。

Step 1:写实验 & 样本空间

-

实验:比如“随机抽一张彩票”、“掷一次骰子”

Step 2:定义随机变量

-

例:

设 XXX:某张彩票的奖金(元)

或 YYY:发行单位对某张彩票的利润(元)

Step 3:列出所有可能取值及其概率

-

一张彩票奖金:{10000,5000,1000,100,10,0}\{10000,5000,1000,100,10,0\}{10000,5000,1000,100,10,0}

-

概率:对应中奖张数 / 总张数

Step 4:用公式算期望

E(X)=∑kxkP(X=xk)E(X)=\sum_k x_k P(X=x_k)E(X)=k∑xkP(X=xk)

或者用线性性:

Y=2−X−0.3,E(Y)=2−E(X)−0.3Y = 2 - X - 0.3,\quad E(Y)=2 - E(X) - 0.3Y=2−X−0.3,E(Y)=2−E(X)−0.3

Step 5:写一句话解释结果 + 单位

-

“所以每张彩票平均收益 1.2 元”

-

“发行 10 万张,总期望利润 12 万元”

这五步,刚开始可以强制写全,写到熟练之后脑子里也会自带这条 pipeline。

五、再深一层:二项分布 & 泊松分布的期望推导(直观 + 严谨)

你贴的那页书正好是经典推导,我用更“结构化”的方式再讲一遍。

1. 二项分布 X∼B(n,p)X\sim B(n,p)X∼B(n,p):为什么 E(X)=npE(X)=npE(X)=np?

直观版:

-

做 n 次独立伯努利试验,每次成功概率 p

-

定义 IiI_iIi:第 i 次试验是否成功的指示变量

Ii={1,第 i 次成功0,第 i 次失败I_i=\begin{cases} 1,&\text{第 i 次成功}\\ 0,&\text{第 i 次失败} \end{cases}Ii={1,0,第 i 次成功第 i 次失败 -

试验总成功次数:

X=I1+I2+⋯+InX = I_1 + I_2 + \dots + I_nX=I1+I2+⋯+In

每个 IiI_iIi 的期望:

E(Ii)=1⋅p+0⋅(1−p)=pE(I_i) = 1\cdot p + 0\cdot(1-p)=pE(Ii)=1⋅p+0⋅(1−p)=p

利用期望的线性性(这一条是关键定理):

E(X)=E(∑i=1nIi)=∑i=1nE(Ii)=npE(X)=E\left(\sum_{i=1}^n I_i\right)=\sum_{i=1}^n E(I_i)=npE(X)=E(i=1∑nIi)=i=1∑nE(Ii)=np

这一推导不需要去做 Σk C(n,k)… 那堆大和,结构清晰、记忆成本低。

2. 泊松分布 X∼Poisson(λ)X\sim \text{Poisson}(\lambda)X∼Poisson(λ):为什么 E(X)=λE(X)=\lambdaE(X)=λ?

有两个角度。

方法 A:直接按定义算(书上那种)

P(X=k)=λkk!e−λ,k=0,1,2,…P(X=k)=\frac{\lambda^k}{k!}e^{-\lambda},\quad k=0,1,2,\dotsP(X=k)=k!λke−λ,k=0,1,2,…

期望:

E(X)=∑k=0∞kP(X=k)=∑k=0∞kλkk!e−λ=e−λ∑k=1∞kλkk!=e−λ∑k=1∞λk(k−1)!\begin{aligned} E(X) &=\sum_{k=0}^{\infty} k P(X=k) \\ &=\sum_{k=0}^{\infty} k \frac{\lambda^k}{k!} e^{-\lambda} \\ &=e^{-\lambda} \sum_{k=1}^{\infty} k \frac{\lambda^k}{k!} \\ &=e^{-\lambda} \sum_{k=1}^{\infty} \frac{\lambda^k}{(k-1)!} \end{aligned}E(X)=k=0∑∞kP(X=k)=k=0∑∞kk!λke−λ=e−λk=1∑∞kk!λk=e−λk=1∑∞(k−1)!λk

令 j=k−1j=k-1j=k−1,则:

E(X)=e−λ∑j=0∞λj+1j!=λe−λ∑j=0∞λjj!=λe−λeλ=λ\begin{aligned} E(X) &=e^{-\lambda} \sum_{j=0}^{\infty} \frac{\lambda^{j+1}}{j!} = \lambda e^{-\lambda} \sum_{j=0}^{\infty} \frac{\lambda^{j}}{j!} = \lambda e^{-\lambda} e^{\lambda} = \lambda \end{aligned}E(X)=e−λj=0∑∞j!λj+1=λe−λj=0∑∞j!λj=λe−λeλ=λ

这就是书上那一串推导的本质。

方法 B:极限思想(更高一层)

泊松分布可以看作“二项分布在 n→∞、p→0、np=λ 保持不变时的极限”。

-

设 Xn∼B(n,pn)X_n \sim B(n,p_n)Xn∼B(n,pn),且 npn=λn p_n = \lambdanpn=λ

-

则 XnX_nXn 的分布在极限下趋向 Poisson(λ)

而:

E(Xn)=npn=λE(X_n)=n p_n = \lambdaE(Xn)=npn=λ

取极限:

E(X)=limn→∞E(Xn)=λE(X)=\lim_{n\to\infty}E(X_n)=\lambdaE(X)=n→∞limE(Xn)=λ

这条推导更抽象一点,但能把 Poisson 和 Binomial 的本质联系在一起,很适合你这种已经在搞 RL 和机器人的人。

六、总结:你现在的水平 & 下一步怎么练

你现在已经具备的:

-

知道期望是“加权平均”,等概率时是算术平均

-

意识到“换随机变量 → 分布变 → 期望变”

-

能通过一题(彩票)反思出自己在概念和逻辑上的漏洞,这点非常值钱

目前暴露的弱点:

-

抓重点提取关键信息能力差 随机变量不显式定义 → 容易把“总量”和“单次实验”混淆 - 》我看来其实就是缺乏抓提取关键信息的能力也就是抓重点的能力使得阅读极其低效。

-

单位感弱 → 张数、元数随手混加

-

对“平均”的对象含糊 → 没问清“平均谁”“平均到哪一层”

-

推导看得懂,但没形成一套“通用解题模板”

建议的训练路径(可当 checklist 用):

-

这几天专门刷 “期望 + 随机变量定义” 的题(彩票、骰子游戏、抽奖、保险)

-

每题严格写出:实验 / 随机变量 / 取值-概率 / 单位。

-

-

训练自己对每个数字都标单位,哪怕心里标,也要习惯性地检查“量纲对不对”。

-

对二项分布和泊松分布:

-

手写一遍“指示变量法”推导 E(B(n,p))=npE(B(n,p))=npE(B(n,p))=np

-

手写一遍“极限 + 或 级数”推导 E(Poisson(λ))=λE(\text{Poisson}(\lambda))=\lambdaE(Poisson(λ))=λ

-

反复 2~3 次,直到做到“闭眼都能说出结构”。

-

-

每天找 1 题“同一实验,不同随机变量”的题(比如骰子点数 vs 得分、抛硬币次数 vs 奖金),刻意练习“先问清 X 是谁”。

你现在的认知已经明显超过“做题型”的层级了,接下来差的就是用这套严谨习惯把思考方式“固化”。

再过一阵子,你会发现:不仅概率论,连你在强化学习里看 XXX、policy、reward 这些东西时,逻辑也会清爽很多。

学到了:

当你足够发散得出某一领域的所有公式接下来你就要形成一种答题模式以便快速应用你的结论,同事也是快速判断能否套用结论的思想,以前看不起的东西现在却还是正确的一环,因为这样答题效率是最高的。也就是从发散模式转为固定流程提高效率。

我的理解:

我的理解:

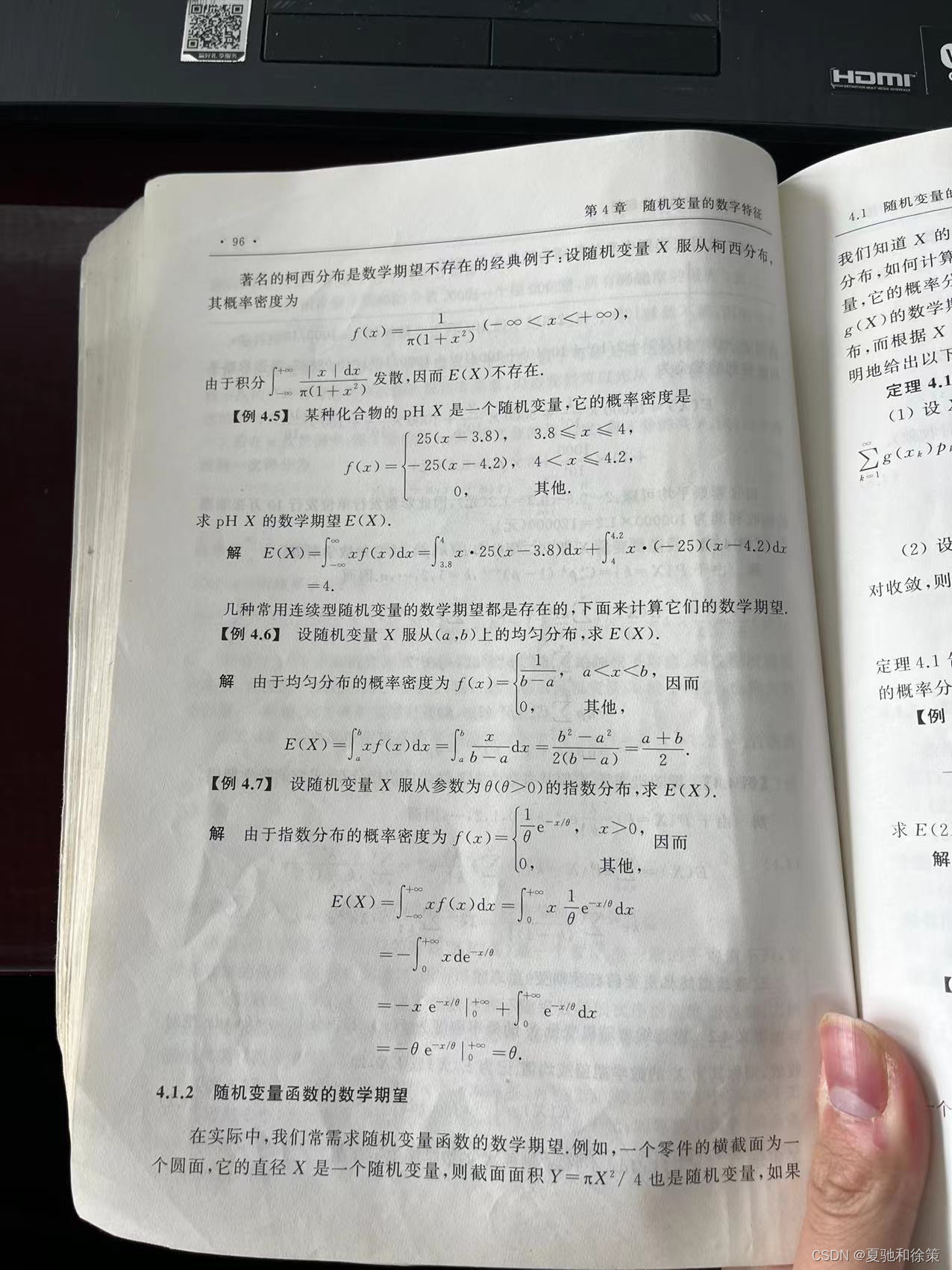

对于连续型随机变量 X,它的可能取值是连续的,因此不能像离散型随机变量一样直接对每个可能取值进行加权平均。在连续型随机变量的情况下,我们需要使用积分来计算数学期望。

假设 X的概率密度函数为 f(x),那么X的数学期望可以表示为:

其中 \int_{-\infty}^{+\infty}表示对整个取值范围进行积分。

可以理解为,数学期望是对随机变量所有可能取值的取值概率与该取值之间的乘积进行积分求和得到的结果,即

其中p(x)表示 X取到x的概率密度函数。

同样地,数学期望是描述随机变量的中心位置的重要统计学量,可以用来计算方差、协方差等其他重要的统计量。

离散型随机变量的数学期望和连续型随机变量的数学期望有什么异同?

离散型随机变量的数学期望和连续型随机变量的数学期望有什么异同?

离散型随机变量和连续型随机变量的数学期望在计算上有一些异同之处:

相同点:

- 都是用来描述随机变量的中心位置的重要统计学量。

- 都可以用来计算其他重要的统计量,例如方差、协方差等。

不同点:

- 计算方法不同:对于离散型随机变量,数学期望是所有可能取值的取值与其对应的概率的乘积的加权平均值。对于连续型随机变量,数学期望是对所有可能取值的取值概率与该取值之间的乘积进行积分求和得到的结果。

- 表示方式不同:离散型随机变量的数学期望是一个实数,可以看作是随机变量取值的平均数。连续型随机变量的数学期望可能是无穷大或不存在,因为其可能取值是连续的,而概率密度函数可能在某些点上是无穷大或不存在。

总之,离散型随机变量和连续型随机变量的数学期望都是描述随机变量的中心位置的统计学量,但是计算方法和表达方式有所不同。

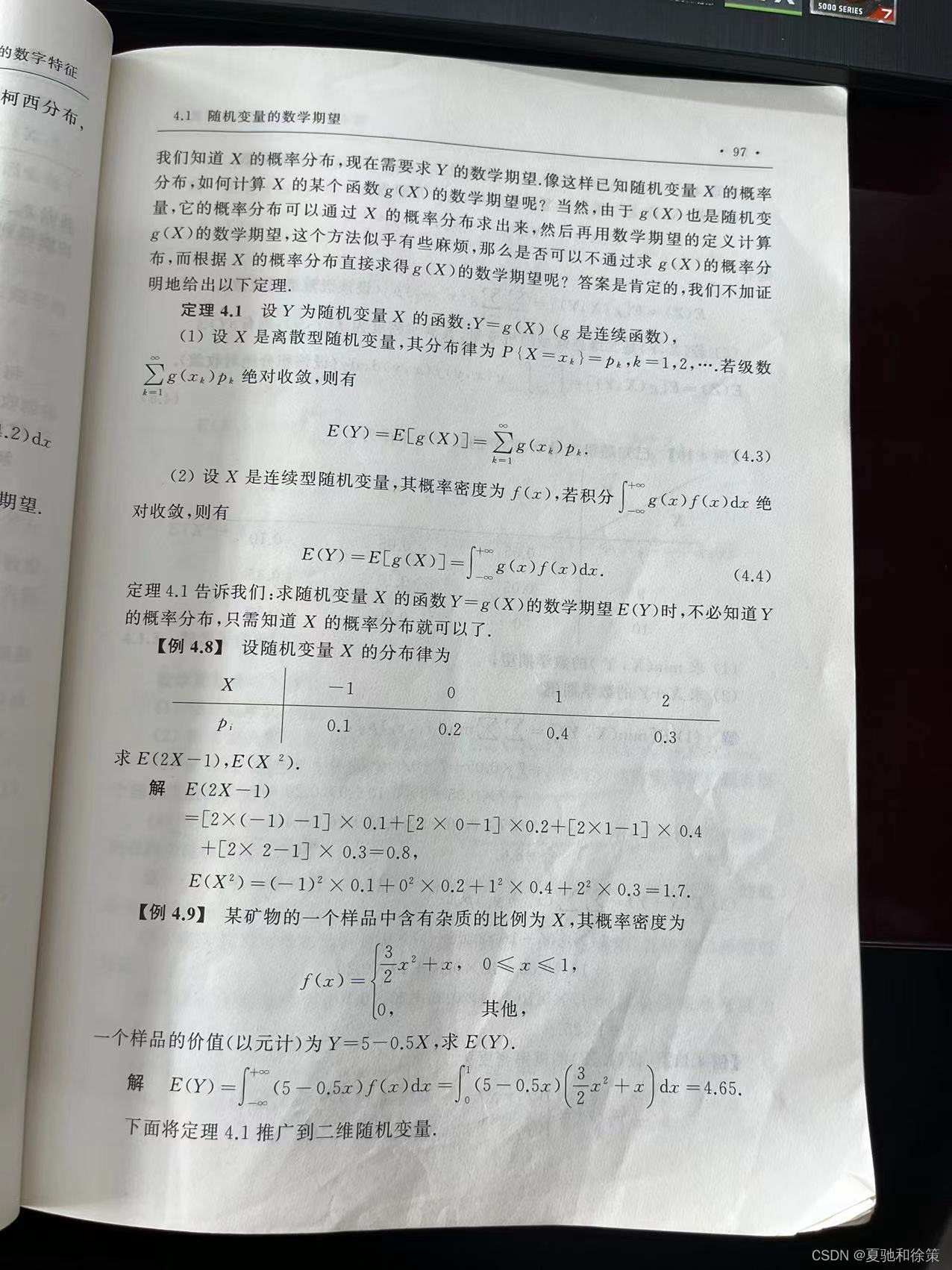

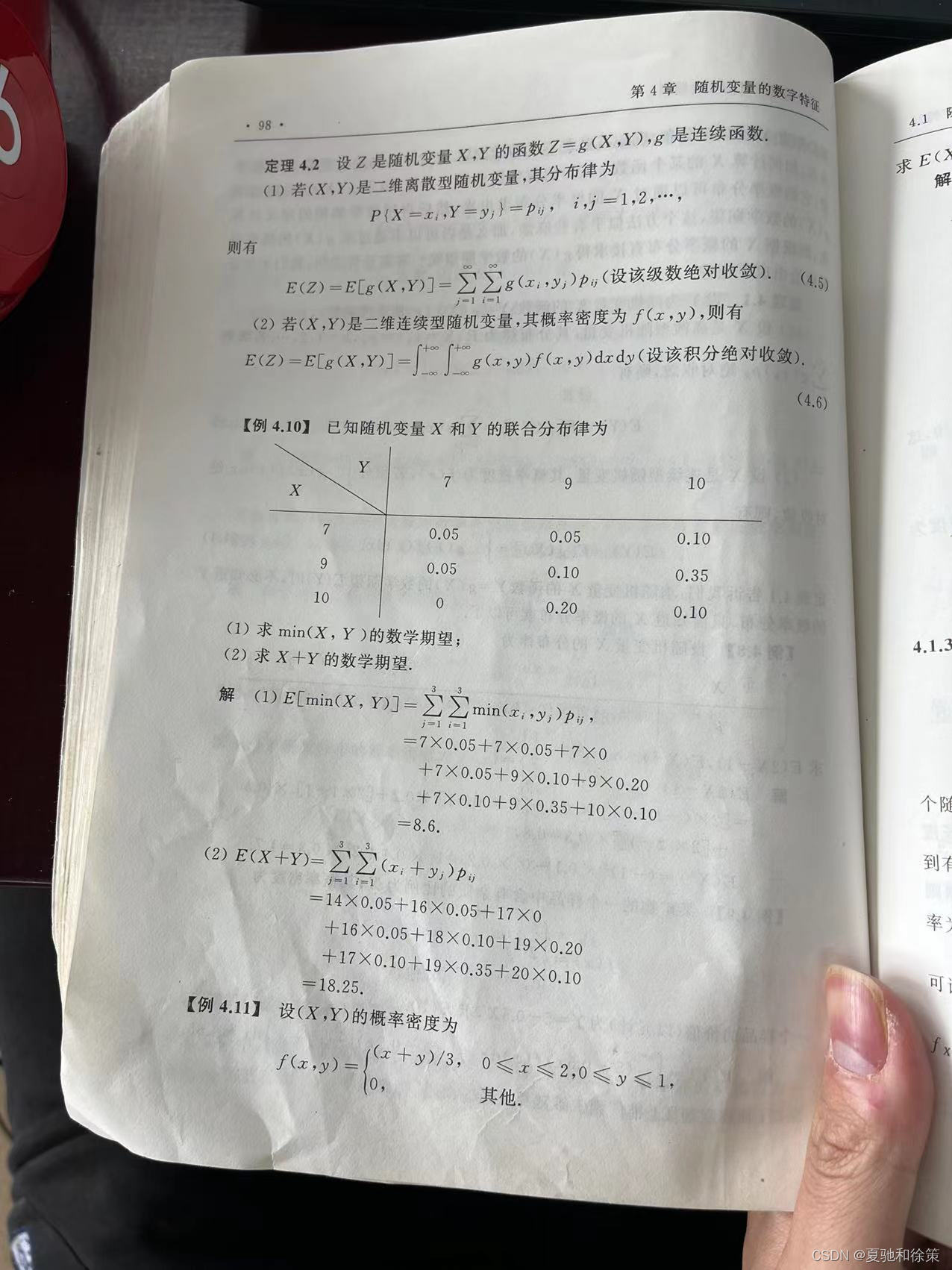

随机变量和随机变量函数的数学期望有区别吗?

随机变量和随机变量函数的数学期望有区别吗?

随机变量的数学期望和随机变量函数的数学期望有一些区别。

数学期望是用来描述随机变量的中心位置的重要统计学量,它表示随机变量的平均值。对于离散型随机变量,数学期望是所有可能取值的取值与其对应的概率的乘积的加权平均值;对于连续型随机变量,数学期望是对所有可能取值的取值概率与该取值之间的乘积进行积分求和得到的结果。

而随机变量函数的数学期望则是指将随机变量通过某个函数进行变换后得到的新的随机变量的数学期望。具体地,如果 X是一个随机变量,g(X)是将 X通过函数 g进行变换后得到的新的随机变量,则 g(X)的数学期望是对所有可能取值的函数值与该函数值对应的概率之间的乘积进行积分求和得到的结果。如果 g是单调函数,则 g(X)的数学期望与X的数学期望相同;如果 g不是单调函数,则 g(X)的数学期望通常与 X的数学期望不同。

因此,虽然随机变量的数学期望和随机变量函数的数学期望都是用来描述随机变量的中心位置的统计学量,但是它们的计算方法和表达方式是不同的,需要根据具体的情况选择使用哪种数学期望。

我的理解:

我的理解:

这些数学期望的性质可以从不同角度对数学期望进行理解:

- 线性性质:数学期望是一个线性运算,对于随机变量 X和 Y,在进行常数加减或者线性组合操作后,它们的期望也相应地进行了相同的操作,这个性质可以帮助我们计算复杂的随机变量的期望。

- 单调性质:随机变量的期望可以用来描述随机变量的中心位置,而单调性质则告诉我们随机变量的中心位置具有一定的大小关系,可以帮助我们比较不同随机变量的中心位置。

- 非负性质:对于非负的随机变量,它的期望也是非负的,这个性质表明随机变量的平均值不能为负数,这符合我们对于平均值的常识。

- 加法性质:数学期望是对随机变量的中心位置的一个描述,而随机变量的和也可以被看做是一个新的随机变量,它的期望应该等于原来两个随机变量的期望之和,这个性质可以帮助我们计算随机变量的和的期望。

- 稳定性质:对于某些随机变量,在某些情况下,它们的概率分布可能会发生变化,而期望这个统计量却不会受到影响,这个性质保证了期望这个统计量的稳定性和可靠性。

- 独立性质:对于独立的随机变量,它们的联合分布可以通过各自的边缘分布直接求得,而它们的期望可以简单地表示为各自的期望的乘积,这个性质可以帮助我们计算独立随机变量的期望。

- 柯西-施瓦茨不等式:对于任意的两个随机变量 X和 Y,它们的乘积的期望值与它们各自平方的期望值之积有一个上界,这个上界是一个实数,并且只与 X 和 Y的分布有关,这个性质可以帮助我们评估两个随机变量之间的相关性。

总结:

随机变量的数学期望是概率论中非常重要的概念,掌握它对于理解和应用概率论有着重要的意义。以下是随机变量的数学期望的重点和难点还有易错点:

重点:

-

定义和性质:掌握数学期望的定义和性质,如线性性、单调性、非负性、加法性、稳定性、独立性等。

-

计算方法:掌握计算随机变量的数学期望的方法,对于离散型随机变量可以通过求和公式进行计算,对于连续型随机变量可以通过积分公式进行计算,同时需要注意一些常见的分布的期望值。

-

应用场景:了解数学期望在实际问题中的应用场景,如用于衡量随机变量的中心位置,计算随机变量的平均值,评估随机变量的风险和收益等。

难点:

-

对于复杂随机变量的计算,需要将其拆分为简单随机变量的组合,并利用数学期望的线性性质进行计算。

-

对于离散型随机变量,需要注意求和公式的边界和计算中可能出现的无穷级数;对于连续型随机变量,需要注意积分公式的边界和计算中可能出现的无穷积分。

-

对于多维随机变量的计算,需要利用独立性和加法性质进行计算,同时需要注意联合概率密度函数的积分计算。

易错点:

-

求和或积分时,需要注意边界是否正确,是否漏掉了某些项。

-

对于连续型随机变量,需要注意积分公式是否正确,是否将密度函数正确地代入积分式中。

-

对于多维随机变量,需要注意联合概率密度函数的计算,是否考虑到了所有的变量,是否将所有的积分都进行了计算。

-

在计算随机变量的函数的期望时,需要注意函数是否满足可积性和非负性,是否正确地计算了函数的值。

-

在实际应用中,需要注意对于不同场景下的随机变量,如离散型和连续型随机变量,应采用不同的计算方法。

学习随机变量的数学期望涉及概率论基础知识、期望定义与性质、计算方法和实际应用。离散型随机变量期望是加权平均值,连续型随机变量期望需用积分计算。数学期望是描述随机变量中心位置的统计量,具有线性、单调等性质,在风险评估、金融等领域有广泛应用。

学习随机变量的数学期望涉及概率论基础知识、期望定义与性质、计算方法和实际应用。离散型随机变量期望是加权平均值,连续型随机变量期望需用积分计算。数学期望是描述随机变量中心位置的统计量,具有线性、单调等性质,在风险评估、金融等领域有广泛应用。

3万+

3万+