由梯度(偏微分)和学习速率来更新新的训练参数,Gradient为Loss等高线的法线方向,注意负号

2)Learning Rate的调节方法

1)画出loss的更新曲线

2)自动调Learning Rate(与目标远的时候调高learning Rate,近的时候调低Learning Rate)

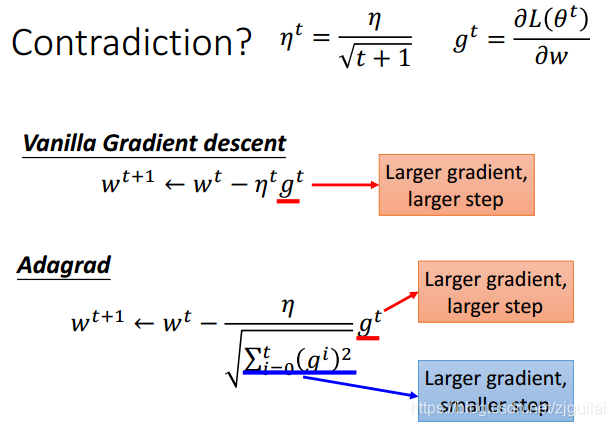

3)针对每个不同的参数设置不同的learing Rate:(Adagrad):每次更新w参数的时候在梯度上除以之前迭代所求出的梯度的均方根,等同二次微分

3) Feature Scaling (参数因子的值域范围一样)

标准正则化:(x-u)/sigma

4)求在局部某点临近范围内的最小Loss通过对factor求全微分

梯度最大的问题是会陷入马鞍线上的点(saddle),局部最优点,非常平缓的地带

2655

2655

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?