自然语言理解与生成问题中的深度学习:梯度下降与激活函数

1. 梯度下降计算

1.1 代码部分与梯度下降引入

首先我们来看代码部分,之后会进入核心的梯度下降计算环节。计算平方误差和的代码片段如下:

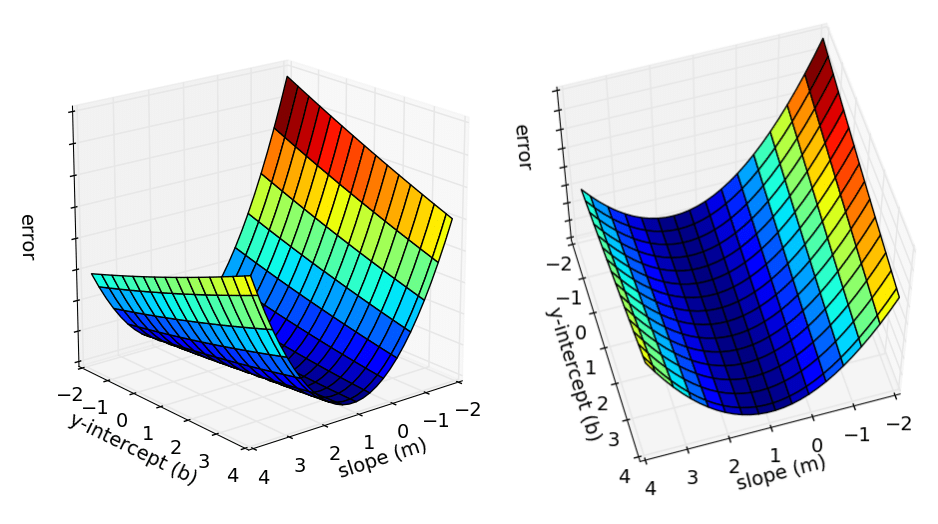

接下来我们进入梯度下降的计算。使用误差函数,我们能判断是否需要更新直线以得到最佳拟合直线,但如何更新直线正是本部分要探讨的内容。我们要思考如何最小化误差并得到最佳拟合直线。为了回答这个问题,我们先对梯度下降有个基本了解,在代码方面,我们只剩下最后一个函数 gradient_descent_runner() 了。参考下面这个用于理解梯度下降的 3D 图:

1.2 梯度下降的原理

这个 3D 图展示了斜率 m 、y 截距 b 和误差的所有可能值。x 轴是斜率值,y 轴是 y 截距,z 轴是误差值。我们的目标是找到误差最小的点。仔细观察图形会发现,曲线底部的误差值最小,这个误差最小的点在机器学习中被称为局部最小值。在复杂数据集中可能存在多个局部最小值,而这里我们的数据集简单,只有一个局部最

超级会员免费看

超级会员免费看

订阅专栏 解锁全文

订阅专栏 解锁全文

7312

7312

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?