问题:噪声矩阵Q,R 的确定,决定了系统的能否收敛,收敛速度。如何确定呢?

数学基础:https://wenku.baidu.com/view/0ba46c5280eb6294dc886c32.html

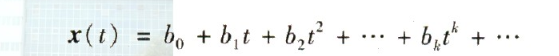

x 是关于t的函数, t 时刻开始, x(t) 泰勒展开为

t= 0, x(0)=bo

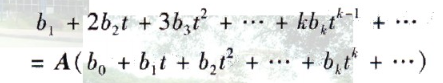

右边写成x(t+1)= x'=

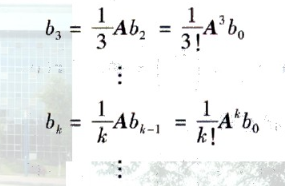

系统相同, 得到 b0*A=b1

带回,x(t),

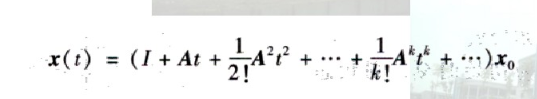

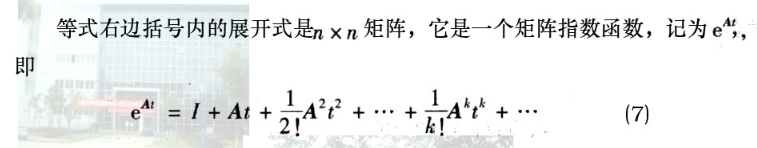

0--t 时间的状态转移矩阵为 括号内的数。可以记做

和 A 矩阵(动态矩阵)维度相同,如果是2*2, 如何表示状态误差呢?

和 A 矩阵(动态矩阵)维度相同,如果是2*2, 如何表示状态误差呢?

本文探讨了噪声矩阵Q和R在系统收敛及收敛速度中的关键作用,通过数学基础链接深入解析其确定方法,并利用泰勒展开和状态转移矩阵概念说明系统相同条件下的动态变化。

本文探讨了噪声矩阵Q和R在系统收敛及收敛速度中的关键作用,通过数学基础链接深入解析其确定方法,并利用泰勒展开和状态转移矩阵概念说明系统相同条件下的动态变化。

389

389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?