目录

基于ELM(Extreme Learning Machine)自编码技术的图像去模糊算法是一种基于深度学习的图像去模糊方法。该方法利用ELM自编码器的特性,通过对输入数据进行编码和解码,以重建清晰图像。

一、ELM自编码技术

ELM(Extreme Learning Machine)是一种单层前馈神经网络(SLFN)算法。它最早由南洋理工大学的黄广斌教授在2004年提出,其原理在于利用随机选取的权重和阈值来训练模型,相较于传统的BP神经网络,ELM的训练速度更快,同时减少了模型结构的复杂性。其特点是具有非常快的训练速度和良好的泛化性能。ELM自编码器是ELM的一种扩展,它由一个编码器和一个解码器组成,用于对输入数据进行编码和解码。编码器将输入数据编码成隐藏层的输出,解码器将隐藏层的输出解码为原始数据的近似值。基于ELM自编码技术的图像去模糊算法利用这一特性,通过训练一个ELM自编码器,以重建模糊图像中的清晰部分。ELM的原理是通过对单隐含层前馈神经网络(SLFN)的输入层进行随机权重赋值,然后使用正则化方法对输出权值进行优化,以得到最佳的权重矩阵。数学公式可以表示为:

首先,对输入数据进行标准化处理,即对每个输入特征进行归一化处理,使得它们具有零均值和单位方差。

然后,对标准化数据进行线性变换,生成隐藏层的输出,这一步是通过一个线性函数实现的,即:

H(x) = (xW+b)

其中,H是隐藏层的输出,x是输入数据,W是权重矩阵,b是偏置向量。

最后,对隐藏层的输出进行非线性变换,生成输出层的输出,这一步是通过一个激活函数实现的,常用的激活函数包括sigmoid函数、ReLU函数等。

- 在训练过程中,随机选取一些权重和阈值作为输入,通过多次迭代计算出最优的输出权值,使得网络的预测输出尽可能接近于真实值。

- 最后,利用训练好的模型进行预测时,只需要将输入数据输入到已经训练好的模型中,即可得到预测结果。

ELM算法具有快速、简单、易于实现等优点,同时在大规模数据处理中具有很高的应用价值。在算法实现上,ELM算法只需要进行一次矩阵乘法和一次矩阵求逆运算,因此训练速度非常快。同时,由于ELM算法不需要对数据进行复杂的预处理和特征提取,因此也具有很强的适应性。

另外,ELM算法还有一个重要的特点是可以避免过拟合问题。由于ELM算法采用的是单隐层前馈神经网络结构,因此可以避免因为过拟合而导致的泛化能力下降的问题。同时,由于ELM算法采用的是随机选取权重和阈值的方法进行训练,因此也可以在一定程度上避免过拟合问题。

总的来说,ELM算法是一种非常有前途的神经网络算法,它具有快速、简单、易于实现等优点,同时在大规模数据处理中具有很高的应用价值。在未来的人工智能领域中,ELM算法将会得到越来越广泛的应用和推广。

二、基于ELM自编码技术的图像去模糊算法原理

图像去模糊问题可以看作一个图像重建问题,即从模糊的图像中恢复出清晰的图像。基于ELM自编码技术的图像去模糊算法将模糊图像作为输入数据,通过ELM自编码器将其重建为清晰图像。

具体步骤如下:

- 数据准备:将模糊图像作为输入数据,对其进行预处理,如去噪、平滑等,以准备用于训练ELM自编码器。

- 训练ELM自编码器:使用已准备好的输入数据训练一个ELM自编码器,该自编码器由一个编码器和一个解码器组成。在训练过程中,通过最小化重构误差来优化网络参数。

- 图像去模糊:将模糊图像作为输入数据输入到训练好的ELM自编码器中,通过解码器的输出来获得去模糊后的图像。

基于ELM自编码技术的图像去模糊算法的数学公式可以表示为以下步骤:

- 定义输入数据:设输入的模糊图像为X,其中X = {x_1, x_2, ..., x_N},N为图像像素点的数量。

- 定义ELM自编码器:ELM自编码器由一个编码器f(·)和一个解码器g(·)组成,其中f(·)将输入数据映射到隐藏层,g(·)将隐藏层映射到输出层。

- 定义损失函数:重构误差可以表示为损失函数L(Y, g(f(X))),其中Y为原始输入数据X的重构结果。

- 定义优化目标:通过最小化损失函数L(Y, g(f(X)))来优化ELM自编码器的参数。

- 定义学习算法:使用随机梯度下降(SGD)算法来优化损失函数L(Y, g(f(X)))。

基于ELM自编码技术的图像去模糊算法的具体实现过程如下:

- 准备数据:使用一组模糊图像作为训练数据,对其进行预处理,以准备用于训练ELM自编码器。

- 初始化:初始化编码器和解码器的权重矩阵W_h和W_o,以及偏置向量b_h和b_o。

- 训练:通过最小化重构误差来训练ELM自编码器。具体来说,使用随机梯度下降算法来更新权重矩阵和偏置向量,以最小化损失函数L(Y, g(f(X)))。

- 去模糊:将模糊图像作为输入数据输入到训练好的ELM自编码器中,通过解码器的输出来获得去模糊后的图像。

三、MATLAB核心程序

x=imread('70.jpg');

x=rgb2gray(x);

subplot(121)

imshow(x)

xlabel('original image');

x=double(x);

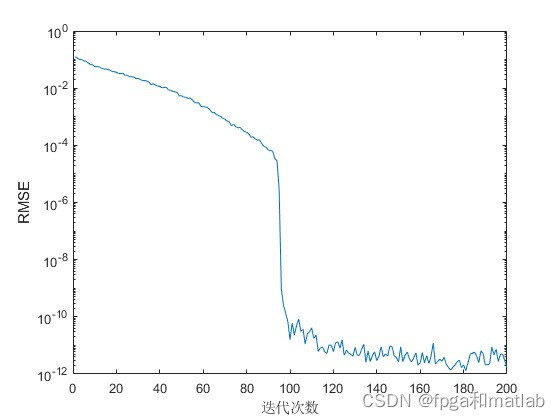

for i=1:200

number_neurons=i;% number of neurons

ActivF='sig';% activation function

%调用ELM自编码模型

[prefomance,B,Hnew]=ELM_AE(x,ActivF,number_neurons);

regenerated=Hnew*pinv(B');

subplot(122)

imshow(regenerated);

Tc=num2str(prefomance);

Tc= ['RMSE = ' Tc];

xlabel('regenerated')

title(Tc)

Tc2(i)=prefomance;

pause(0.01)

end

up2211四、仿真结果

525

525

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?