大家好,我是爱酱。本篇將會系统讲解协方差(covariance,又称共变异数)与相关系数(correlation coefficient,或简称correlation)的定义、公式、几何意义、实际案例和应用场景。内容适合初学者和进阶读者,分步解释,配合公式和可视化示例。

注:本文章含大量数学算式、详细例子说明及大量代码演示,大量干货,建议先收藏再慢慢观看理解。新频道发展不易,你们的每个赞、收藏跟转发都是我继续分享的动力!

一、协方差(Covariance)与相关系数(Correlation)简单介紹

名称定义

-

协方差:同時亦被称為“共变异数”,英文为covariance,常用符号为

或

。

-

相关系数:常被称为“相关系数”,英文为correlation coefficient,简称 correlation,常用符号为

或

。

协方差与相关系数在机器学习中的作用

要学习这两概念,最好先了解他们在机器学习中担任什么样的角色,有什么用途。

-

特征关系分析与特征选择

-

协方差和相关系数用于衡量特征之间的线性关系。

-

在特征选择阶段,相关系数常用于筛除高度相关(冗余)的特征,减少多重共线性,提高模型泛化能力。例如,若两个特征相关系数

,通常只保留一个。

-

-

降维与特征提取

-

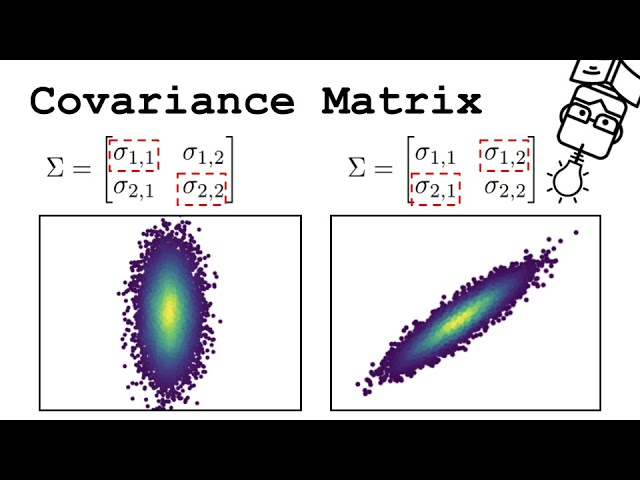

主成分分析(PCA)等降维算法核心就是对协方差矩阵(Covariance Matrix)做特征值分解,找到数据方差最大的方向,实现信息压缩和特征提取。

爱酱之前也做过主成分分析(PCA)的深入介绍文章,有兴趣的同学可以去看看!

主成分分析(PCA)文章传送门:

【AI深究】主成分分析(PCA)全网最详细全流程详解与案例(附大量Python代码演示)|数学原理、案例流程、代码演示及结果解读|几何意义与主成分选择、与LDA的对比、实际应用场景、工程建议与优缺点-优快云博客 -

协方差矩阵的特征向量即为主成分方向,特征值表示该方向上的方差大小。

-

-

异常检测与数据探索

-

通过分析协方差和相关系数,可以发现异常点或异常关系,辅助异常检测、数据清洗等。

-

例如,利用协方差矩阵计算马氏距离(Mahalanobis Distance),可检测多变量异常点。

-

-

回归与建模

-

在线性回归中,协方差用于衡量自变量与因变量的线性关系强度,相

-

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

与相关系数(correlation)是什麽?有什么区别?在机器学习中担任什么角色?|协方差矩阵、马氏距离、归一化|主成分分析PCA、代码实现与可视化、实际应用&spm=1001.2101.3001.5002&articleId=148829993&d=1&t=3&u=28f915b001d84df3a531a57ebba87d57)

1267

1267

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?