大家好,我是爱酱。本篇将会系统梳理XGBoost(eXtreme Gradient Boosting)的核心原理、算法细节、数学表达、工程实现与实际意义,帮助你全面理解这一机器学习领域“常胜将军”的本质。

注:本文章含大量数学算式、详细例子说明及大量代码演示,大量干货,建议先收藏再慢慢观看理解。新频道发展不易,你们的每个赞、收藏跟转发都是我继续分享的动力!

注:XGBoost是集成方法(Ensemble)的一种Boosting方法,爱酱也有文章深入探讨集成方法的仔细介绍,这里也给上链接。

传送门:

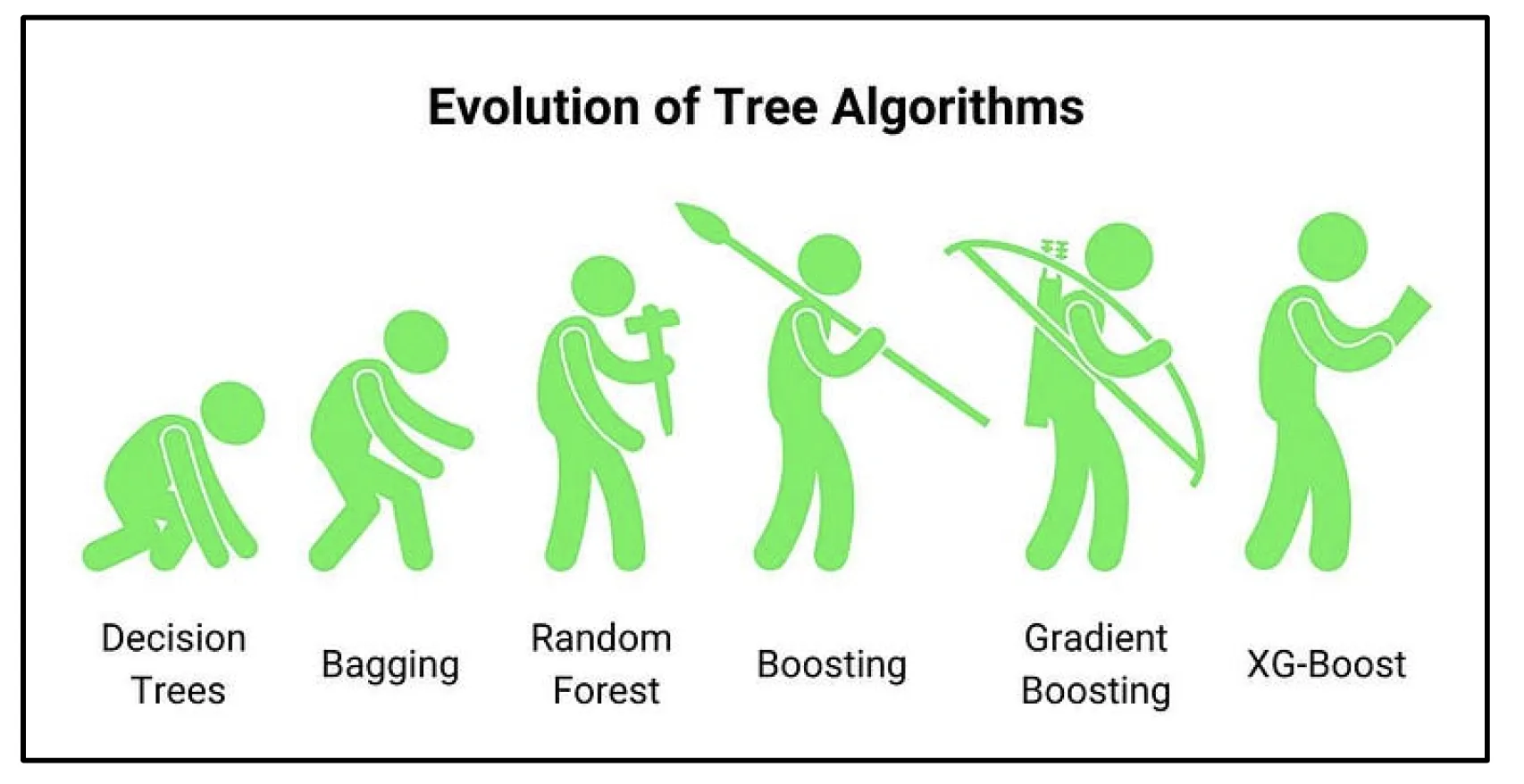

【AI深究】集成方法(Ensemble)全网最详细全流程详解与案例(附Python代码演示)|详解:Bagging与Boosting|随机森林|AdaBoost|XGBoost|优、缺点|选择应用建议-优快云博客

一、XGBoost是什么?

XGBoost,全称eXtreme Gradient Boosting,是一种基于梯度提升(Gradient Boosting)框架的高效、可扩展的机器学习算法库。它由陈天奇博士于2016年提出,因其卓越的性能、灵活性和工程优化,成为Kaggle等数据科学竞赛和工业界的“标配”算法。

-

英文专有名词:XGBoost, eXtreme Gradient Boosting, Gradient Boosted Decision Tree (GBDT)

-

本质:决策树集成的提升方法,采用加法模型和梯度优化,逐步提升模型表现。

二、核心原理与数学表达

1. 梯度提升框架

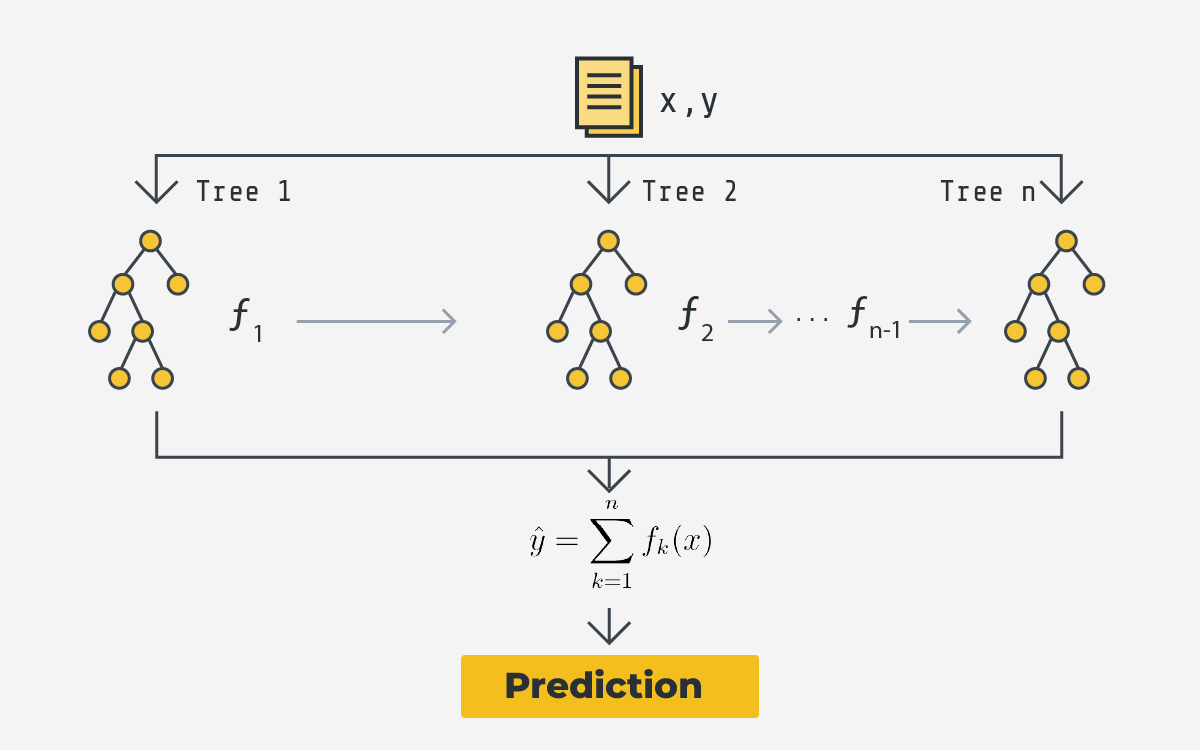

XGBoost属于Boosting家族,通过加法模型和前向分步优化思想,将多个弱学习器(通常是CART决策树)串联起来,每一轮新模型都聚焦于前一轮的残差(误差),不断优化整体预测能力。

加法模型表达:

其中,为树的数量,

为第

棵树,

为所有CART树的集合。

2. 目标函数

XGBoost的优化目标由两部分组成:损失函数(Loss) + 正则化项(Regularization),以兼顾拟合能力和模型复杂度,防止过拟合。

目标函数表达:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

755

755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?