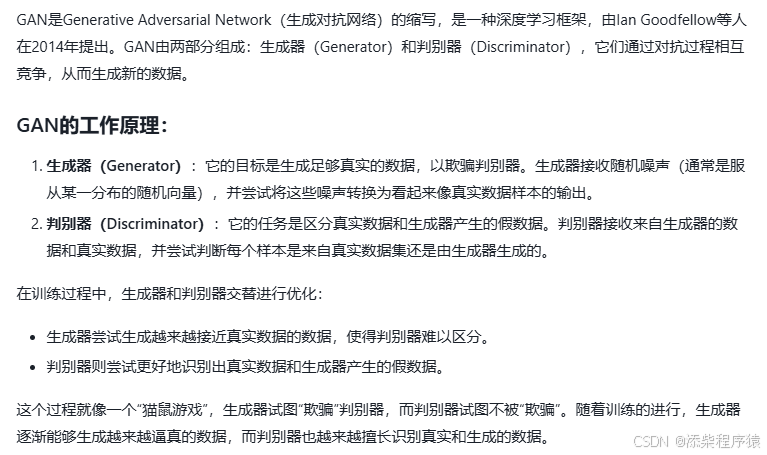

来看一下通俗的GAN的工作原理.

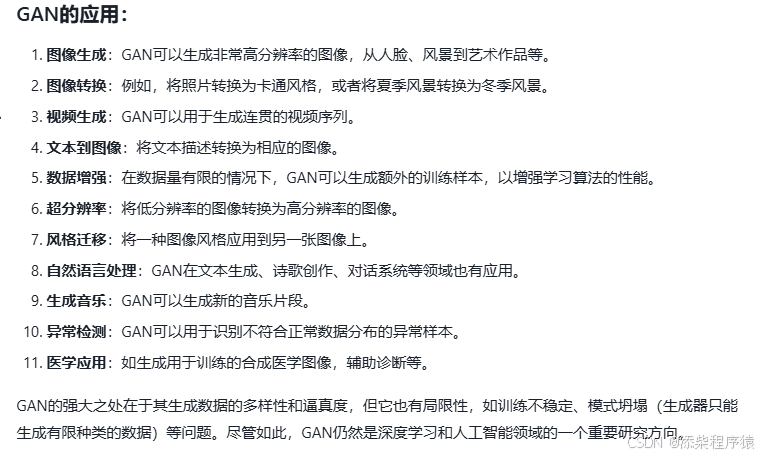

来看一下GAN,生成式对抗神经网络的作用,可以用在哪些方面.

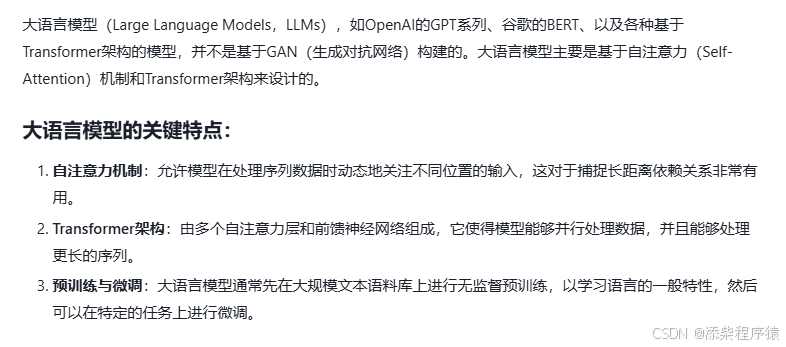

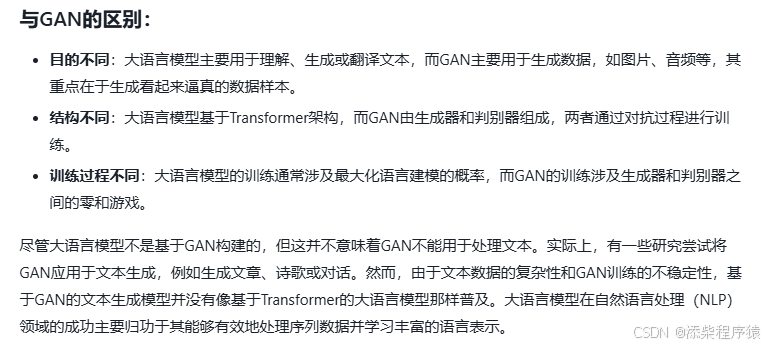

然后再来看一下大语言模型和GAN的区别.

然后再来看一下

在文本生成中,非常重要的要解决的一个问题,长距离依赖关系问题,这个问题.

是如何解决的,为什么说长距离依

来看一下通俗的GAN的工作原理.

来看一下GAN,生成式对抗神经网络的作用,可以用在哪些方面.

然后再来看一下大语言模型和GAN的区别.

然后再来看一下

在文本生成中,非常重要的要解决的一个问题,长距离依赖关系问题,这个问题.

是如何解决的,为什么说长距离依

758

758

1750

1750

2123

2123

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?