ReLU是目前较常用的激活函数,Swish激活函数在它的基础上进一步提高了ImageNet上的精度。参考论文提出了ACON激活函数,它一方面解释了Swish函数的内在机理,证明Swish是ReLU的平滑近似版本,另一方面又推广出ACON激活函数,可进一步提高精度,且ACON的上下边界是可学习的。在网络高度deep的时候证明比其他激活函数更能提高精度。

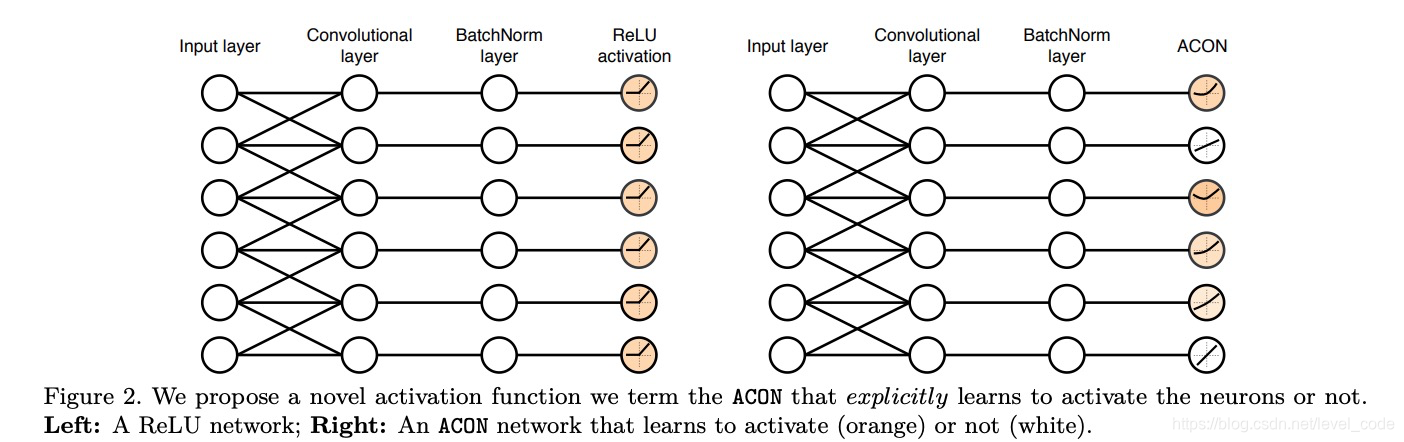

具体改进可见下图,对于每层是不是要激活是不一样的,而ReLU是每层都一样。

ACON原理

考虑max函数

![]()

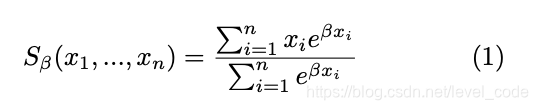

转换成softmax的话为

而ReLU是max(x, 0),是两个变量的max函数,转换成更一般的形式,即两个变量都是x的线性函数,

![]()

本文介绍了ACON激活函数,它作为ReLU和Swish的拓展,能进一步提升深度学习模型的精度。ACON不仅解释了Swish函数的内在机理,而且其边界是可学习的,尤其在深层网络中表现优越。通过转换为softmax形式,作者展示了ACON的一阶导数上下界的可学习性,并提出了Meta-ACON,允许动态学习β参数。实验表明,按层或通道学习β值可以优化每个层的性能。具体实现细节及源代码可在文中找到。

本文介绍了ACON激活函数,它作为ReLU和Swish的拓展,能进一步提升深度学习模型的精度。ACON不仅解释了Swish函数的内在机理,而且其边界是可学习的,尤其在深层网络中表现优越。通过转换为softmax形式,作者展示了ACON的一阶导数上下界的可学习性,并提出了Meta-ACON,允许动态学习β参数。实验表明,按层或通道学习β值可以优化每个层的性能。具体实现细节及源代码可在文中找到。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

993

993

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?