基于知识蒸馏学习的轻量化高光谱图像分类模型代码 Pytorch制作 教师模型采用Resnet18,学生模型是对教师模型进行改进的轻量化模型,外加最新的注意力机制模块。 在一定基础上,可以超过教师模型。 全套项目,包含网络模型,训练代码,预测代码,直接下载数据集就能跑,拿上就能用,简单又省事儿 需要讲解另算) 内附indian pines数据集,采用30%的数据作为训练集,并附上迭代10次的模型结果,准确率90以上。

项目概述

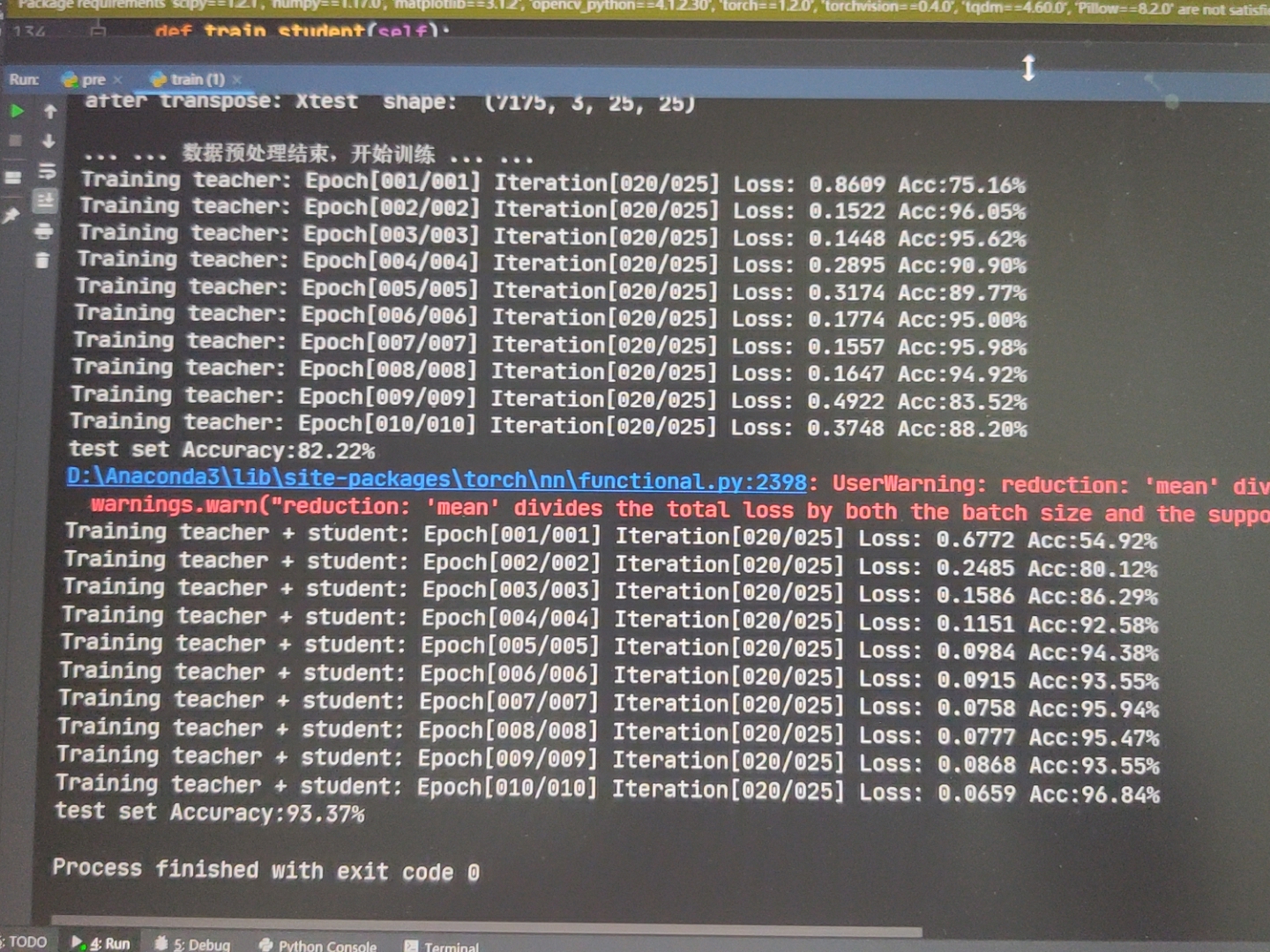

本项目实现了一个基于知识蒸馏(Knowledge Distillation)技术的轻量化高光谱图像分类系统。该系统通过教师-学生网络架构,将大型教师网络的知识迁移到轻量级学生网络中,在保持较高分类精度的同时显著降低模型复杂度,特别适合资源受限环境下的高光谱图像分类任务。

核心功能模块

1. 教师网络 (teacher.py)

教师网络采用标准的ResNet-18架构,作为知识传递的来源:

- 基础残差块:使用标准3×3卷积层构建

- 网络结构:4个残差层,通道数分别为32、64、128、256

- 特点:参数量较大,精度较高,作为知识蒸馏的教师模型

2. 学生网络 (student.py)

学生网络在ResNet基础上进行了轻量化改进:

- 异构卷积 (Conv2db):结合分组卷积和点卷积,减少计算量

- 坐标注意力机制 (CoordAtt):增强特征表达能力

- 轻量化设计:在保持性能的同时显著降低模型复杂度

3. 知识蒸馏训练框架 (train.py)

实现完整的教师-学生蒸馏训练流程:

- 单独教师训练:先训练高性能教师网络

- 单独学生训练:基准对比实验

- 联合蒸馏训练:将教师知识迁移到学生网络

- 损失函数:结合KL散度损失和交叉熵损失

4. 数据预处理工具 (utils.py)

提供高光谱数据处理的完整工具集:

- PCA降维:减少光谱维度,降低计算复杂度

- 图像块提取:以像素为中心提取局部空间特征

- 数据划分:分层抽样确保训练测试集分布一致

- 数据标准化:可选的数据归一化处理

5. 预测模块 (pre.py)

实现训练后模型的推理预测:

- 逐像素分类:对高光谱图像的每个像素进行分类

- 结果可视化:生成分类结果图

- 批量处理:支持大规模图像的高效推理

技术特点

1. 知识蒸馏技术

def distillation(self, y, labels, teacher_scores, temp, alpha):

return self.KLDivLoss(F.log_softmax(y/temp, dim=1),

F.softmax(teacher_scores/temp, dim=1)) * (temp*temp*2.0*alpha) + \

F.cross_entropy(y, labels) * (1. - alpha)2. 轻量化网络设计

- 异构卷积减少参数量

- 坐标注意力机制提升特征提取能力

- 残差连接保证训练稳定性

3. 高效数据预处理

- PCA降维从数百个光谱波段降至3个主成分

- 局部图像块提取充分利用空间上下文信息

- 智能padding处理边界像素

应用场景

本系统特别适用于以下场景:

- 农业遥感:作物分类、病虫害监测

- 环境监测:土地利用分类、植被覆盖评估

- 地质勘探:矿物识别、地质构造分析

- 军事侦察:目标检测与识别

- 资源受限环境:无人机、卫星等计算资源有限的平台

性能优势

- 模型轻量化:学生网络参数量显著减少

- 保持精度:通过知识蒸馏保持接近教师网络的分类精度

- 推理速度快:适合实时或近实时应用

- 内存占用小:适合嵌入式设备部署

使用方法

- 数据准备:将高光谱数据放入

./data/目录 - 教师训练:运行

train.py中的train_teacher()方法 - 蒸馏训练:运行

trainteacherstudent()进行知识蒸馏 - 模型评估:自动在测试集上评估模型性能

- 预测应用:使用

pre.py对新数据进行分类预测

该项目为高光谱图像分类提供了一套完整的轻量化解决方案,通过知识蒸馏技术实现了模型性能与效率的平衡,在实际应用中具有重要价值。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?