点云可视化工具CloudCompare

cloudcompare是一个开源的网站:https://www.cloudcompare.org/

安装方法为:

1安装snap

sudo apt-get install snapd

2安装cloudcompare

snap install cloudcompare

3启动软件:

cloudcompare.CloudCompare

原文链接:

参考教程

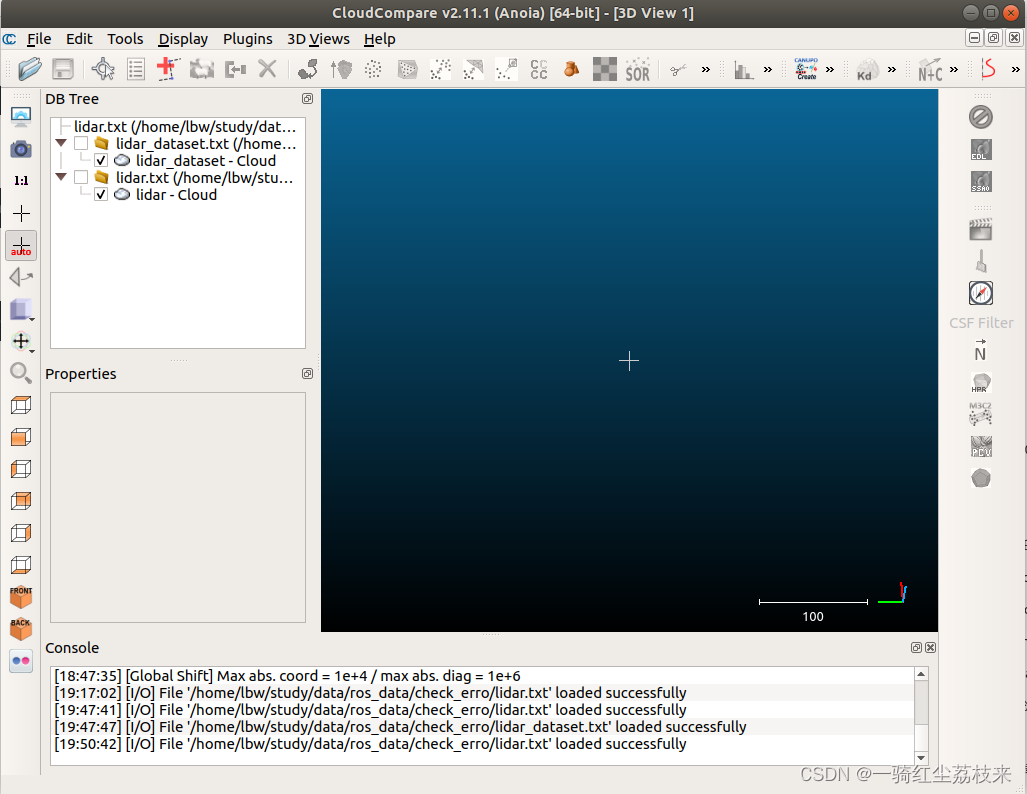

打开后界面如下:

python中将numpy保存成txt

import numpy as np

lidar_data = np.

本文介绍了开源点云可视化工具CloudCompare的安装及使用方法。包括通过Snap安装CloudCompare的过程,如何用Python生成txt格式的点云数据,并利用CloudCompare进行加载与查看。

本文介绍了开源点云可视化工具CloudCompare的安装及使用方法。包括通过Snap安装CloudCompare的过程,如何用Python生成txt格式的点云数据,并利用CloudCompare进行加载与查看。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

187

187

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?