Hugging Face 的生成式 AI 服务(HUGS)让部署和管理大语言模型(LLMs)变得更加简单和快捷。现在,借助 DigitalOcean 免费的一键部署功能,你可以在 GPU Droplet 云服务器上轻松设置、扩展和优化 LLMs,这些 Droplet (DigitalOcean 的云主机)专门针对高性能业务场景进行了优化。本文将一步步带领你完成在 DigitalOcean GPU Droplet 上部署 HUGS 并集成 Open WebUI 的步骤,过程只需要 5 步,完成后你就能理解为什么说一键部署可以让 LLM 推理模型的使用更流畅、可扩展。

准备工作

- 一个 DigitalOcean 云服务的账户,免费注册。

- 在 DigitalOcean 后台开启一个已经部署并运行的 GPU Droplet服务器,以及另一个用于部署和运行 Open WebUI Docker 容器的 Droplet服务器。

- 你需要对 SSH 和基本 Docker 命令有所了解。

- 一个用于登录 Droplet 的 SSH 密钥。

第一步 - 创建并访问你的 GPU Droplet

1、设置 Droplet:

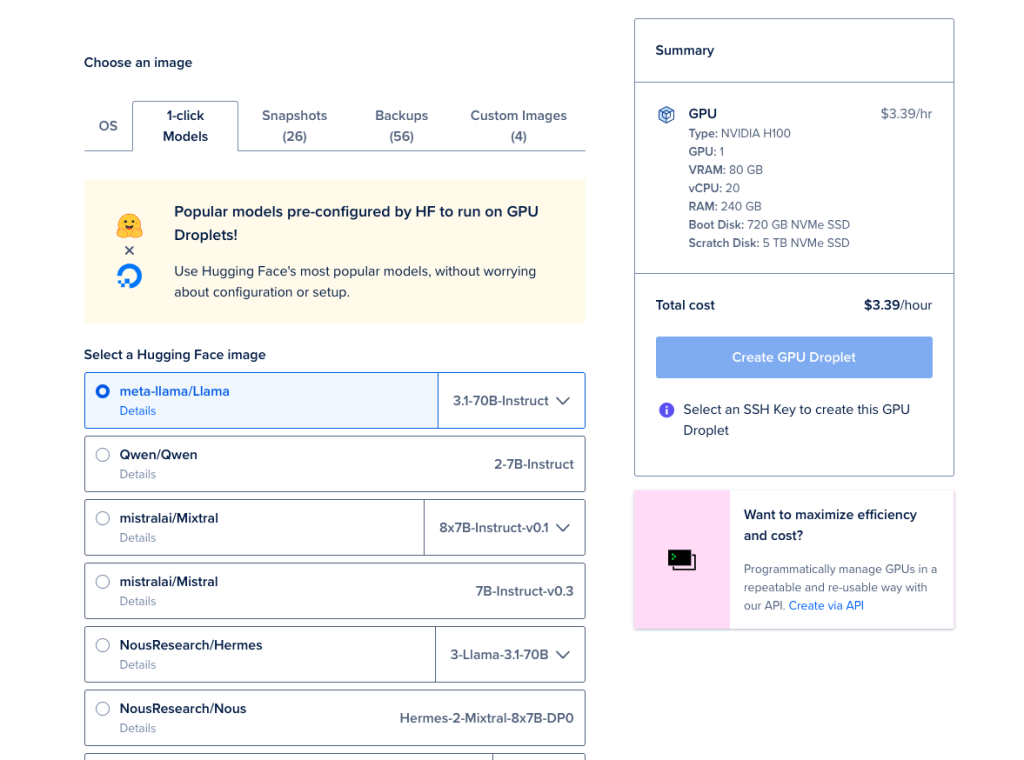

前往 DigitalOcean 的 Droplets 页面,创建一个新的 GPU Droplet。在“选择镜像”选项卡下,选择 1-Click Models,并使用其中一个可用的 Hugging Face 镜像(比如图中的 meta-llama/Llama)。

2、访问控制台(console):

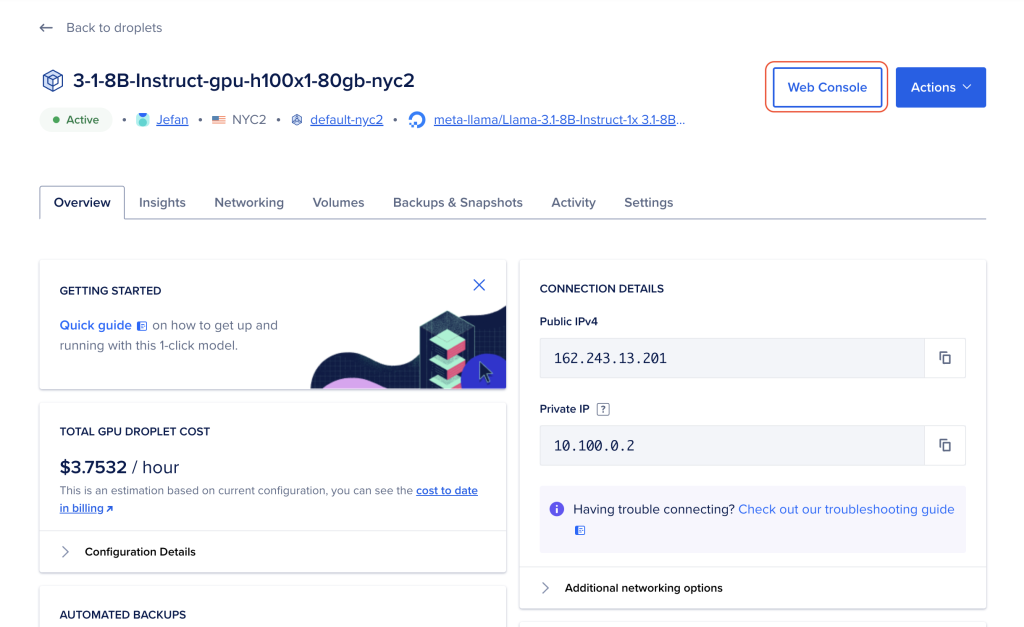

当你的 Droplet 准备好后,点击 Droplets 部分中的你刚刚创建的 Droplet 的名称,然后选择“启动 Web 控制台”。

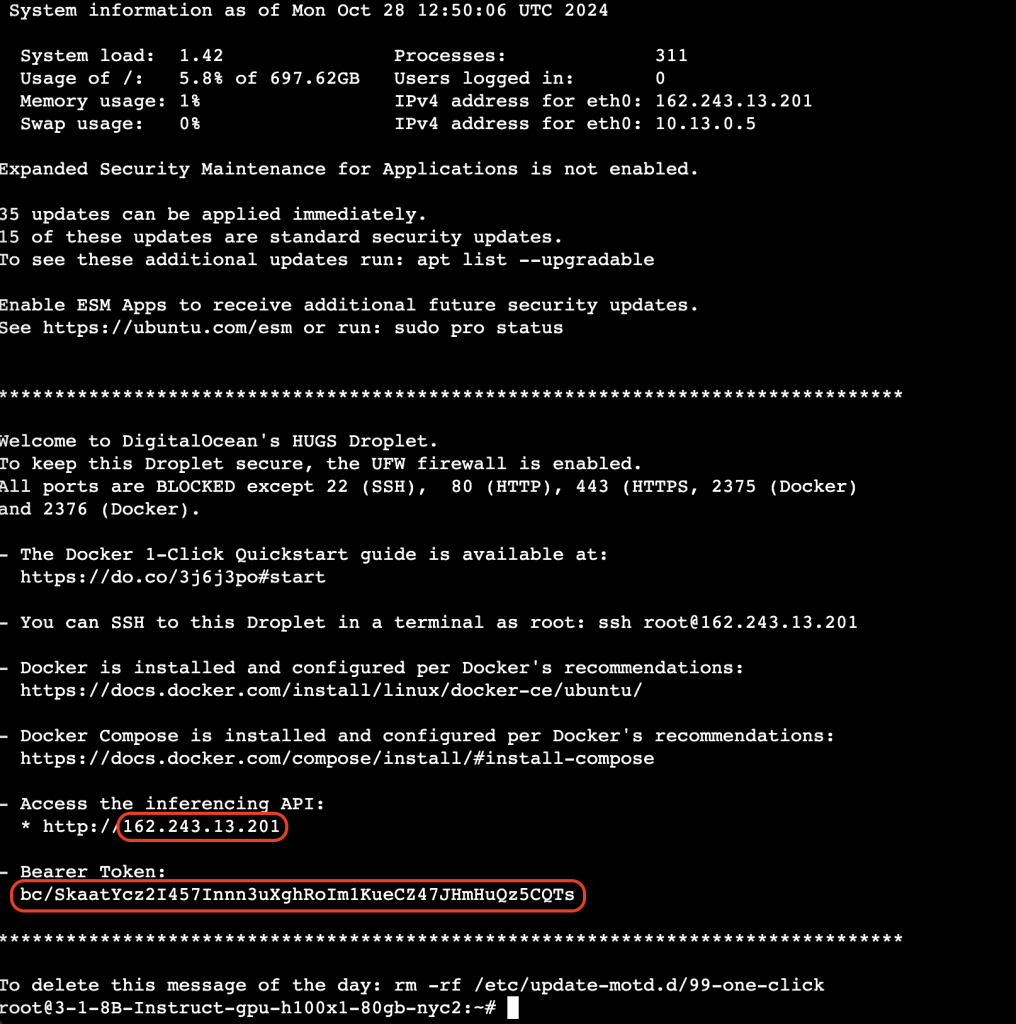

3、请注意“今日消息”(Message of the Day, MOTD):其中包含用于 API 访问的 bearer token 和推理端点(inference endpoint),稍后会用到。

第二步 - 启动 Hugging Face HUGS

Hugging Face HUG

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1233

1233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?