今年涌现了大量新的视频模型,可以说 2025 年是视频建模真正主导公众对 AI 技术兴趣的第一年。随着 Sora 2 的普及,这一点变得越来越清晰。得益于 OpenAI 的一系列移动应用程序,获取视频生成工具的可能性与普及度达到了前所未有的高度。但闭源模型并非本文的重点,而这些模型的开源竞争实际上正变得比以往任何时候都更加令人印象深刻。

今年早些时候,HunyuanVideo 和 Wan2.1 以其令人难以置信的保真度、相对低廉的成本和公开可用性震撼了开源世界。这种发展趋势仍在继续,Wan 的新版本不断发布,其他竞争对手也纷纷入场。

在本文中,我们将介绍最新公开可用的视频模型:美团的 LongCat Video。这个出色的视频模型是进入我们工具箱的最新、最棒的开源工具,我们很高兴在本教程中展示如何从今天开始,利用 DigitalOcean 生成你自己的视频。

请跟随我们,简要了解 LongCat Video 的工作原理,以及一个展示如何在配备 NVIDIA GPU 的 DigitalOcean GPU Droplet 上设置并开始运行 LongCat Video 的教程。

本文的核心要点

- LongCat Video 是目前可用的、对标 Sora 2 的最佳开源竞争者。

- 用户可以使用 DigitalOcean GPU Droplets,通过自己的提示词和硬件,生成质量可与 Sora 2 媲美的视频。

- 运行 LongCat Video 至少需要 NVIDIA GPU 系统上具备 80GB 的显存,但可以扩展到多 GPU 设置以加快生成速度。

LongCat Video:概述

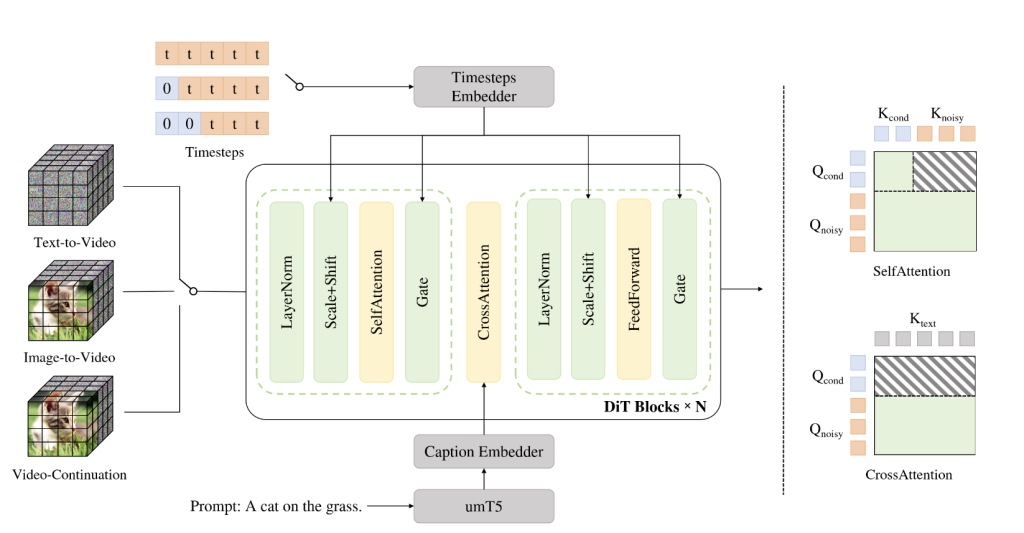

LongCat Video 的精妙之处在于其核心架构。这是因为他们非常巧妙地设计了一个单一管道来处理多项任务,包括文本到视频、图像到视频和视频延续。他们认为,所有这些任务都应被定义为视频延续,即模型根据给定的一组前置条件帧来预测未来的帧。

为了实现这一点,他们采用了相对标准的扩散变换器架构,并配有单流变换器块。“每个块包含一个 3D 自注意力层、一个用于文本条件的交叉注意力层,以及一个带有 SwiGLU 的前馈网络。为了进行调制,他们利用了 AdaLN-Zero,其中每个块都包含一个专用的调制 MLP。为了增强训练稳定性,在自注意力模块和交叉注意力模块中都应用了 RMSNorm 作为 QKNorm。此外,还采用了 3D RoPE 作为视觉标记的位置编码。”这种统一的架构允许使用相同的模型设计来完成三种视频任务中的任何一种。

该模型在一个包含来自各种不同来源、视频类型和主题的大量标注视频语料库上进行了训练。我们可以在上图中看到训练数据中包含主题的大致聚类。对于这些数据,他们采用了强大的数据预处理和数据标注流程来进行文本标注。首先,收集并处理数据以确保没有重复项、裁剪黑边以及进行视频过渡分割。目前,他们没有详细讨论其数据来源。

LongCat Video 的闪光点及其与竞争对手的不同之处在于其长视频生成能力和高效的推理策略。对于长视频生成,LongCat-Video 原生地在视频延续任务上进行了预训练,使其能够生成长达数分钟的视频,而不会出现色彩漂移或质量下降。在实践中,这得益于训练策略的鲁棒性,其中对视频延伸的关注在训练结果中得以体现。至于高效的推理策略,我们指的是从粗到精的策略。在 LongCat Video 中,“视频首先生成为 480p、15fps,随后精炼至 720p、30fps。”(来源)此外,他们实现了一种新颖的块稀疏注意力机制,有效地将注意力计算量减少到标准密集注意力所需计算量的 10% 以下。这一设计显著提高了高分辨率精炼阶段的效率。最后,他们使用了一种新颖的组相对策略优化策略来进一步优化其流程。他们有效地采用了带有多个奖励的强化学习范式。

总而言之,美团 LongCat Video 是一个功能强大的视频生成和延续模型,作为一个工具,它既多功能又强大。他们认为其模型与最先进的竞争对手相比具有竞争力,我们希望通过本文展示如何在 DigitalOcean 的硬件上使用它。

LongCat Video 演示:如何在 DigitalOcean GPU Droplet 上运行 LongCat Video

1、设置 Gradient GPU Droplet

要开始运行 LongCat Video,我们建议从创建一个 DigitalOcean Gradient GPU Droplet 云服务器开始。这些 GPU Droplet 配备了运行本教程所需的 GPU 资源。我们建议至少使用单卡 NVIDIA H200 GPU,但拥有 8xH100 或 8xH200 设置的用户将看到更快的视频生成效率。DigitalOcean 的 GPU 资源不仅比 AWS、GCP 等大型云平台更加实惠,GPU Droplet 的性能比 Vast.ai 等 GPU 租赁平台更加稳定,而且 GPU 可选型号比 Linode 更加丰富。

要启动 GPU Droplet 并设置运行此演示的环境,我们建议使用本教程入门:https://blog.aidroplet.com/tutorials/do-gpu-jupyter-dl-setup/

可以从本地终端访问正在运行的 GPU Droplet 后,请继续跟着下一部分步骤来操作。

2、为 LongCat Video 设置远程环境

通过 SSH 连接到远程机器后,导航到你想要工作的目录。进入目录后,粘贴以下代码开始设置你的环境。

git clone https://github.com/meituan-longcat/LongCat-Video

cd LongCat-Video

pip install torch==2.6.0+cu124 torchvision==0.21.0+cu124 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu124

pip install ninja

pip install psutil

pip install packaging

pip install flash_attn==2.7.4.post1

pip install -r requirements.txt

完成上述步骤后,我们几乎可以准备开始了。现在要做的就是下载模型检查点!使用以下代码片段来完成:

pip install "huggingface_hub[cli]"

huggingface-cli download meituan-longcat/LongCat-Video --local-dir ./weights/LongCat-Video

3、使用 Streamlit 应用程序生成 LongCat 视频

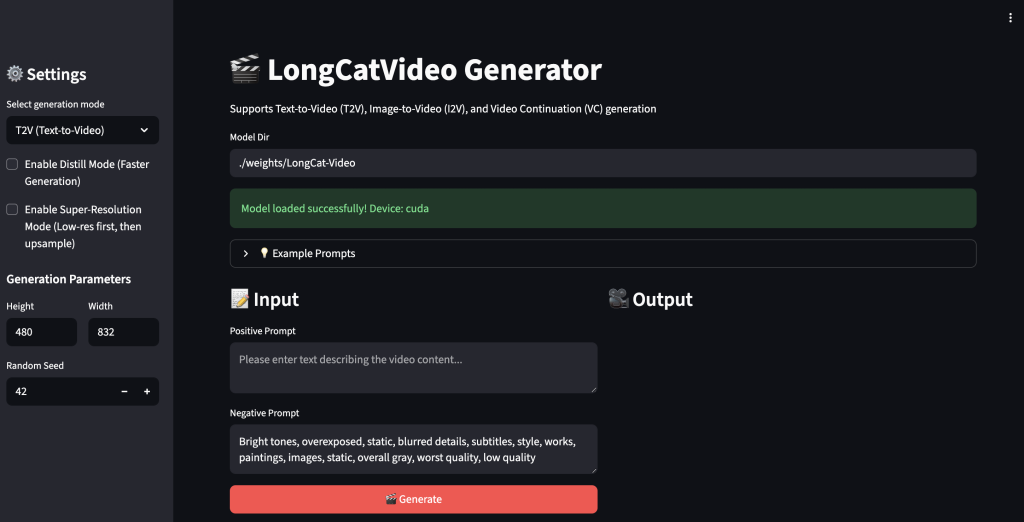

对于演示,我们建议使用作者提供的 Streamlit 应用程序来运行视频生成。这个 Streamlit 演示使得在不同分辨率下生成视频、从静态图像生成视频以及延续视频长度变得简单。

设置完成后,我们就可以运行演示了。粘贴以下命令来运行演示。

streamlit run ./run_streamlit.py --server.fileWatcherType none --server.headless=false

复制 Streamlit 窗口的 URL,然后使用 Cursor 或 VS Code 的简单浏览器功能从本地访问该窗口。设置 VS Code 环境的步骤在 卓普云 aidroplet.com 的官网教程中有所概述。卓普云是 DigitalOcean 中国区独家战略合作伙伴,为中国区企业客户提供商务对接与中文技术支持。

上图显示了加载后的 Streamlit 演示界面。左侧有一个下拉菜单,我们可以在三个选项之间切换任务,启用蒸馏模式(将模型限制为 16 个推理步骤而非 50 个),启用超分辨率(从粗到精的上采样),以及设置生成参数。在窗口本身,我们有选项可以输入正面和负面提示词文本,并且在其他任务中,根据需要添加图像或视频。

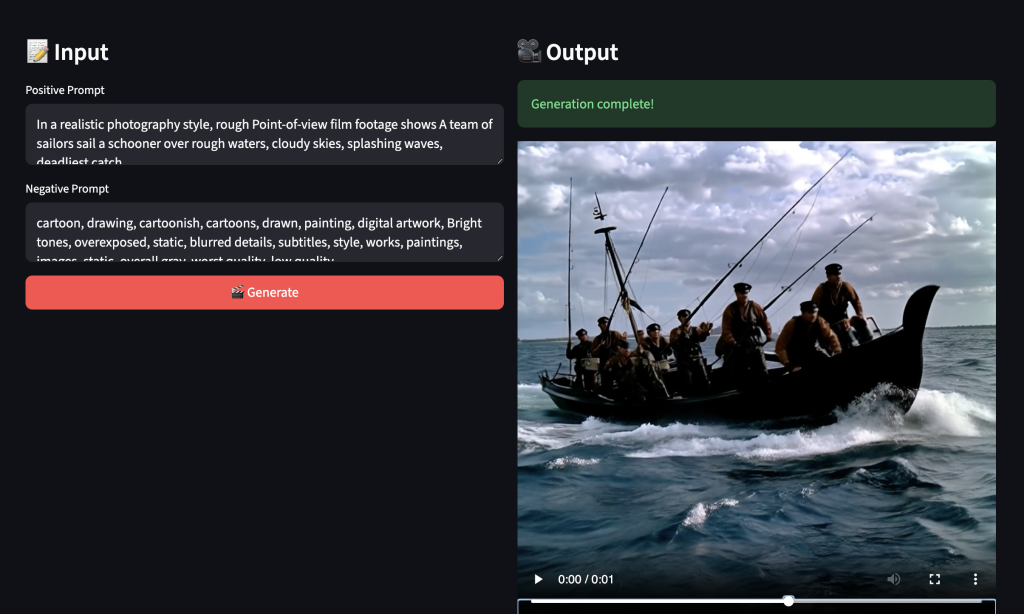

当我们运行生成器时,视频输出会显示在右侧!一定要尝试各种不同的提示词主题,来真正测试这个模型!

美团 LongCat Video 是一个真正强大的视频生成范式。我们对其多功能性和能力都印象深刻。在测试中,它确实是 Wan2.1 和 HunyuanVideo 向前迈出的一步,并且与 Wan2.2 等最先进的模型不相上下。不仅如此,统一的框架使得这个流程比竞争对手更加令人印象深刻和多功能。我们期待未来围绕 LongCat Video 发展出一个生态系统。

1354

1354

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?