上篇介绍了打造个人知识库(Page Assist版)- 私人专属AI-本地化部署deepseek。

打造私人专属AI = 个人知识库 + 本地化部署deepseek模型 / deepseek官方模型(AnythingLLM版)

本篇介绍另一个不错的工具 CherryStudio,同样支持本地化部署 deepseek 模型和 deepseek 官方模型,同时还支持硅基流动,首次注册硅基流动赠送2000W TOKEN,不想充值的小伙伴可以白嫖,白嫖的 TOKEN 可以用挺长一段时间啦,哈哈哈。

一、CherryStudio 介绍

CherryStudio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。 CherryStudio的高度自定义的设计、强大的扩展能力和友好的用户体验,使其成为专业用户和 AI 爱好者的理想选择。无论是零基础用户还是开发者,都能在 CherryStudio 中找到适合自己的AI功能,提升工作效率和创造力。

CherryStudio 是国内团队开发的,更懂国内用户需求和操作习惯,使用体验很好,可以说是更适合中国宝宝体质。

二、CherryStudio下载安装

下载地址:CherryStudio 下载

根据你系统选择下载对应的软件包安装,正常执行安装即可。

三、CherryStudio 数据目录设置

设置 - 数据设置 - 数据目录

应用数据和应用日志默认都在C盘下,且不支持修改,容易把电脑C盘的磁盘打爆。

修改存储位置

如果希望修改存储位置,可以通过创建软连接的方式来实现。将软件退出,然后把数据移动到你希望保存的位置,然后在原位置创建一个链接指向移动后的位置即可。

Step1. 在应用设置里找到数据目录,复制应用数据路径,关闭 CherryStudio,如C:\Users\xxx\AppData\Roaming\CherryStudio

Step2. 将应用数据目录移动到你希望用于存放数据的目的路径,如 D:\AppData\CherryStudio

Step3. 创建目录符号链接(创建符号链接需要管理员权限)或目录联接到新路径。

Step4. 验证 C:\Users\xxx\AppData\Roaming\CherryStudio 正常链接到新路径,启动 CherryStudio。

CMD

针对CMD,可以用mklink命令,语法为:mklink /D Link Target

示例:

mklink /D "C:\Users\xxx\AppData\Roaming\CherryStudio" "D:\AppData\CherryStudio"/D 是符号链接,如果换成 /J 则是目录联接,效果类似。

PowerShell

针对PowerShell,可以用New-Item命令,语法为:New-Item <链接路径> -ItemType <链接类型> -Target <链接目标>

示例:

New-Item "C:\Users\xxx\AppData\Roaming\CherryStudio" -ItemType SymbolicLink -Target

"D:\AppData\CherryStudio"链接类型换成 Junction 是目录联接,效果类似。

四、新建助手

SherryStudio 的交互逻辑是是围绕助手组织的,

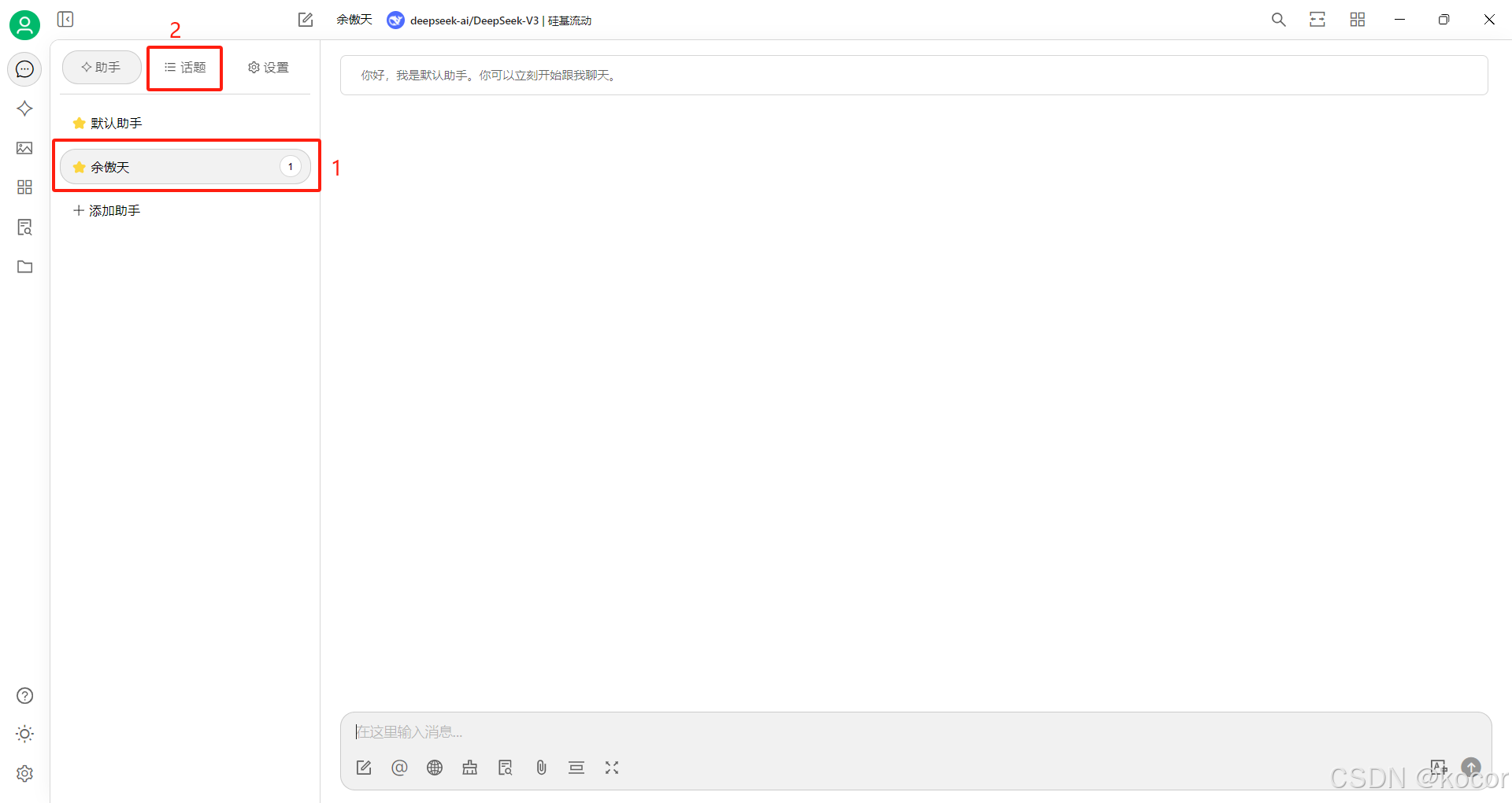

1. 新建助手

新建一个“余傲天”助手。

2. 切换到话题

在助手列表下选定新建的助手,再点击切换到话题列表。

注意留意下图圈出的位置,确认你当前在那个助手下。

3. 选定提供服务的模型

点击图中位置选择提供服务的LLM服务商和对应的模型。

首次使用列表为空,没有配置好的模型。

五、Ollama 模型服务配置

模型服务应用 Ollama 中部署的本地模型。

配置前请在电脑上把 Ollama 运行起来。

1. 开启 Ollama 模型服务

设置 - 模型服务 - 模型平台选择“Ollama” - 点击开启

2. 模型管理

点击模型下的“管理”按钮,进入模型管理列表页。

模型列表页会自动链接电脑上已启动的 Ollama,并把已安装好的模型展示出来。

选择需要的模型添加。

添加完成。

2. 测试效果

切回助手,话题模块下,选择新创建的模型服务和模型。

测试回答正常。

3. 创建知识库

知识库 - 添加 - 输入知识库名称 - 选择嵌入模型 - 确认。

4. 上传知识库文档

选择知识库 - 添加文件 - 确认上传 - 等待文档加载向量数据库完毕。

CherryStudio 还支持其他形式的知识类型,大家可以都去尝试下。

5. 搜索知识库

选择知识库 - 搜索知识库 - 查看结果和评分

这是个超级实用且好用的功能。

向量数据库的检索结果不在是黑盒,明确的看到了检索的搜索结果内容,以及文档分块的检索评分。

这对于我们进行模型回答质量调试、参数调整等有重要的参考作用,同时对我们整理更高质量的文档,提升提问质量等同样起到重要作用。

6. 知识库应用

对话框 - 知识库图标 - 选择应用的知识库 - 提问

正确引用知识库文档回答。

7. 创建智能体

每次问题都需选择知识库,操作繁琐。智能体可以帮我们解决这个问题,提升效率。

助手 - 选定助手 - 右键 - 保存到智能体

8. 编辑智能体

智能体 - 我的 - 选定智能体 - 编辑智能体

8.1 提示词设置

参考内容:

请根据内容进行整理回复,请勿随意虚拟不相关的内容,造成回复质量的下降。

如内容的相关性很低,请直接回复没有相关的知识,引导用户再次组织内容提问。

8.2 默认模型

选择对应服务模型。

其他参数可根据情况适当调整。

8.3 知识库设置

选择对应的知识库

9. 智能体添加为助手

智能体 - 我的 -选定智能体 - 添加到助手

助手列表下多了个与智能体同名的助手。

10. 智能体应用

点击通过智能体创建的助手,发现对应的设置自动应用上去了。

六、siliconflow 模型服务配置

1. 白嫖硅基流动

SiliconCloud 硅基流动云服务,高效、模型丰富、性价比高的大模型服务平台。

目标:白嫖满血版的 Deepseek。

硅基流动地址:SiliconCloud 硅基流动云服务

硅基流动(siliconflow)新注册用户赠送14元账户余额,约 2000W TOKEN。白嫖真香。

2. 创建硅基流动 API 密钥

登录SiliconCloud - API 密钥 - 新建 API 密钥 - 复制密钥。

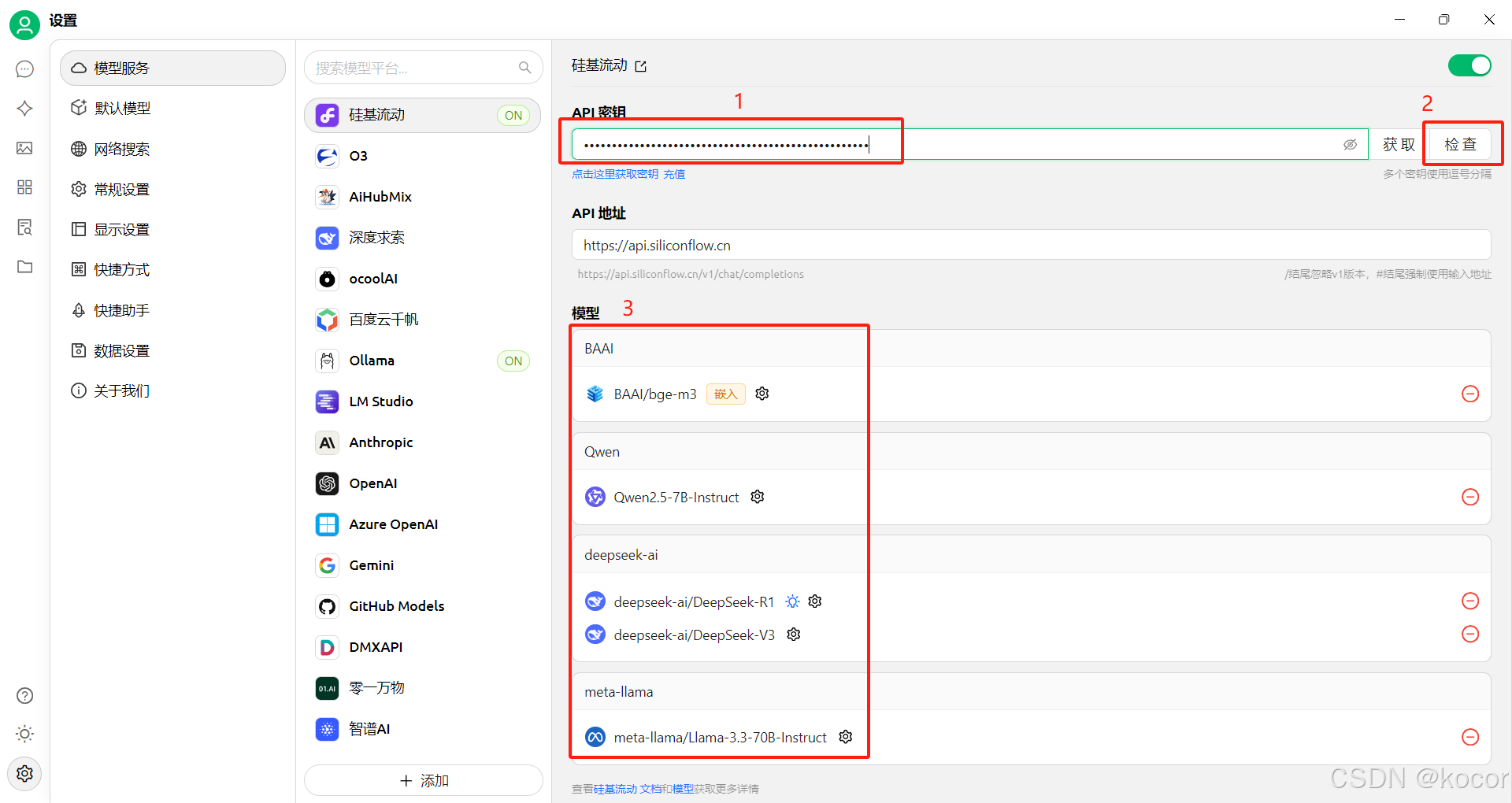

3. 开启硅基流动模型服务

设置 - 模型服务 - 模型平台选择“硅基流动” - 点击开启

4. 填写密钥

填写密钥,点击检查,测试密钥是否正确可用。

5. 管理硅基流动模型

点击“管理”按钮,进入模型管理列表页。

硅基流动支持的模型非常多,根据需要选择即可。

Deepseek 的各种模型都有,可以通过硅基流动白嫖使用 Deepseek。

模型服务也是支持 Deepseek 官方平台的,设置大同小异,大家可自行摸索。

6. 测试应用

成功通过硅基流动使用满血版的 Deepseek 进行回复。

3875

3875

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?