在AI技术飞速发展的今天,大型语言模型已不再是云端服务的专属。本教程将教你如何通过Ollama和Chatbox两款轻量工具,在个人电脑上免费部署炙手可热的DeepSeek模型,无需高端显卡,普通CPU也能流畅运行!

ollama安装及部署Deepseek模型

首先我们需要在电脑上安装ollama,本文以windows为例。

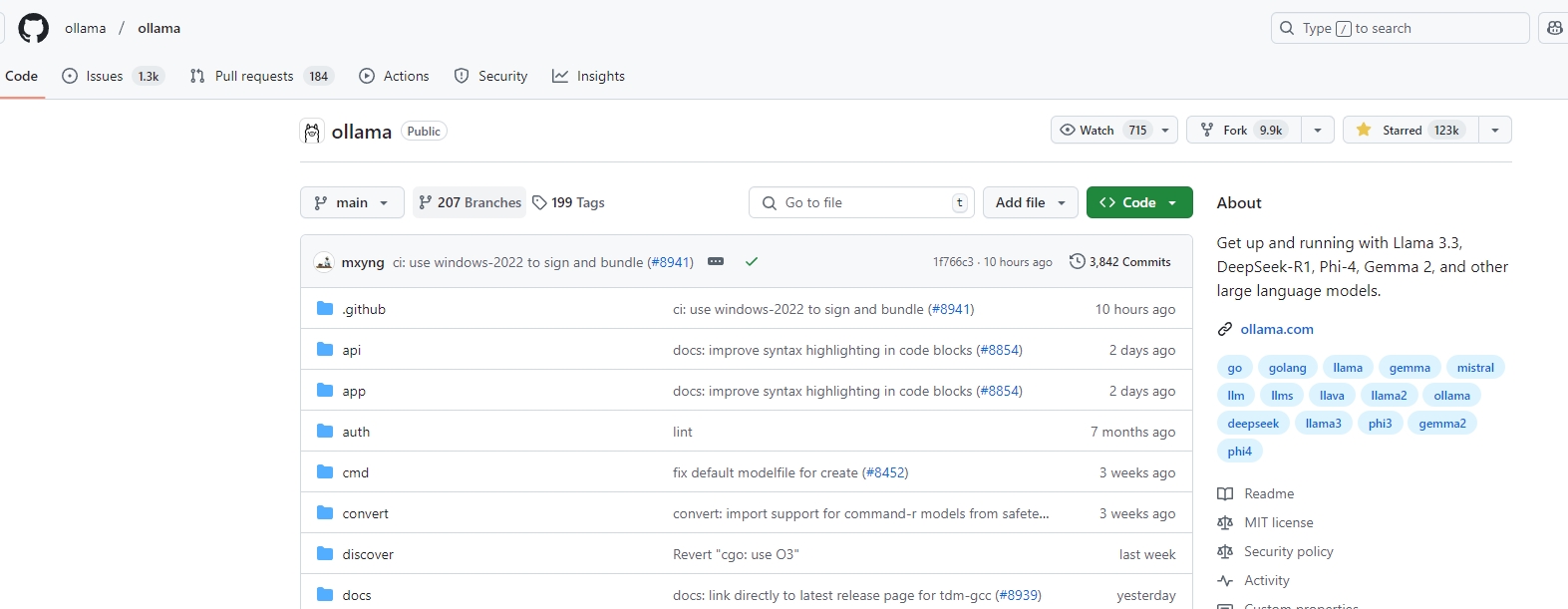

ollama简介

Ollama 是一款开源的本地大模型部署工具,旨在让用户能够轻松在个人电脑上运行各种开源大型语言模型(如 Llama、Mistral、DeepSeek 等)。它支持跨平台操作(Windows/macOS/Linux),提供一键式安装和模型管理,优化了内存和计算资源的使用,即使是普通配置的设备也能流畅运行。通过 Ollama,开发者、研究者和爱好者可以快速部署私有化 AI 应用,无需依赖云端服务,同时享受高效、安全的本地 AI 体验。

ollama目前在github上已经拥有123k star

ollama github地址:https://github.com/ollama/oll

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

936

936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?