一、Ollama

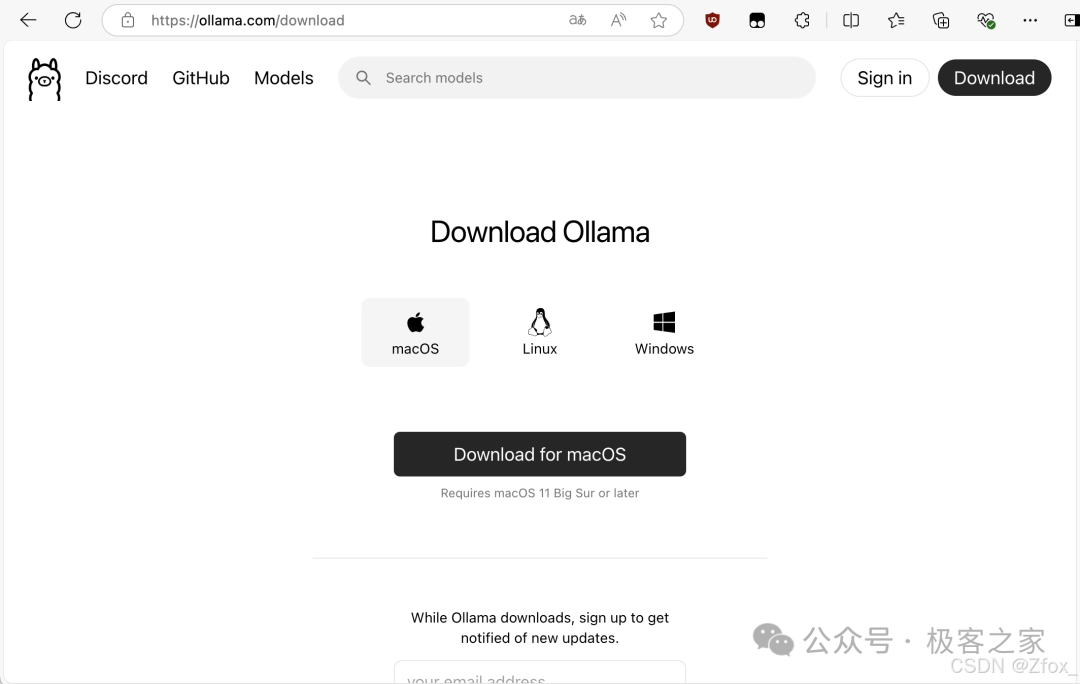

下载 Ollama

https://ollama.com/

-

Ollama 是一个开源的本地化工具,专注于简化大型语言模型(LLMs)的部署和交互。它特别支持 Meta 的 LLaMA 系列模型(如 LLaMA 2、CodeLLaMA 等)及其他开源模型,允许用户在本地计算机上轻松运行这些模型,无需依赖云端服务。

典型使用场景

-

本地开发测试:开发者快速验证 LLM 功能,调试提示词(prompts)。

-

隐私敏感任务:处理不宜上传至云端的数据(如医疗、金融信息)。

-

离线环境应用:在无网络条件下使用模型生成文本、代码或分析数据。

-

目前支持 macOS、Linux、Windows,选择相应的系统下载即可。

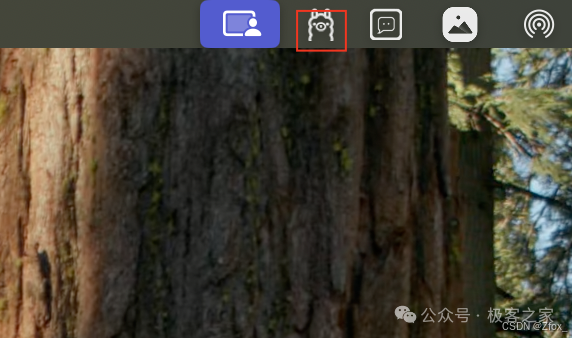

安装后运行软件,在任务栏确认在右上角出现这只 小羊驼🦙 图标

注:

注:

ollma就是比较难下载,需要魔法工具,下面的模型就只能自己慢慢磨时间下载了

这里提供两个方案:

1. 百度网盘:通过网盘分享的文件:Ollama-darwin.zip

链接: https://pan.baidu.com/s/1hVd63qP4naNUFTANixsPSw 提取码: w2vd

2. 魔法工具:感兴趣的小伙伴可以注册一下,首次访问以及注册不是很稳定,注册后就很nice,费用低到你不敢想

https://xn--4gq62f52gdss.ink/#/register?code=ISlpKnv0

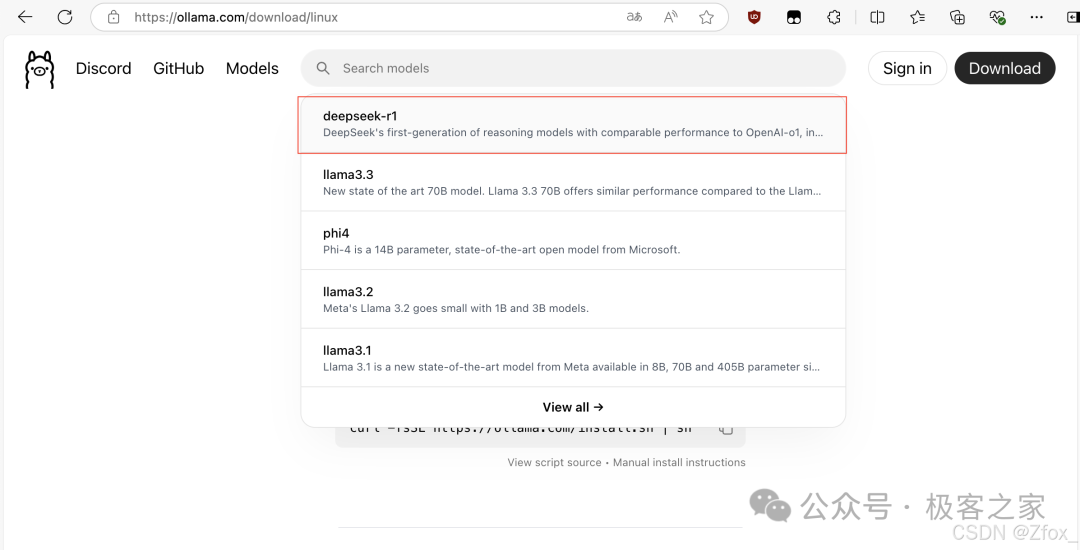

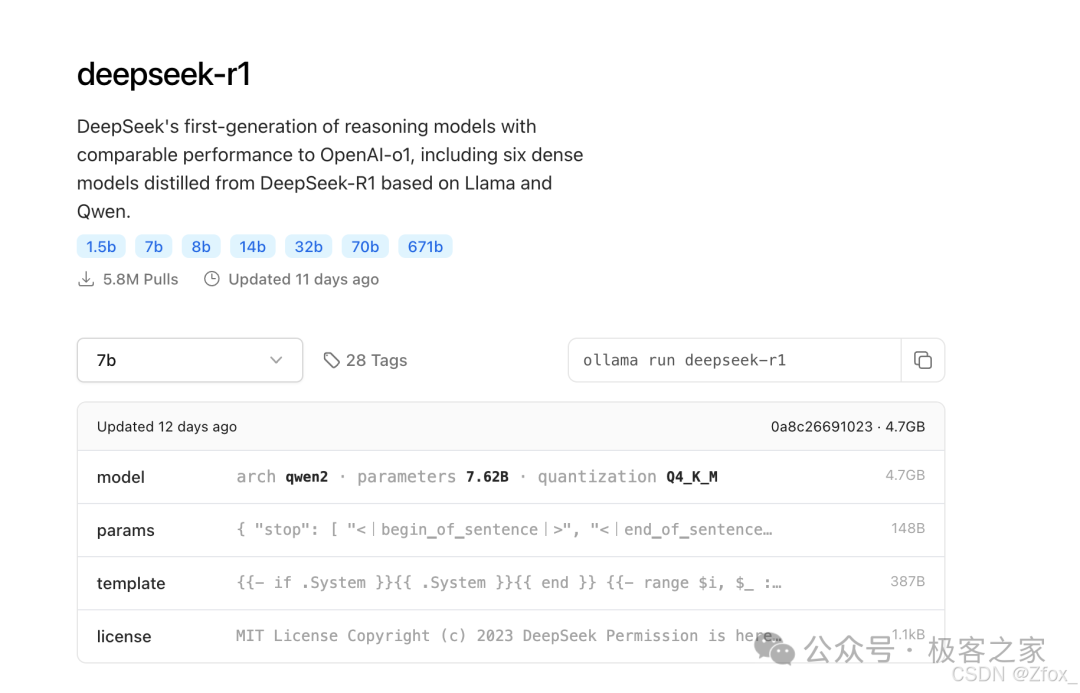

选择模型

点击Search models 搜索框,第一条就是 deepseek-r1 模型。

这里我们发现了多个不同大小的模型,文件大小适配不同的设备

DeepSeek R1提供多个版本,参数量越大,模型通常越强大,但也需要更多的计算资源。

比如1.5B代表有15亿个参数。

借助网上大佬们整理的表格供大家参考,来确认你的电脑可以运行哪个模型:

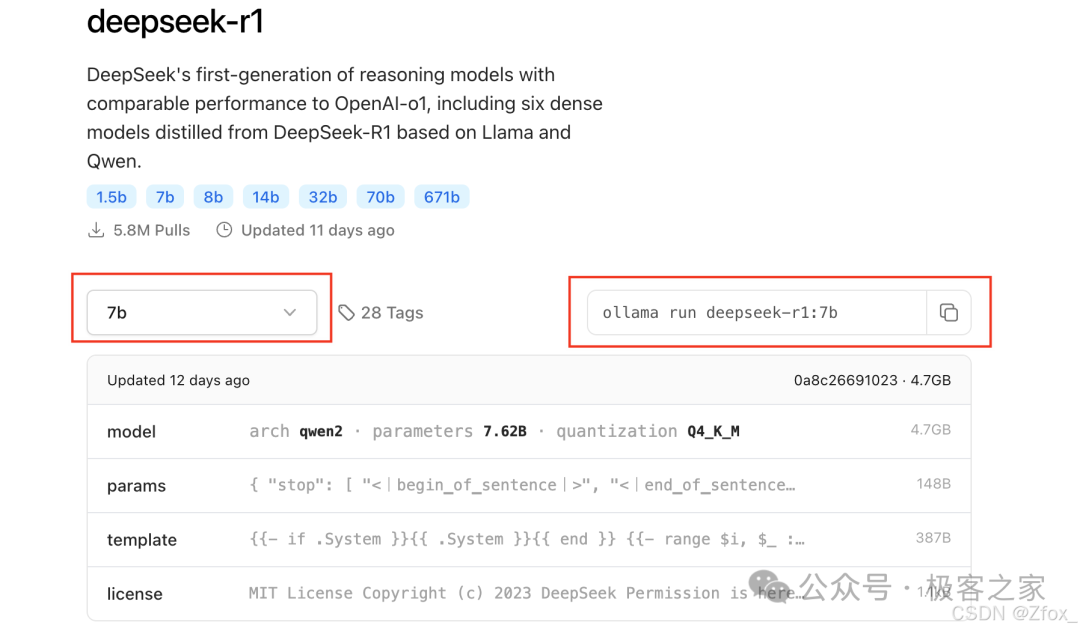

运行模型

运行模型很简单:确定模型后,复制这条指令到终端里

当进度条跑满时,恭喜,你的电脑已经拥有了顶级的推理能力

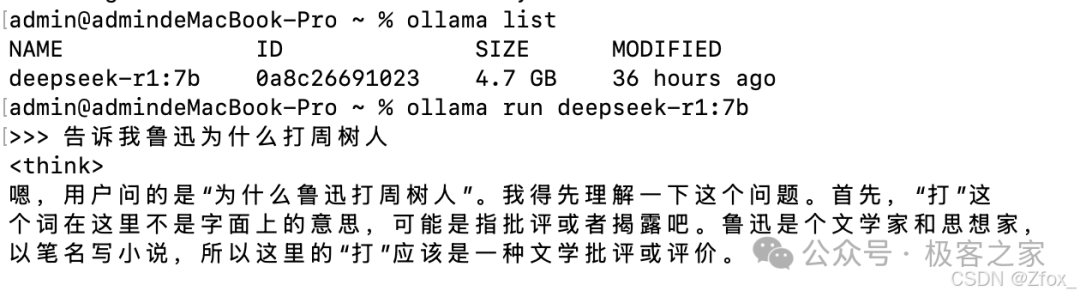

使用 && 测试

这里我已经提前下好了,使用 ollama 提供的终端指令 ollama list 可以看我们电脑上已经部署了哪些模型,然后使用 ollama run 对应的模型 就可以了

输入 /bye即可退出

-

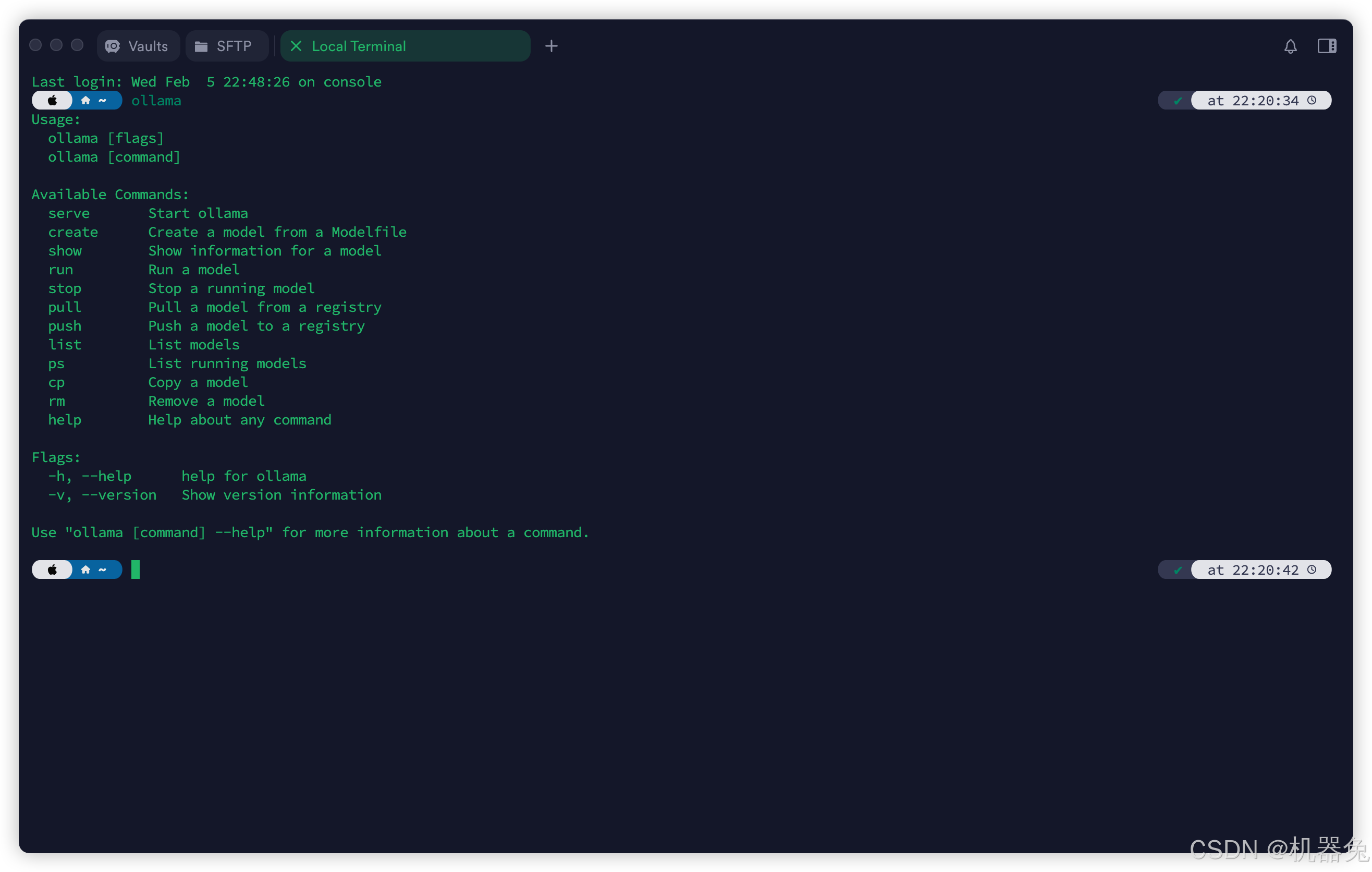

ollama 命令查看

admin@admindeMacBook-Pro ~ % ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

虽然这里终端已经可以使用了,但是还是不太方便。

-

这里就有人要问博主了,你推荐的模型确实挺不错的,但是还是太吃操作了,有没有更加方便的使用方式呢?

-

有的兄弟有的,像更方便的使用方式那么就是 Chatbox

二、Chatbox

浏览器搜索 Chatbox 并下载客户端或者网页版都可以,这个国内的容易下载,一点毛病没有

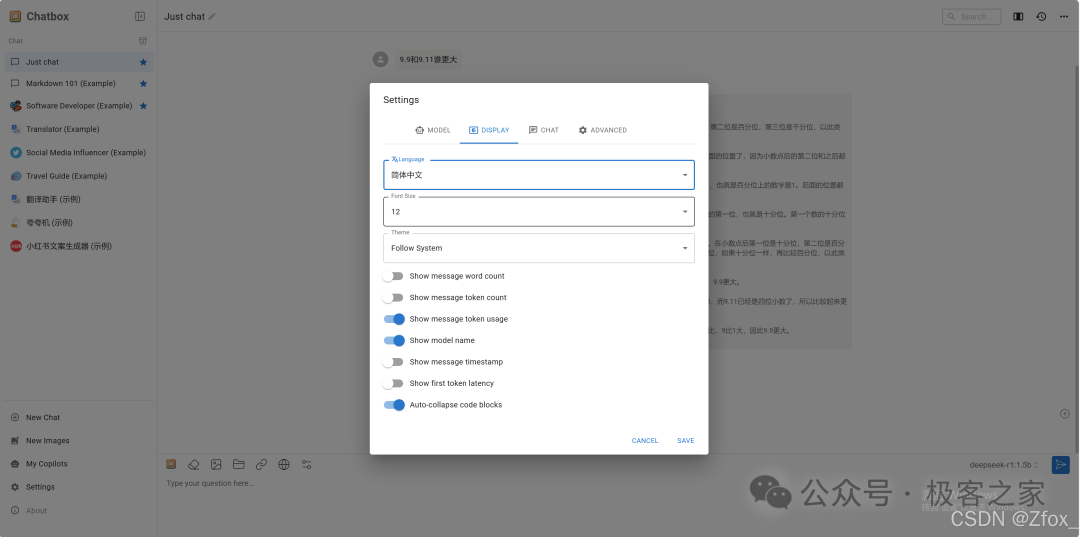

1.设置语言为中文并保存

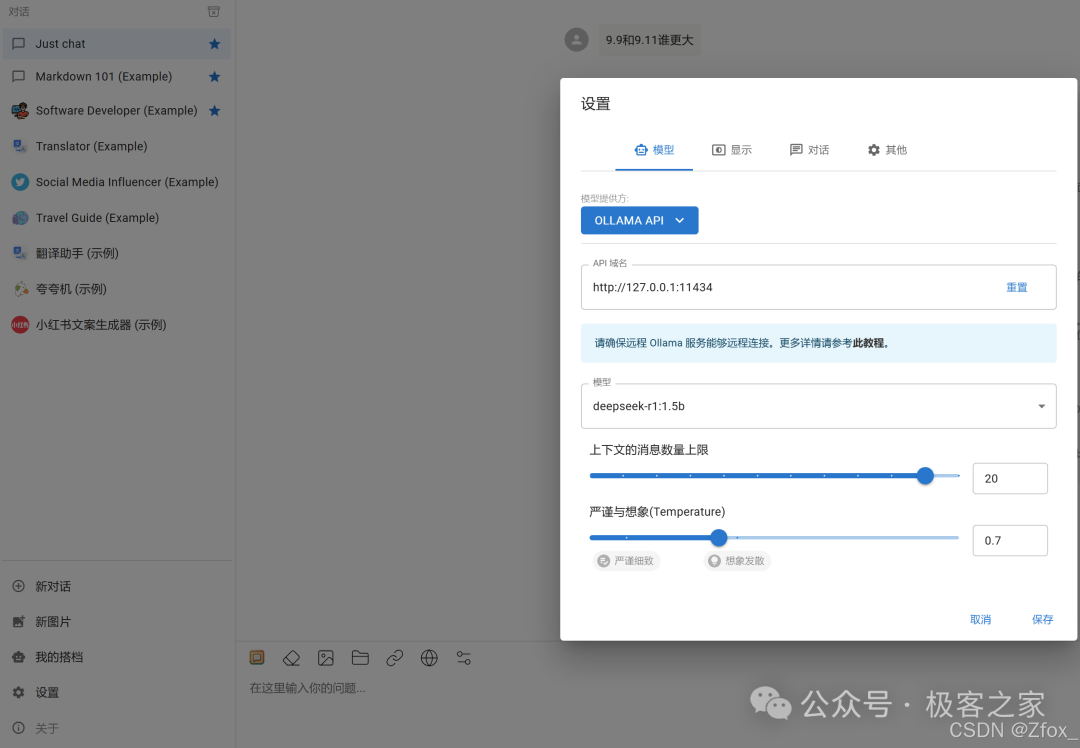

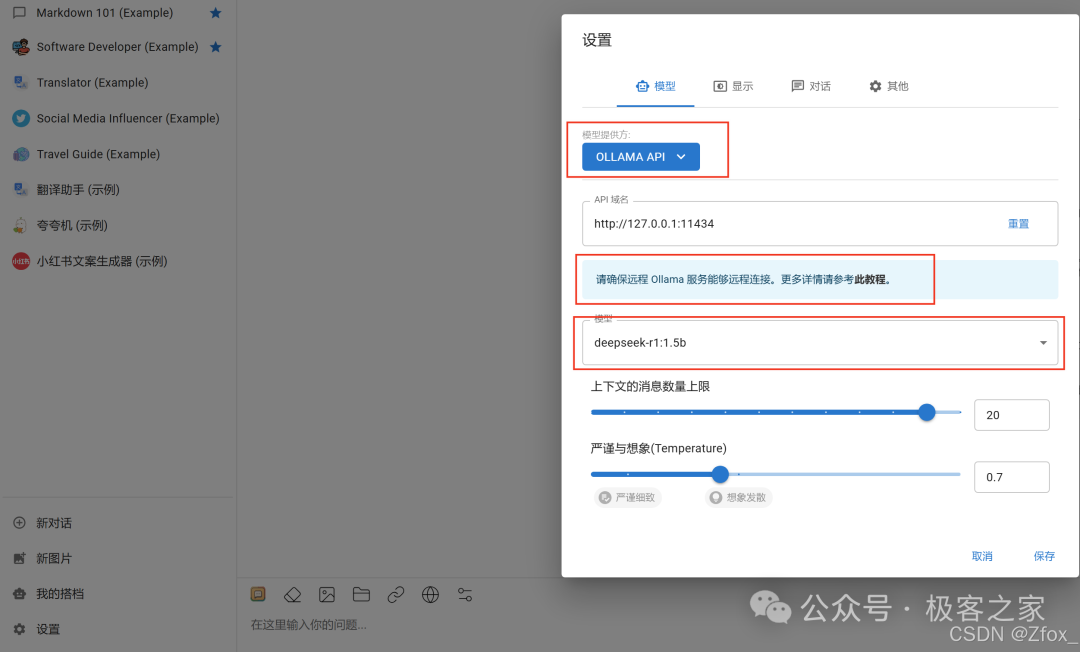

2.点击设置选择模型为 OLLAMA API

为了确保可以连接到本地服务,大家按照提供的教程设置一下,不同的操作系统设置不太一样,然后选择 R1模型并保存

3.连接到本地服务教程跳转

现在你就可以在 浏览器/客户端 上流畅的使用 R1 了。

创建你的专属 GPTs

点击我的搭档,创建搭档,给ai角色设定人格,你也可以选择现有的搭档,一个资深的行业专家就出现了。

三、共勉

以上就是我对 DeepSeek R1本地化部署 Ollama + Chatbox 打造最强 AI 工具 的理解,觉得这篇文章对你有帮助的,可以点赞收藏关注支持一波~

1269

1269

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?