0.

视频资料:吴恩达机器学习课程

https://www.coursera.org/learn/machine-learning/lecture/1z9WW/backpropagation-algorithm

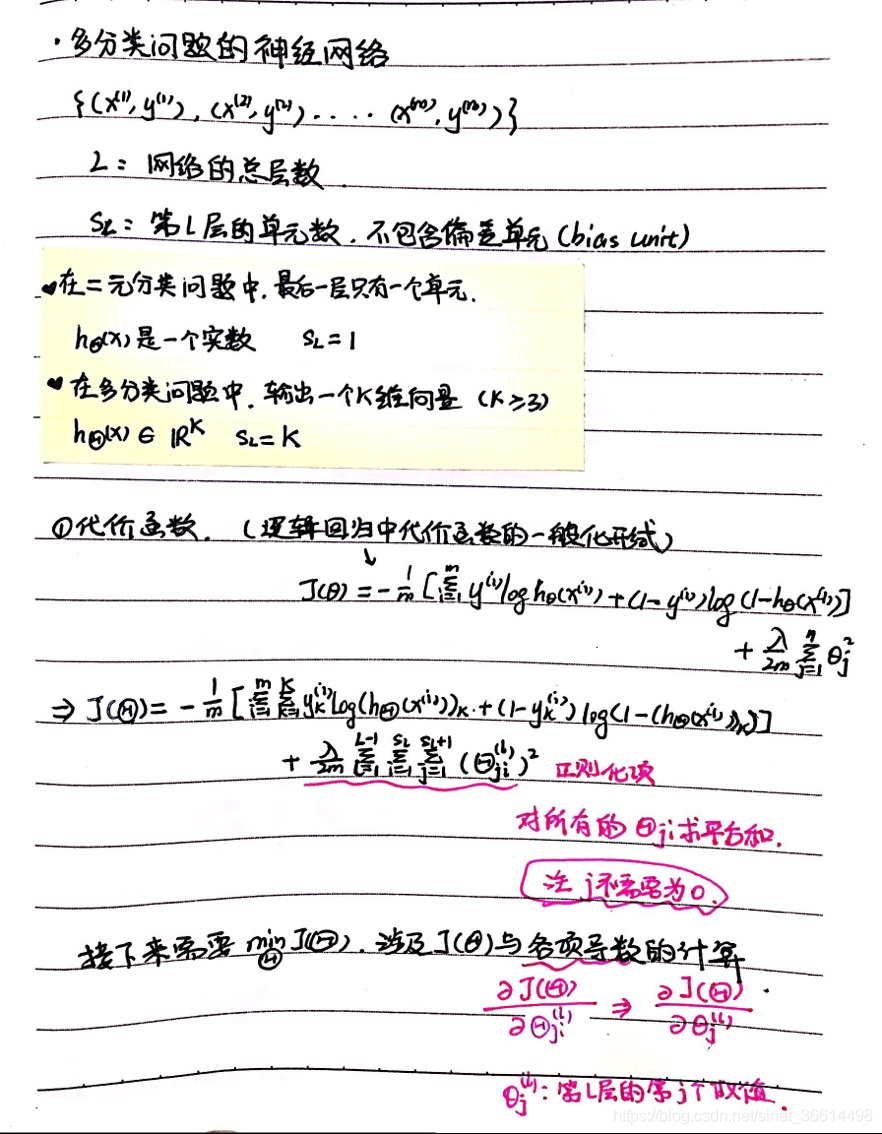

1.多分类问题引出多层神经网络(更复杂的网络)

在多分类问题中,如果有k种分类,最后输出的是一个k维向量

同时根据逻辑回归的损失函数给出多分类问题的损失函数如①中所示

正则化项是对所有层涉及的θ值的平方和(不包含下角标为0的项)

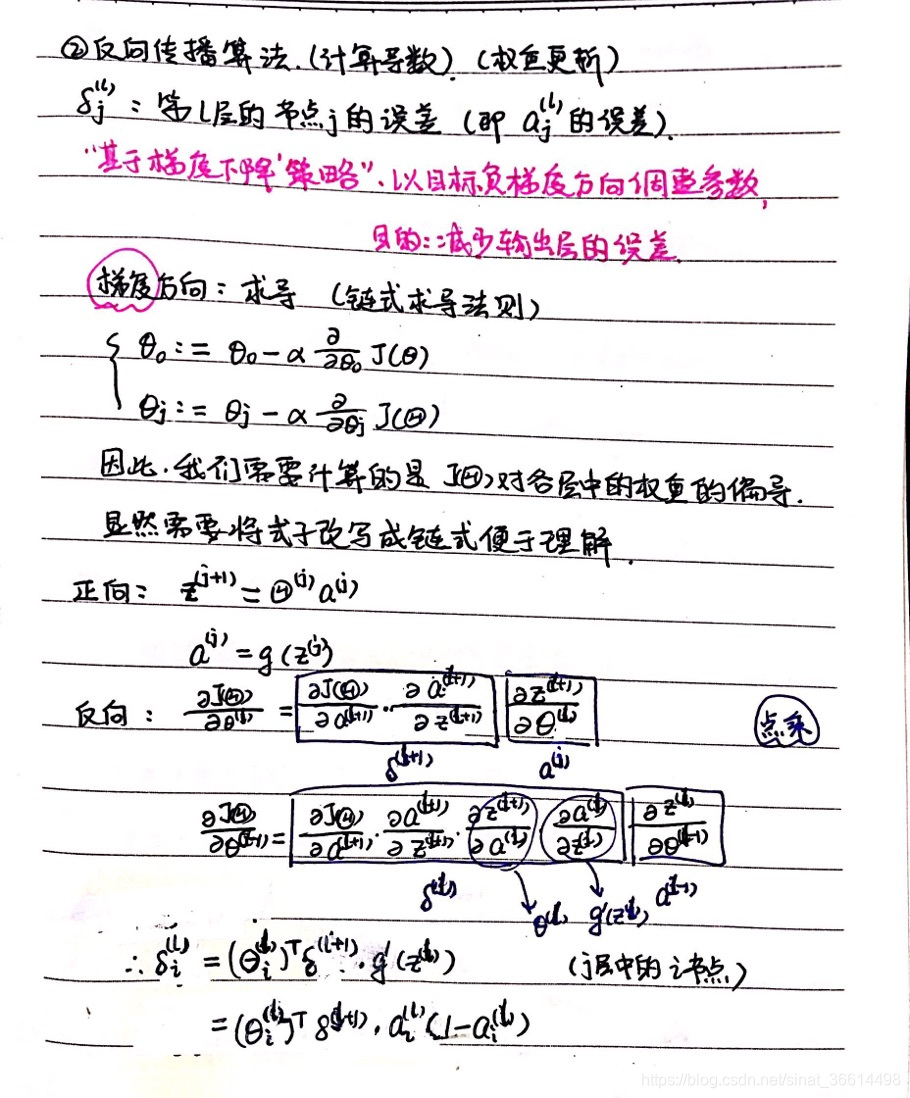

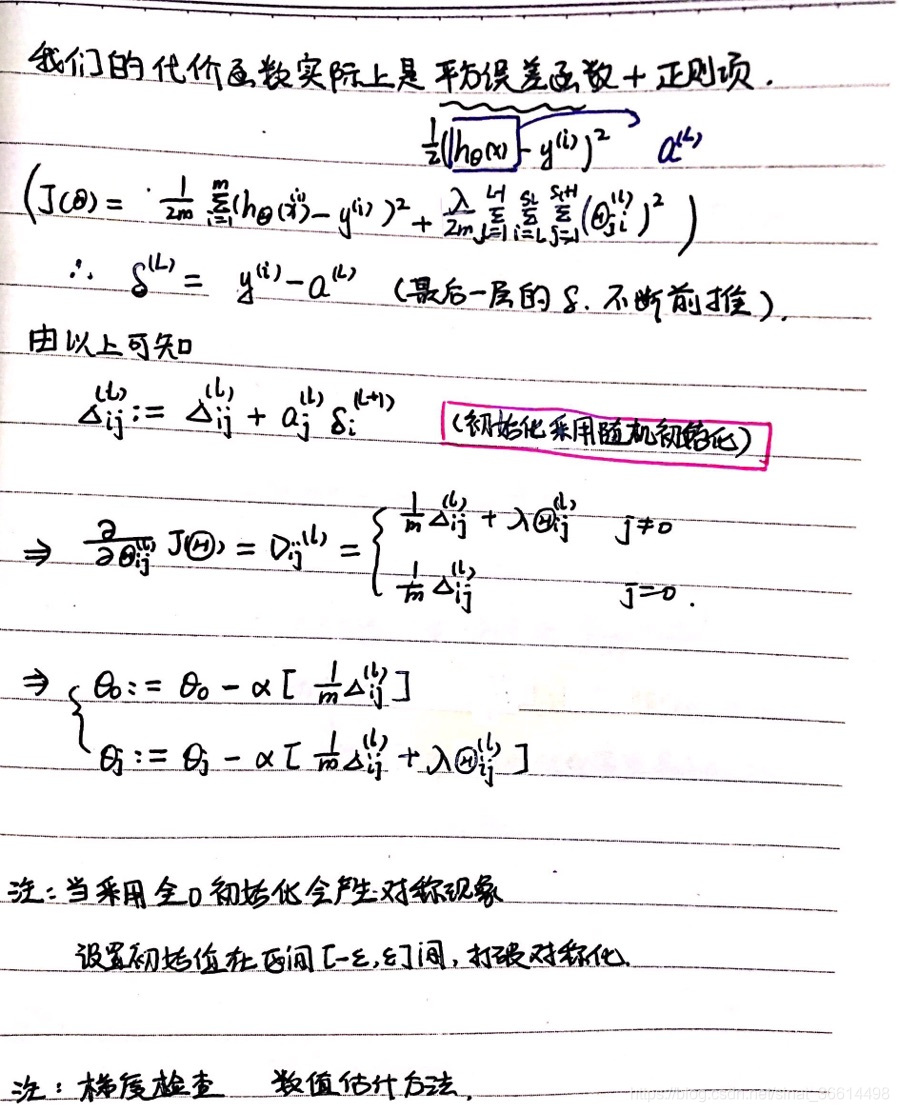

2.BP算法

在上面的多分类问题中,根据前面学习的经验,无论是什么优化算法,如梯度下降法,都需要计算出损失函数对于每一个θ值的偏导数实现对其的迭代更新,直观上来看,BP算法利用了链式求导法则,从而使前一层可以用本层的的δ值进行计算,具体过程都通过笔记进行了顺序化整理。

注:梯度检查与对称现象详见视频。

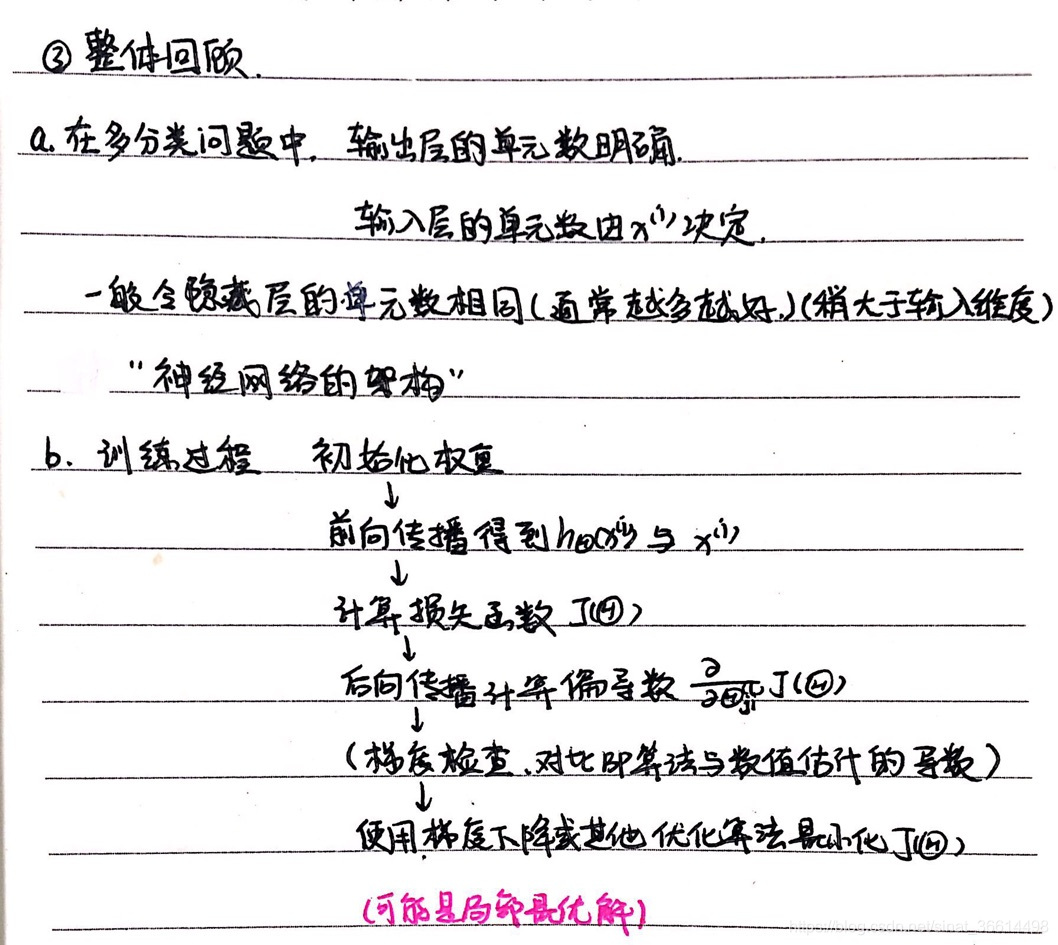

3.整体回顾:一个多分类问题的神经网络

在神经网络模型的构建上,输入层根据x的维度确定,输出层根据类别确定

在隐藏层的确定上,可以选择单层与多层,但一般隐藏层的单元数是相同的,且一般要稍大于输入维度

PS.显然是单元数越多越好,但计算量也随之增大。

探讨了多分类问题下的神经网络模型构建,包括输入层、输出层及隐藏层的设计原则。介绍了吴恩达课程中的BP算法,该算法利用链式求导法则简化了损失函数对θ值的偏导数计算,适用于多层神经网络的参数优化。

探讨了多分类问题下的神经网络模型构建,包括输入层、输出层及隐藏层的设计原则。介绍了吴恩达课程中的BP算法,该算法利用链式求导法则简化了损失函数对θ值的偏导数计算,适用于多层神经网络的参数优化。

5306

5306

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?