0.

视频资料:吴恩达机器学习课程

https://www.coursera.org/learn/machine-learning/lecture/wlPeP/classification

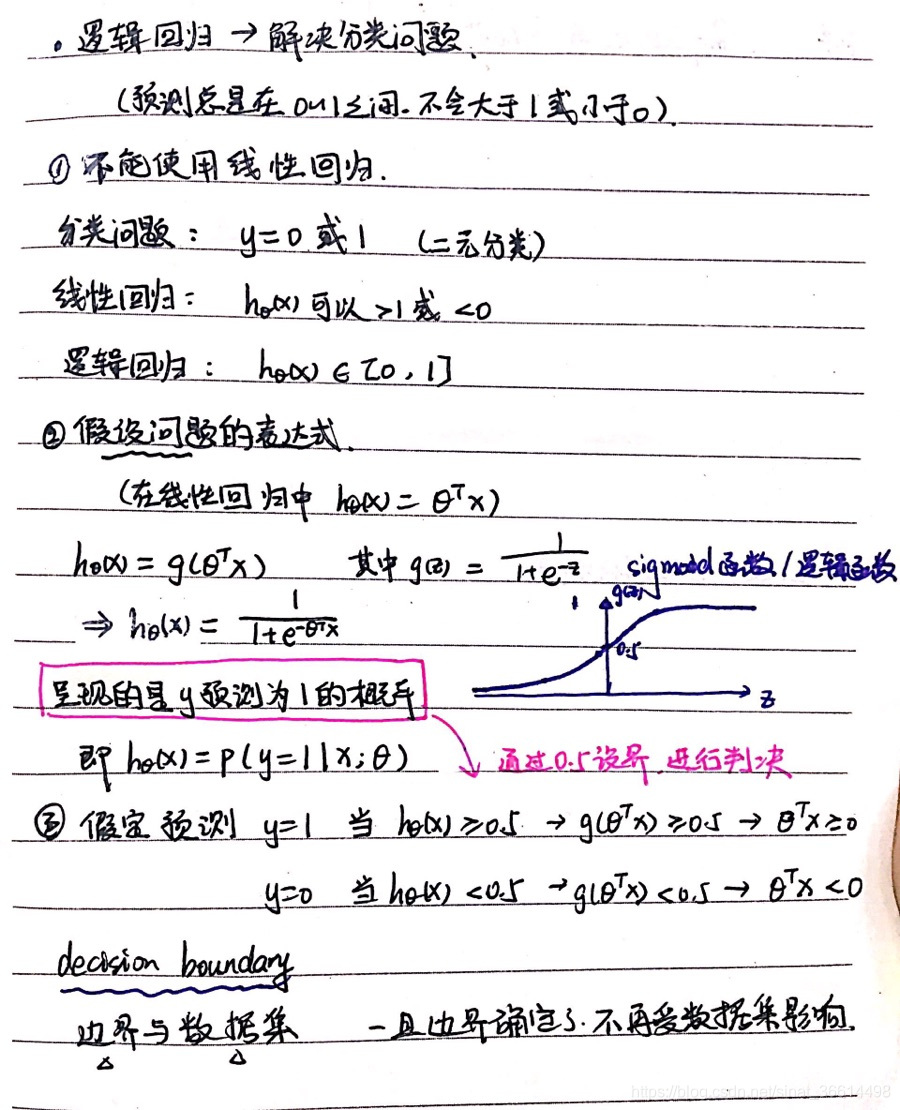

1.用于解决分类问题的逻辑回归

在分类问题中

二分类:

首先,利用h(x)呈现的是y预测为1的概率,利用了sigmoid函数

随后,利用0.5设界,进行判决

最后,利用已有数据集估计θ,划定好边界,边界设置好后不再受数据集影响

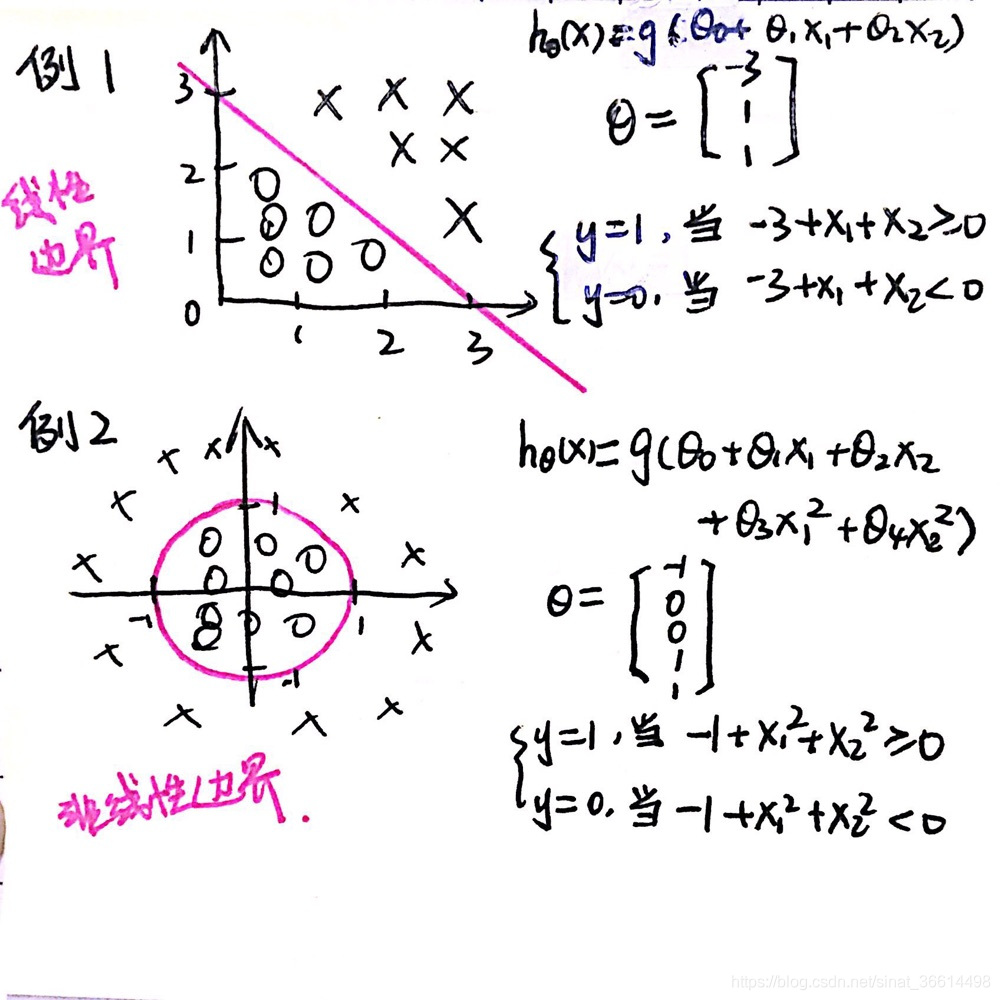

可以参考下图中给出的例子,两种边界,线性与非线性的,考虑多项式回归

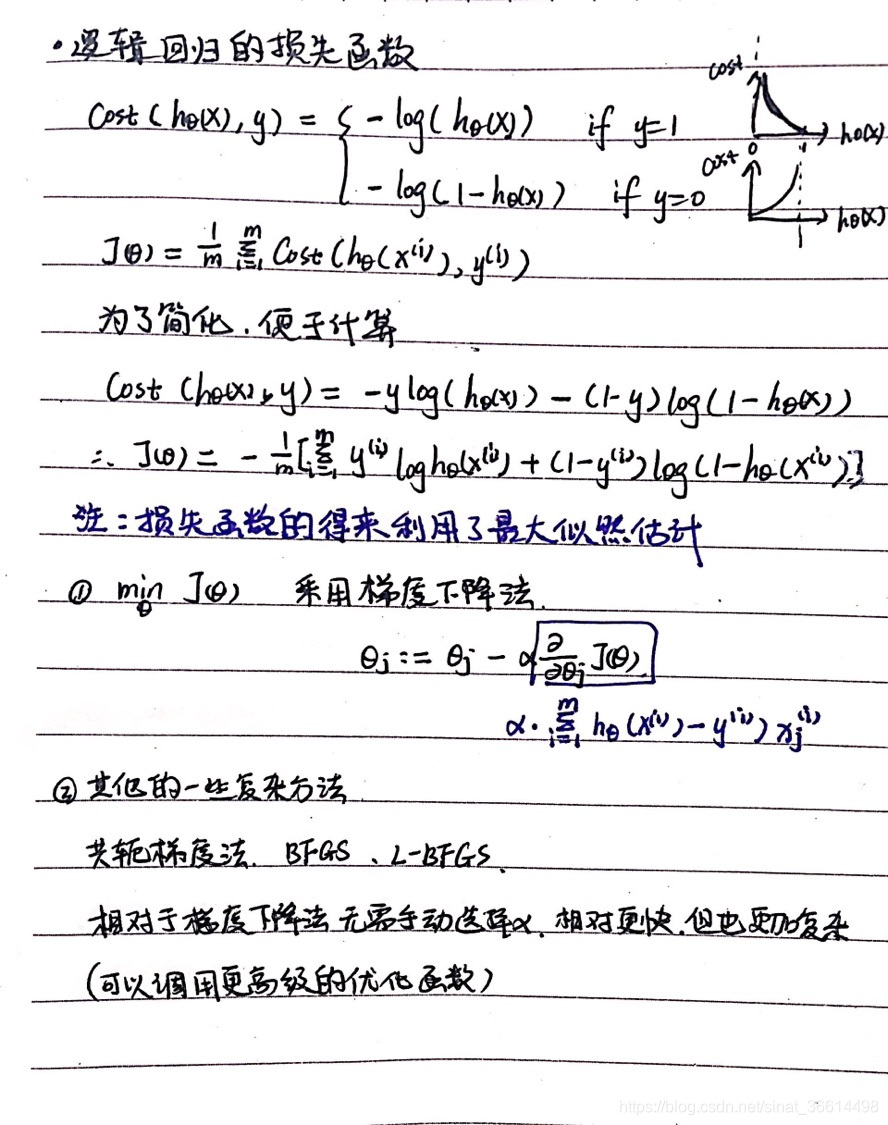

2.逻辑回归的损失函数与优化

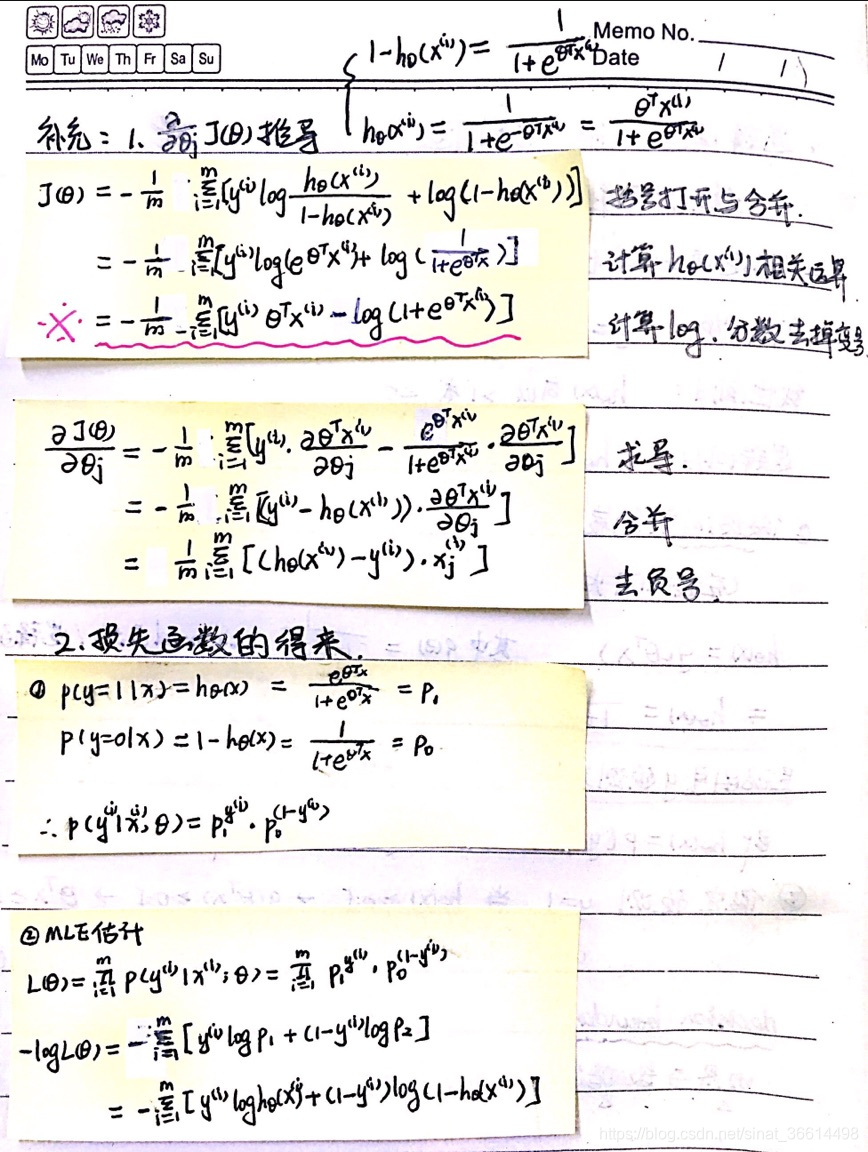

上图中,有两个问题并在下图中给出具体解答

①梯度下降法的求导

②损失函数的得来:MLE最大似然估计

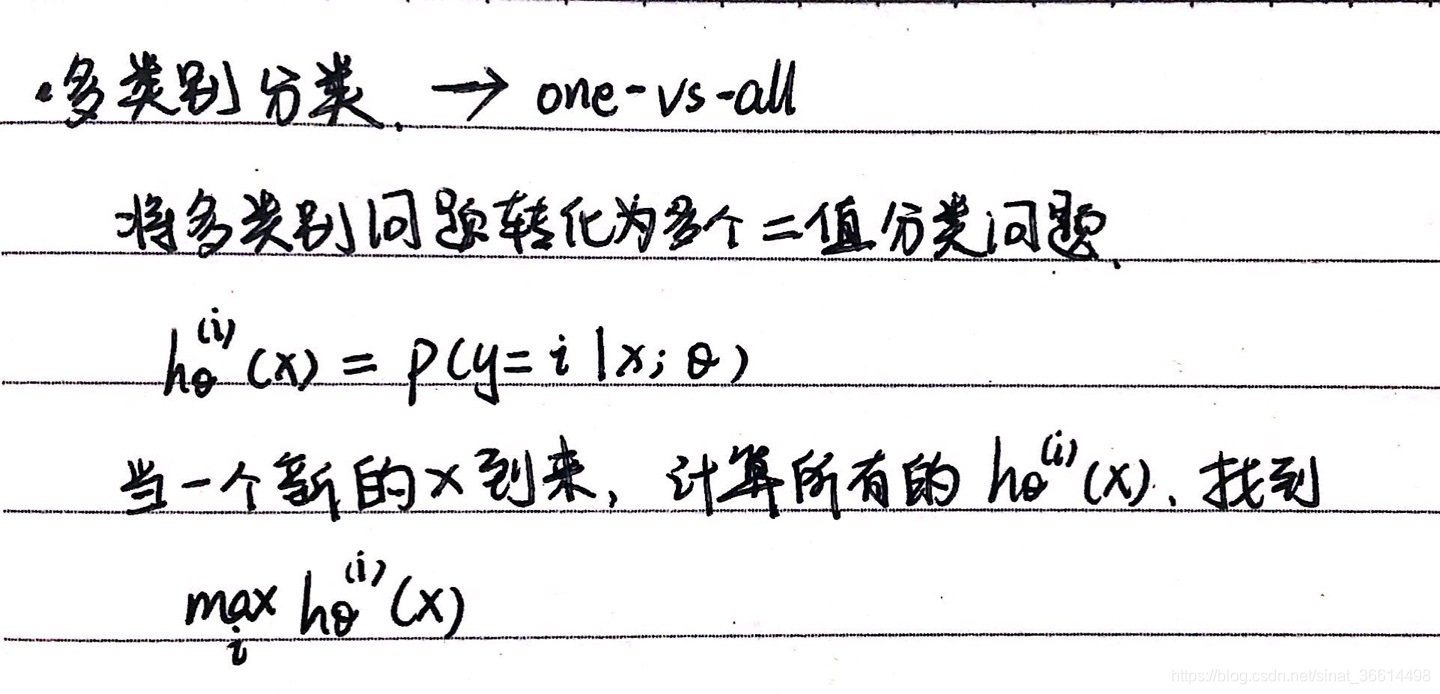

3.利用逻辑回归解决多类别分类——one-vs-all

具体案例参见课程图片

引申学习,对比one-vs-all与one-vs-one

①one-vs-all:也可以说是one-vs-rest,在这种策略中,会建立n个二分类器,每个分类器将其中一个类别定义为正类,将其他rest类别定义为负类。进行预测时,利用这n个二分类器进行分类,得到新数据x属于当前类的概率,并选择其中概率最大的一个类别作为最终的预测结果。

缺点:存在偏差。

②one-vs-one:在这种策略中,会针对两两类别建立二分类器,得到k=n*(n-1)/2个分类器。进行预测时,依次使用这k个分类器进行分类,每次分类相当于一次投票,分类结果是哪个就相当于对哪个类投了一票。在使用全部k个分类器进行分类后,相当于进行了k次投票,选择得票最多的那个类作为最终分类结果。

缺点:代价相对大。

本文深入解析吴恩达机器学习课程中的逻辑回归概念,探讨其在二分类与多分类问题中的应用,包括sigmoid函数、梯度下降法、损失函数及one-vs-all策略。

本文深入解析吴恩达机器学习课程中的逻辑回归概念,探讨其在二分类与多分类问题中的应用,包括sigmoid函数、梯度下降法、损失函数及one-vs-all策略。

452

452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?