一、本文介绍

本文给大家介绍EfficientViM新型轻量级视觉Mamba优化YOLOv12模型!“不需要安装mamba环境也可以运行!”。EfficientViM 模块通过减少计算复杂度、优化内存使用、提升目标检测精度和加速推理,显著改进了 YOLOv12 在目标检测中的表现。适应各种目标检测场景,特别是在实时检测任务中。具体怎么使用请看全文!

YOLOv12专栏改进目录:YOLOv12改进包含各种卷积、主干网络、各种注意力机制、检测头、损失函数、Neck改进、小目标检测、二次创新模块、A2C2f二次创新、独家创新等几百种创新点改进。

全新YOLOv12改进专栏订阅链接:全新YOLOv12创新改进高效涨点+永久更新中(至少500+改进)+高效跑实验发论文

本文目录

1.首先在ultralytics/nn/newsAddmodules创建一个.py文件

2.在ultralytics/nn/newsAddmodules/__init__.py中引用

二、EfficientViM 模块介绍

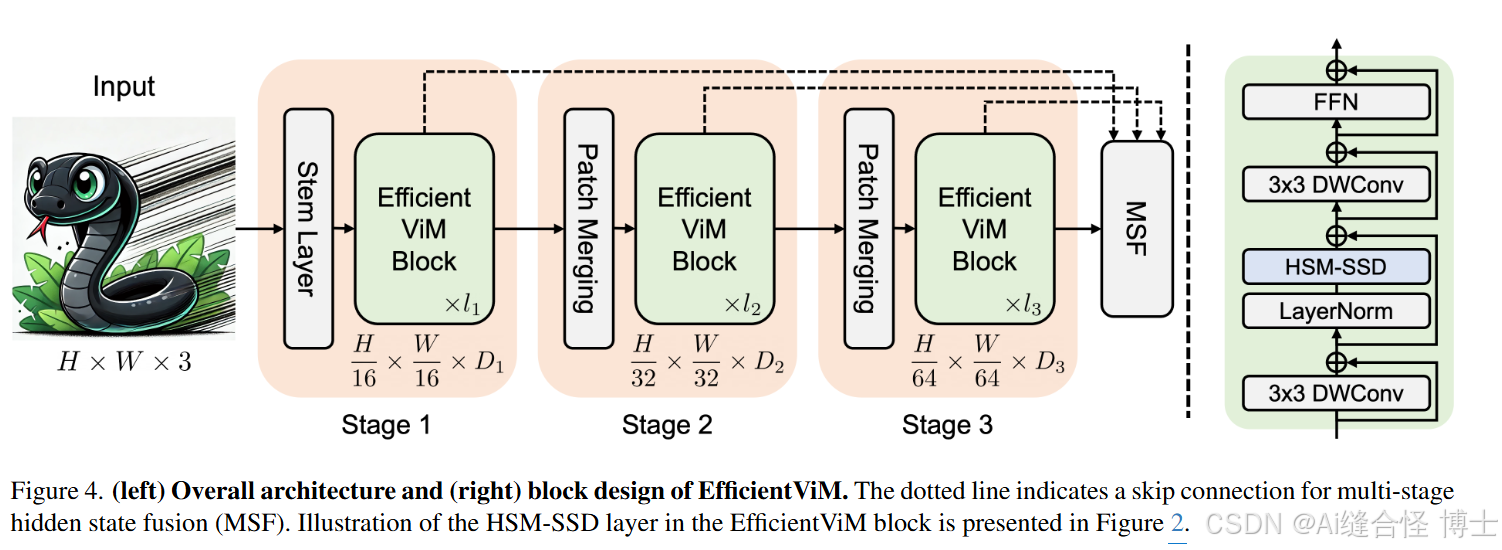

摘要:为了在资源受限的环境中部署神经网络,先前的工作构建了轻量级架构,利用卷积和注意力机制分别捕获局部和全局依赖关系。最近,状态空间模型 (state space model, SSM) 已经成为一种有效的全局交互操作,其优势在于在 tokens 数量上具有良好的线性计算成本。为了利用 SSM 的有效性,我们引入了 Efficient Vision Mamba (EfficientViM),这是一种基于 hidden state mixer-based state space duality (HSM-SSD) 的新型架构,它能有效地捕获全局依赖关系,并进一步降低计算成本。通过观察到 SSD 层的运行时间受输入序列上的线性投影驱动,我们重新设计了原始的 SSD 层,以在 HSM-SSD 层中的压缩隐藏状态内执行通道混合 (channel mixing) 操作。此外,我们提出了多阶段隐藏状态融合 (multi-stage hidden state fusion) ,以增强隐藏状态的表示能力,并提供设计来缓解由内存限制操作引起的瓶颈。因此,EfficientViM 系列在 ImageNet-1k 上实现了新的最先

订阅专栏 解锁全文

订阅专栏 解锁全文

296

296

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?