关注“心仪脑”查看更多脑科学知识的分享。

许多眼动仪软件中,采集完的数据列表中有个一个百分比指标:Gaze Samples. 这个指标是什么含义,它等于数据质量吗?

Gaze Samples是什么

Gaze Samples也称为有效采样率,指的是可以计算出视线落点(Gaze point)的采样次数占总采样次数的比例。

我们知道眼动仪采样时会通过高速摄像机拍摄被试眼球,然后内置算法通过眼球照片计算出视线落点,所以Gaze Samples也就是正确识别到眼球的采样次数占总采样次数的比例。理想情况下可以达到100%,但实际采集过程中通常会由于被试眨眼、看向别处或者头动超过眼动仪采集范围等原因造成大约10%的丢失。

Gaze Samples怎么算

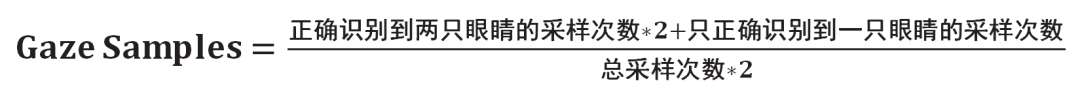

不同的眼动仪软件对于视线落点的算法不同,有的眼动仪采样时必须正确识别到两个眼球,计算两眼视线落点的均值作为此次采样的视线落点;而有的眼动仪在正确识别到两只眼睛时取两眼均值作为视线落点,只识别到一只眼睛时则以该眼的视线落点作为此次采样的视线落点。也有眼动仪的软件可以在设置中对两种算法进行切换。

对于第一种眼动仪软件:

对于第二种眼动仪软件:

眼动数据有效采样率与数据质量的关系解析

眼动数据有效采样率与数据质量的关系解析

眼动仪的Gaze Samples代表有效采样率,即正确识别到眼球的采样次数占比。它受算法和实验设计影响,但并不直接等同于数据质量。数据质量还涉及实验设计等因素,Gaze Samples仅与其有关联性,而非评判标准。

眼动仪的Gaze Samples代表有效采样率,即正确识别到眼球的采样次数占比。它受算法和实验设计影响,但并不直接等同于数据质量。数据质量还涉及实验设计等因素,Gaze Samples仅与其有关联性,而非评判标准。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6388

6388

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?