目录

阶段二:模型转换(Model Conversion & Export)

阶段三:部署与集成(Deployment & Integration)

三、 一个具体的例子:在Android手机上部署图像分类模型

摘要: 随着物联网、人工智能、5G等技术的飞速发展,智能终端已从单一的通信工具演变为集计算、感知、连接和数据交互于一体的综合性入口,深刻重塑着个人生活、产业发展和社会治理模式。本文系统性地研究了智能终端的三大核心维度:首先,从形态与功能出发,将其划分为消费级、工业级和边缘计算终端三大类型并细化其子类;其次,深入剖析了各类终端在生活、生产、公共服务等领域的典型使用场景;最后,前瞻性地探讨了智能终端在未来数字化进程中作为数据采集触点、AI能力载体、产业升级支点的核心赋能方向。本研究旨在为智能终端的产业创新和跨领域融合应用提供理论参考和实践指引。

关键词: 智能终端;物联网;人工智能;人机交互;产业赋能;数字化转型

1. 引言

智能终端(Smart Devices)是指具备信息采集、处理、连接和交互能力,可接入网络并提供智能化服务的电子设备。其演进历程从早期的个人电脑、智能手机,扩展到如今无处不在的智能穿戴、智能家居、工业传感器等,其内涵和外延正经历爆发式增长。智能终端不再是被动的工具,而是主动的“数字器官”,是物理世界与数字世界发生化学反应的关键触点。它们实时生成海量数据、本地化部署算法模型、无缝连接云边端协同网络,构成了数字经济时代的新型基础设施。因此,系统性地梳理智能终端的类型、厘清其应用场景、并洞察其未来赋能方向,对于把握技术发展趋势、推动产业转型升级具有重要的理论和现实意义。

2. 智能终端的主要类型

根据其核心功能、应用领域和技术架构,智能终端可划分为以下三大类型:

2.1 消费级智能终端

此类终端面向广大消费者,聚焦于提升生活体验、提供娱乐和便捷服务。

-

移动智能终端: 智能手机、平板电脑等,是个人计算和通信的核心。

-

智能可穿戴设备: 智能手表、智能手环、智能眼镜等,专注于个人健康监测、运动管理和场景化信息提示。

-

智能家居设备: 智能音箱、智能家电(冰箱、空调、扫地机器人)、智能安防(门锁、摄像头)等,构建智慧家庭生态,实现环境自动控制与远程管理。

-

其他新兴消费终端: AR/VR头显、服务机器人等,提供沉浸式体验和个性化服务。

2.2 工业级/产业级智能终端

此类终端服务于工业制造、农业、物流等B端领域,强调可靠性、耐用性和专用性。

-

工业数据采集终端: 条码/RFID扫描器、工业传感器、DTU(数据传输单元),用于采集生产现场的设备状态、环境参数、物料信息等。

-

工业控制与交互终端: 工业平板电脑、工控机、智能机械臂、AGV(自动导引运输车)控制单元,用于执行控制指令和人机交互。

-

专业领域终端: 农业无人机、物流无人机、智能抄表终端、医疗手持PDA等,针对特定行业需求定制。

2.3 边缘计算终端

此类终端是计算能力下沉的体现,具备较强的本地计算、存储和决策能力,是连接云与物的桥梁。

-

边缘网关/控制器: 汇聚多种协议的网络数据,进行协议转换、边缘计算和策略执行,实现本地自治,减轻云端压力。

-

AI边缘计算盒子(AI Box): 内嵌AI加速芯片,可直接部署AI推理模型,用于视频图像分析、语音识别等实时性要求高的场景。

-

智能网联汽车终端: 车载智能中控、T-Box、域控制器等,是实现车联网、自动驾驶和车载信息服务的关键。

3. 智能终端的核心使用场景

3.1 智慧生活场景

智能终端构建了“以人为中心”的个性化生活空间。智能穿戴设备7x24小时监测用户健康数据;智能手机作为控制中枢,联动全屋智能家电创造舒适、节能、安全的居住环境;AR/VR设备则提供了全新的社交与娱乐方式。

3.2 智能制造场景

在工业领域,智能终端是实现“工业4.0”和“智能工厂”的基石。工业传感器实时监控设备预测性维护;AGV和机械臂协同完成柔性生产;工人通过AR眼镜接收远程专家指导和图谱化作业指令,极大提升生产效率和安全性。

3.3 智慧城市与公共服务场景

智能终端助力城市治理现代化。智能摄像头和各类传感器构成城市感知网络,用于交通流量监控、公共安全预警、环境监测;智能抄表终端实现能源数据的自动采集;政务自助服务终端为市民提供便捷的“一网通办”体验。

3.4 智慧商业场景

在零售、物流等行业,智能终端重塑业务流程。智能POS机、自助收银终端提升结算效率;物流手持PDA实现了包裹从分拣、运输到配送的全流程追踪和管理;商用服务机器人开始承担导购、配送、清洁等任务。

4. 智能终端的未来赋能方向

4.1 赋能方向一:成为全域数据采集的“神经末梢”

未来,智能终端将集成更多、更精密的传感器,实现对物理世界更全面、更细微的感知。从温度、湿度、运动到化学成分、生物特征,终端将成为构建数字孪生世界不可或缺的数据源头,为上层AI分析和决策提供燃料。

4.2 赋能方向二:成为分布式AI能力的“承载实体”

随着端侧芯片算力的提升和模型轻量化技术的发展,AI推理能力将大规模下沉至终端。终端设备将从单纯的“数据采集器”进化为具有本地实时决策能力的“智能体”,实现更低延迟、更高隐私保护的智能服务,形成“云-边-端”协同的分布式智能体系。

4.3 赋能方向三:成为产业数字化升级的“关键支点”

智能终端是传统产业与数字技术融合的物理接口。通过将传统设备“智能化”改造(如加装传感器和智能模块),可以盘活存量资产,释放数据价值,驱动业务流程再造和商业模式创新,最终推动整个产业的数字化、网络化、智能化转型。

4.4 赋能方向四:成为沉浸式人机交互的“创新入口”

随着语音、手势、眼动追踪等自然交互技术的成熟,以及AR/VR终端的普及,智能终端将打破屏幕的限制,提供更直观、更沉浸式的人机交互体验,重塑人们获取信息和与数字世界互动的方式。

5. 结论与展望

智能终端作为数字世界的入口和触点,其形态正日趋多样化,其应用场景正渗透至社会的每一个角落。当前,我们正处在一个从“万物互联”向“万物智联”演进的关键节点。未来的智能终端将不再是功能单一的孤立设备,而是高度集成化、智能化、场景化的生态组合。它们将无声地嵌入环境,主动感知需求,协同提供服务。其发展的核心驱动力将从技术硬件创新转向场景价值挖掘和生态协同能力。如何围绕用户本质需求,设计出更自然、更可靠、更安全的智能终端体验,并通过开放平台促进不同终端间的数据互通与服务协同,将是产业界需要持续探索的核心议题。智能终端的终极赋能方向,是成为人类能力的延伸,无缝融入生活,推动社会向更高水平的智能文明迈进。

案例

算法端侧部署移植详解

一、 核心挑战:为何不能直接部署训练好的模型?

在服务器上训练好的模型(如大型深度学习模型)直接放到资源受限的终端上运行会面临巨大挑战,主要体现在:

-

算力限制: 终端芯片(如MCU、低功耗NPU)的算力远低于服务器GPU,无法承受大型模型的复杂计算。

-

内存限制: 模型的权重参数和中间计算结果(激活值)会占用大量内存。终端设备的RAM和Flash存储空间有限。

-

功耗限制: 复杂的计算会急剧增加功耗,对于电池供电的移动设备或物联网设备,续航是关键指标。

-

延迟要求: 很多终端应用(如自动驾驶的障碍物识别、工业质检)要求毫秒级的实时响应,无法承受网络传输和云端推理的延迟。

-

隐私与安全: 在本地终端处理数据可以避免敏感数据(如人脸、语音)上传到云端,满足隐私保护和数据安全法规的要求。

-

网络依赖性: 终端设备并不总是有稳定、高速的网络连接,离线推理能力至关重要。

二、 部署流程:从实验室模型到终端产品

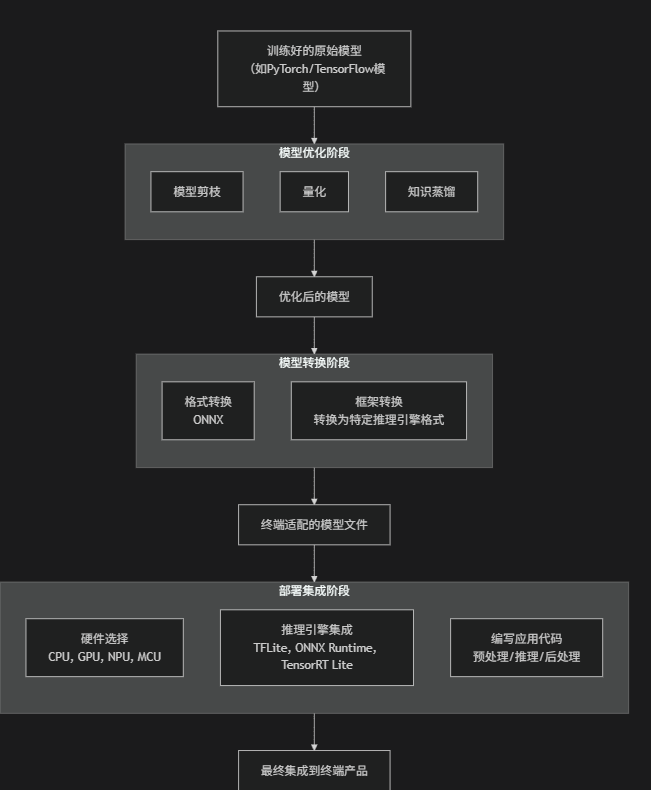

端侧部署是一个完整的流水线(Pipeline),其核心流程如下图所示,主要包含模型优化、转换和部署三大阶段:

图表

代码

下载

部署集成阶段

硬件选择

CPU, GPU, NPU, MCU

推理引擎集成

TFLite, ONNX Runtime, TensorRT Lite

编写应用代码

预处理/推理/后处理

模型转换阶段

格式转换

ONNX

框架转换

转换为特定推理引擎格式

模型优化阶段

模型剪枝

量化

知识蒸馏

训练好的原始模型

(如PyTorch/TensorFlow模型)

优化后的模型

终端适配的模型文件

最终集成到终端产品

下面我们对每个阶段进行详细解读:

阶段一:模型优化(Model Optimization)

此阶段目标是在尽量保持模型精度的前提下,极大降低其计算量和参数量。主要技术有:

-

模型剪枝(Pruning):

-

原理: 移除模型中“不重要”的权重(如权重值接近0的连接)或整个神经元通道(Channel Pruning)。

-

效果: 使模型变得稀疏,减少参数数量和计算量,便于压缩。

-

类比: 给模型“瘦身”,剪掉冗余的枝丫。

-

-

量化(Quantization):

-

原理: 将模型中通常表示的32位浮点数(FP32)权重和激活值转换为低精度数据,如16位浮点数(FP16)、8位整数(INT8),甚至二进制(1bit)。

-

效果:

-

模型大小减少: INT8模型的大小约为FP32的1/4。

-

速度提升: 整数运算在硬件上通常比浮点运算快得多。

-

功耗降低: 对内存访问和计算操作的能耗更低。

-

-

这是端侧部署中最常用、最有效的技术之一。

-

-

知识蒸馏(Knowledge Distillation):

-

原理: 用一个庞大而精确的“教师模型”来指导一个小巧的“学生模型”进行学习,让学生模型模仿教师模型的行为(输出/logits)。

-

效果: 得到一个小巧但性能接近大模型的“学生模型”,非常适合部署。

-

-

模型设计(轻量化模型架构):

-

原理: 直接使用为终端设计的高效网络架构,如MobileNet系列、ShuffleNet系列、SqueezeNet、EfficientNet等。这些模型使用深度可分离卷积等技术,在参数量极少的情况下保持了较高精度。

-

阶段二:模型转换(Model Conversion & Export)

优化后的模型需要转换成终端推理框架能够识别的格式。

-

统一中间格式 - ONNX(Open Neural Network Exchange):

-

作用: ONNX是一个开放的模型表示标准。你可以将PyTorch、TensorFlow等框架训练好的模型先转换为ONNX格式,作为一个中间桥梁。

-

优势: 解耦了模型训练框架和终端部署框架,提高了互操作性。

-

-

目标格式转换:

-

将ONNX模型(或直接来自TF/PyTorch的模型)转换为特定终端推理引擎支持的格式。

-

示例:

-

TensorFlow Lite: 使用

TFLiteConverter将TensorFlow模型转换为.tflite格式。 -

PyTorch Mobile: 使用

torch.jit.trace或torch.jit.script将模型转换为TorchScript格式。 -

NVIDIA TensorRT: 将模型转换为TensorRT引擎计划(

.plan)。 -

其他: ONNX Runtime、OpenVINO等也都有各自的运行时格式。

-

-

阶段三:部署与集成(Deployment & Integration)

这是最终的工程实现阶段。

-

选择推理引擎(Inference Engine):

-

根据终端硬件和转换后的模型格式,选择合适的推理引擎库(通常由芯片厂商提供)。

-

常见推理引擎:

-

通用CPU: TFLite, ONNX Runtime, OpenVINO

-

移动端GPU: TFLite GPU Delegate, Core ML(Apple), NNAPI(Android)

-

专用AI加速器(NPU): 华为HiAI, 高通SNPE, 联发科NeuroPilot

-

微控制器(MCU): TFLite Micro(TensorFlow Lite for Microcontrollers), CMSIS-NN(Arm Cortex-M系列)

-

-

-

编写应用代码:

-

在终端应用程序(C++/Java/Kotlin/Swift/C)中集成推理引擎的SDK。

-

代码流程通常为:

-

预处理: 加载输入数据(如图片、音频),并将其处理成模型需要的格式(如缩放、归一化)。

-

推理: 调用推理引擎的API,将数据送入模型,执行计算,并获取输出。这是核心步骤。

-

后处理: 解析模型输出(如边界框、分类得分),将其转换为业务逻辑需要的结果。

-

-

-

性能调优:

-

尝试不同的优化技术组合(如剪枝+量化)。

-

利用硬件提供的特定算子库和加速指令。

-

优化数据流水线,避免内存拷贝成为瓶颈。

-

三、 一个具体的例子:在Android手机上部署图像分类模型

-

训练: 使用TensorFlow在服务器上训练一个轻量化的MobileNetV2模型(用于图像分类)。

-

优化与转换:

-

对训练好的模型进行全整数量化(Post-training quantization),得到INT8版本的模型。

-

使用

TFLiteConverter将模型转换为.tflite格式。

-

-

部署:

-

在Android Studio项目中引入

org.tensorflow:tensorflow-lite依赖库。 -

将

.tflite模型文件放入App的assets目录。

-

-

集成:

-

编写Java代码:使用

Interpreter类加载TFLite模型。 -

预处理: 从摄像头获取图像,将其缩放到224x224,并转换为

ByteBuffer。 -

推理: 调用

interpreter.run(inputBuffer, outputBuffer)。 -

后处理: 从

outputBuffer中读取概率数组,找到最大概率对应的标签,显示在UI上。

-

四、 总结

将算法部署到终端是一个“带着镣铐跳舞”的过程,需要在模型精度、速度、功耗和资源占用之间找到最佳平衡点。它要求算法工程师不仅懂机器学习,还要了解硬件、编译器和软件工程的知识。随着专用AI芯片的普及和推理引擎的不断成熟,端侧AI部署正变得越来越容易,但其核心思想——为资源受限的环境进行极致优化——将始终是成功的关键。

1286

1286

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?