一、Ollama安装部署

1)安装ollama

这里更新一下Ollama官网(最新)

官网下载:

打开Ollama官网:https://ollama.com/ 点击“Download”

阿里云盘下载:https://www.alipan.com/s/jiwVVjc7eYb 提取码: ft90

百度云盘下载:https://pan.baidu.com/s/1o1OcY0FkycxMpZ7Ho8_5oA?pwd=8cft 提取码:8cft

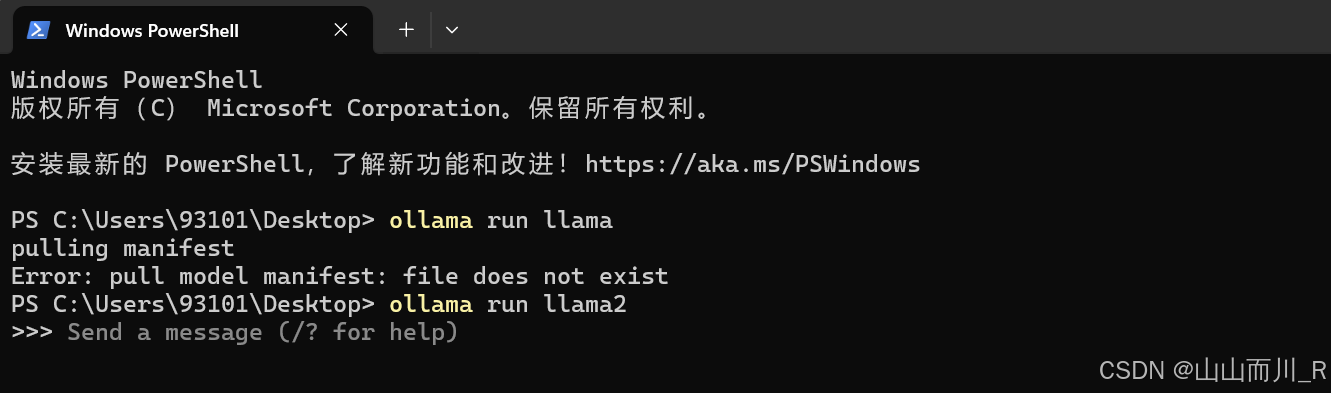

2、

ollama run llama2

3、启动与运行

在Ollama的终端界面中,键入命令Ollama serve,一键将Ollama设置为后端服务器模式,静待其为您的知识库服务。

Ollama serve 运行私有化大模型(基于ollama)

4、随时查看已经下载大模型

ollama list

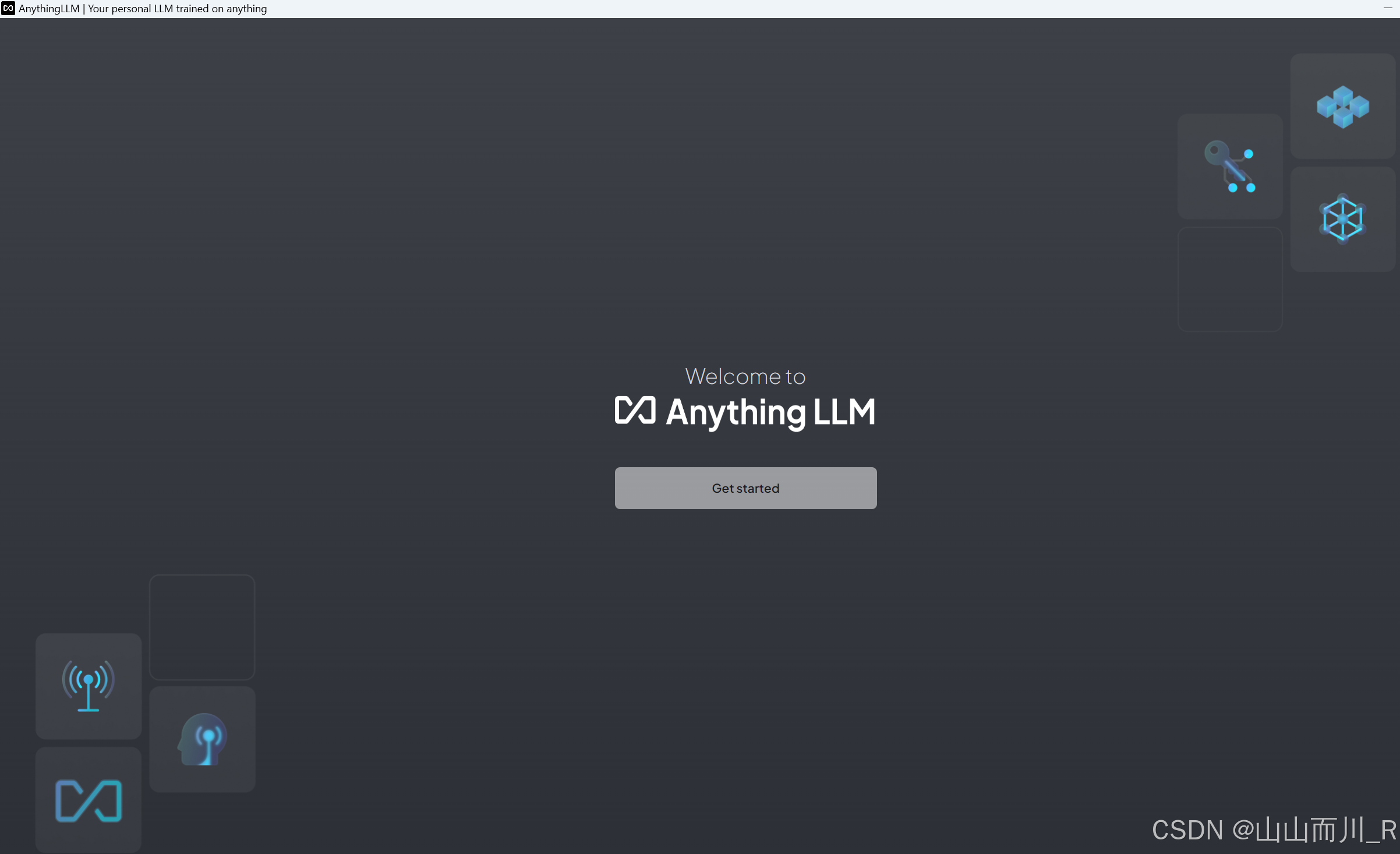

二、AnythingLLM 安装

1、AnythingLLM安装有很多方式,一是到官方网站(Download AnythingLLM for Desktop)下载桌面版,然后双击即可

(为啥有人说打不开呢,我刚试了下载没有问题呀?!可以正常下载!!)

搭建本地聊天工具(部署Anythingllm)

一个功能强大的大模型开发工具下载地址:

https://useanything.com/

(链接:https://pan.quark.cn/s/a9974a779650 提取码:jnBL)

2、安装也是一键安装,左面图标长这样,点击打开即可

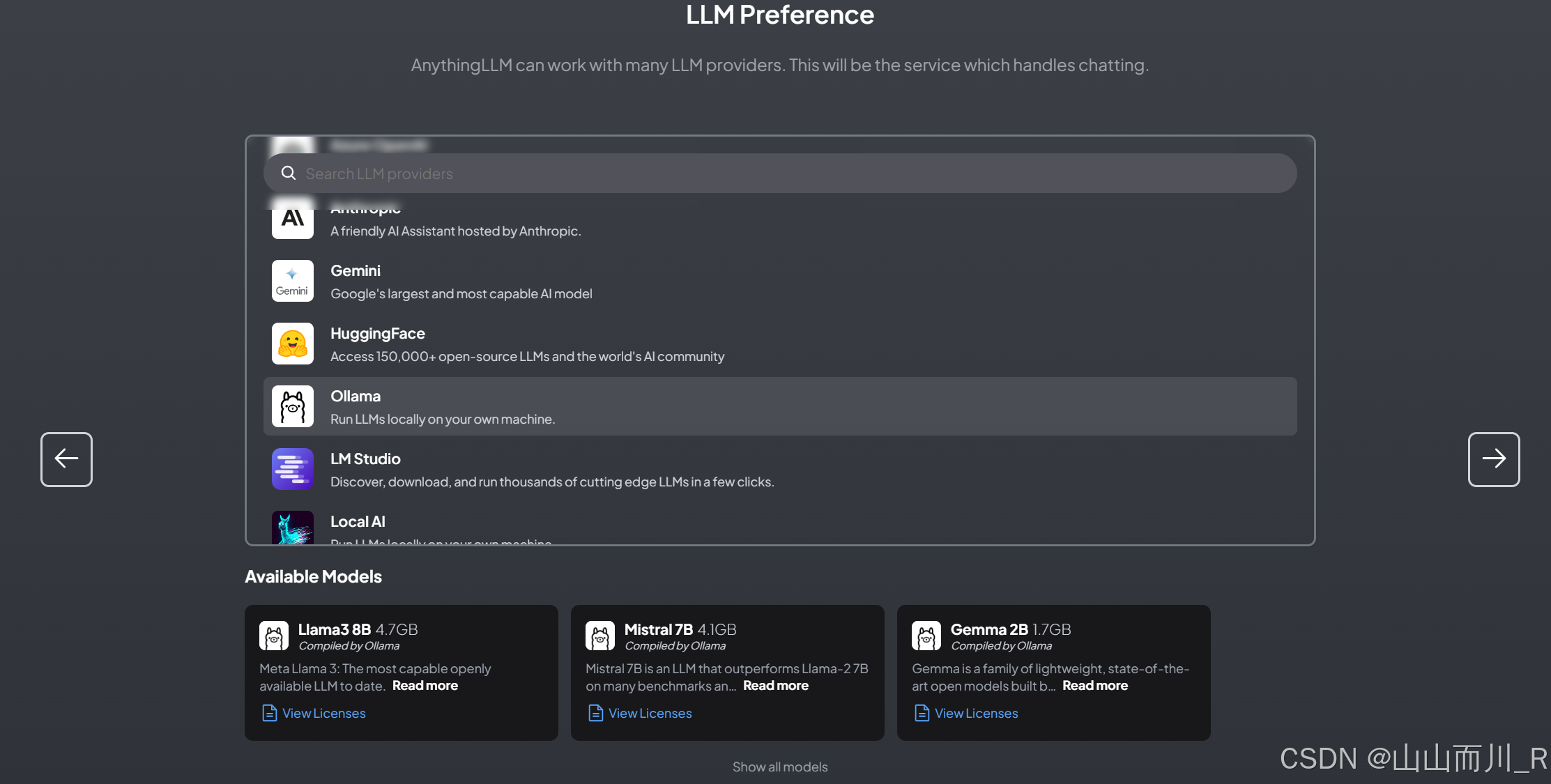

3、配置本地下载的大模型,先点击左下角的【配置】

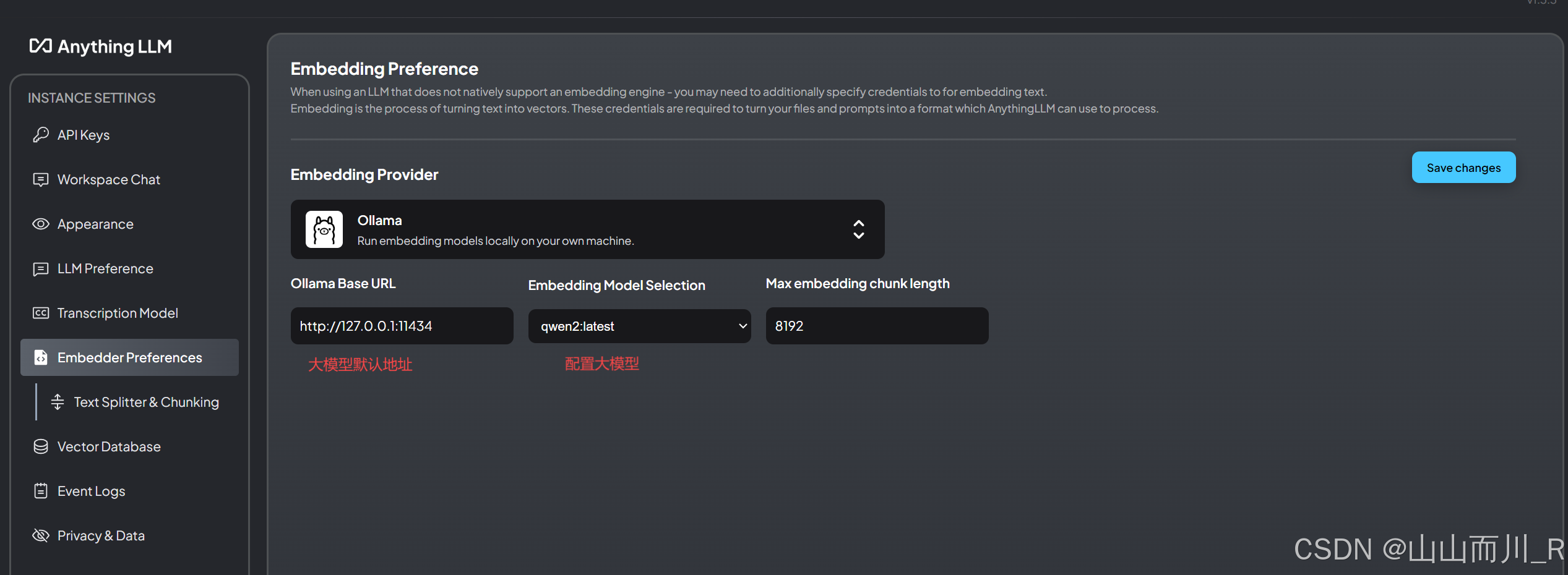

本地大模型默认地址:http://127.0.0.1:11434

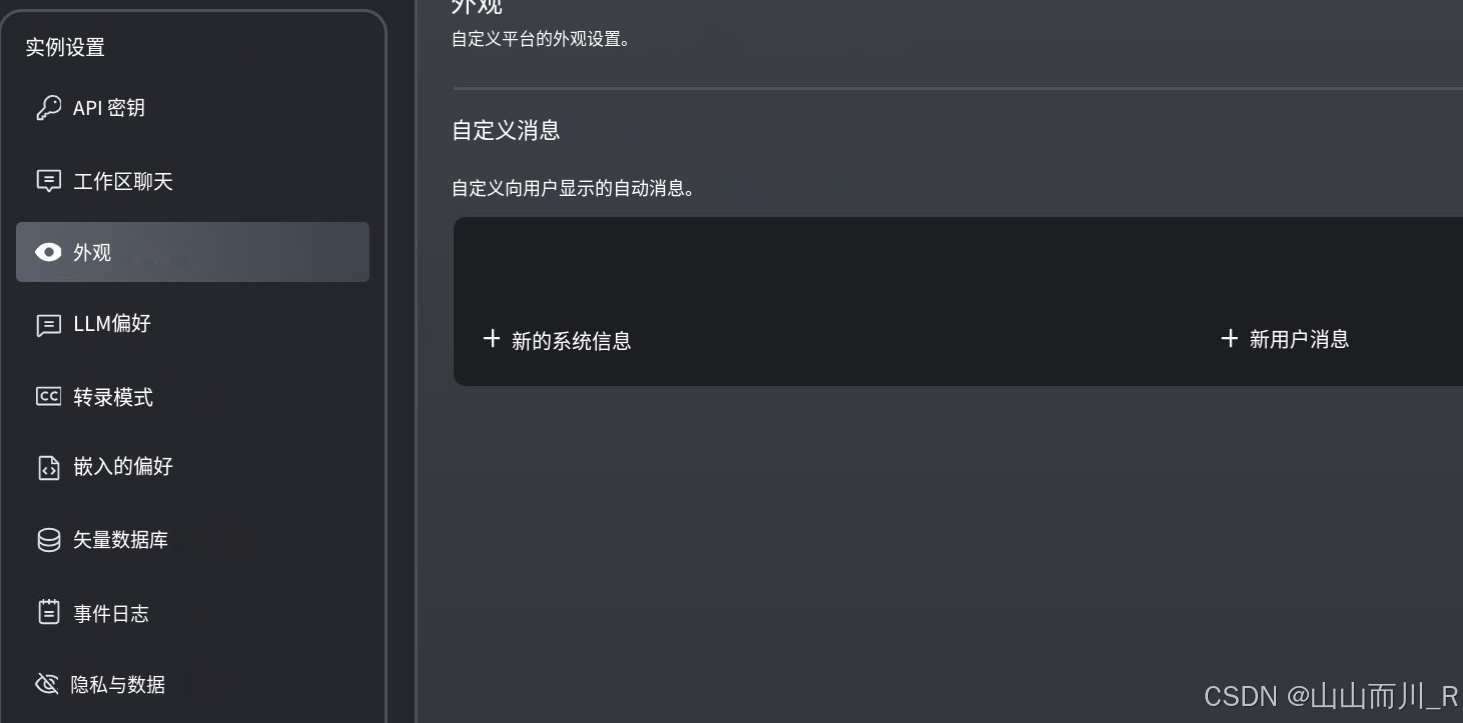

进来之后简单了解翻译一下

4、配置大模型:

5、到此我们已经完成了私有化大模型,聊天机器人的配置,点击左下角返回聊天界面

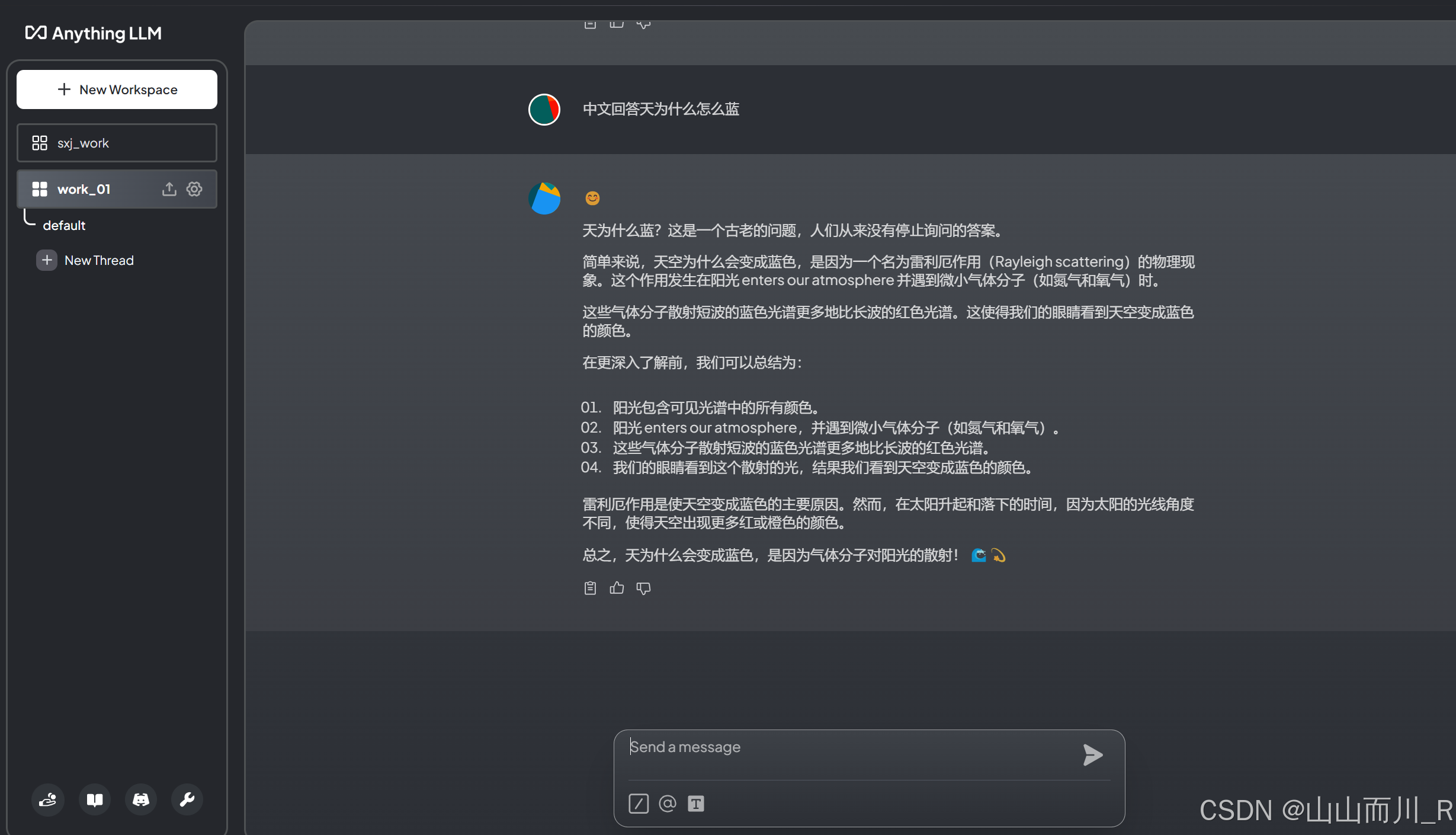

点击【New Workspace】新建一个聊天空间。

写个名字点【Save】

6、左侧点击进入你刚刚创建空间,然后开始和你专属的大模型聊天

三、搭建私有化知识库

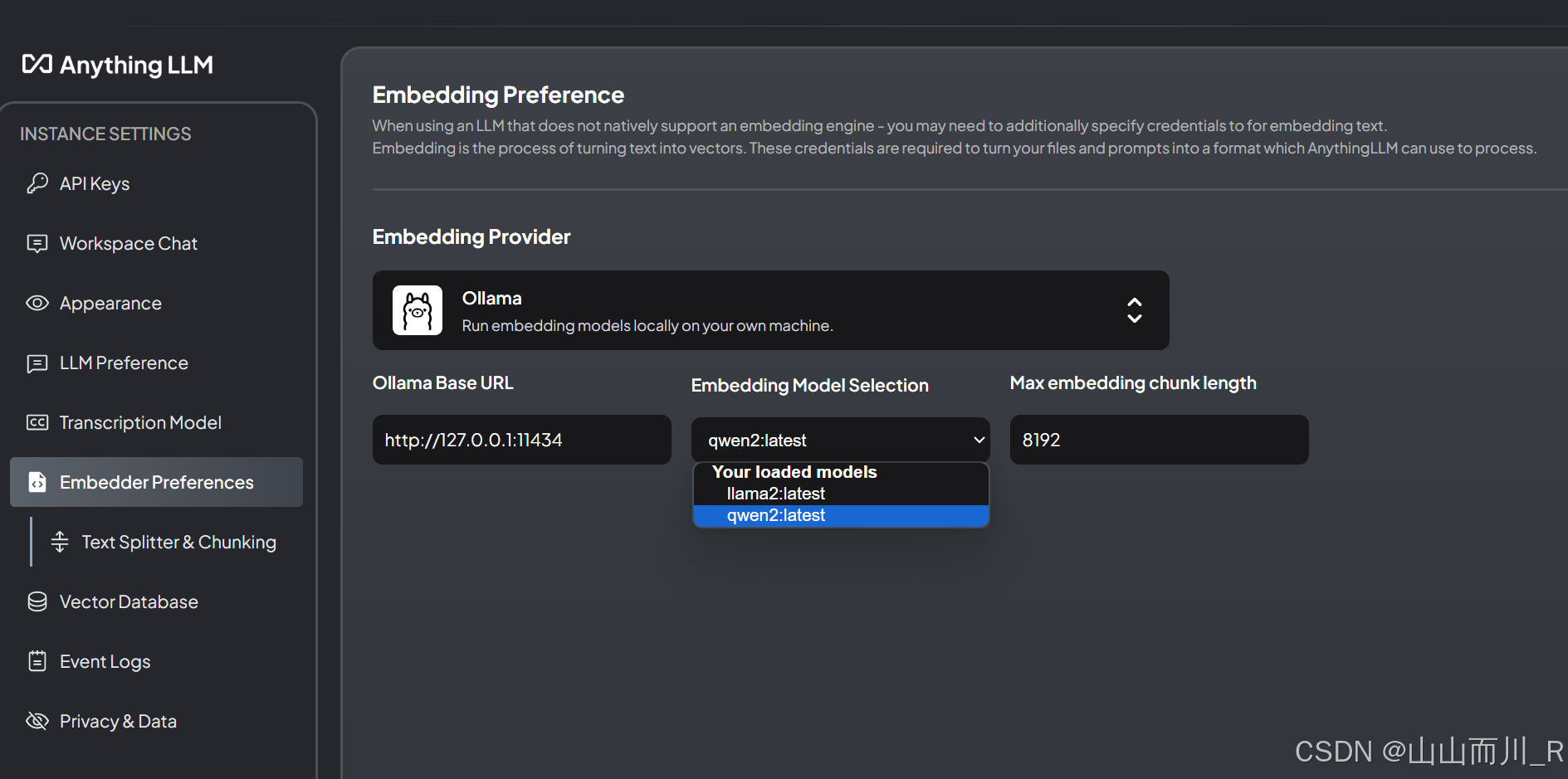

1、嵌入模型选择

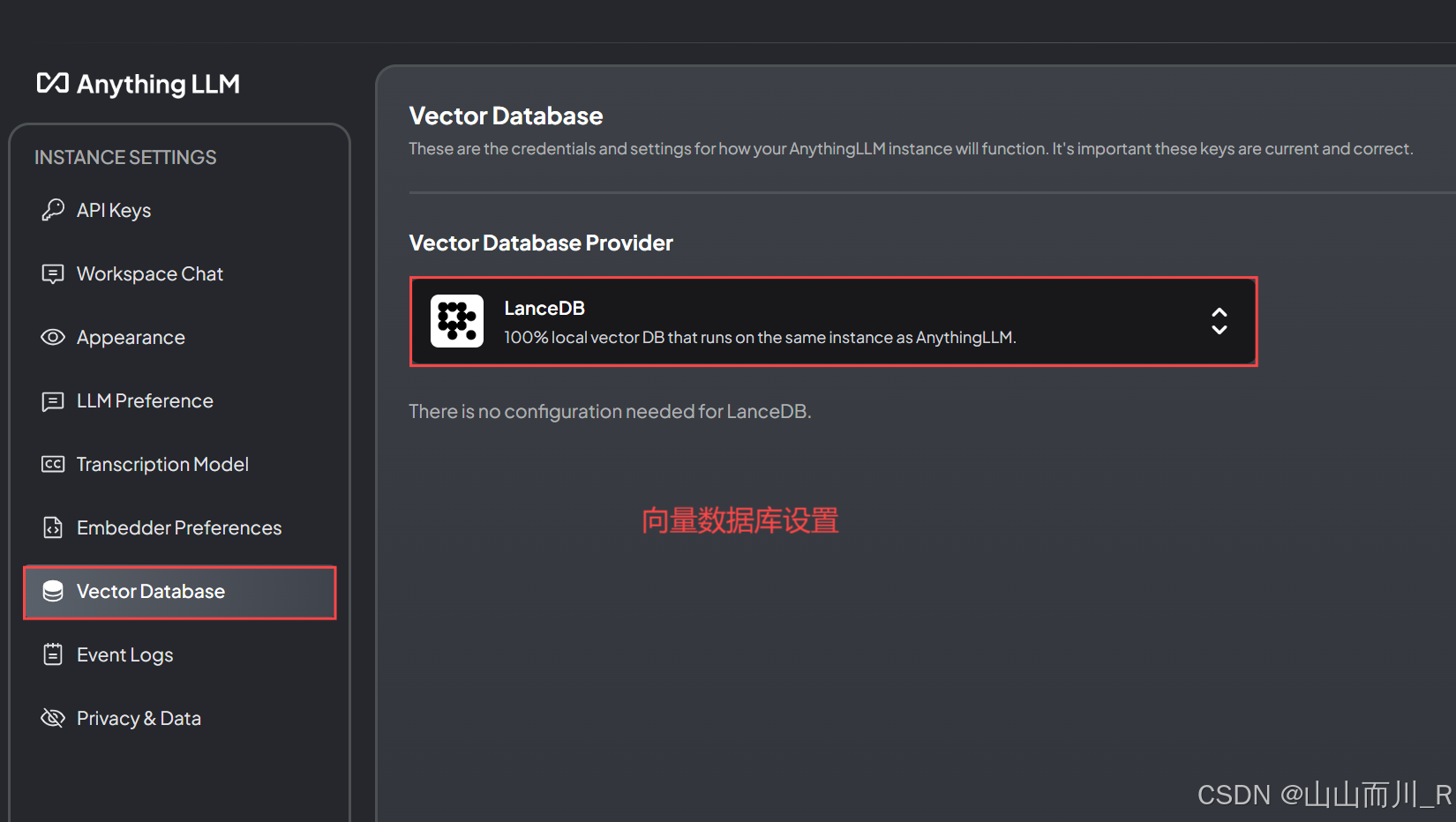

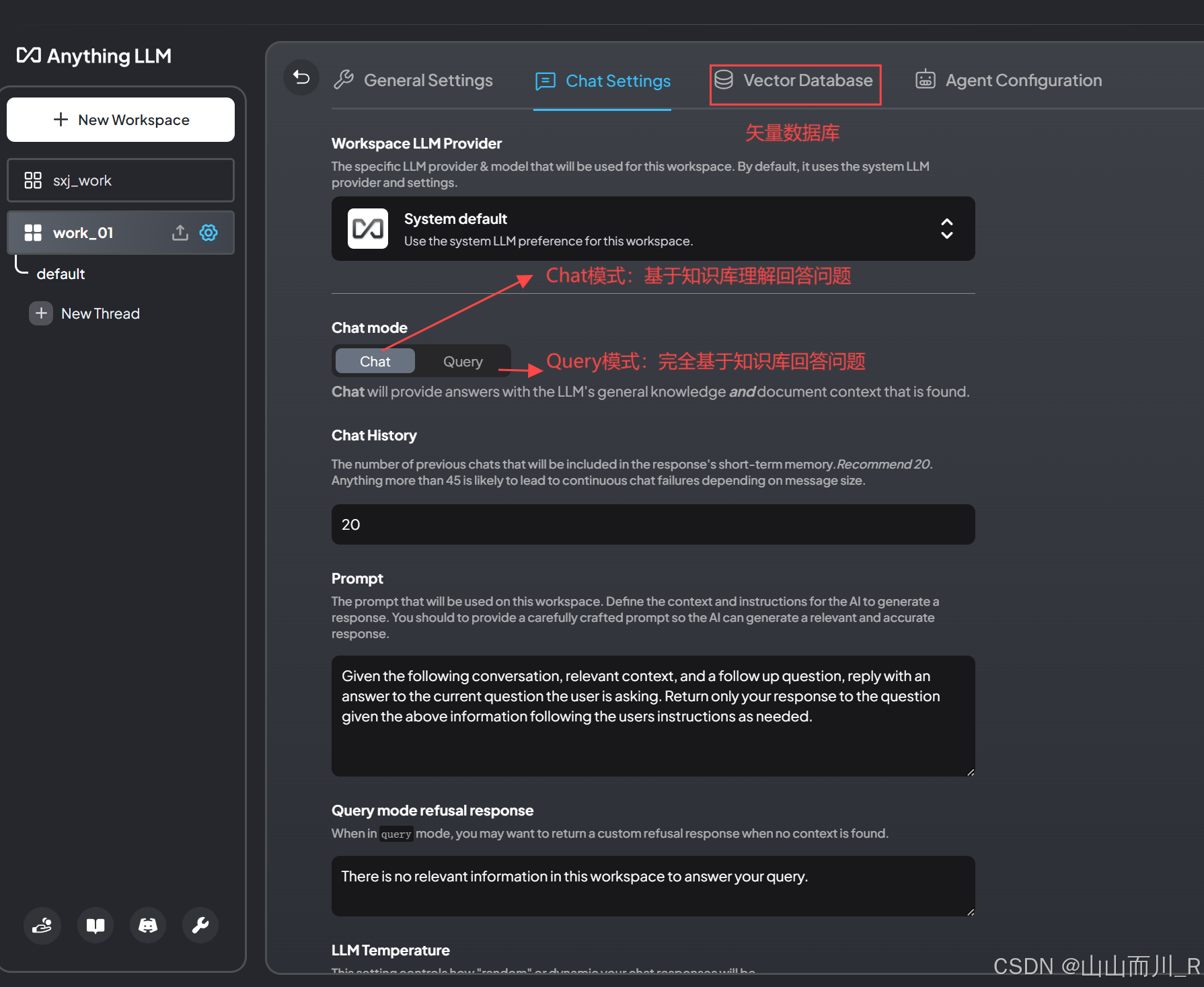

2、设置【向量数据库】

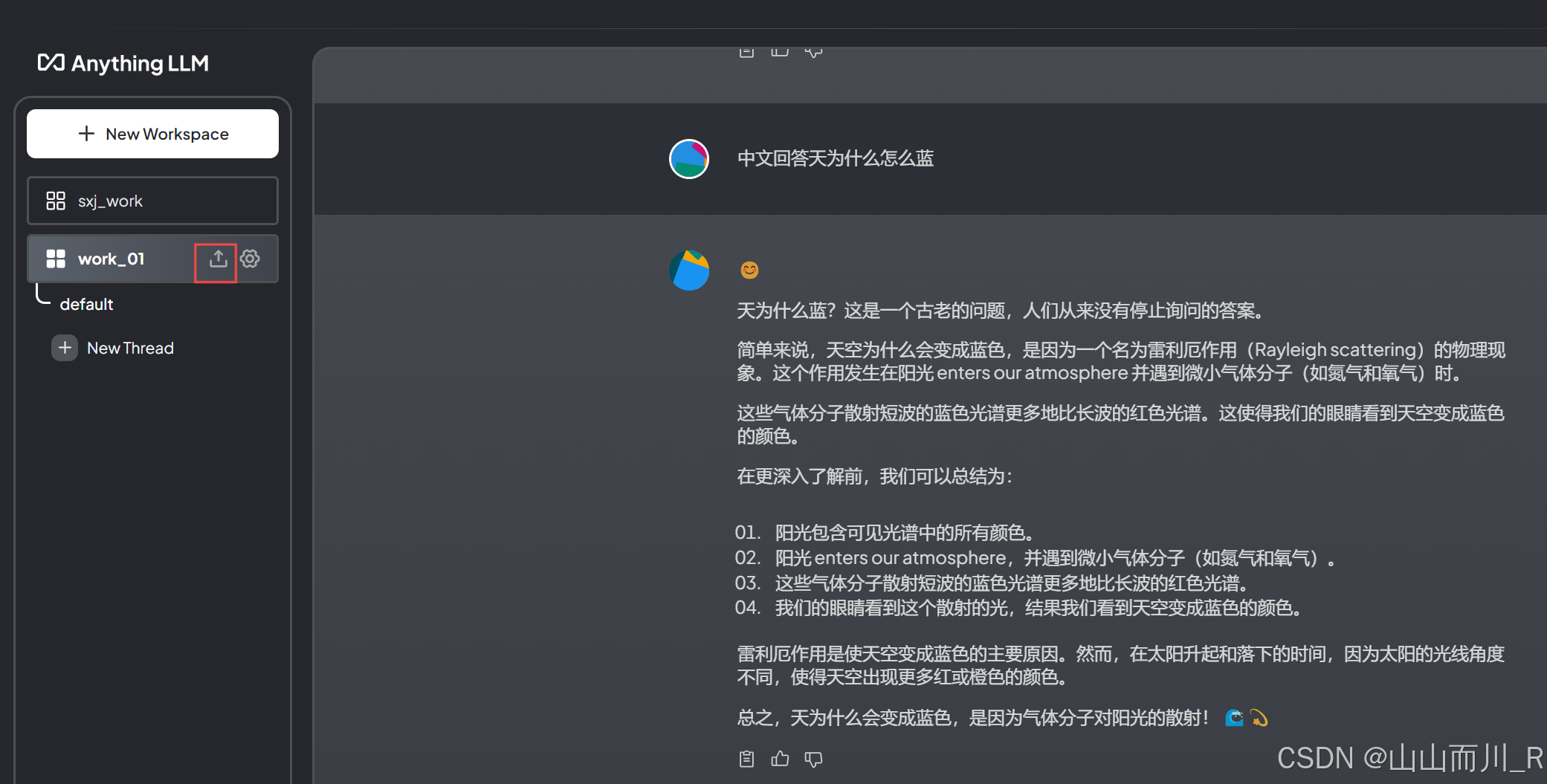

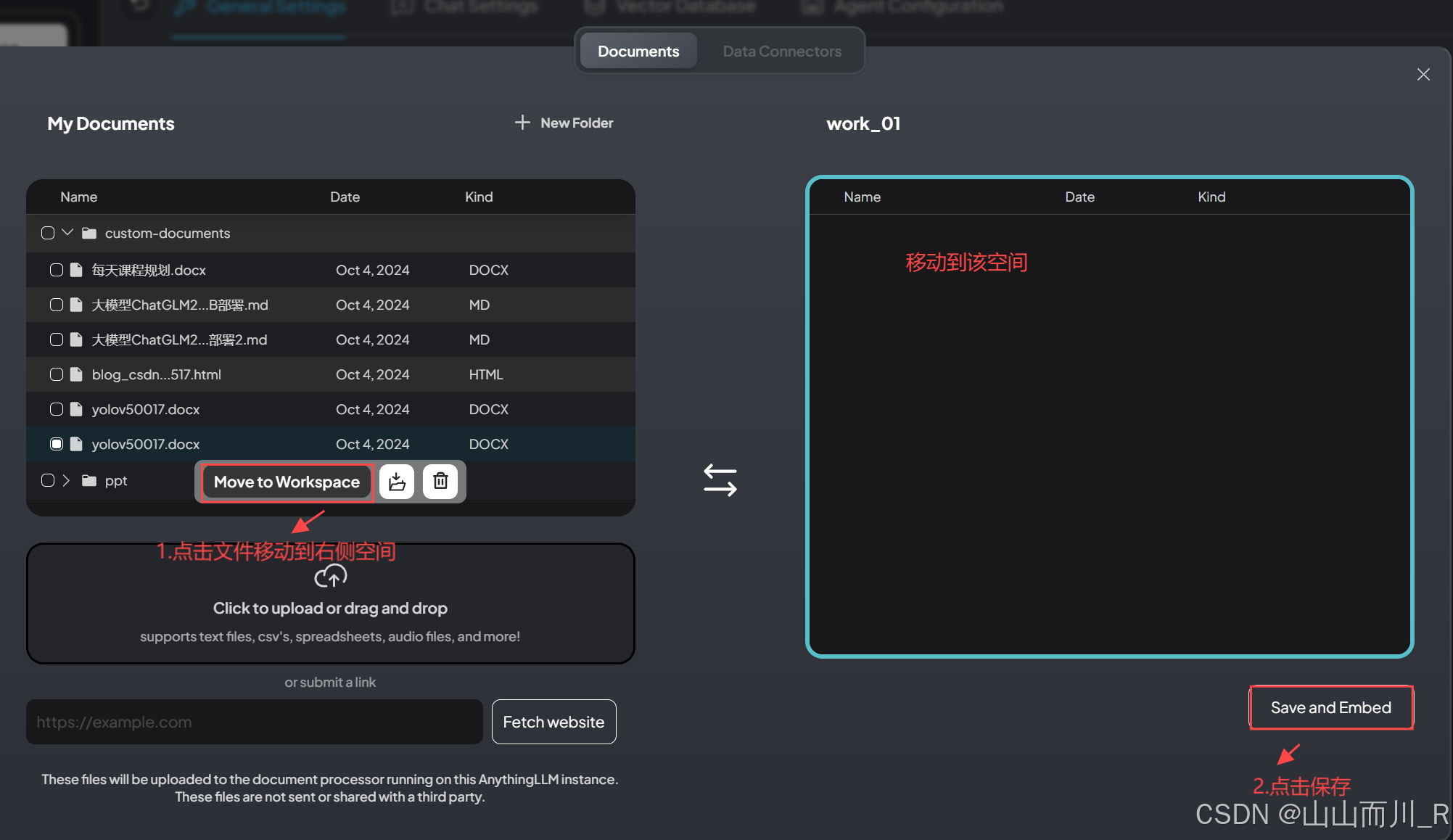

3、返回聊天空间,点击【上传按钮】如图

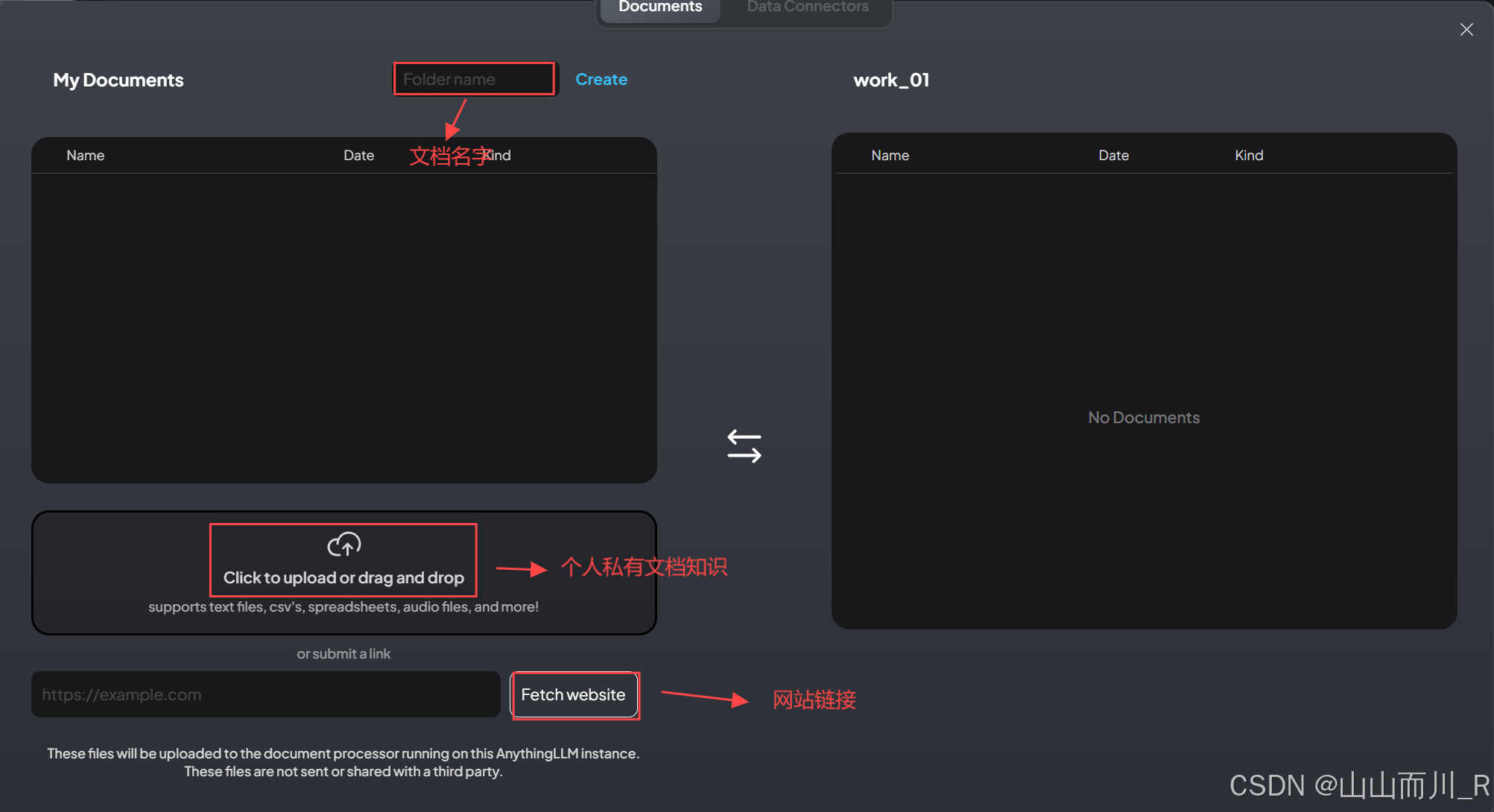

4、上传私有知识文档

5、点击保存

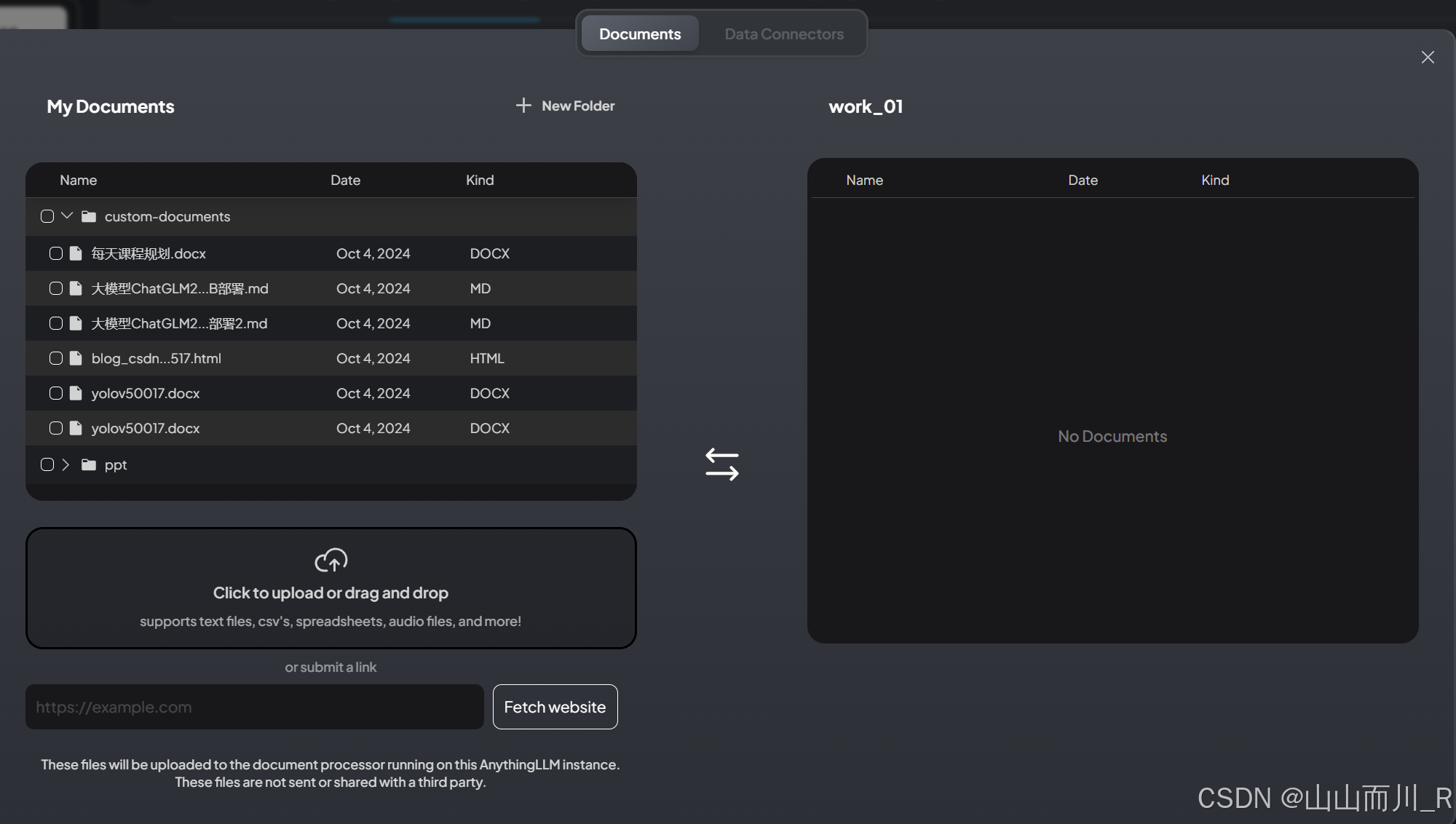

6、保存后有个数据向量化入库的过程。等到完成后右下角不会出现保存,同时文档已经在你的列表中,说明私有化知识库搭建完成了

7、设置知识库模式,两种模式

到此一个私有化知识库大模型搭建完成!

安装DeepSeek模型

版本:8b,(需要4.9GB空余空间)

ollama run deepseek-r1:8b版本:14b,(需要9GB空余空间)

ollama run deepseek-r1:14b

参考:小白速成教程:私有化大模型+知识库_私有大模型和知识库-优快云博客

参考:AI模型:windows本地运行下载安装ollama运行llama3、llama2、Google CodeGemma、gemma等可离线运行数据模型【自留记录】_ollama下载-优快云博客

1775

1775

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?