2025年末,AI领域迎来了一场思想地震。OpenAI前首席科学家、现Safe Superintelligence Inc. (SSI) 创始人Ilya Sutskever公开宣布 “Scaling时代已经终结” 。这一判断标志着AI发展范式的根本转变——从过去五年依赖算力与数据堆砌的“暴力美学”,重新回归到以研究为核心的“精巧设计”时代。

作为深度学习革命的关键人物,Ilya几乎定义了过去十年AI的发展方向。他的这一宣言不仅是对当前技术极限的承认,更是对未来AI架构演进的前瞻性判断。本文将深入解读Ilya倡导的新架构设计,分析其技术背景、设计原理及实现路径,为AI研究者与工程师提供全面的技术视角。

Scaling时代的辉煌与局限

预训练范式的成功逻辑

2012年至2020年属于AI研究时代,而2020年至2025年则进入了规模扩展(Scaling)时代。这一阶段的核心突破在于预训练(Pre-training)提供了一套可复用、几乎必然奏效的“配方”:准备足够的数据、算力和一个能撑住规模的模型结构,性能就会持续上升。

预训练的成功公式可以简化为:模型性能 = f(数据规模, 算力投入, 模型参数)

这套配方让大公司找到了风险极低的资源投资方式,催生了GPT系列、BERT、T5等大型预训练模型,也使得基于Transformer的架构成为自然语言处理的基石。(扩展阅读:初探注意力机制、来聊聊Q、K、V的计算、Transformer 中的注意力机制很优秀吗?、FlashAttention:突破Transformer内存瓶颈的革命性注意力优化技术)

Scaling时代的边际效应与根本瓶颈

然而,到了2025年,规模扩展的回报开始出现边际效应递减。Ilya明确指出:“规模法则正在接近极限。强化学习的算力消耗巨大,却并不能算作真正的‘扩展’。同时,扩展与浪费算力之间的界线变得模糊。”

Scaling时代的主要问题体现在:

-

数据瓶颈:预训练数据即将耗尽,高质量语料库面临枯竭。

-

评估失真:模型在评测集上表现优异,但实际应用能力不足。

-

泛化能力缺失:模型像“刷题家”而非“有天赋的学生”,缺乏真正的理解与迁移能力。

一个典型的生活化案例是编程助手的行为:当用户要求修复一个bug时,模型可能修复了当前bug却引入了新bug,甚至会在两个bug间来回折腾。这种现象暴露了当前模型缺乏全局理解和真正的问题解决能力。

模型能力的“锯齿状”现象

当前模型最令人困惑的特征之一是评估性能与实际性能的脱节。Ilya描述了一种“模型能力的锯齿状现象”——模型能在高难度评测中表现出色,却在简单任务上反复犯错。

这种现象源于“奖励黑客行为”(Reward Hacking):研究人员为了让评测结果好看,过度针对评测集进行强化学习训练,导致模型像应试教育下的学生,只学会了解题技巧而非真正理解知识本质。

新架构的设计哲学与核心原理

从“规模驱动”到“研究驱动”的范式转变

Ilya认为,AI发展正重新回到“研究时代”。科研确实需要算力,但并不需要绝对最多的算力。真正需要的是正确的问题和新的方法。

新的架构设计哲学建立在几个核心原则之上:

-

美与简洁:“美、简洁、优雅”成为架构设计的重要标准。

-

生物学启发:正确借鉴大脑的本质结构,包括神经元的数量、连接的可塑性,以及通过局部规则从经验中学习的能力。

-

自上而下的信念:当数据暂时不支持你的猜想时,仍能支撑你继续前进,因为你相信背后存在内在的正确性。

情感作为价值函数的核心洞察

Ilya提出了一个深刻见解:人类情绪本质上是进化形成的价值函数。他解释道:“一个人因为中风或事故造成了某种脑损伤,导致他失去了情感处理能力,在做任何决策时都变得极其糟糕。这说明人类内置的情感对于让我们成为一个能够在这个世界上生存并有效行动的个体,起着至关重要的作用。”

这种“情感价值函数”与当前强化学习中的奖励机制有根本不同:

-

当前RL系统:需要等待任务完成后才给予奖励反馈。

-

情感价值函数:提供持续的内部指导,无需等待最终结果。

以下代码示例展示了传统奖励机制与情感价值函数的对比:

import numpy as np

class TraditionalReward:

"""传统强化学习奖励机制"""

def __init__(self):

self.total_reward = 0

def calculate_final_reward(self, outcomes):

"""仅在任务结束时计算奖励"""

if outcomes['success']:

self.total_reward += 100

else:

self.total_reward -= 10

return self.total_reward

class EmotionalValueFunction:

"""情感价值函数模拟"""

def __init__(self):

self.internal_state = 0

self.baseline = 0.5 # 情感基线

def update_internal_state(self, current_situation, historical_patterns):

"""基于当前情况和历史模式持续更新内部状态"""

# 模拟基于多因素的情感评估

risk_assessment = self.assess_risk(current_situation)

progress_evaluation = self.evaluate_progress(current_situation)

pattern_recognition = self.recognize_patterns(historical_patterns)

# 情感状态是多个因素的整合

emotional_state = (risk_assessment + progress_evaluation + pattern_recognition) / 3

# 与基线比较产生价值信号

value_signal = emotional_state - self.baseline

return value_signal

def assess_risk(self, situation):

"""评估当前风险"""

return np.random.random() # 简化实现

def evaluate_progress(self, situation):

"""评估进展方向"""

return np.random.random() # 简化实现

def recognize_patterns(self, historical_patterns):

"""识别历史模式"""

return np.random.random() # 简化实现

# 使用示例

traditional = TraditionalReward()

emotional = EmotionalValueFunction()

# 模拟任务执行过程

for step in range(10):

current_situation = {'step': step}

historical_patterns = []

# 传统方法只在结束时奖励

if step == 9: # 最后一步

reward = traditional.calculate_final_reward({'success': True})

print(f"传统奖励: {reward}")

# 情感价值函数持续提供反馈

value_signal = emotional.update_internal_state(current_situation, historical_patterns)

print(f"步骤 {step} 情感价值信号: {value_signal:.4f}")基于大脑灵感的通用学习机制

Ilya强调,人类能迅速学习,是因为进化内置了强大的通用学习机制。人类学习速度快,不是因为我们预装了大量知识,而是因为进化为我们挑选了一小批极其有用的先验。

新架构试图复制这种通用学习能力,而非简单地扩展规模。这包括:

-

样本效率:人类只需少量样本就能学习复杂概念。

-

持续学习:在不遗忘旧知识的情况下整合新知识。

-

跨领域迁移:将一个领域学到的知识应用到另一领域。

新架构的技术实现与组件设计

整体架构概览

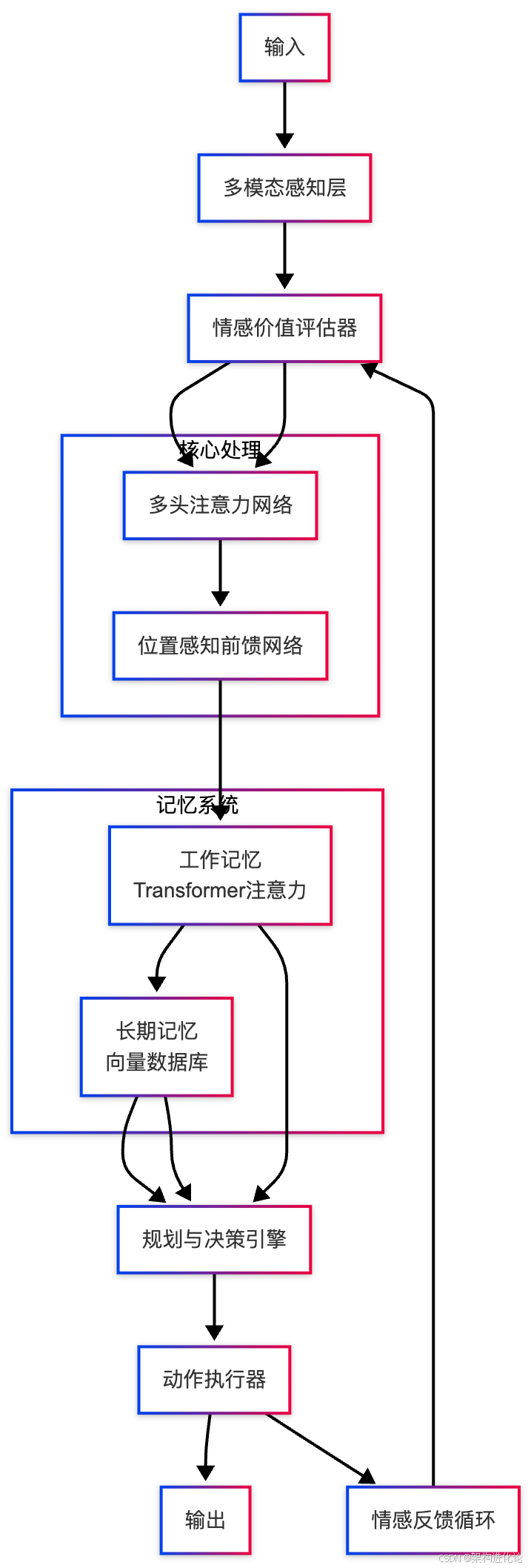

新的架构设计采用了编码器-解码器结构,但在此基础上引入了多个创新组件,特别是情感价值函数和增强的注意力机制。

以下是新架构的图示:

情感价值函数的技术实现

情感价值函数作为新架构的核心组件,需要将情感信号转化为可计算的价值评估。以下代码展示了其基本实现:

import torch

import torch.nn as nn

import torch.nn.functional as F

class EmotionalValueNetwork(nn.Module):

"""

情感价值网络

将情感信号转化为持续的价值评估

"""

def __init__(self, input_dim, hidden_dim, num_emotional_dimensions=4):

super(EmotionalValueNetwork, self).__init__()

# 情感维度:风险感知、进展评估、模式识别、内部状态

self.emotional_encoder = nn.Linear(input_dim, num_emotional_dimensions)

# 价值评估网络

self.value_network = nn.Sequential(

nn.Linear(num_emotional_dimensions, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, hidden_dim // 2),

nn.ReLU(),

nn.Linear(hidden_dim // 2, 1), # 输出单一价值评估

nn.Tanh() # 归一化到[-1, 1]

)

# 情感基线,随时间调整

self.register_buffer('emotional_baseline', torch.tensor(0.0))

def forward(self, state_representation, historical_context=None):

"""

前向传播计算情感价值

Args:

state_representation: 当前状态表示 [batch_size, input_dim]

historical_context: 历史上下文信息 [batch_size, context_dim]

"""

# 编码情感维度

emotional_dimensions = torch.tanh(self.emotional_encoder(state_representation))

# 如果有历史上下文,将其融入情感评估

if historical_context is not None:

context_influence = torch.sigmoid(historical_context.mean(dim=1, keepdim=True))

emotional_dimensions = emotional_dimensions * context_influence

# 计算价值信号

value_signal = self.value_network(emotional_dimensions)

# 相对于基线的价值

relative_value = value_signal - self.emotional_baseline

return {

'value_signal': value_signal,

'relative_value': relative_value,

'emotional_dimensions': emotional_dimensions

}

def update_baseline(self, new_baseline):

"""更新情感基线"""

self.emotional_baseline = new_baseline

class EnhancedTransformerBlock(nn.Module):

"""

增强的Transformer块,集成情感价值评估

"""

def __init__(self, d_model, nhead, dim_feedforward, emotional_network):

super(EnhancedTransformerBlock, self).__init__()

# 标准Transformer组件

self.self_attn = nn.MultiheadAttention(d_model, nhead)

self.cross_attn = nn.MultiheadAttention(d_model, nhead)

# 前馈网络

self.linear1 = nn.Linear(d_model, dim_feedforward)

self.linear2 = nn.Linear(dim_feedforward, d_model)

# 层归一化

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

self.norm3 = nn.LayerNorm(d_model)

# 情感价值网络

self.emotional_network = emotional_network

# 丢弃层用于正则化

self.dropout = nn.Dropout(0.1)

def forward(self, src, tgt=None, src_mask=None, tgt_mask=None, memory_mask=None):

# 自注意力层

src2, attention_weights = self.self_attn(src, src, src, attn_mask=src_mask)

src = self.norm1(src + self.dropout(src2))

# 情感价值评估

emotional_assessment = self.emotional_network(src)

value_guidance = emotional_assessment['relative_value']

# 用情感价值指导注意力重加权

value_aware_src = src * (1 + value_guidance.unsqueeze(-1))

# 交叉注意力(编码器-解码器)

if tgt is not None:

tgt2, cross_attention = self.cross_attn(tgt, value_aware_src, value_aware_src,

attn_mask=memory_mask)

tgt = self.norm2(tgt + self.dropout(tgt2))

# 前馈网络

tgt2 = self.linear2(F.relu(self.linear1(tgt)))

tgt = self.norm3(tgt + self.dropout(tgt2))

return tgt, attention_weights, cross_attention, emotional_assessment

return src, attention_weights, None, emotional_assessment增强的注意力机制

新架构对传统Transformer的注意力机制进行了重要改进,引入了情感引导的注意力重加权和动态上下文感知。

class EmotionalGuidedAttention(nn.Module):

"""

情感引导的注意力机制

"""

def __init__(self, d_model, nhead, emotional_dim=4):

super(EmotionalGuidedAttention, self).__init__()

self.d_model = d_model

self.nhead = nhead

self.head_dim = d_model // nhead

# 查询、键、值投影

self.q_proj = nn.Linear(d_model, d_model)

self.k_proj = nn.Linear(d_model, d_model)

self.v_proj = nn.Linear(d_model, d_model)

# 情感感知投影

self.emotional_q_proj = nn.Linear(d_model + emotional_dim, d_model)

self.emotional_k_proj = nn.Linear(d_model + emotional_dim, d_model)

# 输出投影

self.out_proj = nn.Linear(d_model, d_model)

# 缩放因子

self.scaling = self.head_dim ** -0.5

def forward(self, query, key, value, emotional_context=None, attn_mask=None):

batch_size, tgt_len, embed_dim = query.size()

_, src_len, _ = key.size()

# 如果有情感上下文,将其融入查询和键

if emotional_context is not None:

# 扩展情感上下文以匹配序列长度

emotional_expanded = emotional_context.unsqueeze(1).expand(-1, tgt_len, -1)

query_emotional = torch.cat([query, emotional_expanded], dim=-1)

query = self.emotional_q_proj(query_emotional)

emotional_expanded_key = emotional_context.unsqueeze(1).expand(-1, src_len, -1)

key_emotional = torch.cat([key, emotional_expanded_key], dim=-1)

key = self.emotional_k_proj(key_emotional)

# 标准注意力计算

q = self.q_proj(query).view(batch_size, tgt_len, self.nhead, self.head_dim).transpose(1, 2)

k = self.k_proj(key).view(batch_size, src_len, self.nhead, self.head_dim).transpose(1, 2)

v = self.v_proj(value).view(batch_size, src_len, self.nhead, self.head_dim).transpose(1, 2)

# 注意力得分

attn_weights = torch.matmul(q, k.transpose(-2, -1)) * self.scaling

# 应用注意力掩码

if attn_mask is not None:

attn_weights += attn_mask.unsqueeze(0)

attn_weights = F.softmax(attn_weights, dim=-1)

# 上下文向量

attn_output = torch.matmul(attn_weights, v)

attn_output = attn_output.transpose(1, 2).contiguous().view(

batch_size, tgt_len, embed_dim)

attn_output = self.out_proj(attn_output)

return attn_output, attn_weights新架构的应用场景与优势分析

解决Scaling时代的泛化问题

新架构通过情感价值函数和增强的注意力机制,直接应对当前模型泛化能力不足的核心问题。

生活化案例:智能编程助手

传统的编程助手如Copilot基于大规模代码训练,但常常出现以下问题:

-

修复一个bug引入新bug

-

缺乏对代码整体架构的理解

-

无法进行跨文件的复杂重构

基于新架构的编程助手工作流程:

-

情感价值评估:实时评估代码修改的风险和质量影响

-

全局注意力:同时考虑多个文件和相关文档

-

持续学习:从程序员反馈中调整价值函数

-

规划与执行:将复杂重构分解为有序步骤

class IntelligentCodeAssistant:

"""基于新架构的智能编程助手"""

def __init__(self):

self.emotional_network = EmotionalValueNetwork(

input_dim=512, # 代码表示维度

hidden_dim=256

)

self.attention_mechanism = EmotionalGuidedAttention(

d_model=512, nhead=8

)

self.working_memory = [] # 工作记忆

def analyze_code_change(self, current_code, proposed_change, project_context):

"""分析代码变更的潜在影响"""

# 生成代码表示

code_representation = self.encode_code(current_code, proposed_change)

# 情感价值评估

emotional_assessment = self.emotional_network(

code_representation,

project_context

)

# 如果价值评估为负,拒绝变更或提出警告

if emotional_assessment['relative_value'] < -0.3:

return {

'approval': False,

'confidence': 1 - torch.sigmoid(emotional_assessment['value_signal']),

'alternative_suggestions': self.generate_alternatives(current_code),

'risk_factors': self.identify_risk_factors(emotional_assessment)

}

# 基于情感的注意力重加权

enhanced_representation, _ = self.attention_mechanism(

code_representation, code_representation, code_representation,

emotional_assessment['emotional_dimensions']

)

return {

'approval': True,

'enhanced_representation': enhanced_representation,

'emotional_context': emotional_assessment

}样本效率与持续学习

新架构显著提升了样本效率,这是相对于Scaling范式的主要优势之一。人类只需少量样本就能学习复杂概念,新架构通过情感价值函数模拟了这一能力。

生活化案例:医疗诊断系统

传统AI医疗系统需要数百万标注图像才能达到专家水平,而新架构的实现路径:

class MedicalDiagnosisAgent:

"""基于新架构的医疗诊断智能体"""

def __init__(self):

self.emotional_value_function = EmotionalValueNetwork(

input_dim=1024, # 医学图像和病历的联合表示

hidden_dim=512

)

self.diagnostic_memory = DiagnosticMemory()

def diagnose(self, patient_data, medical_images, similar_cases):

"""诊断患者病例"""

# 生成多模态表示

multimodal_representation = self.fuse_modalities(

patient_data, medical_images

)

# 情感价值评估(模拟医生的"直觉")

clinical_intuition = self.emotional_value_function(

multimodal_representation,

similar_cases

)

# 基于价值信号调整诊断信心

diagnosis_confidence = self.calculate_confidence(

clinical_intuition['value_signal']

)

# 如果价值信号强烈负面,建议进一步检查

if clinical_intuition['relative_value'] < -0.5:

return {

'diagnosis': 'inconclusive',

'confidence': diagnosis_confidence,

'recommendations': ['additional_tests', 'specialist_referral'],

'risk_assessment': 'high'

}

# 生成最终诊断

final_diagnosis = self.final_diagnosis(

multimodal_representation,

clinical_intuition

)

return final_diagnosis技术挑战与未来发展方向

主要技术挑战

新架构的实施面临多个技术挑战:

-

情感价值函数的量化:如何将抽象的情感信号转化为可计算、可优化的数学形式。

-

训练稳定性:情感价值网络与传统Transformer组件的协同训练。

-

评估指标:如何评估新架构的真实泛化能力,而非仅仅是基准测试性能。

-

计算效率:增强的注意力机制带来的额外计算开销。

解决路径与研究方向

针对上述挑战,Ilya指出了几个关键的研究方向:

-

神经科学启发:更深入地研究大脑的价值评估系统,特别是多巴胺系统和前额叶皮层的作用机制。

-

课程学习:设计更好的训练课程,让模型从简单到复杂逐步学习。

-

多模态整合:将视觉、语言、行动等多种模态统一到同一价值函数框架下。(扩展阅读:FedVLA:基于双门控混合专家的联邦视觉-语言-行动学习在机器人操纵中的创新设计、LoHoVLA:统一视觉-语言-动作模型的技术突破与设计精髓、特征金字塔在Vision Transformer中的创新应用:原理、优势与实现分析、视觉Transformer金字塔架构演进:从PVT到CoaT的技术脉络与创新解析、从Transformer到Swin Transformer:视觉领域架构演进与技术突破分析)

-

安全对齐:确保情感价值函数与人类价值观对齐。(扩展阅读:大模型偏好对齐强化学习技术:从PPO、GRPO到DPO的演进与创新、ORPO:颠覆传统,偏好对齐的简约革命)

class ResearchPrototype:

"""新架构研究原型"""

def training_protocol(self):

"""训练协议"""

return {

'phase_1': {

'description': '基础能力培养',

'curriculum': ['simple_patterns', 'basic_reasoning'],

'emotional_guidance': 'weak'

},

'phase_2': {

'description': '价值函数校准',

'curriculum': ['complex_tasks', 'transfer_learning'],

'emotional_guidance': 'moderate'

},

'phase_3': {

'description': '泛化能力提升',

'curriculum': ['novel_situations', 'creative_problem_solving'],

'emotional_guidance': 'strong'

}

}

def alignment_strategy(self):

"""对齐策略"""

return {

'value_alignment': {

'method': 'iterative_refinement',

'mechanism': 'human_feedback_in_loop'

},

'safety_measures': {

'oversight': 'multi_layer_monitoring',

'intervention': 'dynamic_threshold_adjustment'

}

}从规模到智慧的AI新纪元

Ilya Sutskever的架构宣言标志着AI发展进入新阶段。Scaling时代的终结不是进步的终点,而是更深层次突破的起点。新架构的核心洞察在于:真正的智能不在于规模大小,而在于学习机制的本质。

关键转变总结:

-

从数据驱动到价值驱动:情感价值函数提供持续的内部指导,替代单纯的数据拟合。

-

从被动响应到主动理解:增强的注意力机制使模型能够全局理解问题,而非局部优化。

-

从专门化到通用化:新架构旨在培养通用的学习能力,而非狭窄领域的专家技能。

正如Ilya所言:“美、简洁、优雅”成为架构设计的新标准。当AI从“暴力美学”走向“精巧设计”,我们或许将见证真正通用人工智能的诞生。

对于AI从业者而言,这意味着需要重新调整技术路线图和研究重点。算力投入仍然重要,但研究品味和架构洞察将比以往任何时候都更加关键。在这个新纪元中,理解人类智能的本质或许正是创造机器智能的关键钥匙。

6518

6518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?