Jet-Nemotron是英伟达最新推出的小模型系列(2B/4B),由全华人团队打造。其核心创新在于提出后神经架构搜索(PostNAS)与新型线性注意力模块JetBlock,实现了从预训练Transformer出发的高效架构优化。

英伟达最近真的痴迷上「小模型」了。

刚刚,英伟达发布了一个全新的混合架构语言模型系列,Jet-Nemotron。

论文地址:https://arxiv.org/pdf/2508.15884

项目地址:https://github.com/NVlabs/Jet-Nemotron

Jet-Nemotron系列有Jet-Nemotron-2B和Jet-Nemotron-4B大小。

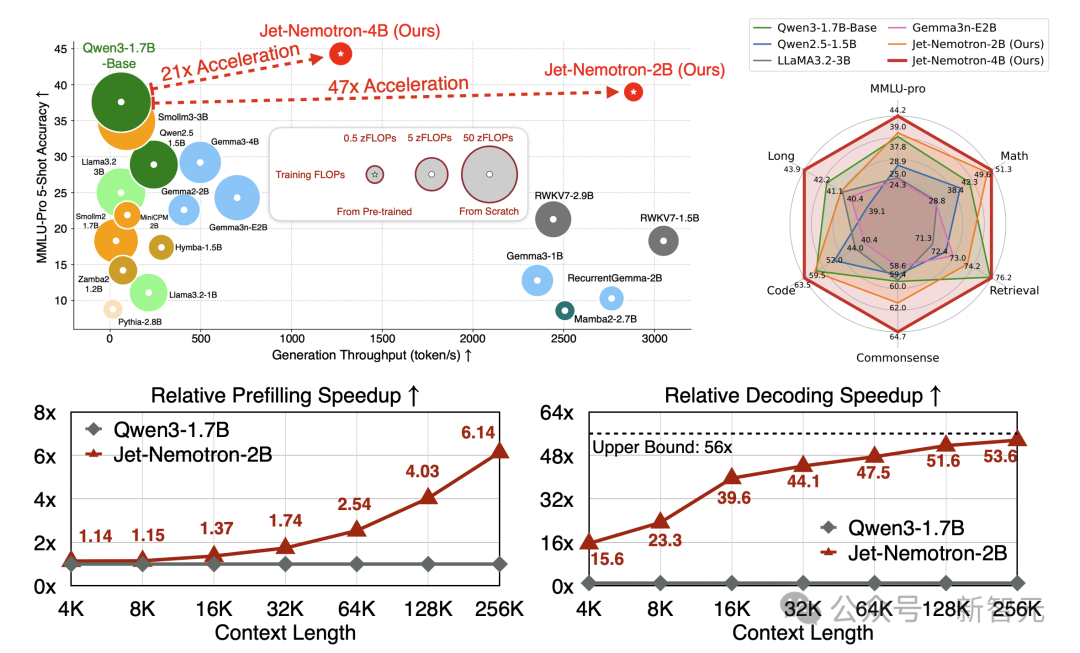

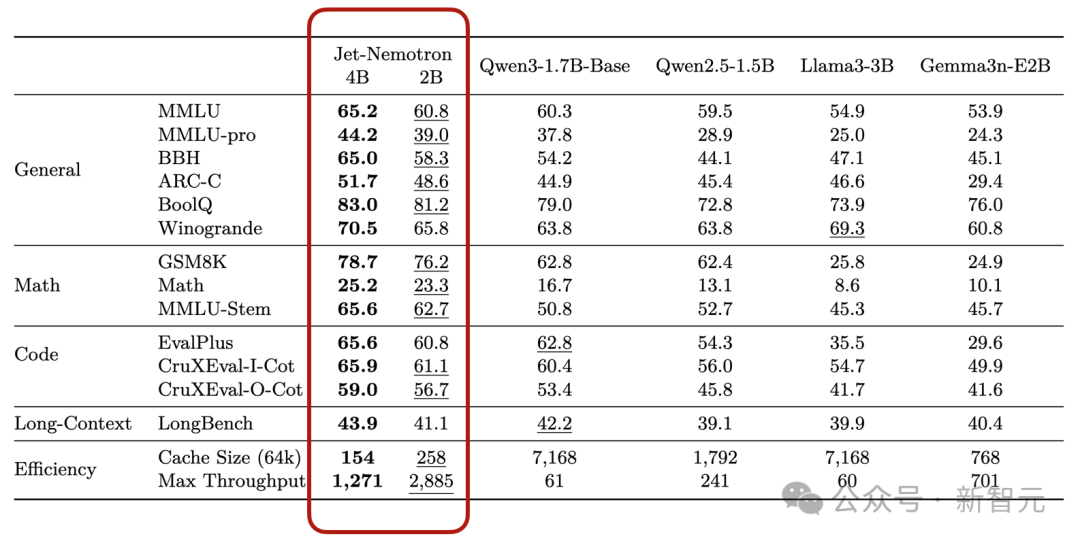

英伟达表示Jet-Nemotron系列「小模型」性能超越了Qwen3、Qwen2.5、Gemma3和 Llama3.2等当前最先进的开源全注意力语言模型。

同时实现了显著的效率提升,在H100 GPU上生成吞吐量最高可提升53.6倍。

在右上角的雷达图中,可以看到Jet-Nemotron简直就是六边形战士。

Jet-Nemotron-4B模型在六个维度MMLU-pro、Math、Retrieval、Commonsense、Code、Long几乎都拉满。

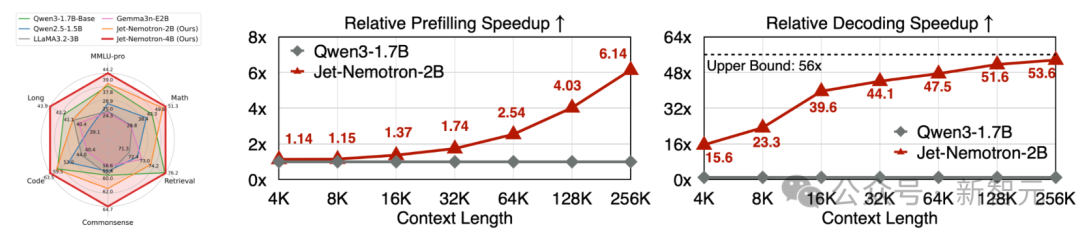

在预填充和解码阶段,Jet-Nemotron-2B在上下文越增加的情况下,相对Qwen 3-1.7B优势越夸张。

一句话总结就是同等硬件与评测设置下,Jet-Nemotron在长上下文的场景里,把吞吐做到了数量级提升(解码可达50倍提升)。

同时在常识/数学/代码/检索/长上下文等维度的准确率不降反升。

相较传统全注意力小模型又快又准。

看来,英伟达盯上了小模型Small Model这个领域。

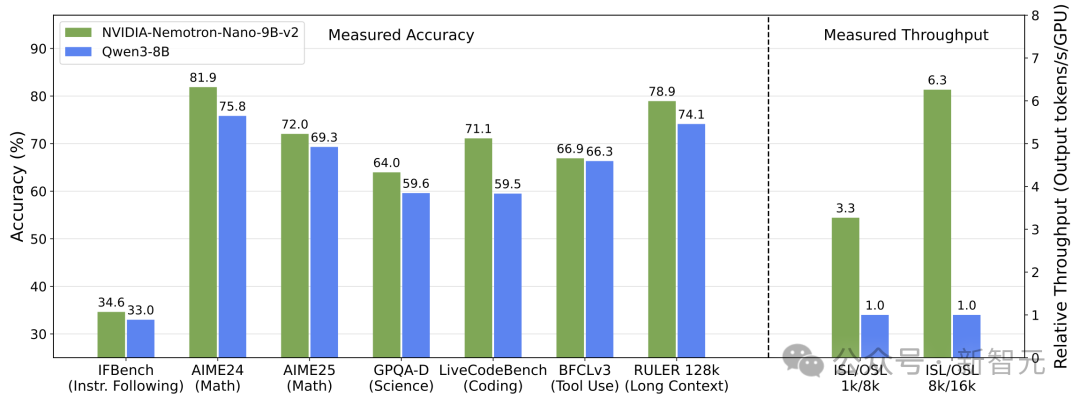

上一周,他们刚刚发布了只有9B大小的NVIDIA Nemotron Nano 2模型。

在复杂推理基准测试中实现了和Qwen3-8B相当或更优的准确率,并且吞吐量最高可达其6倍。

今天就推出了更小的Jet系列,体量降到了2B和4B模型。

核心创新

Jet-Nemotron有两项核心创新。

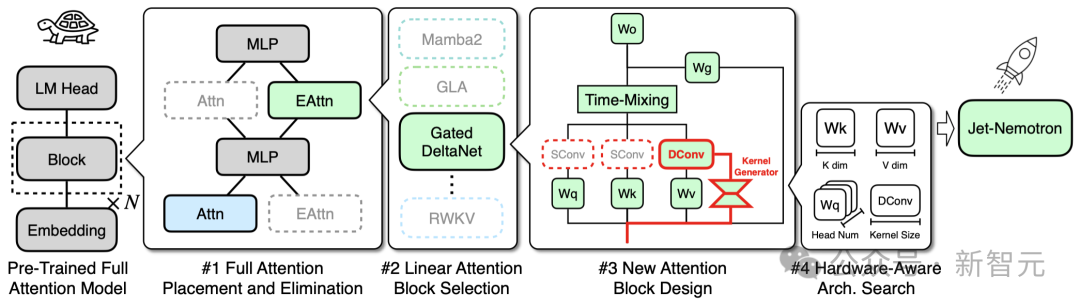

- 后神经网络架构搜索(Post Neural Architecture Search,PostNAS),这是一个高效的训练后架构探索与适应流程,适用于任意预训练的Transformer模型;

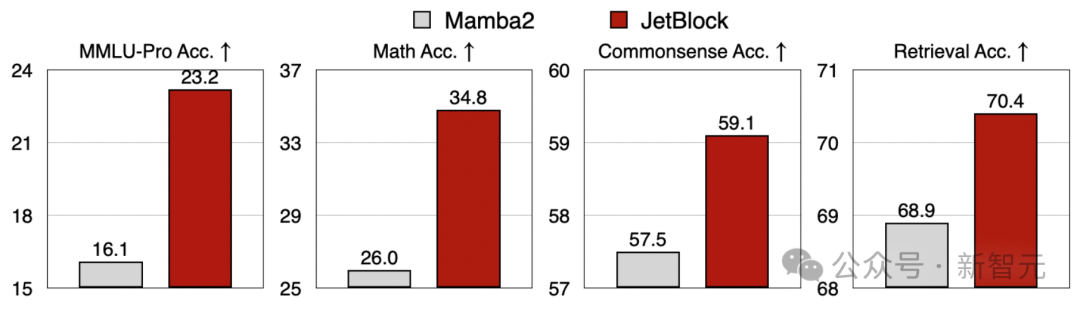

- JetBlock,一种新型线性注意力模块,其性能显著优于先前的设计,如Mamba2。

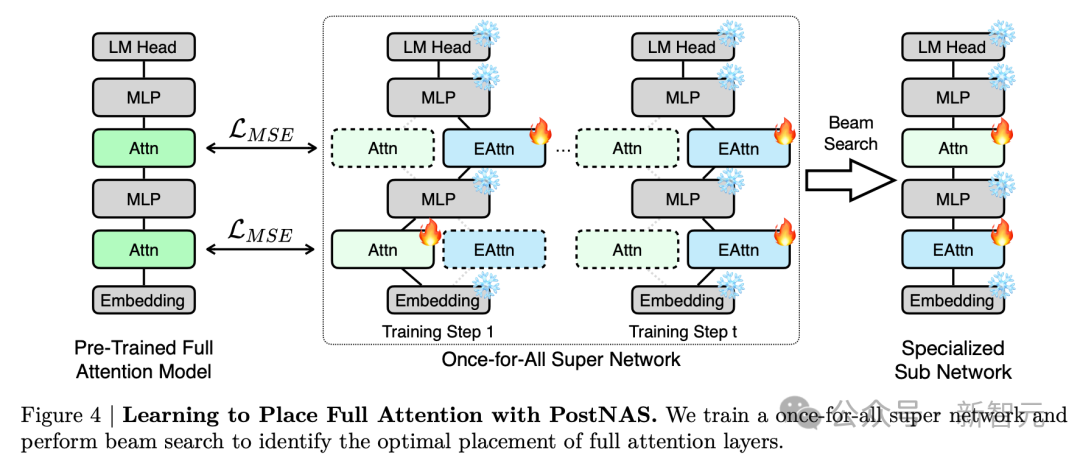

PostNAS:训练后架构探索与适配

与之前从头开始训练以探索新模型架构的方法不同,PostNAS在预训练的Transformer模型基础上进行构建。

同时支持对注意力块设计的灵活探索,从而大大降低了开发新语言模型架构的成本和风险。

PostNAS首先确定全注意力层的最佳放置位置,然后再搜索改进的注意力块设计。

PostNAS从一个已预训练的全注意力模型出发,并将MLP冻结。

随后对高效注意力块的设计进行由粗到细的搜索:

先确定全注意力层的最优放置位置,再选择最合适的线性注意力块或采用新的线性注意力块,最后搜索最优的架构超参数。

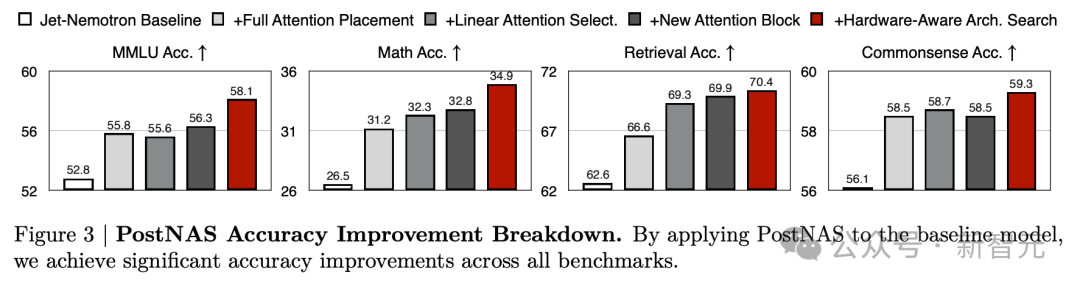

通过将PostNAS应用于基线模型后,在所有基准测试上都取得了显著的准确率提升。

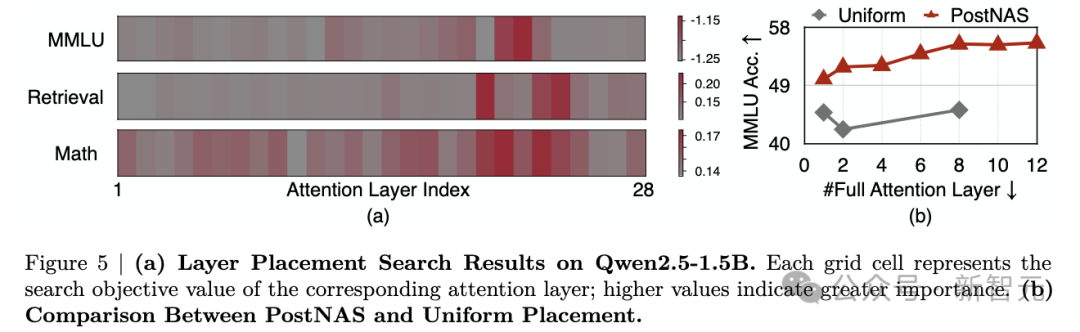

在预训练的Transformer模型中,并非所有注意力层的贡献都是相同的。

PostNAS揭示了预训练Transformer模型中重要的注意力层。

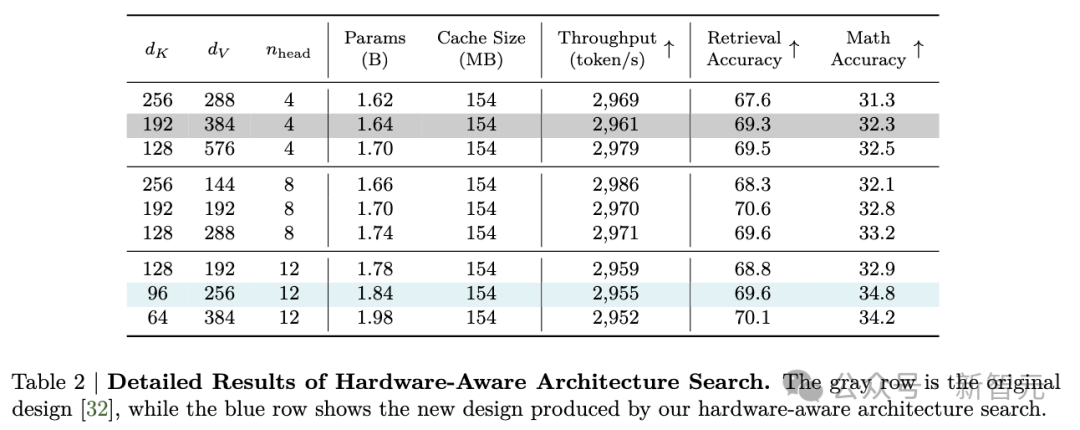

KV缓存大小是影响长上下文和长生成吞吐量的最关键因素。

PostNAS硬件感知搜索能够发现一些架构,在保持相似生成吞吐量的同时,拥有更多参数并实现更高的准确性。

JetBlock: 一种具有SOTA准确率的新型线性注意力模块

通过PostNAS,引入了JetBlock:一种新颖的线性注意力模块,它将动态卷积与硬件感知架构搜索相结合,以增强线性注意力,在保持与先前设计相似的训练和推理吞吐量的同时,实现了显著的准确率提升。

下方使用完全相同的训练数据和训练方案,对Mamba2 Block与JetBlock进行了公平的对比。

性能

Jet-Nemotron-2B和Jet-Nemotron-4B在全面的基准测试中达到或超过了主流高效语言模型(例如Qwen3)的准确率。

同时运行速度明显更快——分别比Qwen3-1.7B-Base快21倍和47倍。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量

2508

2508

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?