ASCII,Unicode,utf8,gbk 的区别

1)ASCII 编码

众所周知,计算机只能处理0和1,任何符号都转换为0和1的序列才能处理。计算机中8个位(bit)作为一个字节,所以1个字节能产生2的8次方个0和1的不同组合,也就是说1个字节做多能表示256种字符。ASCII编码就是用1个字节来存储字符,计算机最初是美国人发明的,他们的符号不多,所以还将8个0和1序列中的第一位固定为0,ASCII只能表示127个字符。

2)GBK 编码

美国佬的符号不多,所以ASCII编码够用,但是其他国家就不行了,每个国家符号数量都不一样,就各自指定了自己的编码。例如我们中国就制定了GB2312编码。GB2312编码用2个字节表示一个字符。

GBK编码是对GB2312编码的扩展,因此完全兼容GB2312-80标准。GBK编码依然采用双字节编码方案,其编码范围:8140-FEFE,剔除xx7F码位,共23940个码位。共收录汉字和图形符号21886个,其中汉字(包括部首和构件)21003个,图形符号883个。GBK编码支持国际标准ISO/IEC10646-1和国家标准GB13000-1中的全部中日韩汉字,并包含了BIG5编码中的所有汉字。

3)Unicode 编码

每个国家都用自己的编码,编码一朵就容易乱套,也没法交流,所以需要一种编码把各个国家的编码都囊括进去,这就是Unicode编码的由来。所以,Unicode也被称为万国码。Unicode编码也用2个字节存储一个字符。Unicode 又称 UTF-16。

4)utf-8 编码

Unicode编码解决了编码不能通用的问题,但是却容易浪费内存,尤其是在存储英文的时候,例如一个字符“A”,ASCII编码只需要1个字节就够,但是Unicode编码必须要用2个字节。为了解决这一问题,就有了utf-8编码。 utf-8编码把存储英文依旧用一个字节,汉字就3个字节。特别是生僻的编程4-6字节,如果传输大量英文,utf-8作用就很明显了。

utf-8编码进行存储时有极大地优势,但是当读取到计算机内存时却不大合适,因为utf-8编码是变长的,不方便寻址和索引,所以在计算机内存中,还是转化为Unicode编码合适些。这就可以解释为什么每次读取文本时,要将编码转化为Unicode编码,而将内存中的字符写入文件存储时,要将编码转化为utf-8了。

例子

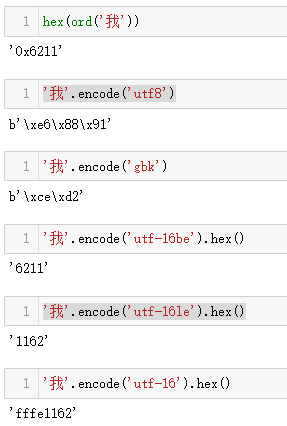

ord 返回字符的unicode编码,str.encode() 默认返回str的 utf8 编码,可以看到对于汉字 ‘我’ 的unicode编码和utf8编码分别是两个字节和三个字节。

UTF-8, UTF-16, UTF-16LE, UTF-16BE的区别

UTF-16, UTF-16LE, UTF-16BE 及其区别BOM,同样都是unicode, 为什么要搞3种这么麻烦?

先说 UTF-16BE(big endian),比较好理解的, 俗称大头 。

比如说 char ‘a’, ascii为 0x61, 那么它的utf-8, 则为 [0x61], 但utf-16是16位的, 所以为[0x00, 0x61]

再说UTF-16LE(little endian), 俗称小头, 这个是比较常用的 。

还是char ‘a’, 它的代码却反过来: [0x61, 0x00], 据说是为了提高速度而迎合CPU的胃口, CPU就是这到倒着吃数据的, 这里面有汇编的知识, 不多说 。

然后说UTF-16, 要从代码里自动判断一个文件到底是UTF-16LE还是BE, 对于单纯的英文字符来说还比较好办, 但要有特殊字符, 图形符号, 汉字, 法文, 俄语, 火星语之类的话, 相信各位都很头痛吧, 所以, unicode组织引入了BOM的概念, 即byte order mark, 顾名思义, 就是表名这个文件到底是LE还是BE的, 其方法就是, 在UTF-16文件的头2个字节里做个标记: LE [0xFF, 0xFE], BE [0xFE, 0xFF]

如何区别系统的LE和BE

#include<stdio.h>

int main()

{

unsigned int uiTest;

unsigned char *pucTmp = NULL;

uiTest = 0x12345678;

pucTmp = (unsigned char *)&uiTest; //指向&uiTest的第一个字节

if(*pucTmp == 0x78)

{

printf("This is Little Endian\n");

}

else

{

printf("This is Big Endian\n");

}

return 0;

}

6160

6160

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?