前言

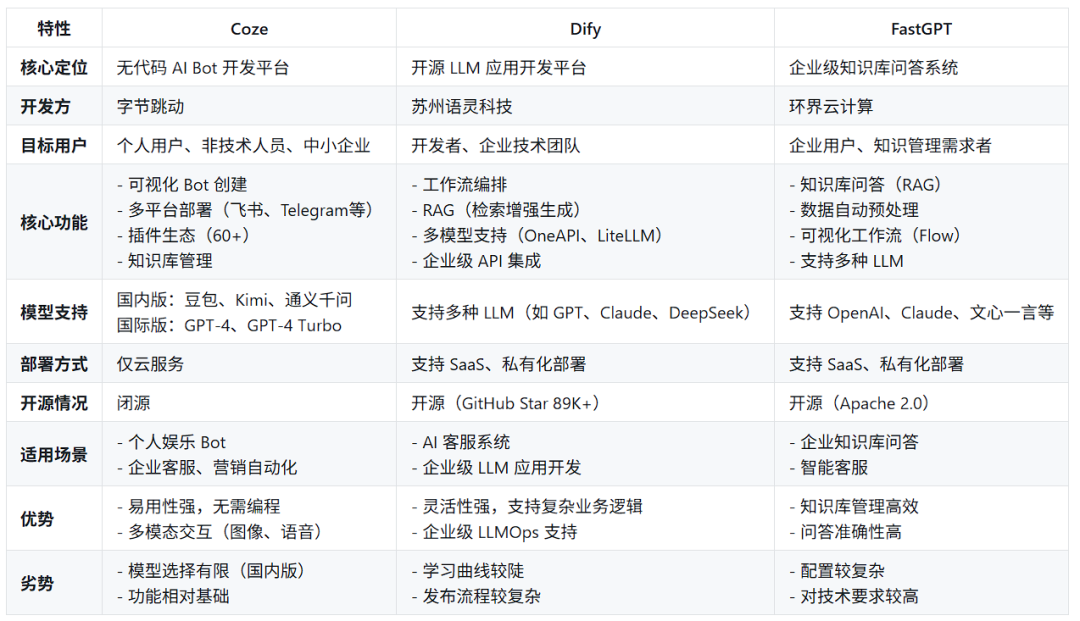

随着AI智能体技术进入规模化商用阶段,开发平台的选择成为企业和开发者面临的首要问题。本文基于2025年最新技术环境,对Coze、Dify和FastGPT三大主流智能体开发平台进行系统性评测,旨在为技术选型提供客观参考。

在AI Agent技术栈快速迭代的背景下,Coze、Dify、FastGPT作为三类技术范式的代表,分别体现了开源知识工程、LLMOps全流程管理、低代码对话交互的核心设计理念。

本文将从产品定位,技术架构、模型集成、工作流引擎、知识库实现等维度展开深度对比,为开发者提供技术选型依据。

产品定位对比

在产品定位上,主要总结以下区别:

- Coze:适合快速搭建聊天机器人,无需/少量需要编程,适合 C 端用户或轻量级企业应用。

- Dify:适合开发者构建复杂 AI 应用,支持多模型切换和私有化部署。

- FastGPT:适合企业知识库管理,需高效问答系统,涉及军工、医疗等敏感数据,且IT团队具备本地化运维能力。

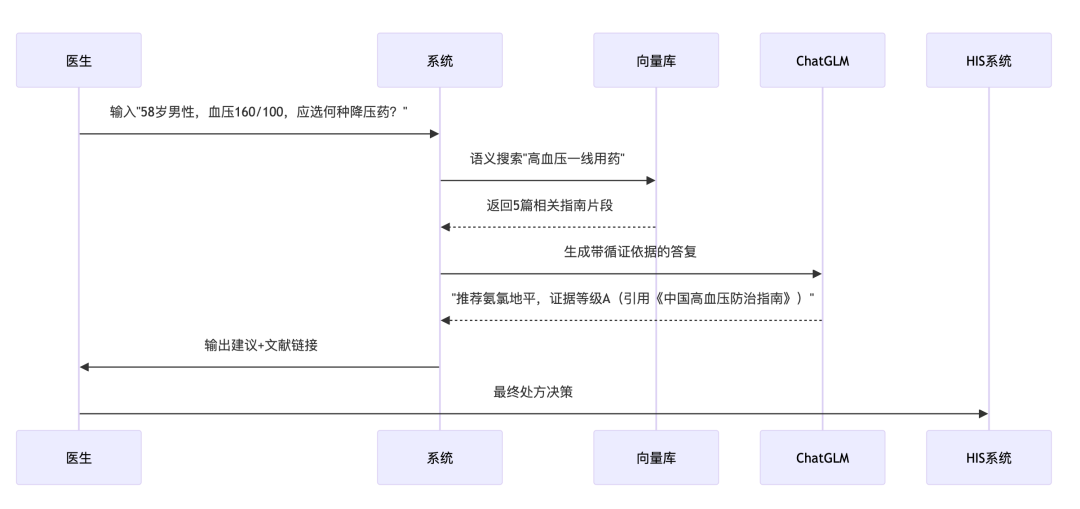

对于私有化部署场景,比较推荐Dify或者FastGPT,举一个实际案例:

FastGPT三甲医院医疗知识库(全本地化)

**场景需求:医院需构建内部临床决策支持系统,整合最新诊疗指南和药品库,禁止数据外传。

**

技术实现:

-

知识库构建:

-

- 将2000份PDF指南通过FastGPT 向量化引擎 转换为嵌入数据

- 建立药品-适应症关联图谱

-

查询流程:

-

整体流程:

-

硬件配置: 本地部署在3台A100服务器,响应延迟<1.5秒。

-

效果体现 医生查询指南时间从15分钟缩短至20秒,诊断符合率提升12%

技术架构对比

FastGPT

开源架构基于Node.js + React技术栈,采用微服务化设计(支持独立部署知识库引擎与LLM网关)。**

**

核心模块

- Flow Engine:基于DAG(有向无环图)的可视化编排系统,支持Python代码节点注入。

- RAG Pipeline:集成多阶段召回-排序机制,支持混合检索(关键词+向量)。

扩展性通过Docker Compose实现私有化部署,支持自定义插件开发(需修改Go语言编写的中间件)。

Dify

LLMOps架构采用BaaS(Backend-as-a-Service)模式,抽象出"Dataset-LLM-App"三层结构。**

**

关键技术

- 模型路由层:支持OneAPI协议,可动态切换不同厂商的LLM(如Azure/OpenAI/Anthropic)。

- 异步任务队列:基于Celery实现长文本生成任务的分片处理。

部署方案提供Kubernetes Helm Chart,支持水平扩展的Worker节点。

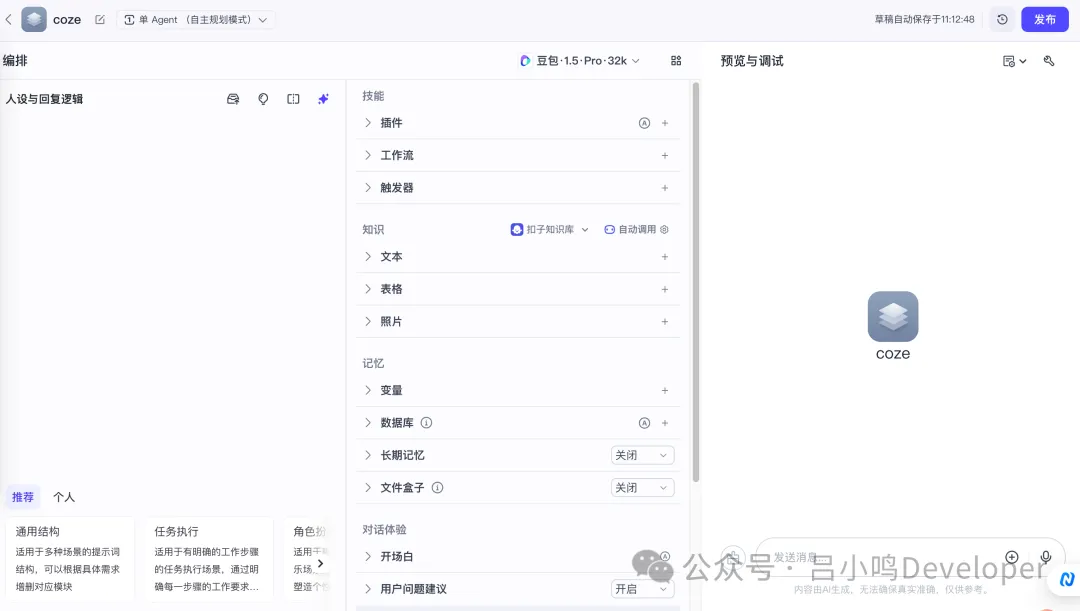

Coze

低代码架构前端采用WebAssembly优化交互性能,后端基于字节跳动自研的MLaaS平台。**

**

核心特性

- 对话状态机:内置NLU引擎支持意图识别与上下文管理(有限状态机实现)。

- 插件热加载:通过WebSocket实现插件动态更新,无需重启服务。

运维体系依赖字节云原生基础设施,暂未开放私有化部署方案。

模型支持与集成深度对比

总结以上关键结论:

模型灵活性:

- Dify > FastGPT > Coze

- Dify支持混合云架构,可同时调用云模型和本地模型。

企业级集成:

- Dify 提供完整的API工具链和微调能力,适合构建复杂AI中台。

- FastGPT 在数据隐私场景有绝对优势,但扩展性受限。

成本效率:

- FastGPT 本地化方案长期成本最低,但初期部署门槛高。

- Dify 适合需要平衡灵活性与成本的中大型企业。

生态绑定:

Coze 深度集成字节系产品(如抖音、飞书、即梦),非字节生态慎选。

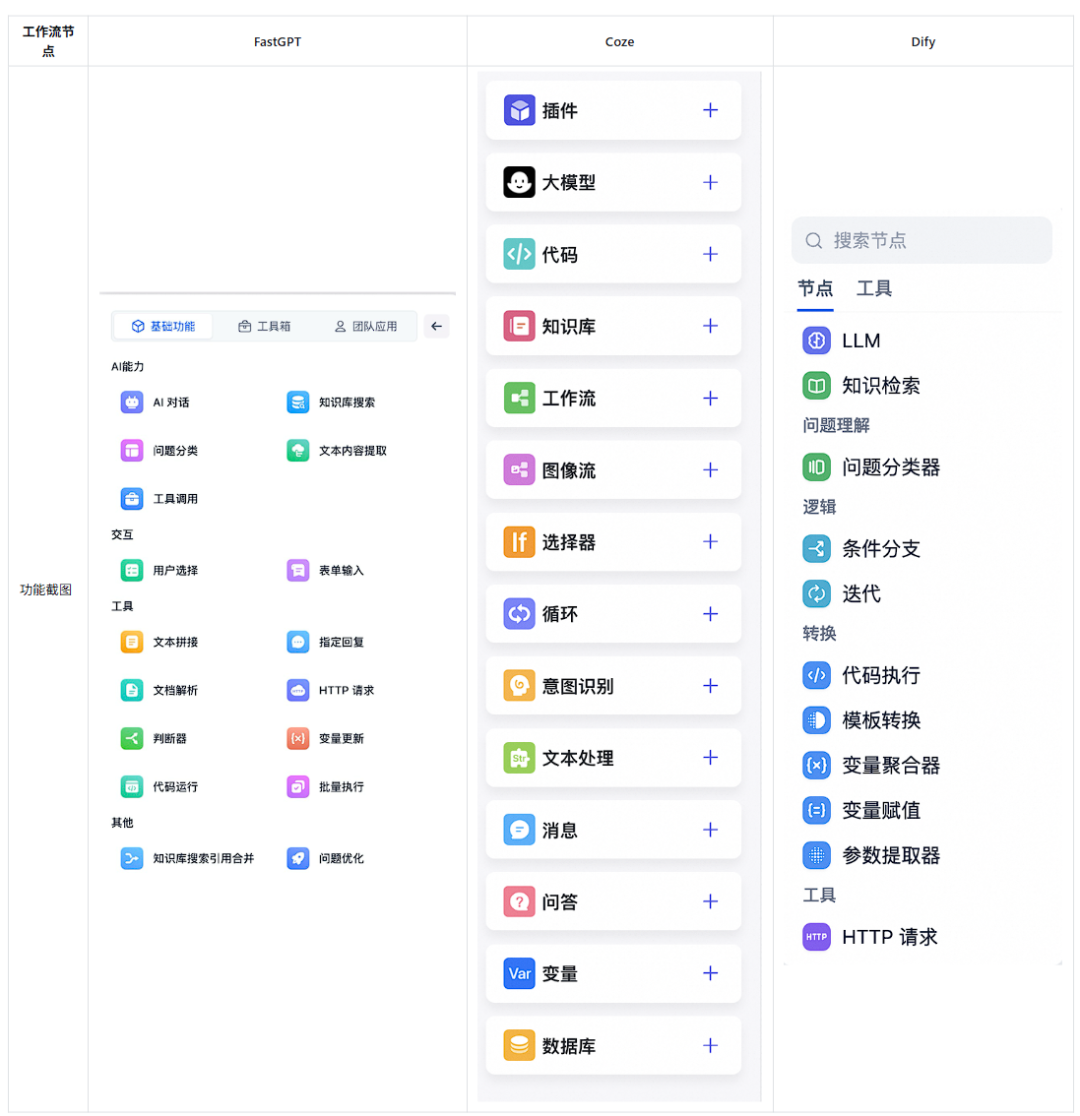

工作流编排

FastGPT

-

基础类

-

- 开始/结束

- 大模型节点

- 知识检索节点

-

问题理解类

-

- 问题分类器节点

-

逻辑类

-

- 条件分支节点

- 迭代节点

-

转换类

-

- 代码执行节点

- 模板转换节点

- 变量聚合器节点

- 变量赋值节点

- 参数提取器节点

-

工具类

-

- HTTP请求

- 插件节点

Coze

-

基础类

-

- 开始/结束节点

- 大模型节点

- 知识库节点

- 数据库节点

-

逻辑类

-

- 选择器节点

- 循环节点

-

问题理解类

-

- 意图识别节点

-

工具类

-

- 工作流节点

- 图像流节点

- 插件节点

-

转换类

-

- 代码节点

- 文本处理节点

- 变量节点

-

对话体验类

-

- 消息节点

- 问答节点

Dify

-

基础类

-

- 开始/结束

- 大模型节点

- 知识检索节点

-

问题理解类

-

- 问题分类器节点

-

逻辑类

-

- 条件分支节点

- 迭代节点

-

转换类

-

- 代码执行节点

- 模板转换节点

- 变量聚合器节点

- 变量赋值节点

- 参数提取器节点

-

工具类

-

- HTTP请求

- 插件节点

总结以上关键结论:

三者对于工作流的创建流程上大致相似。功能丰富度上,Coze和Dify的节点丰富度都较高,但Coze更侧重一些降低使用门槛的功能,例如“意图识别”可代替“条件分类”用自然语言判断用户意图,“消息”、“问答”等功能可预置一些标准回答提高准确度和回复效率;而Dify则侧重一些数据处理类的功能,便于优化对后续LLM的输入。FastGPT的功能较前两者属于取长补短类型,但三者都可借助代码工具实现较为高级的功能,对用户的代码基础有一定要求。

总结以上关键结论:

- 专业垂直领域:FastGPT的术语优化和合规设计优势明显

- 企业级复杂数据整合:Dify的灵活ETL和多模态支持更胜一筹

- 轻量级标准化场景:Coze开箱即用,但扩展性受限

生态系统与开发者支持

FastGPT

-

专注知识库场景:优化了长文本处理、批量任务(如循环运行节点),但整体功能较垂直,扩展性弱。

-

技术门槛适中:提供Docker快速部署脚本,适合中小团队快速搭建问答系统,但高阶开发支持有限。

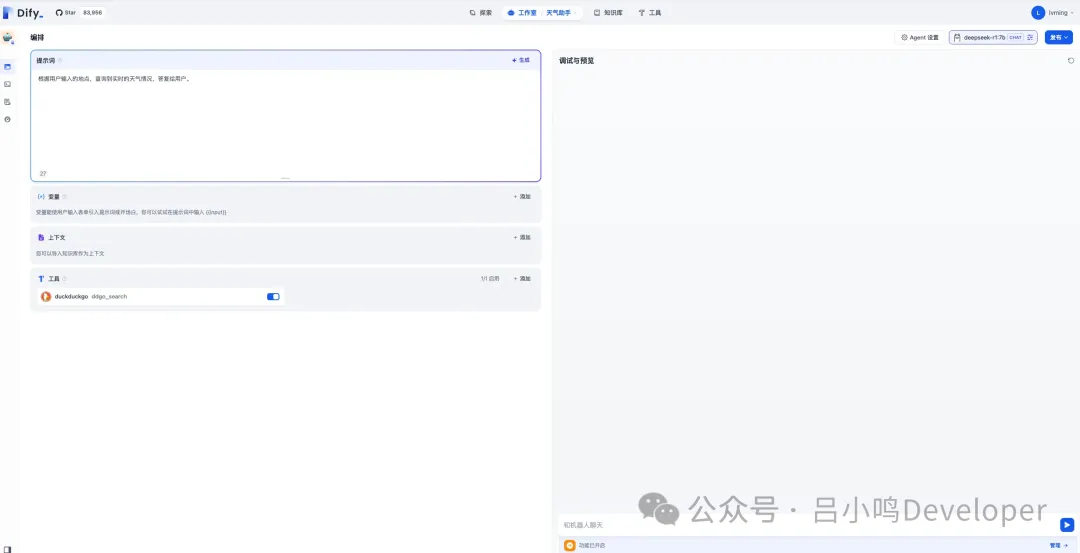

Dify

- 面向开发者设计:提供可视化Prompt编排、API调试界面、支持复杂逻辑的工作流(如Agent、RAG管道),适合技术用户精细控制。

- 文档与API支持:开源社区活跃(GitHub 89K+ stars),提供详尽API文档和部署指南,适合二次开发。

Coze

- 无代码/低代码优先:无代码/低代码优先:通过拖拽式工作流设计、预置插件(如搜索、图像理解、数据库操作),让非技术用户也能快速搭建复杂AI应用。

- 调试与思维链可视化:支持实时查看模型推理过程(如DeepSeek-R1),调试体验友好

- 学习资源:模板商店丰富,但深度技术文档较少,适合快速上手而非深度定制

结语

- FastGPT适合需要高度定制化需求的企业级客户,特别是在模型训练或者工作流调优方面有特殊需求的场景。

- Coze提供了优秀的用户体验和广泛的功能,商业化氛围较浓,适合寻求快速搭建高质量AI Agent的用户,无论是初学者还是进阶用户都能找到合适的工具。

- Dify凭借其开源特性和广泛的模型支持,适合追求高度定制化和灵活性的开发者,尤其是那些希望利用数据处理增强LLM性能的应用场景。

- 这份完整版的A智能体整合包已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【

保证100%免费】

1641

1641

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?