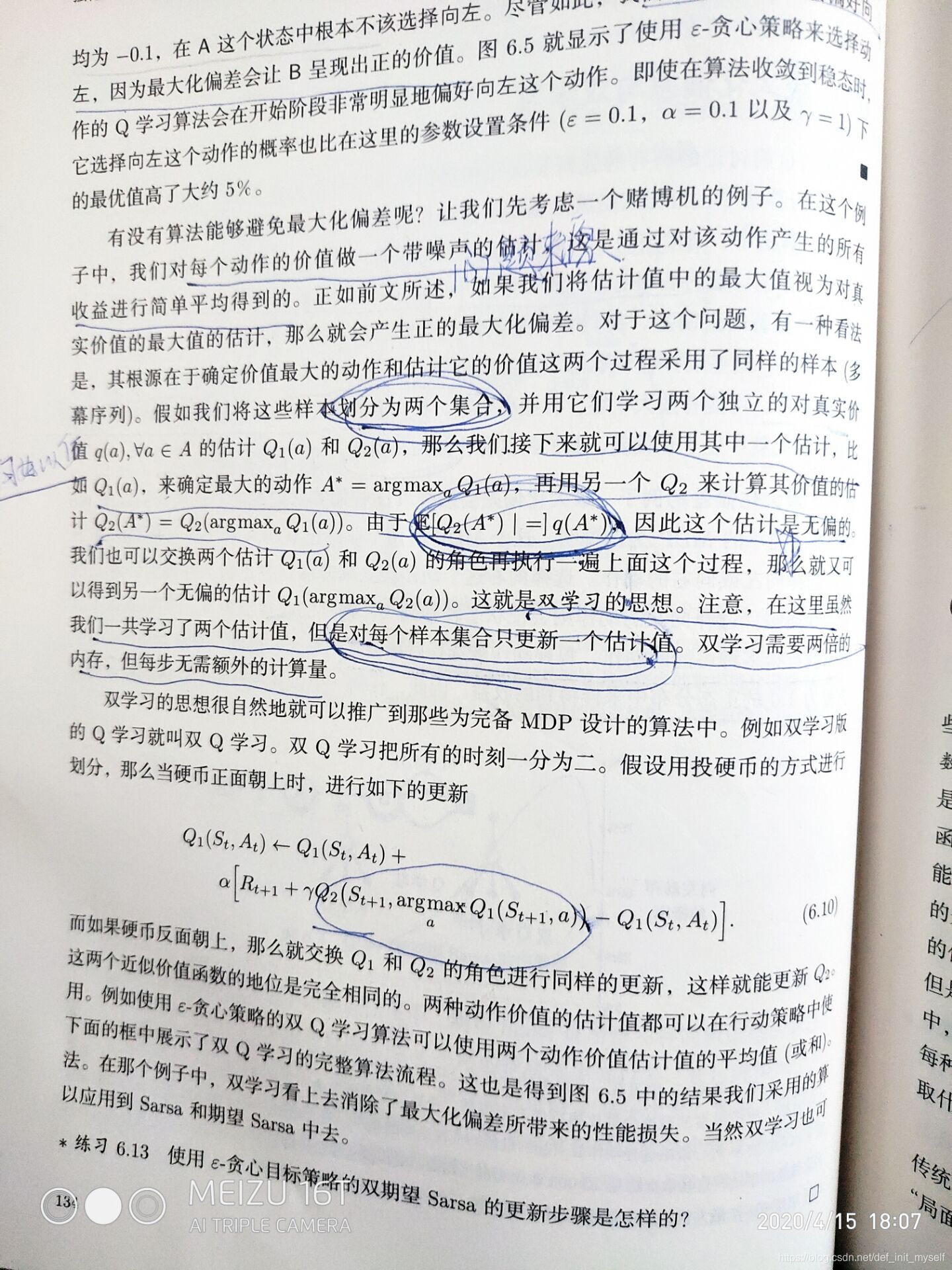

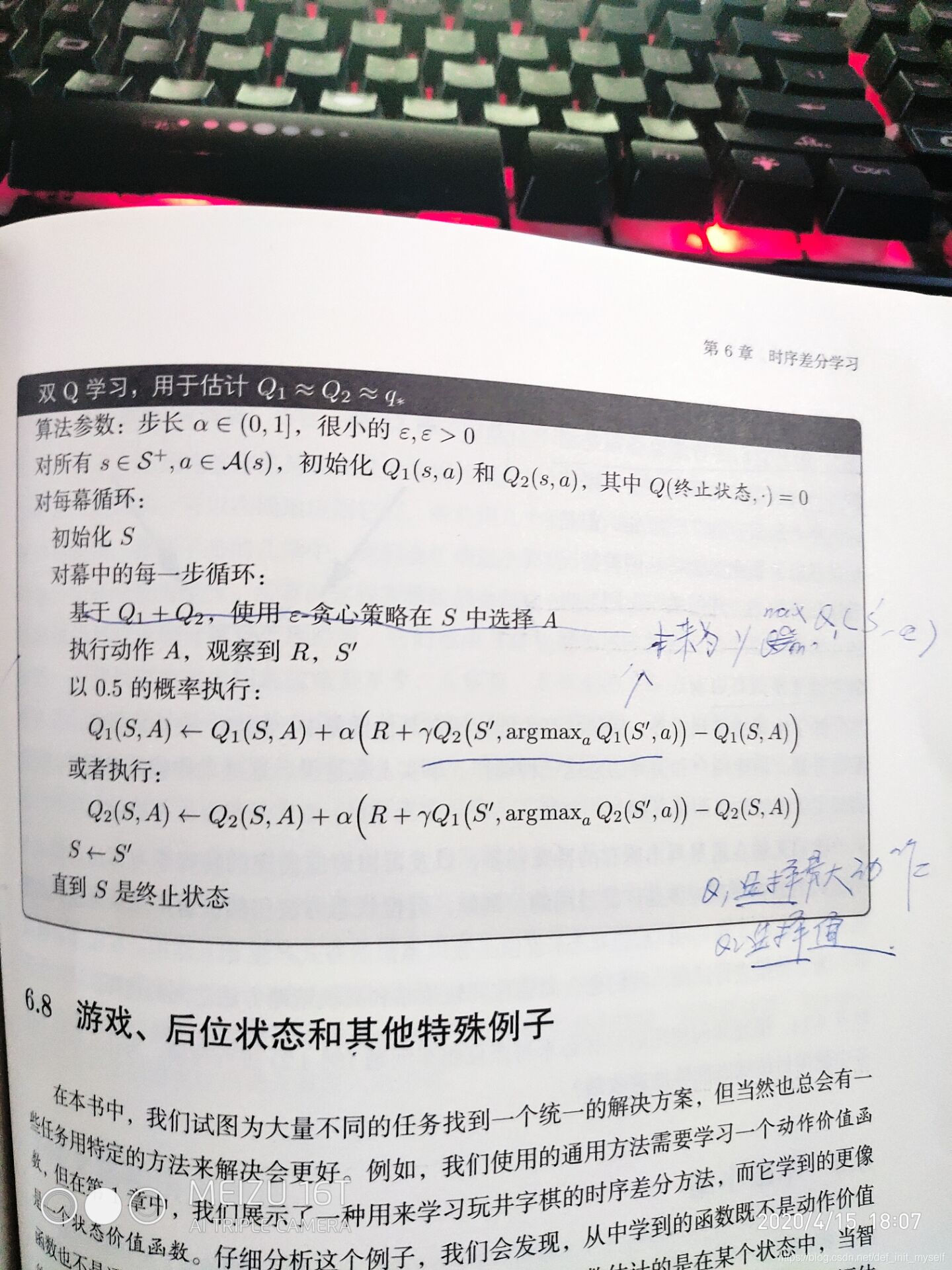

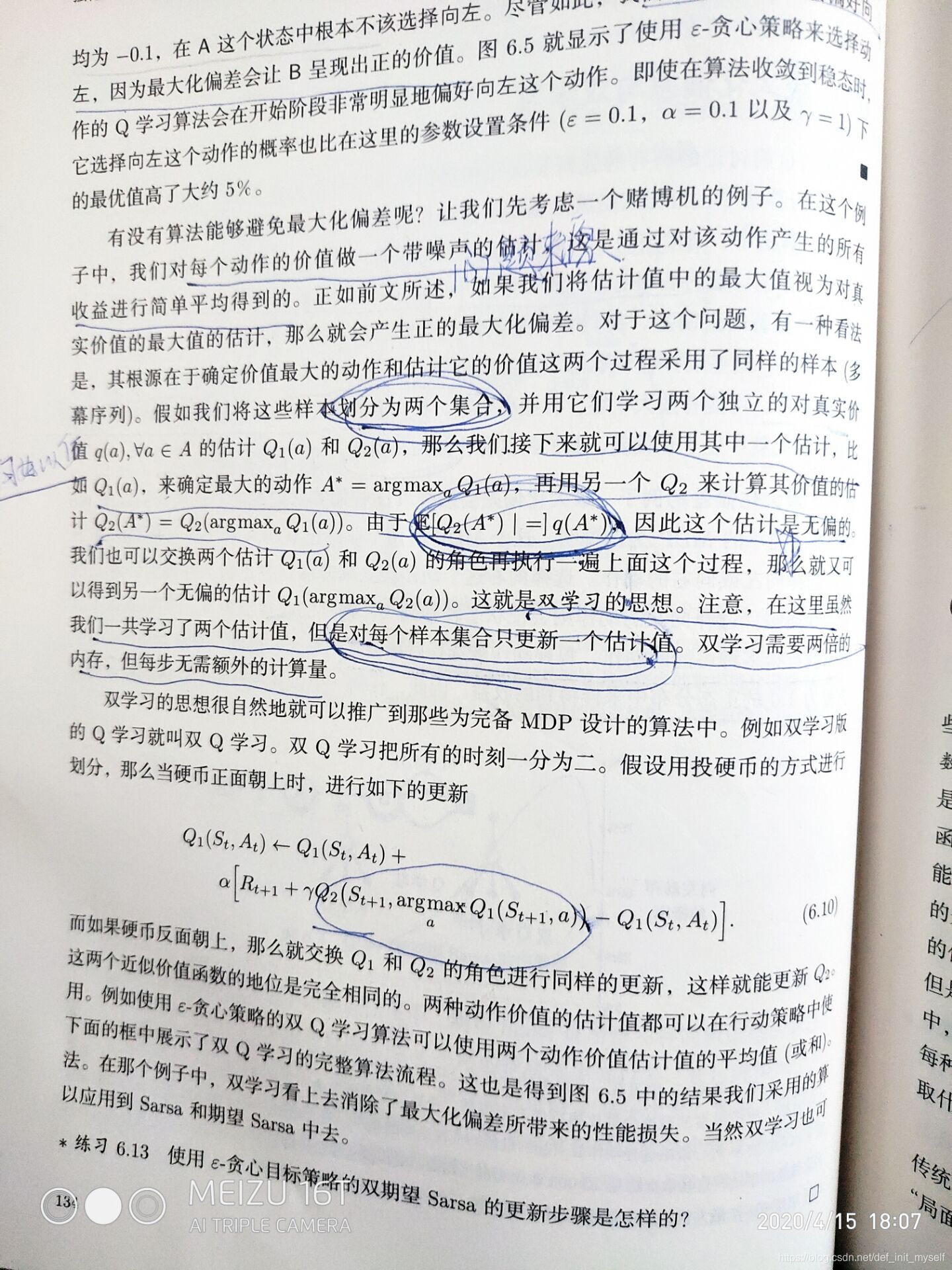

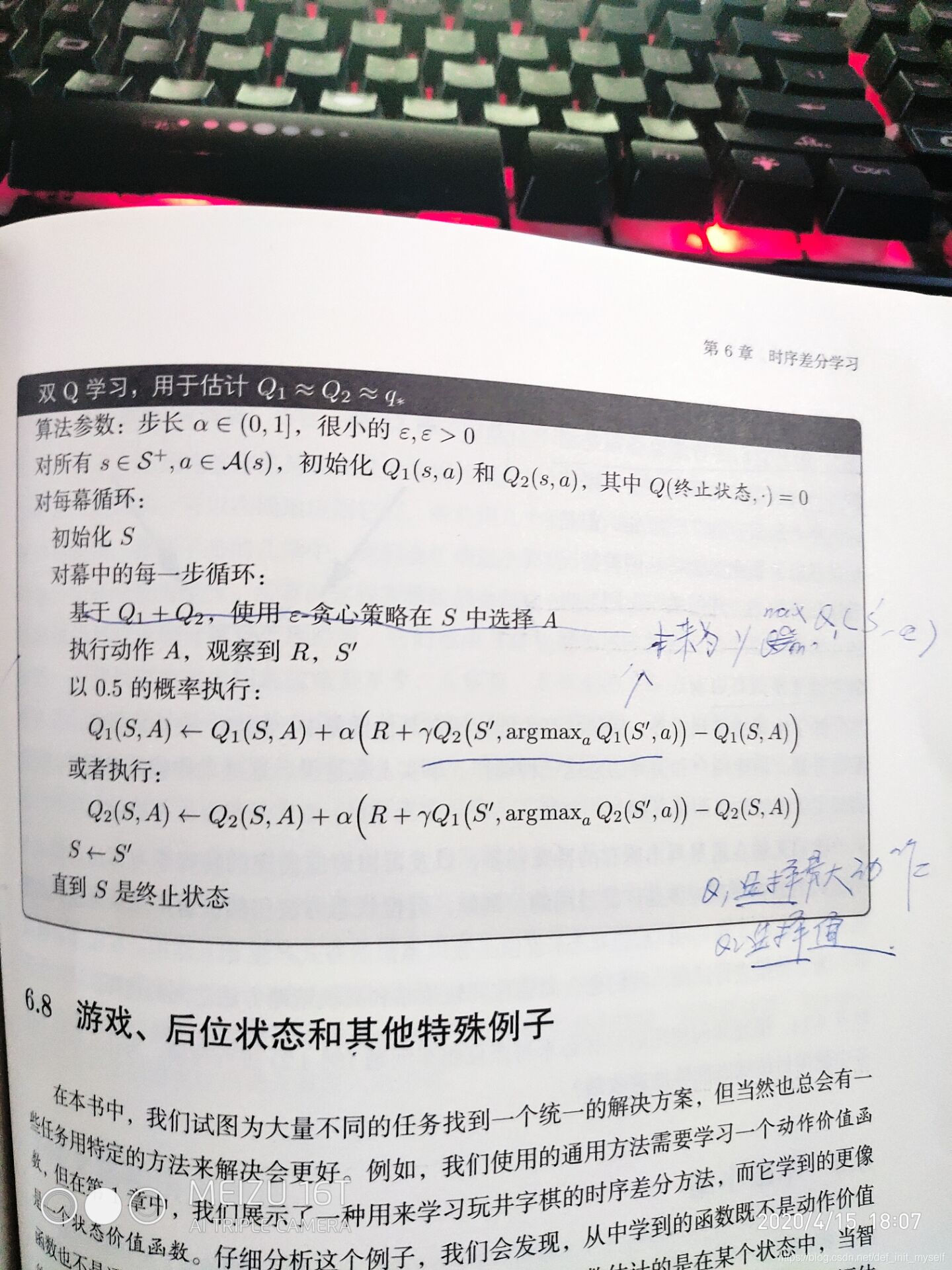

我的理解是这个最大化偏差来源于Q学习中的求取的最大化这个步骤可能得到的值不准确。然后这个期望,我觉得是讲动作和值解耦,然后从E的表达式来看,求得期望就是从另一个Q得到的动作的期望,默认第一个Q学到的是最大动作,然后第二个Q只求期望。两个没有干扰

我的理解是这个最大化偏差来源于Q学习中的求取的最大化这个步骤可能得到的值不准确。然后这个期望,我觉得是讲动作和值解耦,然后从E的表达式来看,求得期望就是从另一个Q得到的动作的期望,默认第一个Q学到的是最大动作,然后第二个Q只求期望。两个没有干扰

同时,在周博磊的视频课程中,也可以认识到,因为我们采取的max这个操作的时候,用的还是待优化的东西,因此不是很准确,有偏差。

本文深入探讨了Q学习中最大化偏差的来源,分析了求取最大值步骤可能导致的不准确性,并解释了通过解耦动作和值来减少这种偏差的方法。同时,提到了在优化过程中使用待优化元素进行max操作带来的潜在问题。

本文深入探讨了Q学习中最大化偏差的来源,分析了求取最大值步骤可能导致的不准确性,并解释了通过解耦动作和值来减少这种偏差的方法。同时,提到了在优化过程中使用待优化元素进行max操作带来的潜在问题。

我的理解是这个最大化偏差来源于Q学习中的求取的最大化这个步骤可能得到的值不准确。然后这个期望,我觉得是讲动作和值解耦,然后从E的表达式来看,求得期望就是从另一个Q得到的动作的期望,默认第一个Q学到的是最大动作,然后第二个Q只求期望。两个没有干扰

我的理解是这个最大化偏差来源于Q学习中的求取的最大化这个步骤可能得到的值不准确。然后这个期望,我觉得是讲动作和值解耦,然后从E的表达式来看,求得期望就是从另一个Q得到的动作的期望,默认第一个Q学到的是最大动作,然后第二个Q只求期望。两个没有干扰

同时,在周博磊的视频课程中,也可以认识到,因为我们采取的max这个操作的时候,用的还是待优化的东西,因此不是很准确,有偏差。

540

540

1671

1671

493

493

520

520

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?