一、西瓜书的阅读方式

周志华大佬建议:

读《机器学习》,建议三次

第一次:建议用时1个月,观其大略

第二次:建议用时3个月,阅读一些具体分支的材料

第三次:建议用时三年,对关键点进行理解,理解本质,升华认识,去理解不同内容之间的联系

二、机器学习的定位

机器学习的经典定义:利用经验改善系统自身的性能

在计算机中就“经验”大多数以数据的形式存在,所以,目前机器学习主要是研究智能数据分析的理论和方法。而我们学习机器学习的过程中,不仅仅只是去了解模型,更重要的是机器学习的这种解决问题的思想。

三、机器学习的背景

机器学习有深厚的数学理论基础和计算机科学理论基础

数学背景中的计算学习理论(Computational learning theory) ,其中PAC是机器学习的重要支撑

PAC(Probably Approximately Corret) learning model:概率近似正确模型

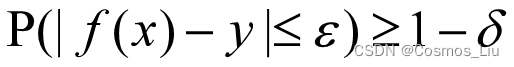

此处注意这个表达式的过程。

此处注意这个表达式的过程。

首先如果我们有一个广义的x,此处的x代表一个样本,f是一种模型,现在让这个模型f去分析样本x ,于是有了f(x),而f(x)输出的结果是一个假设的预测值,y表示真实值。我们非常希望我们预测的f(x)是准确的,这在数学中定量可表示,|f(x)-y|非常小,于是给出一个任意小的ε,有|f(x)-y|<=ε时,如果这个ε非常小,那么说明预测值和真实值非常接近。但是由于我们很难每次都能准确的给出结果,于是用概率来衡量它,如果P(|f(x)-y|<=ε)很大,说明这个模型准确的概率就大,P(|f(x)-y|<=ε)>=1-δ,δ如果足够小,那么这个模型应该是比较准确和稳定了。

四、思考N=Np?

机器学习问题是否属于在多项式时间内可以验证的问题?或者多项式时间内可以验证这个解有多好吗

以及我们在做算法的时候,应该考虑到时间复杂度等问题。

五。阅读脉冲神经网络发展综述

神经网络被认为是当前人工智能发展的主要驱动力,其经历了几个发展阶段:第一个阶段是感知机,1957 年美国神经学家 Frank Rosenblatt 提出可以模拟人类感知能力的机器,并称之为“感知机”,随后成功在 IBM704 机上完成了感知机的仿真,并于 1960 年基于感知机实现了能够识别一些英文字母的神经计算机。

第二个阶段是基于联结主义的多层人工神经网络 (Artificial Neural Network, ANN),其兴起于二十世纪 80 年代中期,并在 2006 年以后以深度卷积网络,引领了近十几年人工智能的发展。然而,ANN 在生物学上是不精确的,缺少神经内部的动力学机制,不能较准确地模仿生物大脑神经元的运作机制。近年来起源于脑科学的脉冲神经网络(Spiking Neural Network, SNN) 被誉为新一代的神经网络,SNN 领域的研究仍然处于快速发展的早期阶段。当前 SNN 领域的研究主要围绕神经元模型、训练算法、编程框架、数据集以及硬件芯片加速五大方向进行。

在神经元模型领域,积分泄漏发放(Leaky Integrate-and-Fire, LIF)模型及其变体,寻找兼具高生物可实现性、良好的网络学习能力以及超大规模集成电路构建能力的神经元模型是目前需要研究的问题。

训练算法领域当前主要分为以脉冲时间依赖可塑性(Spike-timing Dependent

Plasticity,STDP) 为代表的非监督训练算法[31] 与以 ANN转 SNN 和时间空间维度的误差反传 为代表的有监督训练算法。尽管训练算法众多,当前 SNN 在超大超深层的网络训练算法上,仍然面临脉冲信号如何编码、梯度消失、训练资源开销大甚至算法收敛性的问题。因此,研究超大超深层 SNN 网络的编码方式和匹配的训练算法是需要研究的问题。当前支持 ANN 训练的编程框架种类繁多,常见的有 Theano、TensorFlow、Caffe、Pytorch、MXNet 和 Keras等。

在数据集方向, 我们认为 SNN 和 ANN的比较应该面向不同的数据集和任务。当前,ANN 领域有种类繁多的数据集,包括MNIST、CIFAR-10、ImageNet等。而适合 SNN 的数据集由时空事件流构成,目前仅有Neuromorphic-MNIST、N-Caltech101、DVS-CIFAR10、DVS-Gesture等比较小的数据集。发展更大规模且更加契合 SNN 时空处理能力的数据集将成为 SNN 发展的驱动力之一

在硬件芯片加速方向,正因为 SNN 在硬件电路上具有超低能耗实现的优势,最近十年以曼彻斯特大学的 SpiNNaker 芯片、美国斯坦福大学 Neurogrid 芯片、IBM TrueNorth 芯片、英特尔 Loihi 芯片[13]、浙江大学达尔文芯片 为代表,支持 SNN 硬件实现的神经形态芯片异军突起。

相比之下,当前脉冲神经网络领域尚不存在公认的核心训练算法与技术。在生物合理性与任务表现间存在不同的侧重度,以及网络采用的神经元模型和编码方式各异造成了训练算法的多样化。依据训练过程中是否使用标签信息,可以将其概括性地划分为无监督学习与有监督学习两类。

文章探讨了机器学习的阅读方法,强调了理解《机器学习》的三次深入过程。机器学习被定义为利用数据改善系统性能,其理论基础包括PAC学习模型。脉冲神经网络(SNN)作为新一代神经网络,正快速发展,但训练算法和大规模数据集仍是挑战。硬件芯片的进展为SNN提供了低能耗实现的可能性。

文章探讨了机器学习的阅读方法,强调了理解《机器学习》的三次深入过程。机器学习被定义为利用数据改善系统性能,其理论基础包括PAC学习模型。脉冲神经网络(SNN)作为新一代神经网络,正快速发展,但训练算法和大规模数据集仍是挑战。硬件芯片的进展为SNN提供了低能耗实现的可能性。

17万+

17万+