1、主要参考

(1)

(2)

https://www.jianshu.com/p/bca9fa02efbb

(3)

关于Resnet网络中残差连接实线与虚线的含义_FYY2LHH的博客-优快云博客_resnet 虚线

2、Resnet的网络结构

2.1 整体网络结构

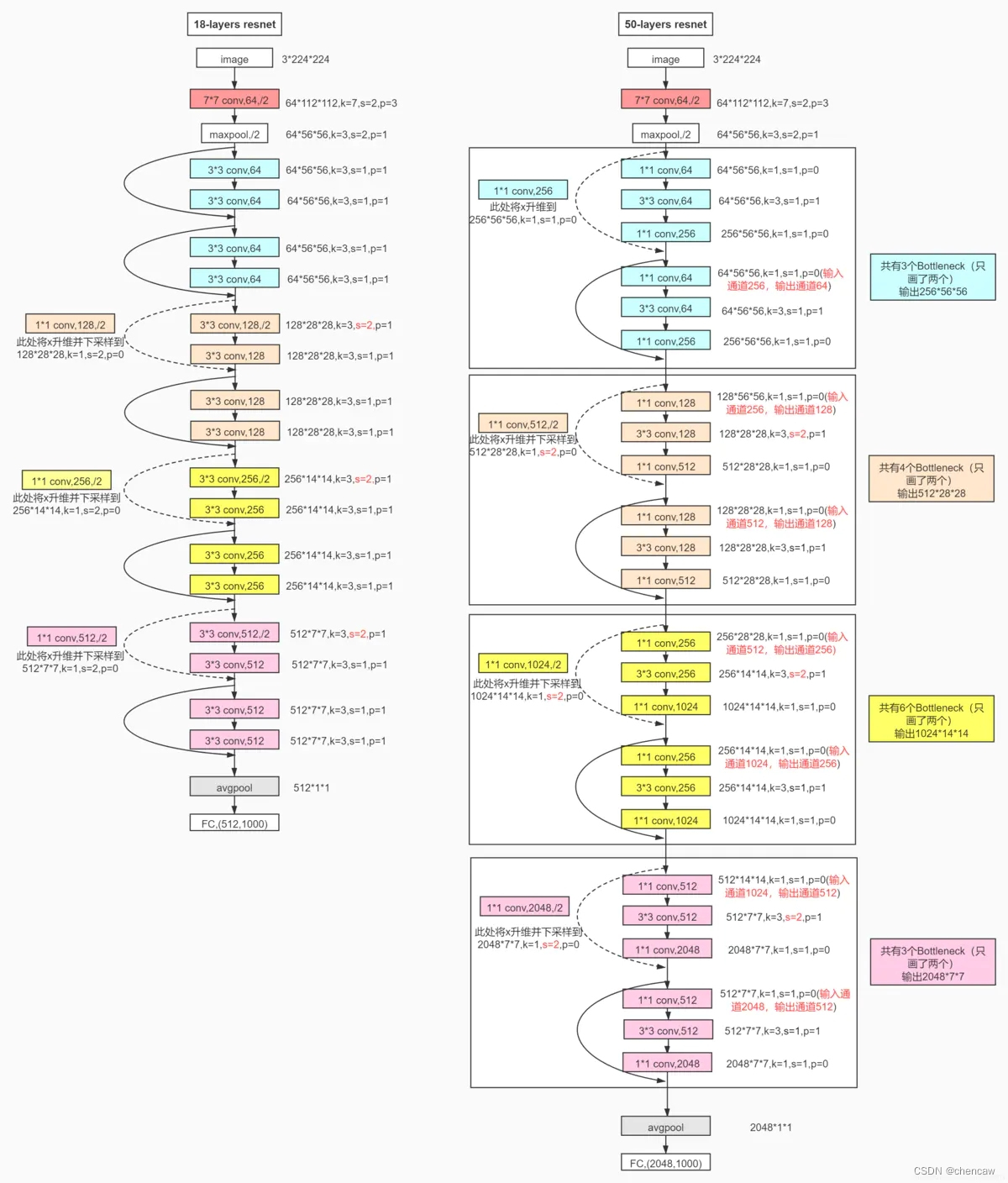

resnet 所使用的网络结构如下图所示

2.2 两种不同的resnet模块

在何大佬的文章中,提出了下面两种残差块:

注意:resnet18只用了左侧最基础的模块。

2.3 虚线连接和实现连接

(1)何大神的在论文中给出了两种连接,分别是实线连接和虚线连接

(2)多个层是作为一个block存在的(对应上面的conv2_x,conv3_x,conv4_x,conv4_x),

(3)每个层(conv2_x,conv3_x,conv4_x,conv4_x)的内部用实线连接,因为输入的通道数与输出的通道数是相同的,那么通过残差连接就可以直接相加。

(4)每个层(conv2_x,conv3_x,conv4_x,conv4_x)之间用虚线连接,衔接上下两层的部分,输入通道的维数与输出通道的维数并不相同,那么不能直接相加,这时候就需要在残差连接的过程中添加一个1*1的卷积核来改变通道数。

2.4 resnet18和resnet50的结构图

本文详细介绍了Resnet网络结构,包括整体网络布局、两种不同类型的残差模块,以及实线和虚线连接的区别。重点解析了resnet18和resnet50的结构差异,特别是虚线连接在通道数不同时如何通过1*1卷积进行调整。

本文详细介绍了Resnet网络结构,包括整体网络布局、两种不同类型的残差模块,以及实线和虚线连接的区别。重点解析了resnet18和resnet50的结构差异,特别是虚线连接在通道数不同时如何通过1*1卷积进行调整。

5872

5872

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?