大家好,我是爱酱。本篇延续将会系统梳理合成数据(Synthetic Data)的核心原理、主流方法、数学表达、工程实践与未来趋势,结合数学公式,帮助你全面理解这一AI建模的关键技术。

注:本文章含大量数学算式、详细例子说明及大量代码演示,大量干货,建议先收藏再慢慢观看理解。新频道发展不易,你们的每个赞、收藏跟转发都是我继续分享的动力!

一、合成数据是什么?

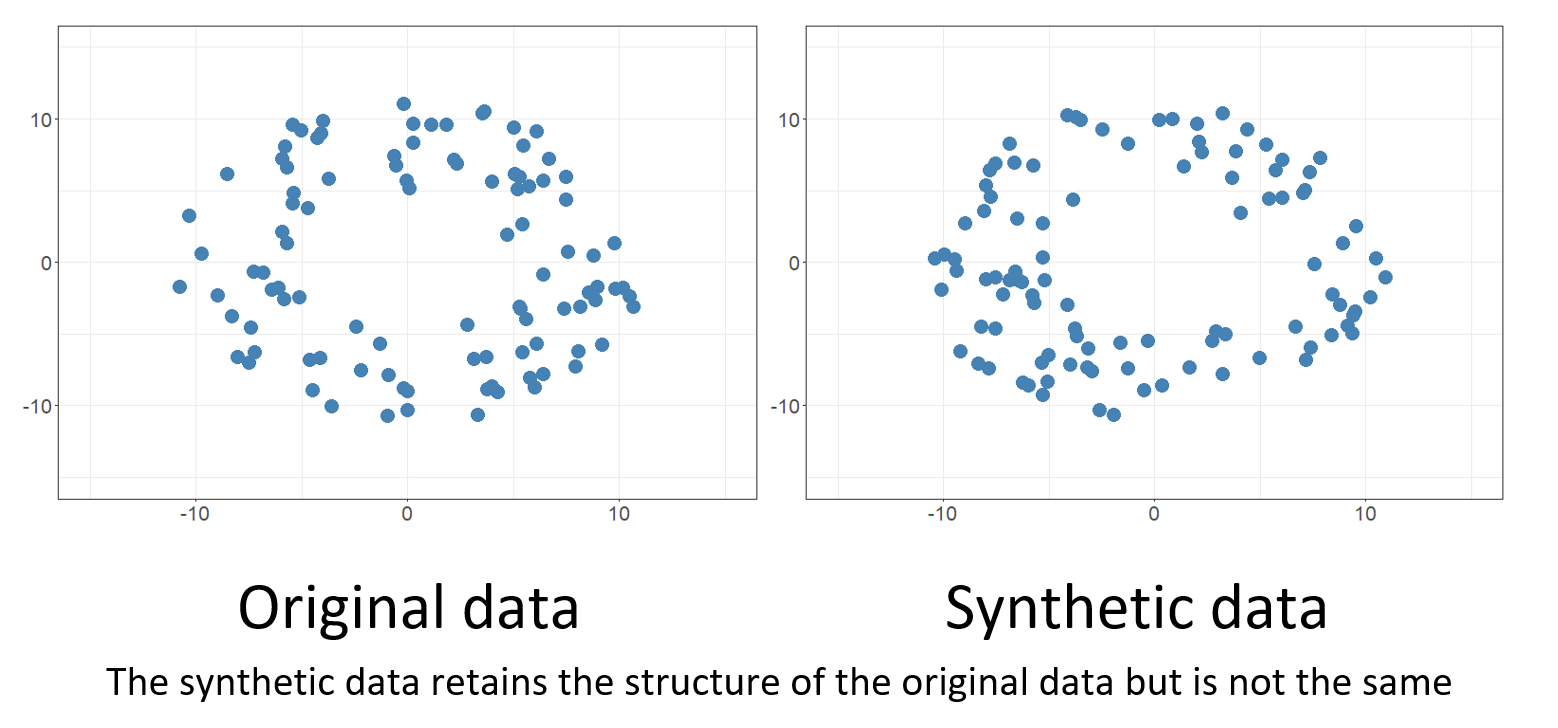

合成数据(Synthetic Data)指通过算法、仿真或生成模型(如GAN、VAE、GPT等)人工生成的数据。这些数据在统计分布、结构和相关性上高度拟合真实数据,但不包含任何真实个体的直接信息。

-

英文专有名词:Synthetic Data, Generative Model, Data Synthesis

-

本质:用AI或统计方法“造”出与真实数据分布一致但不含原始敏感信息的全新数据。

二、合成数据的核心原理与数学表达

1. 基本思想

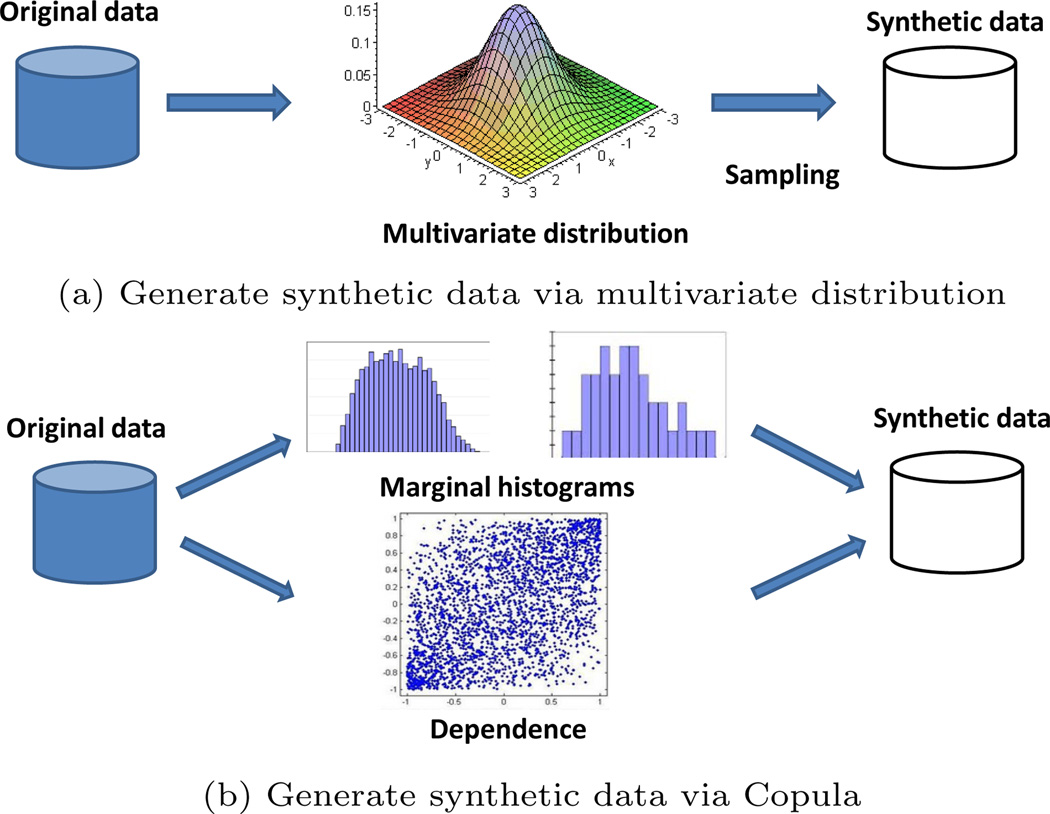

合成数据的生成通常分两步:

-

用真实数据训练生成模型,学习其分布、相关性与特征结构。

-

用训练好的生成器随机采样,生成“假”数据。

2. 数学表达

-

原始数据集:

-

生成模型(如GAN、VAE、GPT):

其中

为参数为

的生成器,

为噪声或先验分布。

-

合成数据集:

-

分布拟合目标:

其中

为KL散度,

为真实数据分布,

为生成器生成的数据分布。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

707

707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?