简介

提出了一种声音分离网络,对视觉特征应用了空间最大池化,与声音特征进行点乘融合,以二值或软掩膜作为监督信号。每个音频有对应的视觉响应。收集了MUSIC数据集。

所提方法

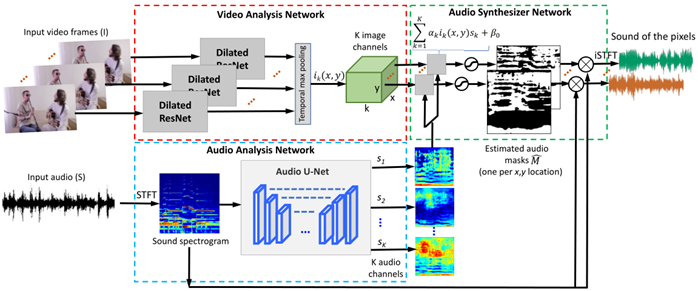

网络结构

视频分析网络:使用ResNet-18作为骨干,提取T×(H/16)×(W/16)×K,使用了时间池化。

音频分析网络:对数声谱图,用U-Net作为骨干。==为何用对数声谱图?==对于诸如乐器等的谐波具有平移不变性(其基频和高阶谐波随着音高的变化在对数频率尺度上平移)

合成网络:帧特征和声音特征同时输入,为视觉特征乘以一个可学习的尺度因子(与通道数量相等),然后与声音特征进行点乘,最后加上一个偏置。

损失函数

L1 loss

实施

数据集:混合的声音为单独的声音进行线性相加。掩膜可以是二值的格式,也可以是比例的格式。

若为二值格式,则目标声音掩膜上每个位置的值,是由该声音是否占据混合声音的主要成分来确定的

Mn(u,v)=⟦Sn(u,v)≥Sm(u,v)⟧,∀m=(1,...,N)M_n(u,v)=\llbracket S_n(u,v)\geq S_m(u,v)\rrbracket, \forall m=(1,...,N)Mn(u,v)=[[Sn(u,v)≥Sm(u,v)]],∀m=(1,...,N),此时的损失函数为sigmoid cross entropy loss。

若为比例格式,则为Mn(u,v)=Sn(u,v)Smix(u,v)M_n(u,v)=\frac{S_n(u,v)}{S_{mix}(u,v)}Mn(u,v)=Smix(u,v)Sn(u,v),使用L1损失

音频采样率降到11kHz,在训练时随机为每个音频采集6秒,STFT的窗口尺寸为1022,步幅256,得到512×256的对数声谱图

本文提出了一种声音分离网络,通过结合ResNet-18提取的视频特征和U-Net处理的对数声谱图声音特征,利用点乘融合策略实现声音分离。网络采用空间最大池化处理视觉信息,并以二值或比例掩膜作为监督信号。实验在MUSIC数据集上进行,数据集中的混合声音由单独声音线性相加构成。损失函数根据掩膜格式选择L1损失或sigmoid交叉熵损失。该方法旨在识别并分离视频中的特定声音源。

本文提出了一种声音分离网络,通过结合ResNet-18提取的视频特征和U-Net处理的对数声谱图声音特征,利用点乘融合策略实现声音分离。网络采用空间最大池化处理视觉信息,并以二值或比例掩膜作为监督信号。实验在MUSIC数据集上进行,数据集中的混合声音由单独声音线性相加构成。损失函数根据掩膜格式选择L1损失或sigmoid交叉熵损失。该方法旨在识别并分离视频中的特定声音源。

1081

1081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?