文章汉化系列目录

文章目录

摘要

我们提出了DenseAV,这是一种新颖的双编码器定位架构,能够仅通过观看视频来学习高分辨率、语义丰富并且音视频对齐的特征。我们展示了DenseAV可以在没有明确定位监督的情况下,发现单词的“含义”和声音的“位置”。此外,它能够在没有监督的情况下自动发现并区分这两类关联。我们证明了DenseAV的定位能力源自一种新的多头特征聚合操作符,该操作符直接比较密集的图像和音频表示,用于对比学习。相比之下,许多其他系统学习的是“全局”音频和视频表示,无法定位单词和声音。最后,我们贡献了两个新的数据集,用于通过语音和声音提示的语义分割来改进AV表示的评估。在这些数据集和其他数据集上,我们展示了DenseAV在语音和声音提示的语义分割任务中大幅超越了现有技术水平。DenseAV在跨模态检索任务中也超越了当前的最先进模型ImageBind,并且参数量少于一半。项目页面:https://aka.ms/denseav

1.引言

将音频与视频关联是人类感知的基本方面之一。随着婴儿的成长,声音的同步和对应关系使得多模态关联成为可能——例如,将声音与面孔对应,或者将“哞声”与牛对应【50】。之后,随着他们语言能力的发展,他们会将口语与其代表的物体关联起来【10, 45】。令人惊讶的是,这些关联能力(包括语音识别、声音事件识别和视觉对象识别)几乎是在没有直接监督的情况下发展起来的。本研究的目标是通过学习高分辨率、语义丰富的音视频(AV)对齐表示来构建一个具备这种能力的模型。具备这些特性的特征可以用于在没有定位监督或语言文本表示知识的情况下,发现模态之间的细粒度对应关系。

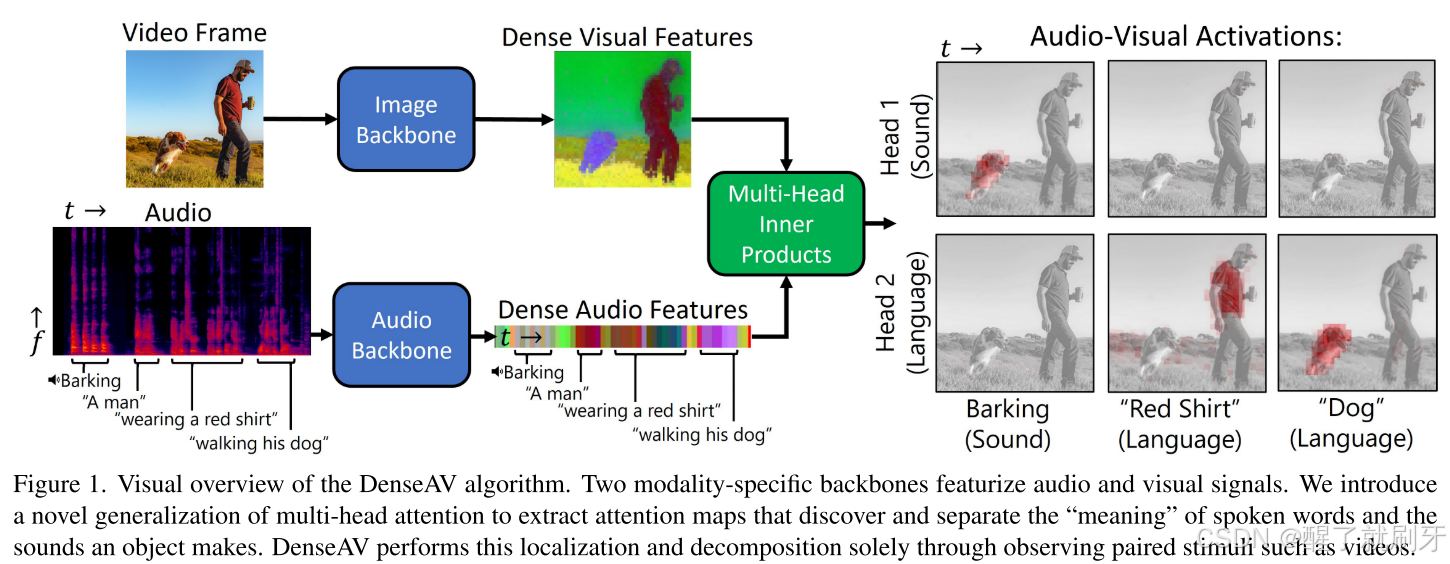

举个例子,考虑图1所示图像的语音描述和伴随的声音。我们希望以高分辨率“定位”语音和声音。例如,如果视觉信号中存在狗的图像,那么音频信号中的“狗”这个词和狗叫声都应该与视觉信号中狗的像素关联起来。我们追求高质量的局部特征表示,其中特征之间的简单内积能够展示这种行为,而有趣的是,现有文献中的流行方法并没有表现出这一点。

图1. DenseAV算法的视觉概览。两个模态特定的主干网络对音频和视觉信号进行特征提取。我们引入了一种多头注意力机制的广义化版本,以提取注意力图,从而发现并分离口语单词的“含义”和物体发出的声音。DenseAV仅通过观察诸如视频等成对的刺激来实现这种定位和分解。

为实现这一目标,我们做了三项创新。首先,我们引入了DenseAV,这是一种双编码器架构,它在音频和视觉特征上计算出一个稠密的相似度体积,然后将该体积聚合为一个相似度分数。如果我们观察当某个单词被说出时这个相似度体积的某一切片,如图1所示,我们可以可视化单词或声音与图像像素之间的音视频(AV)激活强度。我们引入的新颖之处在于使用多头机制对这种稠密相似度进行广义化,类似于多头注意力机制。这种广义化允许每个头部专注于视觉和音频模态之间的特定类型的耦合。有趣的是,我们发现当给DenseAV两个头并在包含语言和声音的数据集上进行训练时,这些头能够在仅使用跨模态监督的情况下,自然地学习区分语言和更一般的声音。例如,如图1所示,头1专注于哪个物体发出声音,比如狗的叫声,而头2则只专注于单词的含义。

其次,我们展示了在对比学习中,使用“聚合函数”来创建音频片段与视频帧之间的相似度分数的重要性。传统的选择,例如使用全局表示(如类别标记【5, 13, 49】)或池化特征【18, 58】之间的内积,无法促进稠密局部特征的音视频对齐。因此,许多在跨模态检索中表现优异的流行音视频主干网络,无法通过其局部特征直接关联对象和声音。这限制了它们在下游任务(如语义分割、声音定位或无监督的语言学习与发现)中的应用能力。

第三,我们引入了两个语义分割数据集,用于评估通过音视频(AV)表示进行的语音和(非语音)声音的视觉定位。这些数据集基于ADE20K数据集【59】提供的高质量分割掩码构建,并在二元掩码预测任务中测量平均精度(mAP)和平均交并比(mIoU)。相比之前用于测量视觉定位的评估方法(如概念计数指标【23】和“指点游戏”【2, 14, 38】),这些方法仅检查热图的峰值是否位于目标框或段内,我们的评估更简单且更加全面。此外,我们的评估避免了使用不稳定的WordNet本体【34】、聚类、Wu和Palmer距离【55】、阈值选择及其他复杂因素。

总结起来,我们的主要贡献如下:

- 我们提出了DenseAV,这是一种新颖的自监督架构,能够学习高分辨率的音视频(AV)对应关系。

- 我们引入了一种基于局部特征的图像相似度函数,与常见策略(如平均池化或CLS标记)相比,这显著提升了网络的零样本定位能力。

- 我们引入了新的数据集,用于评估由语音和声音提示的语义分割任务。实验表明,DenseAV在这些任务以及跨模态检索中明显优于当前的最先进方法。

- 我们发现,多头架构自然地将音视频对应关系解耦为声音和语言成分,并且仅通过对比监督实现了这一点。

2.相关工作

音视频(AV)、文本视觉以及更广泛的多模态模型最近迅速流行起来【60】。从广义上讲,DenseAV是一种音视频对比学习架构,这类方法通过对齐配对信号并推开负信号来学习AV表示【11, 27】。在这一类模型中,有些在声音定位【2, 7, 42】或捕捉语言语义【23, 43】方面表现突出。许多这类模型通过全局表示(如池化的深度特征或类别标记)之间的内积来比较AV信号【18, 35, 53】,或使用类别标记【17, 32, 42, 43, 49】。尤其是,ImageBind因其在各种任务和数据集上表现优异,以及统一的类别标记对比架构而受到关注。在这项工作中,我们展示了许多此类架构虽然在“全局”跨模态检索上表现出色,但在其局部特征中并没有表现出强大的定位能力。这限制了它们在处理新领域的声音、没有文本表示的声音以及低资源语言中的适用性。我们不同于这些方法的是,直接监督局部特征标记。特别是,我们基于之前的工作【2, 23】,这些工作显示最大池化可以改善定位能力,并引入了一种新的多头聚合操作符,该操作符使用类似于自注意力【52】的机制来推广之前的损失函数。

另一类方法通过单模态和多模态聚类来发现信号中的结构。早期的音频聚类工作【41】在无监督的情况下发现了有意义的语音片段。类似的视觉分析方法也发现了视觉对象【4, 8, 20, 28】。最近的一些工作将这些思想应用于音视频(AV)领域【1, 21】,但它们并不关注提取高分辨率的AV表示。最后,一些研究探讨了生成式音视频学习。The Sound of Pixels【57】通过源分离损失生成特定对象的声音。更近的方法则使用生成对抗网络(GAN)【30, 31】和扩散模型【9, 17, 33】生成视频中的音频,或反向生成音频中的视频。本文的重点是改进对比学习模型的局部表示,因为这些方法相对具有较好的扩展性、简单性,并且能够学习高质量的表示。

3.方法

从总体上看,DenseAV试图通过稠密的音视频(AV)表示来判断给定的音频和视觉信号何时属于同一个场景。为了稳健地完成这一任务,DenseAV必须学习如何从视觉信号预测音频内容,反之亦然。这使得DenseAV能够学习到模态特定的稠密特征,捕捉不同模态之间共享的互信息【51】。一旦学会了这些特征,我们可以直接查询这些信息丰富的特征来执行如图1所示的语音和声音提示的语义分割任务。

更具体地说,DenseAV由两个模态特定的深度特征提取器构建。这些主干网络在一个音频片段上生成时间变化的音频特征,并在单个随机选取的帧上生成空间变化的视频特征。我们的损失函数基于这样一个直观假设:如果两个信号之间有多种强耦合或共享对象,则它们是相似的。更正式地说,我们通过小心地聚合稠密特征之间的成对内积,来为一对音频和视频信号形成一个标量相似度。我们使用了InfoNCE【36】对比损失函数,鼓励“正”信号对之间的相似性,并减少通过批内随机打乱形成的“负”信号对之间的相似性。图3以图形方式描述了这个损失函数,随后的章节详细介绍了我们架构的每个组成部分。

图3. 多头注意力聚合器的架构概览。在我们的实验中,稠密特征图被分成K个头(K = 1, 2)。我们通过对每个头的特征在视觉和音频信号的空间和时间范围内进行内积来形成一个音视频(AV)激活张量,如公式1所示。然后,我们通过对头部和空间维度进行最大池化、对音频维度进行平均池化,将这个相似度体积聚合成一个相似度分数。我们的目标是鼓励网络识别音频和视觉模态之间的特定共享对象。特别地,对头部的最大池化能够将声音和语言进行解耦,而对空间维度的最大池化有助于定位对象。

3.1. 多头相似度聚合

DenseAV的关键架构区别在于其损失函数,该损失函数直接监督视觉和音频特征提取器的“局部”标记。这与其他工作【5, 17, 19, 39, 46, 49】有显著不同,后者在对比损失之前,将模态特定的信息池化成“全局”表示。与这些先前的工作不同,我们的损失函数聚合了局部标记之间的全部成对相似度,形成音频和视觉信号对的总体相似度度量。图2显示,这种架构选择使DenseAV的局部特征能够跨模态对齐,而其他方法如平均池化、类别标记和SimPool【44】则无法实现这种对齐。

图2. 现代架构中关联音频和视频模态的定性比较。只有DenseAV能够学习到高分辨率且语义对齐的局部特征集。这使我们可以仅通过深度特征之间的内积来执行语音和声音提示的语义分割。其他方法,例如ImageBind,没有显示对齐的局部特征图。而一些展示出一定定位能力的方法,如DAVENet,无法泛化到声音和语言,也无法达到DenseAV的高分辨率定位能力。局部特征使用PCA进行可视化,参考【20】。

我们首先非正式地描述我们的损失函数,随后在下一段中更精确地定义它。我们的损失函数通过计算每对视觉和音频特征的(未归一化的)内积,生成一个“内积体积”。这个体积表示音频信号的每个部分与视觉信号的每个部分之间的耦合强度。我们的目标是找到许多在正对音频和视觉信号之间的大耦合点,理想情况下,这些耦合应该将视觉对象与其在音频信号中的参照关联起来。相反,我们不希望在负对信号之间找到耦合点。为了计算一对信号的整体耦合强度,我们将这个成对相似度体积聚合成一个单一的数值。聚合这个体积的方法有很多种,范围从“柔和”的平均池化到“硬”的最大池化不等。平均池化会生成稠密梯度,有助于提升收敛速度和稳定性;然而,最大池化允许网络专注于最佳的耦合点,而不考虑物体的大小或声音的持续时间。我们的聚合函数结合了平均池化和最大池化的优点,通过在视觉维度上进行最大池化,并在音频维度上进行平均池化【23】。直观地讲,这种方法在音频信号上平均了最强的图像耦合,这既允许小的视觉对象产生大的影响,又为信号的多个区域提供强有力的训练梯度。最后,我们从多头自注意力机制【52】中获得灵感,将这一操作推广到多个“头”,并在对视觉和音频维度进行池化之前对每个头进行最大池化。这允许DenseAV发现跨模态关联对象的多种“方式”。

更为正式地定义,相似度 S ( a , v ) ∈ R S(a, v) \in \mathbb{R} S(a,v)∈R 表示音频特征张量 a ∈ R C × K × F × T a \in \mathbb{R}^{C \times K \times F \times T} a∈RC×K×F×T(维度为通道数 C × K × F × T C \times K \times F \times T C×K×F×T)与视觉特征张量 v ∈ R C × K × H × W v \in \mathbb{R}^{C \times K \times H \times W} v∈RC×K×H×W(维度为 C × K × H × W C \times K \times H \times W C×K×H×W)之间的相似度。为了定义这个标量相似度分数,首先我们创建一个局部相似度体积 s ( a , v ) ∈ R K × F × T × H × W s(a, v) \in \mathbb{R}^{K \times F \times T \times H \times W} s(a,v)∈RK×F×T×H×W。为了简化,我们考虑单个图像和音频片段之间的聚合相似度,但也可以很容易地将其推广到对视频帧进行最大池化。我们定义的全成对相似度体积为:

s ( a , v ) ∈ R K × F × T × H × W = ∑ c = 1 C a [ c , k , f , t ] ⋅ v [ c , k , h , w ] s(a,v) \in \mathbb{R}^{K \times F \times T \times H \times W} = \sum_{c=1}^{C} a[c,k,f,t] \cdot v[c,k,h,w] s(a,v)∈RK×F×T×H×W=c=1∑Ca[c,k,f,t]⋅v[c,k,h,w]

其中, a [ c , k , f , t ] a[c, k, f, t] a[c,k,f,t] 表示在位置 [ c , k , f , t ] [c, k, f, t] [c,k,f,t] 处的音频特征值, ⋅ \cdot ⋅ 表示标量乘法。

然后,我们将这个相似度体积聚合成一个单一分数 S ( a , v ) ∈ R S(a, v) \in \mathbb{R} S(a,v)∈R:

S ( a , v ) = 1 F ⋅ T ∑ f = 1 F ∑ t = 1 T max k , h , w ( s ( a , v ) [ k , f , t , h , w ] ) \mathcal{S}(a, v) = \frac{1}{F \cdot T} \sum_{f=1}^{F} \sum_{t=1}^{T} \max_{k,h,w} \left ( s(a,v)[k,f,t,h,w] \right ) S(a,v)=F⋅T1f=1∑

DenseAV:音视频特征定位与分割新架构

DenseAV:音视频特征定位与分割新架构

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2025

2025

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?