安装gpu版本的pytorch

“GPU是一个卡,是有内存的,等于说我把CPU的数据搬过去了"“GPU是一个卡,是有内存的,等于说我把CPU的数据搬过去了"“GPU是一个卡,是有内存的,等于说我把CPU的数据搬过去了"

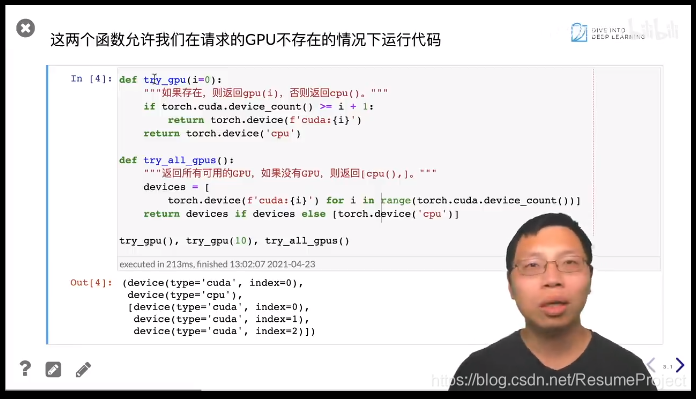

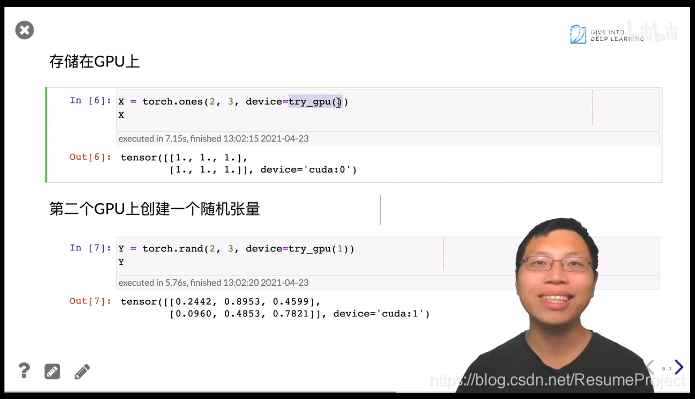

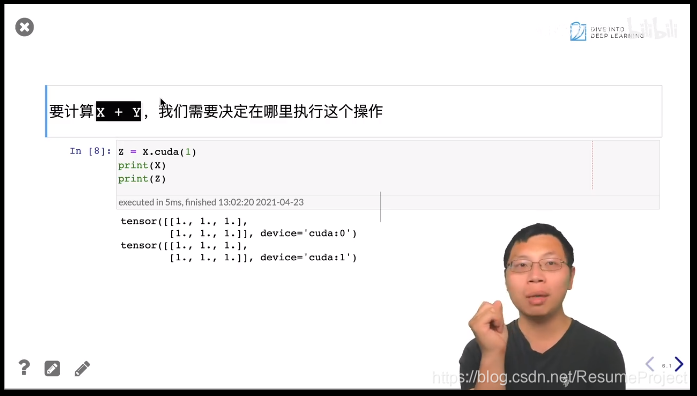

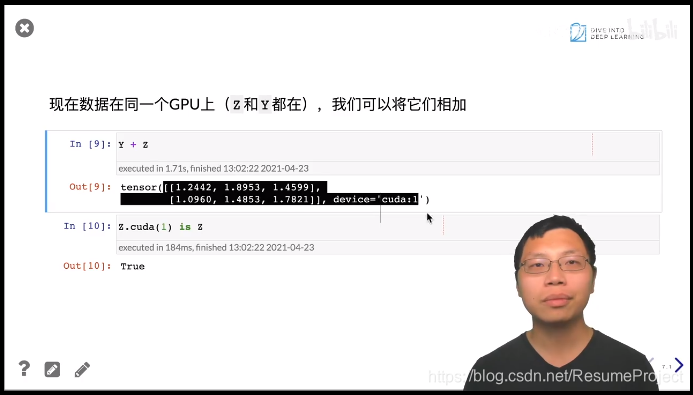

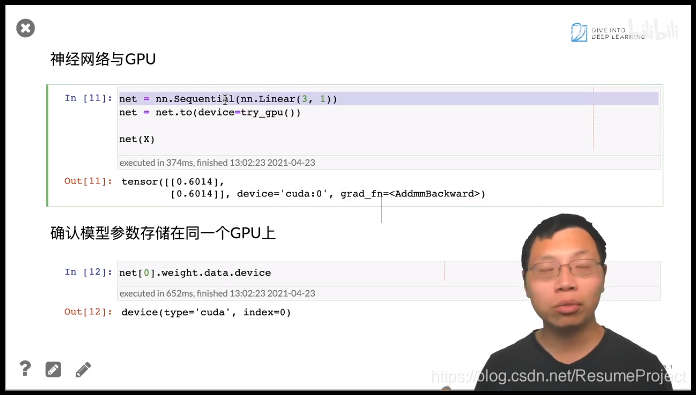

因为在不同的device之间传递数据非常慢,尤其是gpu与cpu之间的传递x与y做运算发生在x和y对应的device上,之前x和y都存在cpu上,x与y的默认运算发生在cpu,同样,在GPU上计算,需要保证在同一个GPU上因为在不同的device之间传递数据非常慢,尤其是gpu与cpu之间的传递\\x与y做运算发生在x和y对应的device上,之前x和y都存在cpu上,x与y的默认运算发生在cpu,\\同样,在GPU上计算,需要保证在同一个GPU上因为在不同的device之间传递数据非常慢,尤其是gpu与cpu之间的传递x与y做运算发生在x和y对应的device上,之前x和y都存在cpu上,x与y的默认运算发生在cpu,同样,在GPU上计算,需要保证在同一个GPU上

怎样在GPU上做神经网路呢?

神经网路可在CPU上创建,然后挪到一个device上

本文介绍了如何在GPU上运行PyTorch神经网络,强调了GPU内存的重要性以及避免CPU-GPU间慢速数据传输的方法。要进行GPU计算,需确保数据都在同一GPU设备上,以提高效率。

本文介绍了如何在GPU上运行PyTorch神经网络,强调了GPU内存的重要性以及避免CPU-GPU间慢速数据传输的方法。要进行GPU计算,需确保数据都在同一GPU设备上,以提高效率。

36万+

36万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?