✅作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,代码获取、论文复现及科研仿真合作可私信。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

🔥 内容介绍

在机器学习和深度学习领域,卷积神经网络(CNN)和长短期记忆网络(LSTM)是两种非常重要的模型。它们在图像分类、语音识别、自然语言处理等任务中取得了令人瞩目的成果。然而,随着问题的复杂性增加,单一模型的性能可能会受到限制。因此,结合多个模型以提高性能已成为当前研究的热点之一。

近年来,注意力机制(Attention)在深度学习领域引起了广泛的关注。注意力机制可以使模型集中于输入数据的关键部分,从而提高模型的性能。在自然语言处理任务中,注意力机制已经被广泛应用于机器翻译、文本摘要等任务中,取得了显著的效果。然而,在图像处理和其他领域中,注意力机制的应用相对较少。

为了探索卷积神经网络、双向长短期记忆网络和注意力机制的结合,研究人员提出了SSA-CNN-BILSTM-Attention模型。该模型在Matlab环境中实现,并使用麻雀算法对模型进行优化。这个模型的目标是提高图像分类任务的准确性和性能。

首先,让我们来了解一下卷积神经网络(CNN)。CNN是一种专门用于处理具有网格结构数据的神经网络。它通过卷积层、池化层和全连接层来提取图像的特征,并进行分类。CNN的优点是能够自动学习图像中的特征,从而减少了手工特征提取的工作量。

接下来,我们介绍一下长短期记忆网络(LSTM)。LSTM是一种递归神经网络(RNN)的变体,专门用于处理序列数据。LSTM通过门控机制来捕捉序列数据中的长期依赖关系,并通过记忆单元来存储和更新信息。LSTM的优点是能够处理变长的序列数据,并具有较强的记忆能力。

然后,我们讨论一下注意力机制(Attention)。注意力机制是一种用于加权输入数据的方法,使模型能够集中于关键部分。在SSA-CNN-BILSTM-Attention模型中,注意力机制被应用于图像分类任务中,以提高模型的性能。通过对输入图像的不同区域进行加权,模型可以更好地理解图像的内容,并做出更准确的分类。

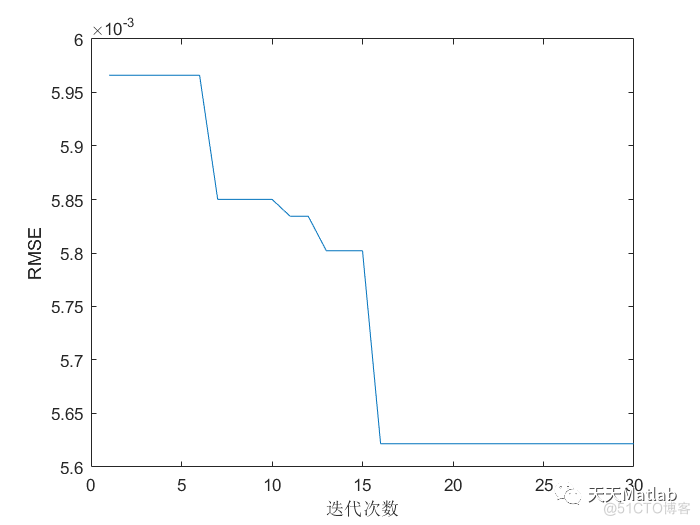

最后,我们介绍一下麻雀算法(Sparrow Algorithm)。麻雀算法是一种基于鸟群行为的优化算法,用于解决复杂的优化问题。在SSA-CNN-BILSTM-Attention模型中,麻雀算法被用于优化模型的参数。通过模拟麻雀群体的行为,算法可以搜索全局最优解,并提高模型的性能。

总结一下,SSA-CNN-BILSTM-Attention模型是一种将卷积神经网络、双向长短期记忆网络和注意力机制相结合的模型。它在图像分类任务中具有较高的准确性和性能。通过使用麻雀算法对模型进行优化,可以进一步提高模型的性能。这个模型在深度学习领域具有重要的研究价值,并有望在实际应用中取得更好的效果。

📣 部分代码

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 导入数据

res = xlsread('数据集.xlsx');

%% 划分训练集和测试集

temp = randperm(357);

P_train = res(temp(1: 240), 1: 12)';

T_train = res(temp(1: 240), 13)';

M = size(P_train, 2);

P_test = res(temp(241: end), 1: 12)';

T_test = res(temp(241: end), 13)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

t_train = ind2vec(T_train);

t_test = ind2vec(T_test );

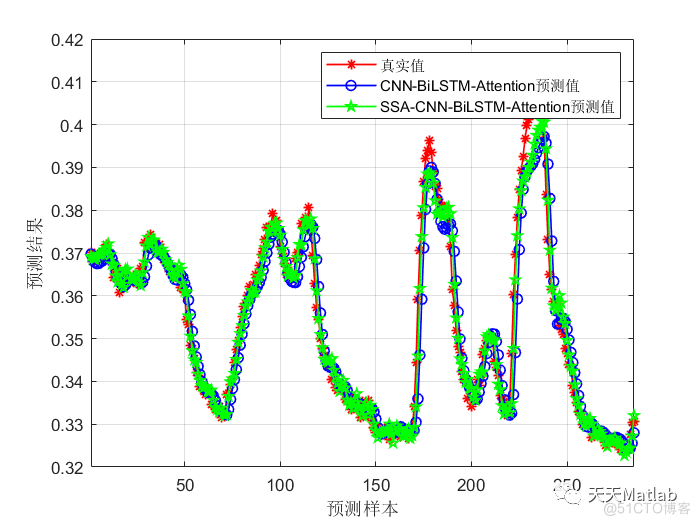

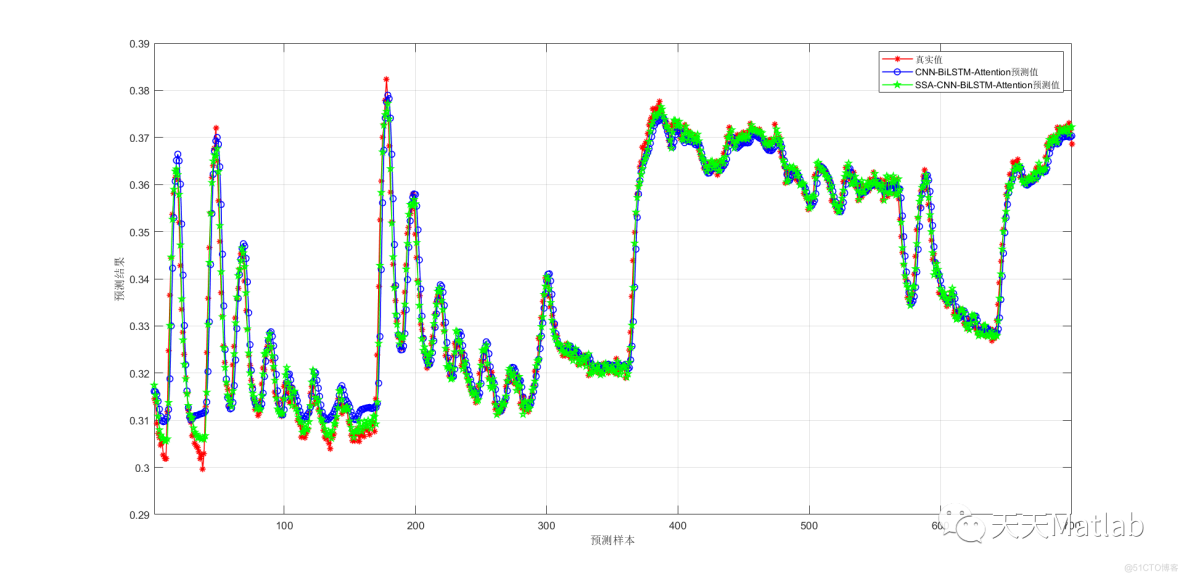

⛳️ 运行结果

🔗 参考文献

[1] Bahdanau, D., Cho, K., & Bengio, Y. (2014). Neural machine translation by jointly learning to align and translate. arXiv preprint arXiv:1409.0473.

[2] Xu, K., Ba, J., Kiros, R., Cho, K., Courville, A., Salakhudinov, R., ... & Bengio, Y. (2015). Show, attend and tell: Neural image caption generation with visual attention. In International conference on machine learning (pp. 2048-2057).

[3] Yang, Z., Yang, D., Dyer, C., He, X., Smola, A., & Hovy, E. (2016). Hierarchical attention networks for document classification. In Proceedings of the 2016 conference of the North American chapter of the association for computational linguistics: human language technologies (pp. 1480-1489).

[4] Yang, Z., Dai, Z., Yang, Y., Carbonell, J., Salakhutdinov, R., & Le, Q. V. (2019). XLNet: Generalized autoregressive pretraining for language understanding. In Advances in neural information processing systems (pp. 5754-5764).

[5] Yang, Z., Dai, Z., Yang, Y., Carbonell, J., Salakhutdinov, R., & Le, Q. V. (2019). XLNet: Generalized autoregressive pretraining for language understanding. In Advances in neural information processing systems (pp. 5754-5764).

深度学习中的SSA-CNN-BILSTM-Attention模型:结合与优化

深度学习中的SSA-CNN-BILSTM-Attention模型:结合与优化

文章探讨了在深度学习中,SSA-CNN-BILSTM-Attention模型如何结合卷积神经网络、长短期记忆网络和注意力机制,以提高图像分类任务的性能。模型利用Matlab实现,并借助麻雀算法进行优化,展示了在复杂问题中的潜力和研究价值。

文章探讨了在深度学习中,SSA-CNN-BILSTM-Attention模型如何结合卷积神经网络、长短期记忆网络和注意力机制,以提高图像分类任务的性能。模型利用Matlab实现,并借助麻雀算法进行优化,展示了在复杂问题中的潜力和研究价值。

2609

2609

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?