🌐 社群导航

🔗 点击加入➡️【AIGC/LLM/MLLM/3D/自动驾驶】 技术交流群

数源AI 最新论文解读系列

论文名:Unified Reward Model for Multimodal Understanding and Generation

论文链接:https://arxiv.org/pdf/2503.05236

开源代码:https://codegoat24.github.io/UnifiedReward/

导读

近期在人类偏好对齐方面的进展极大地推动了多模态生成与理解任务的发展。一种直接的技术路径是直接收集人类反馈,以构建用于模型优化的偏好数据集。尽管这种方法有效,但收集大规模的人类反馈既耗时又耗资源。为此,另一种流行的方法是从有限的偏好数据中学习奖励模型,并使用学习到的奖励函数根据视觉模型的输出来生成偏好数据。然后可以利用这些合成的偏好数据进行视觉模型的偏好对齐,从而显著减少对大量人工标注的需求。

简介

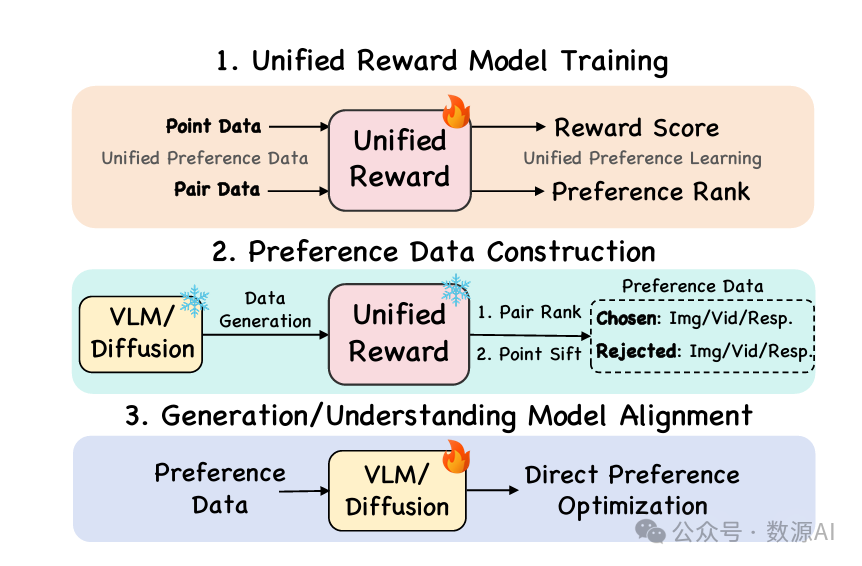

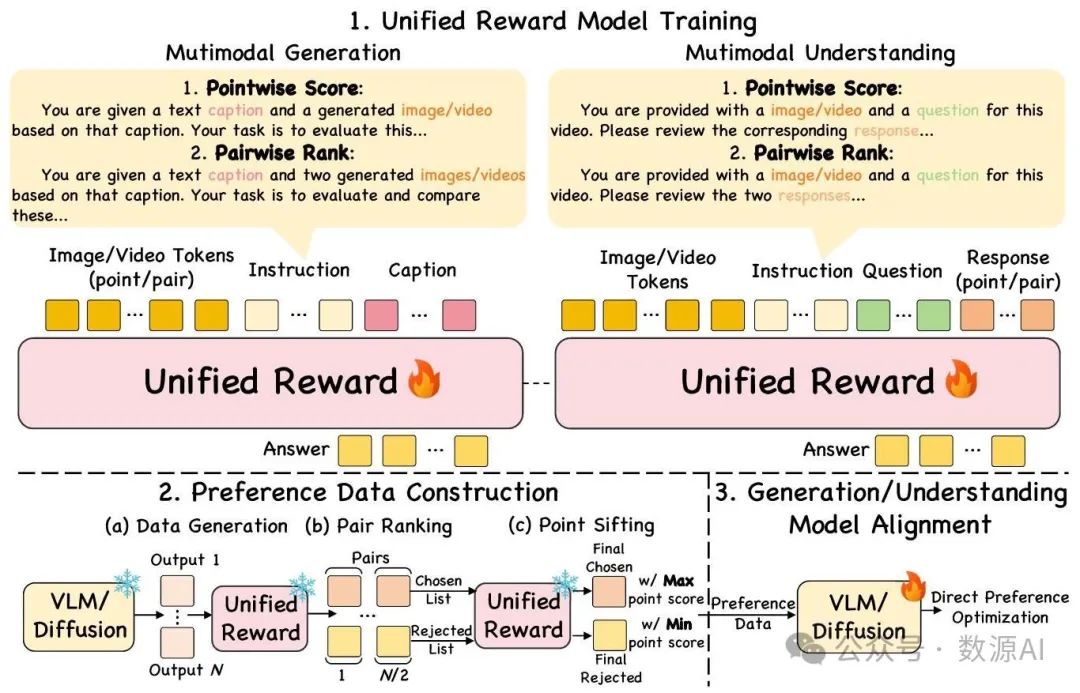

人类偏好对齐方面的最新进展显著提升了多模态生成与理解能力。一种关键方法是训练奖励模型以引导偏好优化。然而,现有模型通常针对特定任务,限制了它们在不同视觉应用中的适应性。我们还认为,联合学习评估多个任务可能会产生协同效应,即改进的图像理解能力可提升图像生成评估效果,而精细的图像评估则可通过更好的帧分析使视频评估受益。为此,本文提出了UNIFIEDREWARD,这是首个用于多模态理解和生成评估的统一奖励模型,支持成对排序和逐点评分,可用于视觉模型的偏好对齐。具体而言,(1)我们首先在构建的大规模人类偏好数据集上开发了UNIFIEDREWARD,该数据集涵盖图像和视频的生成/理解任务。(2)然后,利用该模型基于视觉模型自动构建高质量的偏好对数据,通过成对排序和得分筛选逐步精细过滤其输出。(3)最后,通过直接偏好优化(DPO)利用这些数据进行偏好对齐。实验结果表明,联合学习评估不同视觉任务可带来显著的互利效果,我们将该流程应用于图像和视频的理解/生成任务,显著提升了各领域的性能。

方法与模型

1. 概述

这项工作旨在为视觉模型偏好对齐提出一个统一的奖励模型。现有研究通常如表格1所示,为特定任务开发专门的奖励模型,这限制了它们在不同视觉应用中的适应性。此外,我们直观地认为,联合学习多个视觉任务可以产生相互强化的效果,但这仍是一个未被充分探索的领域。为此,这项工作提出了UNIFIEDREWARD,这是首个用于多模态理解和生成评估的统一奖励模型,支持成对排序和单点评分。然后,它被用于视觉 - 语言模型(Vision - Language Models,VLMs)和扩散模型的对齐,使不同视觉任务的偏好学习更加稳健和具有适应性。该流程如图2所示。

图2. 方法概述

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

189

189

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?