大佬Kayzaks在github上发表了一系列攻击神经网络的教程,地址在:

https://github.com/Kayzaks/HackingNeuralNetworks

这几天简单做了一下,有一定收获,不过在给出的9个例子中,GPU attack没有跑,不知道什么效果;还有几个代码是有问题的,修改后也跑不出效果。

不顾repo里的article.pdf中的介绍的东西还是比较精练有意义的,需要注意,这里的代码模型都是toy,只是便于理解掌握,实际情况没有这么简单。

1Attacking Weights and Biases

假设我们访问不到代码,但是有针对model.h5文件的访问权限。

H5文件有神经网络的全部信息(当然是用json也能存储神经网络,但是一般使用h5)

Keras使用模型文件来存储整个神经网络架构,包括所有权重和偏差。因此,我们可以通过仔细编辑来修改网络的行为。

比如对于基于神经网络的虹膜特征扫描仪来说,可能会对输入的虹膜图像进行二分类为access denied或者是access granted。

我们的目的就是修改HFD5文件来欺骗模型,可以对我们输入的任何图像进行错误的分类,比如都给予访问权限。

如果我们直接修改模型的输入输出可能会影响到相关代码,添加删除层也会导致一些奇怪的的结果,但是我们可以自由修改权重weight和偏差bias。

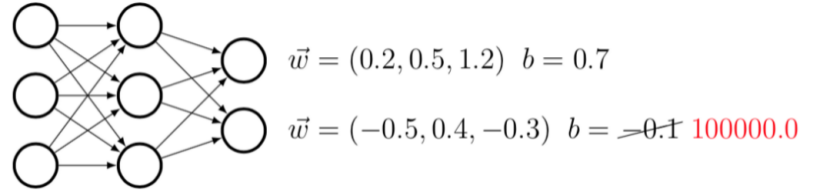

但是就目前学术界的研究来说,对于大部分层的weight,bias没有很好的理解和解释,但是我们可以直接修改最后一层。以下图为例

我们将最后一层中的一个神经元的bias修改的很大,这将覆盖前面那些weight*input的对模型最终的影响。也就是说,这么修改了以后,模型的输出更容易受到被修改的bias的影响。

通过使用如此高的值,我们几乎可以保证分类器将始终在该类的每个输入上贴错标签。 如果该类是我们的“access granted”,那么我们向它显示的任何输入(包括一些精制的假虹膜)都会通过判断。或者,我们也可以将最后一层的所有权重和偏差设置为0.0,而仅保持我们的目标神经元为1.0。

对于蓝军的启示:将模型文件作为数据库来对待,因为里面存储着敏感数据,注意权限控制,不要随意提供读写权限。可以考虑对其加密处理。即使这和安全无关,但也涉及到知识产权的保护。

2.backdooring neural network

上一种方法有个弊端就是会导致输入任何图片都会被access granted。这种异常行为很容易被发现。

我们希望模型可以对其他图片都维持正常的分类结果,只对我们指定的后门图像是误分类。

这里需要注意一下,选择后门时,建议不要选择完全不同的东西。将猫的图像用作虹膜扫描仪的后门可能会引起问题,因为大多数现代系统首先对输入进行健全性检查,以确保它确实是虹膜。

我们不需要重头开始训练,只需要在现有模型基础上继续训练即可

3.Extracting Information

我们可以从神经网络中提取与训练数据相似的信息。由于神经网络能够泛化并且主要针对稀疏数据进行训练,因此提取原始训练集的过程非

本文介绍了如何通过修改H5模型文件来操控神经网络,包括攻击模型权重与偏差、植入后门、信息提取、暴力破解、GPU漏洞利用等技巧。还探讨了如何利用神经网络进行文本翻译攻击和AV规避,以及供应链安全威胁。

本文介绍了如何通过修改H5模型文件来操控神经网络,包括攻击模型权重与偏差、植入后门、信息提取、暴力破解、GPU漏洞利用等技巧。还探讨了如何利用神经网络进行文本翻译攻击和AV规避,以及供应链安全威胁。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2753

2753

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?