0. 论文信息

标题:ProTracker: Probabilistic Integration for Robust and Accurate Point Tracking

作者:Tingyang Zhang, Chen Wang, Zhiyang Dou, Qingzhe Gao, Jiahui Lei, Baoquan Chen, Lingjie Liu

机构:宾夕法尼亚大学、北京大学、香港大学、山东大学

原文链接:https://arxiv.org/abs/2501.03220

代码链接:https://michaelszj.github.io/protracker

1. 导读

在本文中,我们提出了ProTracker,一种新的框架,用于对视频中的任意点进行鲁棒和精确的长期密集跟踪。我们的方法的关键思想是结合概率积分来改进来自光流和语义特征的多个预测,用于鲁棒的短期和长期跟踪。具体来说,我们以概率方式整合光流估计,通过最大化每个预测的可能性来产生平滑和精确的轨迹。为了有效地重新定位由于堵塞而消失和重新出现的挑战点,我们进一步将长期特征对应性结合到我们的流动预测中,用于连续轨迹生成。大量实验表明,ProTracker在无监督和自监督方法中取得了最先进的性能,甚至在几个基准测试中超过了监督方法。我们的代码和模型将在发布后公开。

2. 效果展示

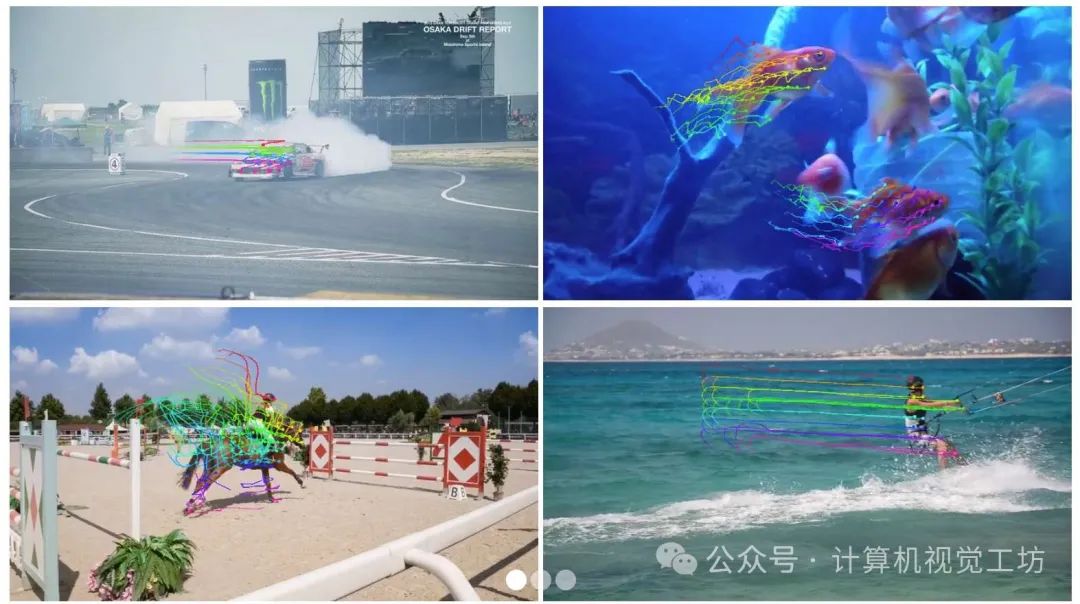

由ProTracker生成的稀疏轨迹。我们的方法鲁棒地生成精确和平滑的轨迹。

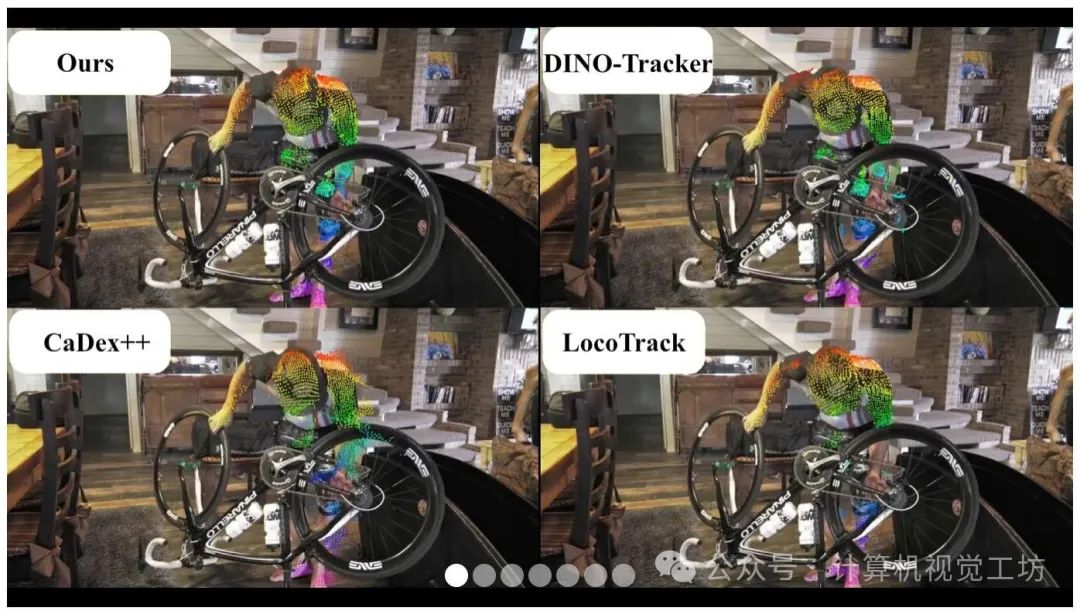

我们的方法能够捕捉更精细的细节,并恢复不太明显的点的完整轨迹。

虽然这些基于滑动窗口的跟踪器容易漂移并且容易被遮挡,但是我们的方法可靠地保持了对同一点的精确跟踪。

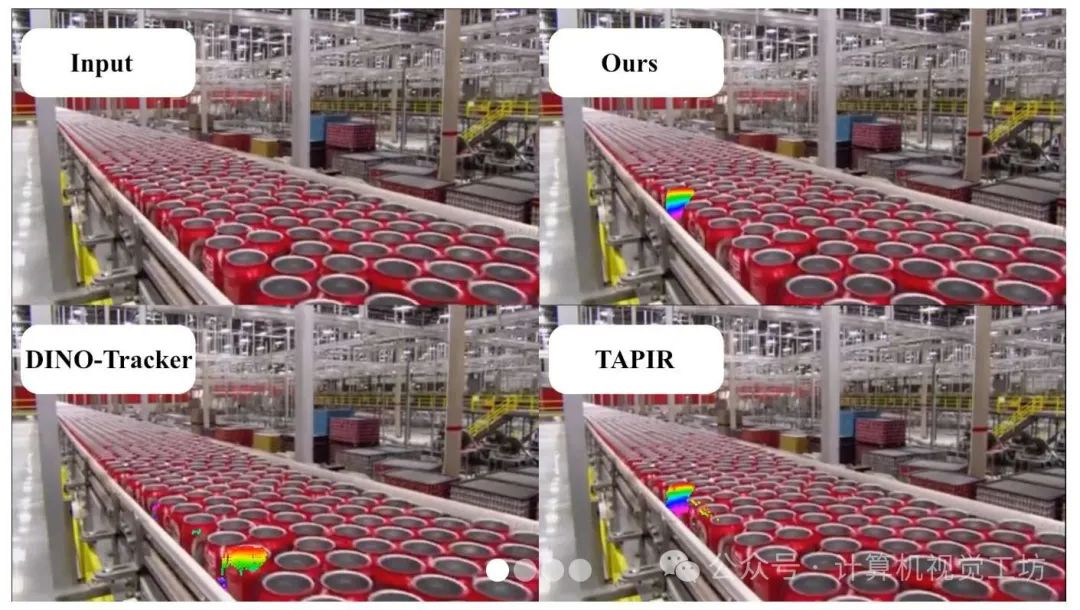

为了进一步说明我们的方法的鲁棒性,我们对来自网络的挑战性视频进行了实验。一些先前的方法依赖于计算查询点和目标帧之间的热图。然而,每帧热图缺乏时间意识,可能会混淆不同的对象。我们通过利用mask并将热图与光流相结合来解决这个问题。虽然我们的方法也依赖于每帧热图来提取关键点,但我们的方法具有很强的时间意识,能够区分相似的对象。

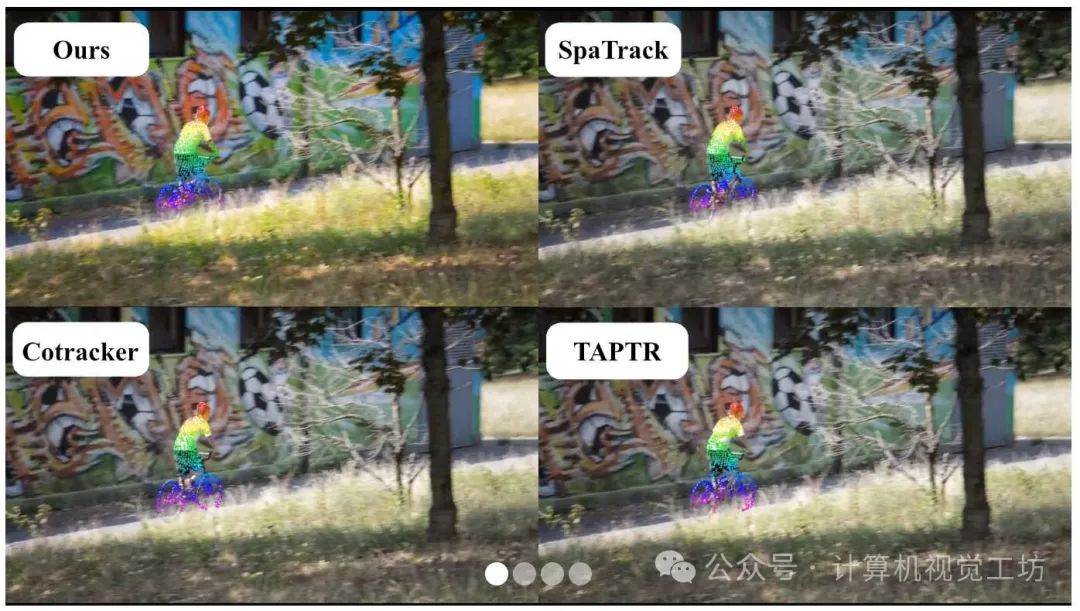

为了进一步证明我们方法的鲁棒性,我们在TAP-Vid-DAVIS的扩展视频上进行实验,通过重复每帧三次来模拟高帧率视频。与典型的滑动窗口或基于流量的跟踪器,这往往会随着时间累积误差和漂移,我们将长期关键点与短期光流相结合,实现了通过遮挡对同一点的连续、无漂移跟踪。实验在全分辨率下进行。

3. 方法

我们提出的方法的管道概述。(1)采样和链接:通过光流链接对关键点进行初始采样和链接,以产生初步的轨迹预测。(2)长期对应:关键点在更长的时间跨度内重新定位,以保持连续性,即使对于暂时消失的点也是如此。(3)双阶段滤波器:应用掩模和特征滤波器来去除不正确的预测,从而为后续步骤减少噪声。(4)概率整合:首先整合跨帧的经过滤的流量预测,然后与长期关键点组合以产生最终预测,从而产生更平滑和更一致的轨迹。

4. 实验结果

5. 总结 & 未来工作

在本文中,我们提出了一种稳健的跟踪框架,该框架通过概率整合将光流积分与长期对应关系相结合,从而在动态视频序列中实现精确且平滑的点跟踪。通过融入对象级过滤、双向概率整合以及几何感知特征提取,我们的方法有效缓解了漂移问题,处理了遮挡情况,并对暂时消失的点进行重新定位。在处理复杂运动和较长时间间隔方面,我们的方法优于传统方法,证明了整合短期和长期信息以实现可靠跟踪的优势。

尽管我们的方法提供了稳健的跟踪性能,但其对关键点提取过程中测试时训练的依赖降低了其相对于监督方法的效率——这是自监督跟踪方法的常见局限。这种对测试时训练的依赖源于当前特征提取器的分辨率不足以及缺乏时间感知能力。未来,高分辨率特征提取技术的改进有望避免测试时训练,并提高对象和区域之间的区分度,从而实现完全无监督和实时的密集跟踪。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

1134

1134

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?