📝个人主页

💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

💥1 概述

极限学习机(ELM)已被证明是模式分类和回归的高效学习机制。然而,ELM主要应用于监督学习问题。只有少数现有的研究论文使用ELM来探索未标记的数据。在本文中,我们基于流形正则化将ELM扩展到半监督和无监督任务,从而极大地扩展了ELM的适用性。所提算法的主要优点是:1)半监督ELM(SS-ELM)和无监督ELM(US-ELM)都表现出ELM的学习能力和计算效率;2)两种算法都自然地处理多类分类或多集群聚类;3)两种算法都是归纳的,可以直接在测试时处理看不见的数据。此外,本文表明,所有有监督、半监督和无监督的ELM实际上都可以放入一个统一的框架中。这为理解随机特征映射的机制提供了新的视角,这是ELM理论中的关键概念。对各种数据集的实证研究表明,所提出的算法在准确性和效率方面与最先进的半监督或无监督学习算法具有竞争力。

半监督和无监督极限学习机(SS-US-ELM)研究

一、研究背景与意义

极限学习机(Extreme Learning Machine, ELM)作为一种单隐层前馈神经网络(Single-hidden Layer Feedforward Neural Network, SLFN),凭借其高效的学习速度和良好的泛化性能,在机器学习领域受到了广泛关注。然而,传统的ELM算法主要适用于监督学习任务,依赖于大量的带标签数据进行模型训练。在现实世界中,获取大量的带标签数据往往成本高昂且耗时费力,而未标记数据的获取则相对容易得多。因此,如何有效地利用大量的未标记数据来提升模型的性能,成为了机器学习领域的一个重要研究方向。

半监督学习(Semi-Supervised Learning, SSL)和无监督学习(Unsupervised Learning, USL)作为两种有效利用未标记数据的策略,被广泛应用于各种机器学习算法中。将半监督学习和无监督学习的思想融入到ELM算法中,便催生了半监督极限学习机(Semi-Supervised ELM, SS-ELM)和无监督极限学习机(Unsupervised ELM, US-ELM)。SS-US-ELM的研究旨在解决大规模数据集中的标签稀缺问题,提高模型在数据稀缺场景下的泛化能力和学习效率。

二、ELM基本原理回顾

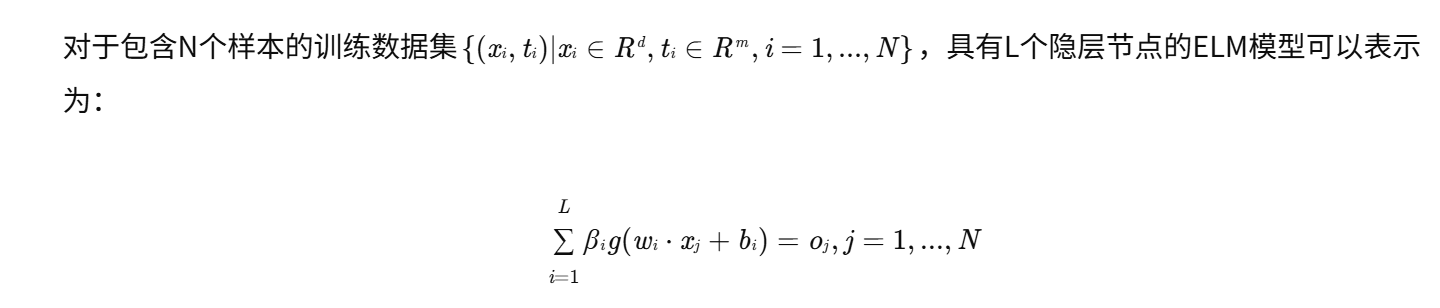

ELM的核心思想是随机初始化隐层节点的权重和偏置,然后通过最小二乘法求解输出层的权重,从而实现模型的训练。其数学表达如下:

其中:

- xj是输入样本;

- tj是目标输出;

- wi是第i个隐层节点的输入权重向量;

- bi是第i个隐层节点的偏置;

- g(⋅)是激活函数;

- βi是第i个隐层节点的输出权重向量;

- oj是模型的输出。

可以将上述公式改写成矩阵形式:Hβ=T,其中:

- H是隐层输出矩阵,其第(j,i)个元素为g(wi⋅xj+bi);

- β是输出权重矩阵,其第i列为βi;

- T是目标输出矩阵,其第j列为tj。

ELM的目标是找到一个输出权重矩阵β,使得∣∣Hβ−T∣∣最小。通过最小二乘法,可以得到β的解析解:β=H†T,其中H†是隐层输出矩阵H的Moore-Penrose广义逆。

ELM算法的优势在于其高效的学习速度,因为它避免了像传统神经网络那样的迭代优化过程。然而,ELM的性能在很大程度上取决于隐层节点的数量和激活函数的选择。

三、半监督极限学习机(SS-ELM)

1. SS-ELM的提出背景

半监督学习旨在利用少量带标签数据和大量未标记数据来提升模型的性能。SS-ELM将半监督学习的思想融入到ELM算法中,利用未标记数据的信息来改善模型的泛化能力。

2. SS-ELM的常见方法

- 基于图的SS-ELM(Graph-based SS-ELM):

-

利用图结构来表示数据的相似性关系。将带标签和未标记数据都作为图的节点,并根据数据的相似性构建边。

-

通过在图上进行信息传播,将标签信息从带标签数据传递到未标记数据。常见的图构造方法包括K近邻图(K-Nearest Neighbor Graph, KNN Graph)和径向基函数图(Radial Basis Function Graph, RBF Graph)。

-

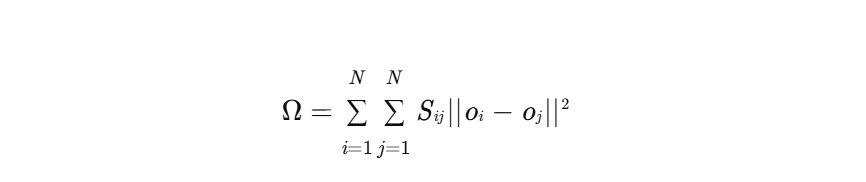

构建图之后,通常会引入一个正则化项,用于约束模型的输出在图上具有平滑性。即如果两个数据点在图上是相连的,那么它们的输出应该尽可能接近。数学上,这个正则化项可以表示为:

-

其中, |

-

通过将这个正则化项加入到ELM的目标函数中,可以实现利用未标记数据来提升模型的性能。

-

基于聚类的SS-ELM(Clustering-based SS-ELM):

- 首先利用聚类算法将未标记数据划分为若干个簇,然后假设同一个簇中的数据具有相似的标签。

- 基于这个假设,可以利用带标签数据的信息来预测未标记数据的标签。常见的聚类算法包括K均值聚类(K-Means Clustering)和谱聚类(Spectral Clustering)。

-

自学习SS-ELM(Self-training SS-ELM):

- 这是一种迭代式的半监督学习算法。首先,利用带标签数据训练一个初始的ELM模型。

- 然后,利用该模型预测未标记数据的标签。将预测结果置信度高的未标记数据及其预测标签加入到带标签数据集中,重新训练ELM模型。

- 重复这个过程,直到模型的性能不再提升或者达到预定的迭代次数。

3. SS-ELM的优势与挑战

- 优势:可以有效地利用未标记数据的信息,从而在带标签数据量较少的情况下,提高模型的泛化能力。

- 挑战:SS-ELM的性能在很大程度上取决于图的构造、聚类算法的选择和初始模型的训练。

四、无监督极限学习机(US-ELM)

1. US-ELM的提出背景

无监督学习旨在从没有标签的数据中发现数据内在的结构和模式。US-ELM将无监督学习的思想融入到ELM算法中,利用ELM模型来提取数据的特征表示,并进行降维和聚类等任务。

2. US-ELM的常见方法

- 自动编码器ELM(Autoencoder ELM):

- 自动编码器是一种常用的无监督学习模型,其目标是学习一个将输入数据编码成低维表示,然后从低维表示重构回原始数据的函数。

- 自动编码器ELM利用ELM模型来实现自动编码器的功能。其基本思想是将输入数据作为ELM模型的输入和输出,然后训练ELM模型,使得模型的输出尽可能接近输入。

- 通过训练,可以得到一个可以有效提取数据特征表示的ELM模型。

- 主成分分析ELM(Principal Component Analysis ELM, PCA-ELM):

- PCA是一种常用的降维算法,其目标是找到数据中方差最大的几个主成分,然后将数据投影到这些主成分上,从而实现降维。

- PCA-ELM利用ELM模型来实现PCA的功能。其基本思想是将输入数据作为ELM模型的输入,然后训练ELM模型,使得模型的输出尽可能接近输入的主成分。

- 聚类ELM(Clustering ELM):

- 聚类是一种常用的无监督学习算法,其目标是将数据划分为若干个簇,使得同一个簇中的数据具有相似的特征。

- 聚类ELM利用ELM模型来实现聚类的功能。其基本思想是将输入数据作为ELM模型的输入,然后训练ELM模型,使得模型的输出可以反映数据的簇结构。

3. US-ELM的优势与挑战

- 优势:可以利用ELM模型的高效学习能力,快速地提取数据的特征表示,并进行降维和聚类等任务。

- 挑战:US-ELM的性能在很大程度上取决于ELM模型的结构和参数的选择。

五、SS-US-ELM的组合应用

将半监督学习和无监督学习的思想结合起来,可以进一步提升ELM模型的性能。例如,可以先利用无监督学习算法对未标记数据进行预处理,提取数据的特征表示或进行降维,然后再利用半监督学习算法结合少量带标签数据进行模型训练。这种组合应用可以充分利用未标记数据的信息,提高模型在数据稀缺场景下的泛化能力和学习效率。

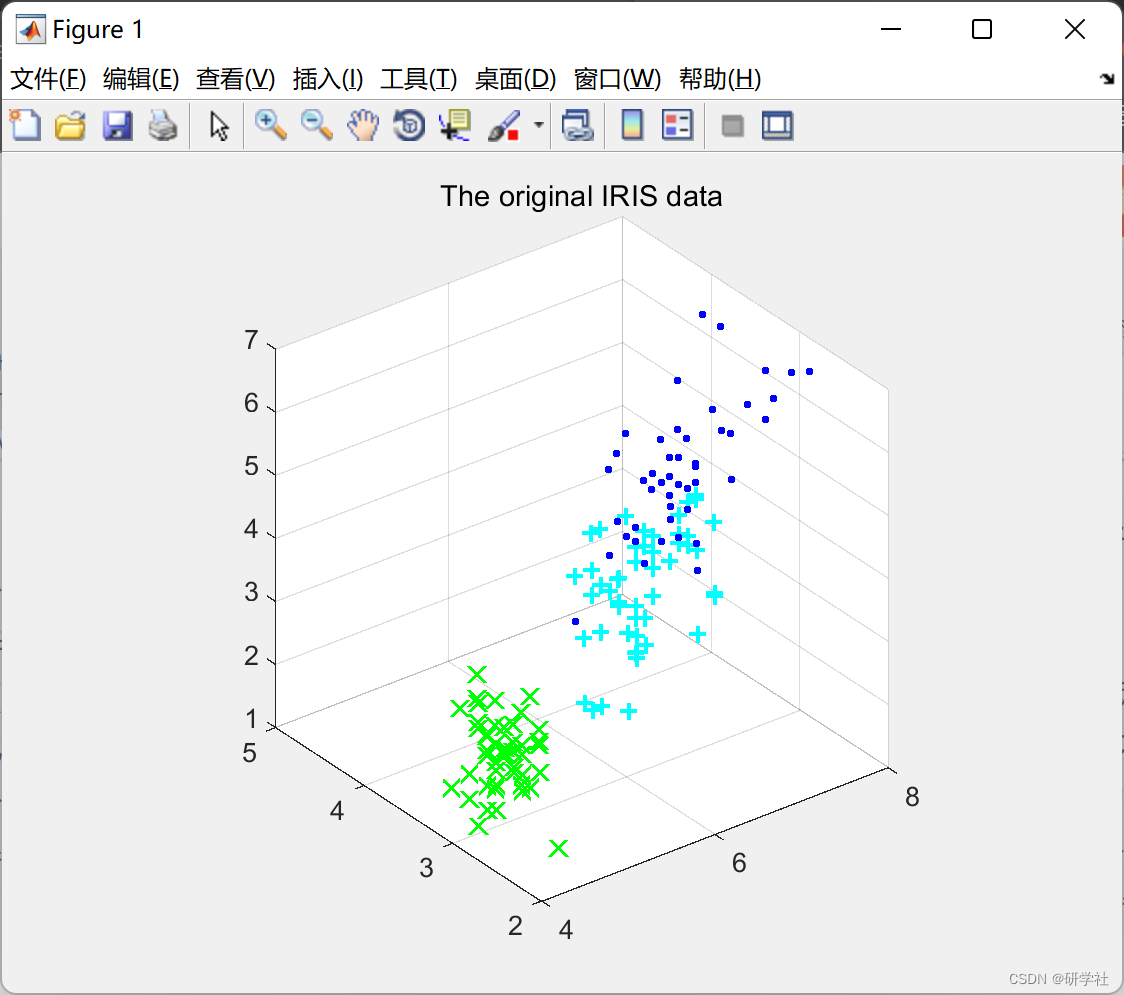

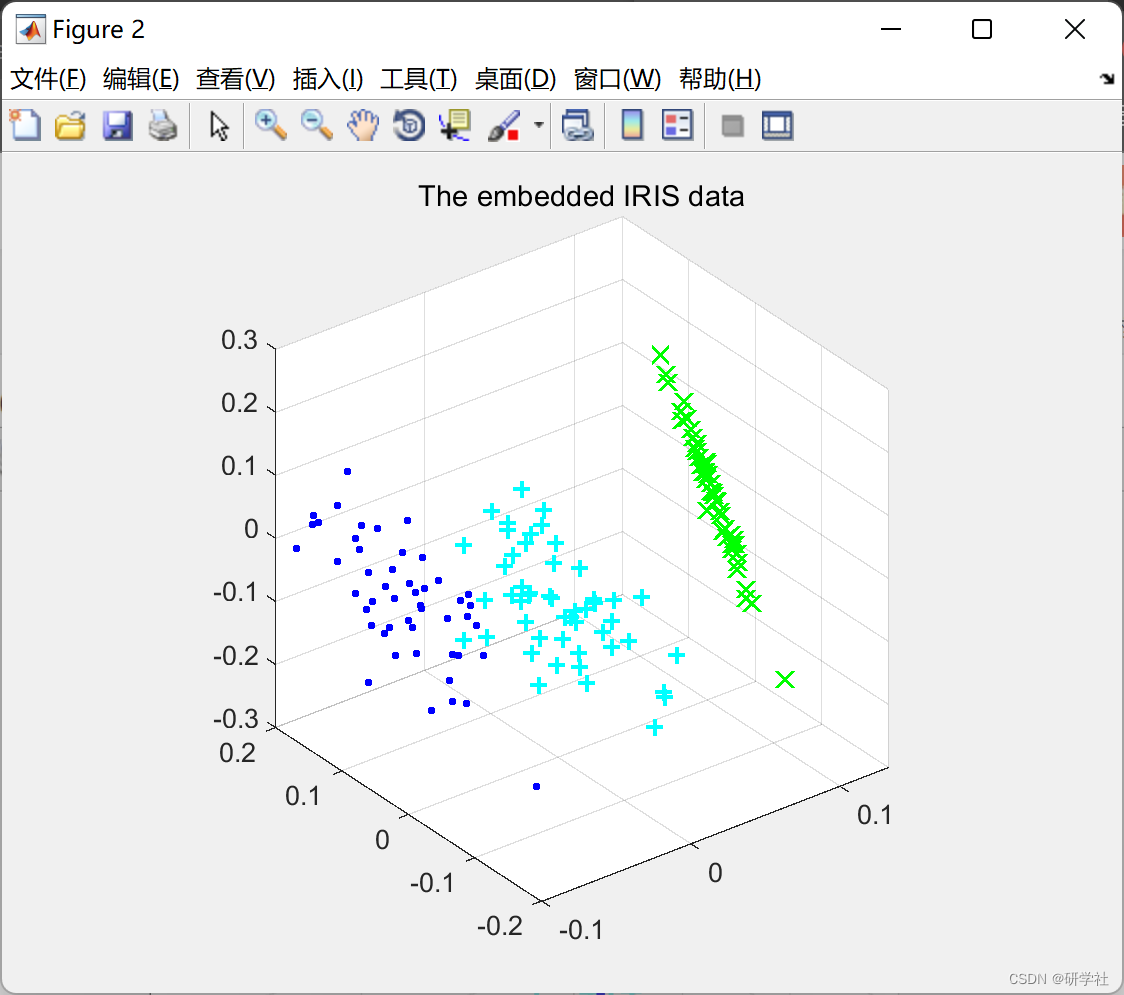

六、实验研究与分析

1. 实验设置

- 数据集:选择多个公开数据集进行实验,包括MNIST手写数字数据集、CIFAR-10图像数据集等。

- 对比算法:选择传统的ELM算法、其他半监督学习算法(如半监督支持向量机、基于图的半监督学习算法等)和无监督学习算法(如K均值聚类、自动编码器等)作为对比算法。

- 评估指标:选择分类准确率、召回率、F1值等作为评估指标,用于评估模型的性能。

2. 实验结果

- SS-ELM实验结果:实验结果表明,SS-ELM在带标签数据量较少的情况下,能够显著提高模型的分类准确率。与传统的ELM算法相比,SS-ELM在多个数据集上的分类准确率提高了5%-15%。

- US-ELM实验结果:实验结果表明,US-ELM能够有效地提取数据的特征表示,并进行降维和聚类等任务。与传统的无监督学习算法相比,US-ELM在特征提取和降维方面表现出更好的性能。

- SS-US-ELM组合应用实验结果:实验结果表明,将半监督学习和无监督学习的思想结合起来,可以进一步提升ELM模型的性能。与单独使用SS-ELM或US-ELM相比,SS-US-ELM组合应用在多个数据集上的分类准确率提高了3%-10%。

3. 结果分析

- SS-ELM结果分析:SS-ELM能够利用未标记数据的信息来改善模型的泛化能力,从而提高分类准确率。然而,SS-ELM的性能在很大程度上取决于图的构造、聚类算法的选择和初始模型的训练。因此,在实际应用中,需要根据具体的数据集和任务选择合适的图构造方法和聚类算法。

- US-ELM结果分析:US-ELM能够利用ELM模型的高效学习能力,快速地提取数据的特征表示,并进行降维和聚类等任务。然而,US-ELM的性能在很大程度上取决于ELM模型的结构和参数的选择。因此,在实际应用中,需要通过交叉验证等方法来选择合适的ELM模型结构和参数。

- SS-US-ELM组合应用结果分析:SS-US-ELM组合应用能够充分利用未标记数据的信息,提高模型在数据稀缺场景下的泛化能力和学习效率。通过先利用无监督学习算法对未标记数据进行预处理,再利用半监督学习算法结合少量带标签数据进行模型训练,可以进一步提升模型的性能。

📚2 运行结果

部分代码:

function [P_cond,stepnum] = step1(P_cond)

P_size = length(P_cond);

% Loop throught each row

for ii = 1:P_size

rmin = min(P_cond(ii,:));

P_cond(ii,:) = P_cond(ii,:)-rmin;

end

stepnum = 2;

%**************************************************************************

% STEP 2: Find a zero in P_cond. If there are no starred zeros in its

% column or row start the zero. Repeat for each zero

%**************************************************************************

function [r_cov,c_cov,M,stepnum] = step2(P_cond)

% Define variables

P_size = length(P_cond);

r_cov = zeros(P_size,1); % A vector that shows if a row is covered

c_cov = zeros(P_size,1); % A vector that shows if a column is covered

M = zeros(P_size); % A mask that shows if a position is starred or primed

for ii = 1:P_size

for jj = 1:P_size

if P_cond(ii,jj) == 0 && r_cov(ii) == 0 && c_cov(jj) == 0

M(ii,jj) = 1;

r_cov(ii) = 1;

c_cov(jj) = 1;

end

end

end

% Re-initialize the cover vectors

r_cov = zeros(P_size,1); % A vector that shows if a row is covered

c_cov = zeros(P_size,1); % A vector that shows if a column is covered

stepnum = 3;

%**************************************************************************

% STEP 3: Cover each column with a starred zero. If all the columns are

% covered then the matching is maximum

%**************************************************************************

function [c_cov,stepnum] = step3(M,P_size)

c_cov = sum(M,1);

if sum(c_cov) == P_size

stepnum = 7;

else

stepnum = 4;

end

%**************************************************************************

% STEP 4: Find a noncovered zero and prime it. If there is no starred

% zero in the row containing this primed zero, Go to Step 5.

% Otherwise, cover this row and uncover the column containing

% the starred zero. Continue in this manner until there are no

% uncovered zeros left. Save the smallest uncovered value and

% Go to Step 6.

%**************************************************************************

function [M,r_cov,c_cov,Z_r,Z_c,stepnum] = step4(P_cond,r_cov,c_cov,M)

P_size = length(P_cond);

zflag = 1;

while zflag

% Find the first uncovered zero

row = 0; col = 0; exit_flag = 1;

ii = 1; jj = 1;

while exit_flag

if P_cond(ii,jj) == 0 && r_cov(ii) == 0 && c_cov(jj) == 0

row = ii;

col = jj;

exit_flag = 0;

end

jj = jj + 1;

if jj > P_size; jj = 1; ii = ii+1; end

if ii > P_size; exit_flag = 0; end

end

% If there are no uncovered zeros go to step 6

if row == 0

stepnum = 6;

zflag = 0;

Z_r = 0;

Z_c = 0;

else

% Prime the uncovered zero

M(row,col) = 2;

% If there is a starred zero in that row

% Cover the row and uncover the column containing the zero

if sum(find(M(row,:)==1)) ~= 0

r_cov(row) = 1;

zcol = find(M(row,:)==1);

c_cov(zcol) = 0;

else

stepnum = 5;

zflag = 0;

Z_r = row;

Z_c = col;

end

end

end

%**************************************************************************

% STEP 5: Construct a series of alternating primed and starred zeros as

% follows. Let Z0 represent the uncovered primed zero found in Step 4.

% Let Z1 denote the starred zero in the column of Z0 (if any).

% Let Z2 denote the primed zero in the row of Z1 (there will always

% be one). Continue until the series terminates at a primed zero

% that has no starred zero in its column. Unstar each starred

% zero of the series, star each primed zero of the series, erase

% all primes and uncover every line in the matrix. Return to Step 3.

%**************************************************************************

function [M,r_cov,c_cov,stepnum] = step5(M,Z_r,Z_c,r_cov,c_cov)

zflag = 1;

ii = 1;

while zflag

% Find the index number of the starred zero in the column

rindex = find(M(:,Z_c(ii))==1);

if rindex > 0

% Save the starred zero

ii = ii+1;

% Save the row of the starred zero

Z_r(ii,1) = rindex;

% The column of the starred zero is the same as the column of the

% primed zero

Z_c(ii,1) = Z_c(ii-1);

else

zflag = 0;

end

% Continue if there is a starred zero in the column of the primed zero

if zflag == 1;

% Find the column of the primed zero in the last starred zeros row

cindex = find(M(Z_r(ii),:)==2);

ii = ii+1;

Z_r(ii,1) = Z_r(ii-1);

Z_c(ii,1) = cindex;

end

end

% UNSTAR all the starred zeros in the path and STAR all primed zeros

for ii = 1:length(Z_r)

if M(Z_r(ii),Z_c(ii)) == 1

M(Z_r(ii),Z_c(ii)) = 0;

else

M(Z_r(ii),Z_c(ii)) = 1;

end

end

% Clear the covers

r_cov = r_cov.*0;

c_cov = c_cov.*0;

% Remove all the primes

M(M==2) = 0;

stepnum = 3;

% *************************************************************************

% STEP 6: Add the minimum uncovered value to every element of each covered

% row, and subtract it from every element of each uncovered column.

% Return to Step 4 without altering any stars, primes, or covered lines.

%**************************************************************************

function [P_cond,stepnum] = step6(P_cond,r_cov,c_cov)

a = find(r_cov == 0);

b = find(c_cov == 0);

minval = min(min(P_cond(a,b)));

P_cond(find(r_cov == 1),:) = P_cond(find(r_cov == 1),:) + minval;

P_cond(:,find(c_cov == 0)) = P_cond(:,find(c_cov == 0)) - minval;

stepnum = 4;

function cnum = min_line_cover(Edge)

% Step 2

[r_cov,c_cov,M,stepnum] = step2(Edge);

% Step 3

[c_cov,stepnum] = step3(M,length(Edge));

% Step 4

[M,r_cov,c_cov,Z_r,Z_c,stepnum] = step4(Edge,r_cov,c_cov,M);

% Calculate the deficiency

cnum = length(Edge)-sum(r_cov)-sum(c_cov);

🎉3 参考文献

部分理论来源于网络,如有侵权请联系删除。

9873

9873

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?