简介:在Unity引擎中,VFX是创建交互式图形和游戏体验的关键领域,包括创建、管理及优化特效资源。本文将探讨Unity VFX Graph的使用,实现音频与视觉效果的结合,Kinect设备数据在VFX中的应用,以及如何利用颜色映射和位置映射来动态控制粒子效果。同时,还将介绍如何分析和优化VFX子文件,并使用Shader来创造定制的视觉效果,以及通过事件系统实现VFX与其他游戏对象的交互。

1. Unity VFX Graph使用

Unity VFX Graph是一个强大的视觉效果编辑器,它为开发者提供了一个可视化的节点系统来创建复杂的粒子效果。与传统的粒子系统相比,VFX Graph能够提供更高的灵活性和定制性,尤其是在实时渲染场景中,这为游戏和应用的视觉效果带来了革命性的提升。

1.1 VFX Graph的基本概念与优势

1.1.1 VFX Graph与传统粒子系统的对比

传统粒子系统通常以预设的模块和参数为主,相比之下,VFX Graph支持更为复杂和动态的视觉效果。VFX Graph通过节点间的连接来控制粒子的行为,使用户可以更加直观地看到每一个参数如何影响最终的视觉效果。

1.1.2 VFX Graph在实时渲染中的作用

实时渲染要求视觉效果既真实又流畅,VFX Graph通过节点化的设计让开发者能够快速迭代和测试,极大地缩短了开发时间。利用其强大的计算能力,VFX Graph能够在保持高帧率的同时渲染出高质量的粒子效果。

1.1.3 创建VFX Graph项目的基本步骤

创建一个VFX Graph项目首先需要在Unity中打开VFX Graph编辑器,并选择“Create New Graph”开始。接下来,可以添加所需的节点,如粒子发射器、模拟器、材质节点等,并将它们连接起来。通过调整各个节点的参数,开发者可以控制粒子的形状、生命周期、颜色和其他属性。

这一章节提供了VFX Graph的基础知识和优势,接下来我们将会深入探讨VFX Graph的核心组件及其应用。

2. 音频与视觉效果结合

音频与视觉效果的同步是多媒体应用中的重要部分,它们相互作用能够极大地增强用户的沉浸感和体验。在本章节,我们将深入探讨音频与视觉效果结合的理论基础以及实际实现技巧。

2.1 音频视觉同步的理论基础

音频与视觉效果同步要求对音频信号处理以及人类视觉感知有深刻的理解。音频信号处理涉及将声音的波形转换为可操控的数字信号,而同步则要求这些视觉效果能够以某种方式映射或响应音频信号的内容。

2.1.1 音频信号处理基础

音频信号处理是音频分析的核心,包括信号的采集、滤波、放大、压缩等一系列过程。处理后的音频信号能够更有效地用于视觉效果的触发和控制。

音频信号通常以数字化的方式存储和处理。模拟信号首先被转换为数字信号(采样和量化),随后通过数字信号处理器(DSP)进行各种算法处理。处理的目的是提取有助于视觉同步的特征,比如音高、节奏和声音的动态范围。

2.1.2 音频与视觉效果同步的必要性

在电影、游戏和交互式艺术作品中,音频与视觉效果的同步可以创造一种统一的感官体验。这种同步不仅限于简单的节奏对齐,还包括基于音频内容(如情感、主题或动作)的复杂同步。

同步强化了故事情节和用户情感,使得视觉元素更加吸引人。例如,音乐的高潮部分能够与视觉上的爆炸或快速移动的场景同步,从而产生更大的冲击力。

2.1.3 音频分析技术在VFX中的应用

在VFX中,音频分析技术可用于实时地从音频信号中提取关键信息,并将这些信息转化为视觉效果。音频分析技术通常包括以下内容:

- 频谱分析 :使用傅里叶变换分解音频信号,获取频率成分的信息。

- 声音强度 :测量音频信号的振幅或能量水平。

- 节奏追踪 :检测音乐的节拍和节奏模式。

通过这些分析结果,可以创建基于音频的视觉效果,例如根据音乐节奏点亮光效,或者根据声音强度改变场景中的颜色和动态。

2.2 实现音频与VFX的结合实践

为了实现音频与VFX的结合,我们需要使用音频分析工具以及在Unity中的VFX Graph来创建响应音频的视觉效果。

2.2.1 音频触发VFX的案例解析

一个典型的音频触发VFX案例是当音频中的某一频率达到一定阈值时,触发视觉效果的激活。这通常涉及到音频信号的频率分析。在Unity中,我们可以使用内置的音频源和音频监听器组件来捕捉音频数据,并使用脚本来分析音频信号并触发VFX。

using UnityEngine;

using UnityEngine.Audio;

using UnityEngine.VFX; // 引入VFX namespace

public class AudioToVFX : MonoBehaviour

{

public AudioSource audioSource; // 音频源

public VisualEffect vfx; // VFX实例

public float threshold = 0.5f; // 频率阈值

void Update()

{

if (audioSource != null && vfx != null)

{

float frequencyData = AnalyzeFrequency(audioSource); // 分析音频频率

if (frequencyData > threshold)

{

vfx.SendEvent("TriggerVFX"); // 触发VFX事件

}

}

}

float AnalyzeFrequency(AudioSource source)

{

// 使用AudioSource的方法来分析频率

// 例如使用FFT(快速傅里叶变换)来获取频率数据

// 返回高于阈值的频率数据

}

}

2.2.2 音频频率响应与视觉效果的映射

在VFX Graph中,音频信号的频率响应可以用来控制粒子系统的参数。例如,低频段可能对应粒子的大小,而高频段可能控制粒子的颜色变化。

在Unity的VFX Graph中,我们可以创建一个自定义的Property来接收音频频率数据,并将其映射到粒子系统的相应参数中。这种映射可以是线性的,也可以是更复杂的函数关系。

2.2.3 实时音频分析与VFX生成

为了实时分析音频数据并生成VFX,我们可以结合Unity中的音频监听器组件和VFX Graph。音频监听器组件负责监听和分析音频数据,而VFX Graph负责根据分析结果生成相应的视觉效果。

音频分析可以在脚本中进行,也可以使用第三方音频分析插件。一旦音频分析完成,结果会被传递到VFX Graph中,用于调整粒子系统的各个属性。

graph LR

A[音频源] --> B[音频分析]

B --> C[结果传递]

C --> D[VFX Graph]

D --> E[视觉效果生成]

通过以上流程,我们可以创建出实时与音频同步的视觉效果,不仅丰富了场景的表现力,也提高了用户的沉浸感。下一章节我们将继续探讨Kinect设备在VFX中的应用。

3. Kinect设备在VFX中的应用

3.1 Kinect设备的技术介绍

随着体感技术的迅速发展,Kinect设备为交互式视觉效果带来了革命性的变化。本节深入探讨Kinect的工作原理及其在VFX(视觉特效)中的应用。

3.1.1 Kinect的传感器原理

Kinect是微软公司开发的一种深度感测器和动作捕捉设备。它集成有多种传感器,包括一个常规摄像头、红外发射器和红外摄像头。红外摄像头能够检测由红外发射器发出的信号,并通过飞行时间(ToF)技术计算出距离信息。这个距离信息能够构建出3D深度图像,即所谓的深度图,用以感知人体的动作和姿态。

3.1.2 Kinect SDK与Unity的集成

Kinect传感器数据可以通过Kinect for Windows SDK与Unity进行集成。SDK提供了大量的接口来访问深度数据、颜色数据、骨骼追踪等信息。开发者可以使用这些接口,通过C#脚本编程,将Kinect的输入转化为Unity中的交互式VFX。

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

using Windows.Kinect; // 必须导入Kinect for Windows的命名空间

public class KinectManager : MonoBehaviour

{

KinectSensor sensor;

BodyFrameReader bodyFrameReader;

Body[] bodies;

void Start()

{

sensor = KinectSensor.GetDefault();

if (sensor != null)

{

bodyFrameReader = sensor.BodyFrameSource.OpenReader();

if (!sensor.IsOpen)

{

sensor.Open();

}

}

}

void Update()

{

if (bodyFrameReader != null)

{

var frame = bodyFrameReader.AcquireLatestFrame();

if (frame != null)

{

if (bodies == null)

{

bodies = new Body[sensor.BodyFrameSource.BodyCount];

}

frame.GetAndRefreshBodyData(bodies);

frame.Dispose();

frame = null;

}

}

}

void OnApplicationQuit()

{

if (sensor != null)

{

if (sensor.IsOpen)

{

sensor.Close();

}

sensor = null;

}

}

}

该脚本启动了Kinect传感器,持续读取人体骨架数据,并将其存储在 bodies 数组中供后续处理。

3.1.3 Kinect数据流在VFX中的运用

Kinect捕获的数据可以转化为多种类型的VFX。例如,实时追踪用户动作来驱动粒子效果的产生,或者用作游戏中的角色动画输入。通过编程,在Unity中可以实时分析深度数据和骨骼信息,并将其映射为VFX参数,从而创造出自然的交互体验。

3.2 利用Kinect捕捉与VFX交互

通过将Kinect捕捉到的数据用于驱动VFX,我们可以构建出创新的交互式视觉体验。本节将介绍如何使用这些数据来创造动态VFX。

3.2.1 体感捕捉数据驱动VFX的实例

假设我们要创造一种互动效果,使得用户的移动能够在屏幕上形成颜色渐变的波纹效果。首先需要捕捉用户的位置信息,然后根据这些信息动态生成波纹。以下是一个简化的逻辑示例:

using UnityEngine;

using System.Collections.Generic;

public class WaveEffect : MonoBehaviour

{

public KinectManager kinectManager;

public GameObject wavePrefab;

public int maxWaves = 100;

private List<GameObject> waves = new List<GameObject>();

void Start()

{

// 监听KinectManager的人体数据更新事件

kinectManager.OnBodyFrameUpdate += UpdateBodyPosition;

}

void UpdateBodyPosition(Body body)

{

if (waves.Count >= maxWaves) return;

// 获取Kinect提供的用户关节位置

var joints = body.Joints;

var spineBasePosition = joints[JointType.SpineBase].Position;

// 在用户位置生成新的波纹效果

GameObject newWave = Instantiate(wavePrefab, spineBasePosition.ToUnityVector3(), Quaternion.identity);

waves.Add(newWave);

}

}

该脚本每隔一定时间从KinectManager获取用户的位置数据,并在相应位置实例化一个新的波纹效果。

3.2.2 实时体感捕捉下的动态VFX创造

进一步地,为了创建一个更加动态的VFX,我们需要考虑Kinect捕捉数据的时间序列。我们可以通过记录一系列的用户动作,然后让VFX根据这些动作动态变化。例如,在一个舞蹈游戏里,每个舞步的完成都会触发一系列由音效和颜色构成的视觉效果。

3.2.3 体感数据与视觉效果的同步优化

为了确保VFX与体感捕捉数据之间的同步,我们可以进行性能分析,找到潜在的瓶颈并进行优化。这包括减少对Kinect数据的读取频率,以及优化VFX实例的生成和销毁逻辑。

体感数据与视觉效果同步的优化策略表

| 优化策略 | 说明 |

|---|---|

| 减少读取频率 | 通过降低数据采集的频率来减少CPU负载。 |

| 缓存数据 | 利用缓冲区来临时存储数据,避免实时读取的开销。 |

| 异步处理 | 在后台线程处理VFX的生成逻辑,减少对主线程的影响。 |

| 对象池技术 | 重用已经创建的VFX对象,而不是每次都需要销毁和重建。 |

通过将这些策略组合应用,可以显著提升体感捕捉与VFX结合时的交互性能和体验。

4. 颜色和位置映射技术

4.1 颜色映射技术在VFX中的应用

4.1.1 颜色空间与颜色映射基础

颜色映射技术是视觉效果设计中的核心技术之一,其涉及的颜色空间理论是其基础。颜色空间可以理解为在特定的系统中描述颜色的方式,有如RGB、CMYK、HSV等不同类型。在VFX中,我们主要用到RGB颜色空间,因为它在计算机图形中应用广泛。

在RGB空间中,任何颜色都可以通过红(Red)、绿(Green)、蓝(Blue)三个基本色彩的不同强度组合来表示。颜色映射技术就是将一种颜色空间的色彩映射到另一种颜色空间的色彩。例如,将RGB空间的颜色映射到HSV空间中,可以在视觉上产生不同的效果。

4.1.2 实现颜色转换的Shader编写技巧

在Unity中使用Shader来实现颜色映射是一个常见的技术手段。Shader语言通常用于编写渲染管线中的顶点和片段程序,它们控制着颜色的最终输出。以下是一个简单的Shader代码示例,用于颜色空间之间的转换:

Shader "Custom/ColorMapping"

{

Properties

{

_MainTex("Texture", 2D) = "white" {}

_Saturation("Saturation", Float) = 1.0

}

SubShader

{

// ...省略部分代码,设置渲染通道等...

Pass

{

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

#include "UnityCG.cginc"

struct appdata

{

float4 vertex : POSITION;

float2 uv : TEXCOORD0;

};

struct v2f

{

float2 uv : TEXCOORD0;

float4 vertex : SV_POSITION;

};

sampler2D _MainTex;

float _Saturation;

v2f vert (appdata v)

{

v2f o;

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = v.uv;

return o;

}

float4 frag (v2f i) : SV_Target

{

float4 color = tex2D(_MainTex, i.uv);

// RGB到HSV转换

float4 hsvColor = RGBtoHSV(color.rgb);

// 调整饱和度

hsvColor.g *= _Saturation;

// HSV转回RGB

color.rgb = HSVtoRGB(hsvColor.rgb);

return color;

}

ENDCG

}

}

}

在上述代码中,我们使用了UnityCG.cginc中的函数以及自定义的RGBtoHSV和HSVtoRGB函数来进行颜色的转换。在fragment阶段,我们通过片段着色器对每个像素的颜色值进行了处理。

4.1.3 颜色映射在视觉效果中的创新应用

颜色映射不仅限于改变视觉效果的色彩表现,还能够用于增强特定视觉元素的识别度,或者创造特定的视觉氛围。例如,通过颜色映射,开发者可以将真实世界的色彩映射到虚拟世界中,或者模拟某种特定的光照条件和天气效果。

在VFX的实际应用中,颜色映射技术可以被用来制作动态的色彩变化效果,如日落、极光等。还可以通过对不同色彩空间的深入理解,开发出具有艺术风格的视觉效果,比如赛博朋克风格的霓虹色彩映射。

颜色映射技术的创新应用不仅仅体现在色彩变化上,还体现在如何将它与视觉叙事相结合,创造出具有深度和情感的视觉体验。在游戏和电影的VFX制作中,颜色映射技术的巧妙应用能极大地提升作品的艺术表现力和观众的情感共鸣。

4.2 位置映射在VFX中的作用

4.2.1 3D空间中的位置映射原理

位置映射技术是指在3D空间中根据特定的规则来决定粒子系统中粒子的位置。在Unity VFX Graph中,位置映射通常依赖于粒子发射器的设置以及与之相关联的模拟器节点。

在3D空间中,位置映射的原理是将每个粒子的3D坐标与世界坐标系或者某个局部坐标系对齐。例如,如果我们将粒子发射器放置在摄像机视点位置,那么发射出的粒子将基于摄像机的位置和方向进行空间位置映射。

位置映射的关键在于对粒子发射位置的控制,以及对粒子随时间变化的行为模拟。这种控制可以通过多种方式实现,如使用噪声函数、向量场、碰撞器等。

4.2.2 利用脚本实现位置映射的策略

在Unity中,脚本编程是实现动态位置映射的重要方式。通过编写C#脚本,我们可以获取实时输入,如用户输入或者设备输入,并将这些输入用于粒子系统的动态控制。

以下是一个C#脚本示例,它展示了如何根据摄像机位置动态更新粒子发射器的位置:

using UnityEngine;

using UnityEngine.VFX;

public class PositionMapper : MonoBehaviour

{

public VisualEffect vfx;

public Camera mainCamera;

void Update()

{

if(mainCamera != null && vfx != null)

{

// 将粒子系统位置设置为摄像机位置

vfx.transform.position = mainCamera.transform.position;

}

}

}

在这个简单的脚本中,我们把粒子系统的当前位置设置为摄像机的位置,这使得粒子效果总是基于摄像机视角生成。

4.2.3 高级位置映射技术的VFX效果实现

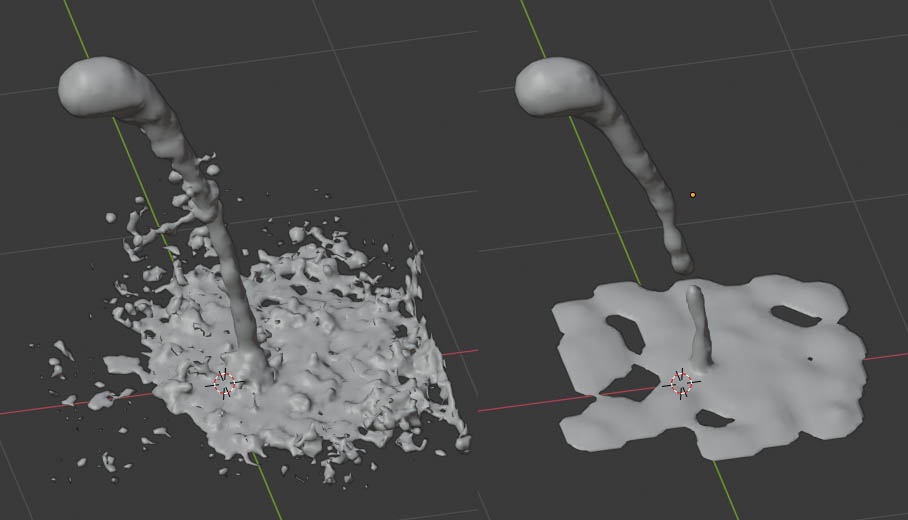

在VFX中,高级位置映射技术可以用来创建更加复杂和逼真的效果,如流体动力学模拟、重力场模拟以及各种自然界现象的模拟。

例如,通过使用自定义的噪声函数和力场模拟器节点,我们可以创建出如水流、火焰等动态效果。这样的高级位置映射技术不仅需要对VFX Graph节点的深入理解,还需要一定的物理和数学知识。

在实现高级位置映射时,VFX开发者通常利用现有的粒子系统和物理模拟器,结合脚本编程来扩展系统的功能。比如,通过脚本控制粒子系统的发射器和模拟器参数,可以实现更加复杂的粒子动态和交互。

通过这种技术的综合运用,开发者能够创造出仿佛拥有自己生命力的VFX效果,极大地提升视觉体验的真实感和沉浸感。例如,在游戏《死亡搁浅》中,为了模拟各种自然现象和环境影响,就使用了复杂的粒子系统和位置映射技术。

5. VFX性能优化方法

5.1 VFX性能瓶颈分析

在游戏和实时交互应用中,VFX(视觉效果)的性能优化至关重要。一个优秀的VFX设计,不仅能提升视觉吸引力,还应确保不会对游戏性能造成负面影响。

5.1.1 VFX资源使用效率的评估

资源使用效率通常与场景中VFX实例的数量和复杂度有关。开发者需要评估VFX占用的计算资源、内存带宽和显存。这些可以通过Unity编辑器中的Profiler工具进行分析,具体操作如下:

// 示例代码:使用Profiler来记录VFX资源消耗情况

void Start()

{

Profiler.BeginSample("VFXResourceUsage");

// 在这里添加激活和修改VFX的代码

Profiler.EndSample();

}

上述代码块通过Profiler的BeginSample和EndSample方法定义了一个性能分析的区间,这样可以在Profiler窗口中观察到该区间内的资源使用情况。

5.1.2 常见性能问题及其影响

在VFX的实现中,常见的性能问题包括但不限于过度的粒子数量、复杂的着色器运算、以及不合理的渲染流程。这些问题会导致帧率下降,影响玩家的体验。

5.1.3 面向性能的VFX设计原则

为确保VFX设计的性能,应遵循以下原则:

- 最小化不必要的粒子 : 只有当必需时才使用粒子效果,并在效果完成后适时销毁粒子系统。

- 使用高效的着色器 : 优化着色器代码,减少不必要的计算,如避免高精度数值运算。

- 层级细节(Lod)技术 : 在视距较远时使用较少细节的VFX,视距近时再展现高细节效果。

5.2 VFX性能优化的实践技巧

5.2.1 减少VFX资源占用的方法

为了减少VFX资源占用,我们可以采取以下措施:

- 预计算 : 对于那些不需要实时计算的效果,可以考虑预计算并存储为纹理。

- 空间和时间的采样 : 通过降低粒子发射频率和使用LOD技术减少视觉上的信息量,可以减少每个帧中需要渲染的粒子数。

下面的代码展示了如何在Unity中根据摄像机距离调整粒子发射率:

void Update()

{

float distance = Vector3.Distance(transform.position, Camera.main.transform.position);

float emissionRate = Mathf.Lerp(emissionHighRate, emissionLowRate, distance / maxDistance);

particleSystem.emissionRate = emissionRate;

}

5.2.2 多级细节技术在VFX中的运用

多级细节技术(LOD)是确保VFX性能的有效方法之一。根据对象距离视点的距离,可以切换不同复杂度的VFX表现。下面表格展示了不同距离下LOD的应用:

| 距离范围 | LOD级别 | 表现特征 |

|---|---|---|

| 0 - 10米 | LOD1 | 高细节,高粒子数 |

| 10 - 50米 | LOD2 | 中等细节,中等粒子数 |

| 50米以上 | LOD3 | 低细节,低粒子数,静态效果 |

5.2.3 优化工具与反馈循环的建立

最后,开发团队需要建立一个性能优化的反馈循环。这通常包括:

- 性能测试 : 定期对游戏进行性能测试,检测VFX对整体性能的影响。

- 性能优化 : 根据测试结果对VFX进行优化。

- 用户反馈 : 收集用户在不同硬件上体验游戏的反馈,进一步优化VFX表现。

在Unity中,可以通过引入第三方性能分析工具来辅助优化,如PGF(Performance Gauges Framework)或Intel GPA。

通过上述章节的分析与讨论,我们可以了解到在Unity中优化VFX性能的一些核心策略与实践方法,从理论到实际操作都有所涉及,为开发者在实现高效VFX表现提供了参考。

简介:在Unity引擎中,VFX是创建交互式图形和游戏体验的关键领域,包括创建、管理及优化特效资源。本文将探讨Unity VFX Graph的使用,实现音频与视觉效果的结合,Kinect设备数据在VFX中的应用,以及如何利用颜色映射和位置映射来动态控制粒子效果。同时,还将介绍如何分析和优化VFX子文件,并使用Shader来创造定制的视觉效果,以及通过事件系统实现VFX与其他游戏对象的交互。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?