GS-Occ3D

GS-Occ3D: Scaling Vision-only Occupancy Reconstruction with Gaussian Splatting

Abstract

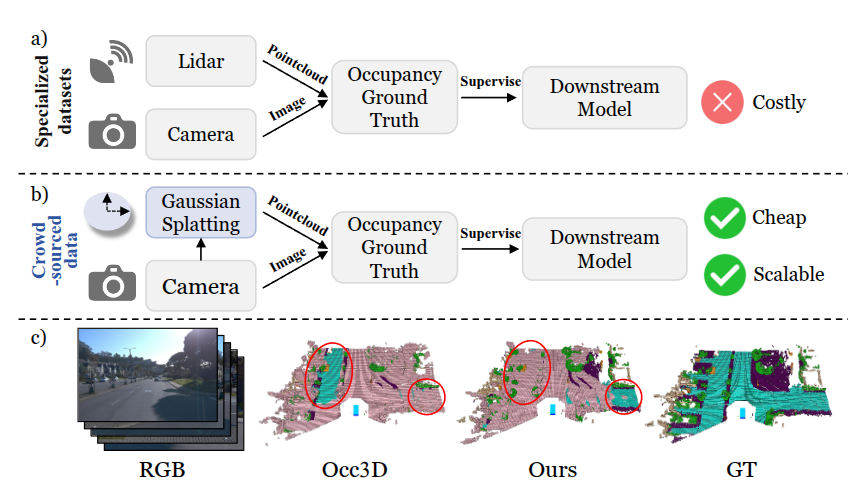

现阶段的OCC数据集主要基于点云生成标签,本文旨在利用纯图像生成OCC数据集,但现有的纯图像生成方案多使用mesh重建的方法,受几何完整性和后处理的影响很大,为了解决这个问题,本文提出一种基于吧茶树形式的高斯曲面模型的方法,实现高效的3D空间表征。此外,对于场景的细化处理与其他方案类似,地面主要通过重建方法得到大面积统一稳定的结果;动态目标则依据其运动状态进行捕捉和时序聚合处理。

Introduction

Goal: 纯视觉重建

Limitations of prior methods:

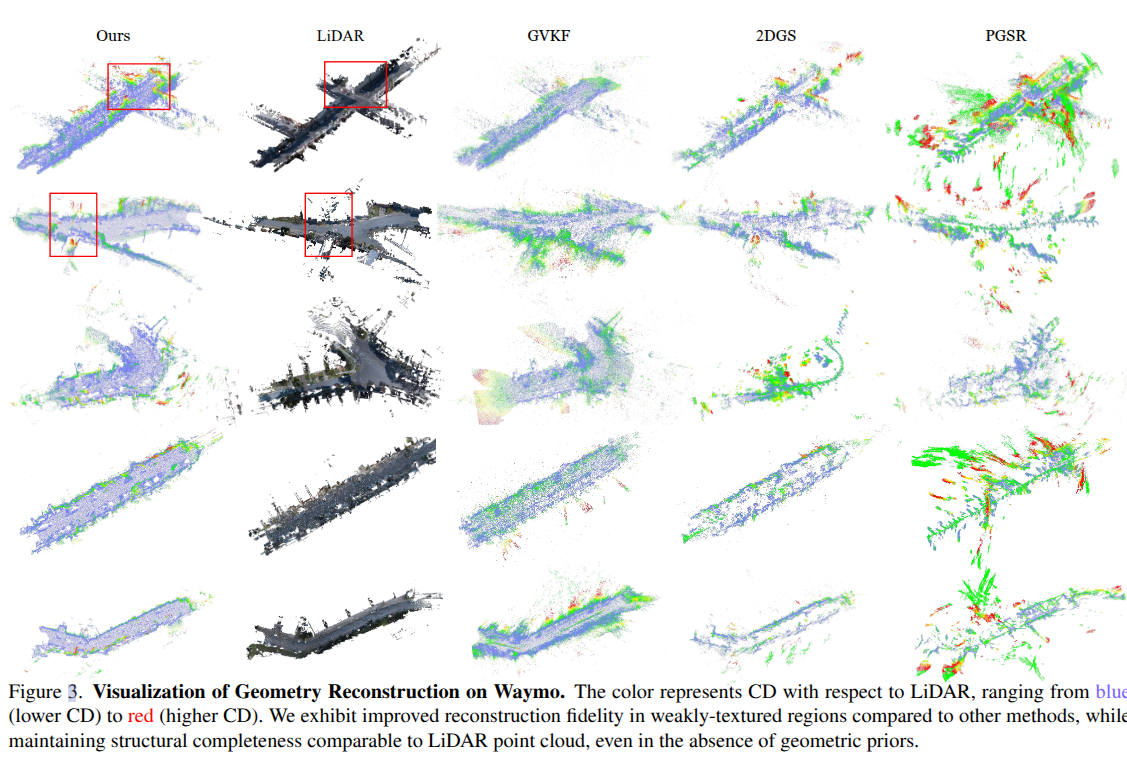

- 大多集中在单个物体或室内场景和简单的室外场景,但扩展到广泛的自动驾驶场景中就不work了,特别是纹理较弱,长视距高速行驶的场景;

- 现有的方法多依赖mesh方法,从而引入了其方法的弊端: 过于光滑化的处理、碎片化的出现、空洞的重构等,从而带来了额外的后处理工作;

- 大多集中在静态场景重建,动态场景不work;

Related Works

Methods

-

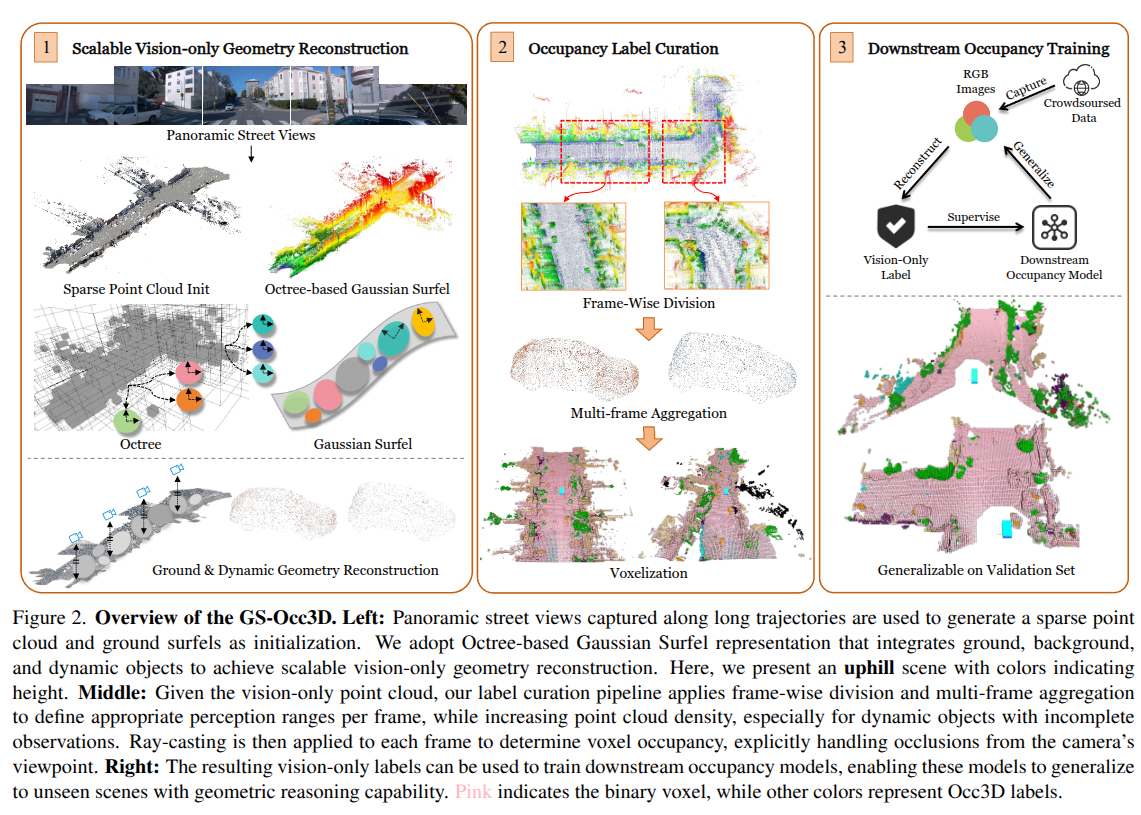

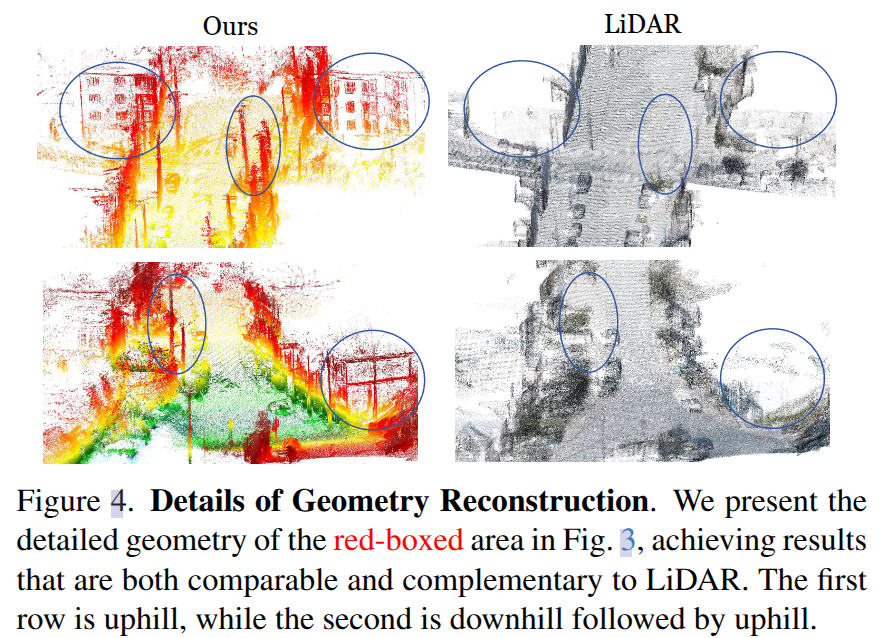

Scalable Vision-only Geometry Reconstruction

-

先使用SfM和地面高斯来生成稀疏点云作为初始的场景表示,并使用了分割模型进行一些必要的解耦。

-

为了弥补几何先验的稀疏性问题,本文采用了基于八叉树的高斯表面元素,使用初始的点云作为场景骨架,以最大化利用来自与处理阶段的几何信息。这种结构在训练期间实现了分层空间划分和灵活的调整,确保了高效、准确和可扩展的几何重建。动态八叉树结构在训练过程中自适应,根据场景密度和复杂性进行扩展或收缩。每个稀疏体素可以生成多达m个高斯基元,限制在以体素为中心的小区域内。体素分辨率适应不同的八叉树级别。粗层次的特点是空间密度较低,有效地建模墙壁和道路等全局结构,而细层则捕捉植被、建筑物和物体边界等高频细节。八叉树级别K的数量由观察到的摄像机中心和输入稀疏点云之间的距离分布决定。计算如下:

K=⌊log2(dmaxdmin)⌉+1K= \lfloor \log_2(\frac{d_{max}}{d_{min}})\rceil + 1 K=⌊log2(dmindmax)⌉+1

其中,dmaxd_{max}dmax和dmind_{min}dmin为观察到的摄像机中心到输入稀疏点云的最长和最短距离。 -

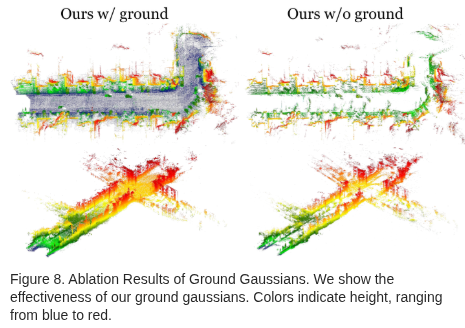

地面重建:假定地面与相机平行,通过xy平面投影来初始化地面的高斯表面元素。为了处理高程,使用最近的相机pose对局部地面进行拟合。再利用平面正则化进行平滑处理。

-

动态目标重建:引入OD结果,利用运动状态进行捕捉和时序聚合处理,其中为了减轻初始姿势中的噪声,增加一个可学习的offset参数:

Rt′=Rt+ΔRt,tti=tt+ΔttR_t^{'} = R_t + \Delta R_t , t_t^{i} = t_t + \Delta t_tRt′=Rt+ΔRt,tti=tt+Δtt -

最终的损失函数可以描述为:

L=Lrgb+λgeoLgeo+λobjLobj+λroadLroad+λskyLskyL = L_{rgb} + \lambda_{geo}L_{geo} +\lambda_{obj}L_{obj} + \lambda_{road}L_{road}+ \lambda_{sky}L_{sky} L=Lrgb+λgeoLgeo+λobjLobj+λroadLroad+λskyLsky

Lgeo=λsLs+λdLd+λnLn L_{geo} = \lambda_s L_s + \lambda_d L_d + \lambda_n L_n Lgeo=λsLs+λdLd+λnLn

分别为表面点正则化、深度失真和深度法线一致性

-

-

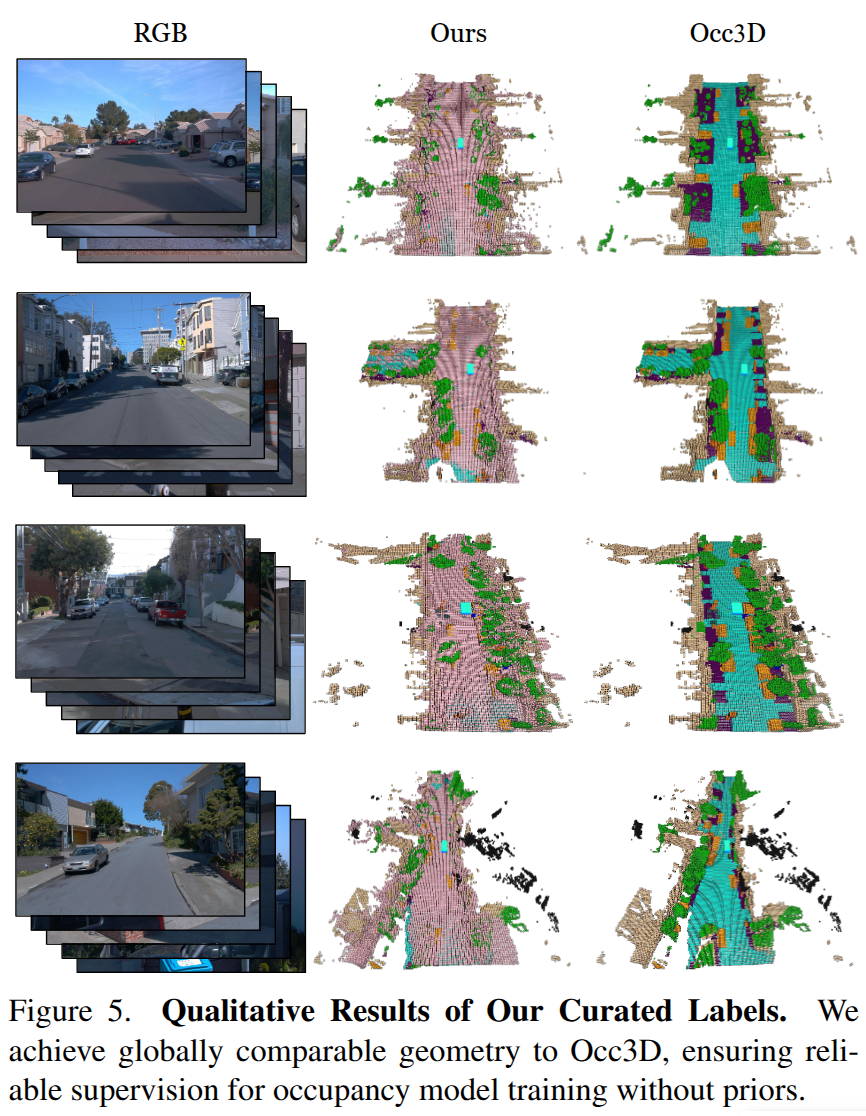

Occupancy Labels Curation

为了解决点云稀疏性和相机遮挡的问题,本文采用了以帧为单元,以及帧聚合的方法来定义纯视觉点云的感知范围,并增加点云密度,尤其是对于观测不完整的动态目标。采用射线传播的方式来解决遮挡问题。

- 以帧为单元划分:与扫描点云不同的是,重建点云不存在对应的传感器来源,因此本文定义了一个以相机为中心的感知范围,在范围内进行均匀采样以形成单扫描点云,并确保点的数量与真实雷达扫描的数量一致。

- 帧聚合:对于动态物体,将同一目标的点云聚合到一起,以增加点云的密度。而对于静态目标,则没有必要进行聚合。

- 体素化: 利用射线传播的方式来解决遮挡问题,为被照射的部分均被认为是未观测的。

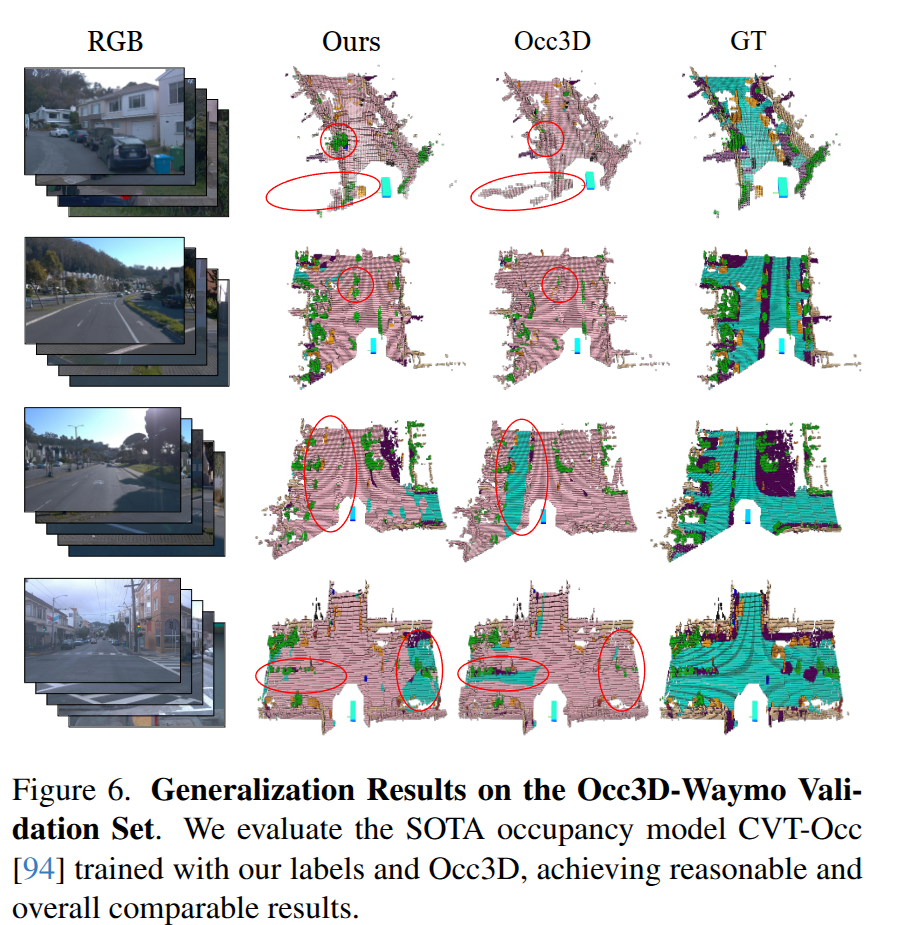

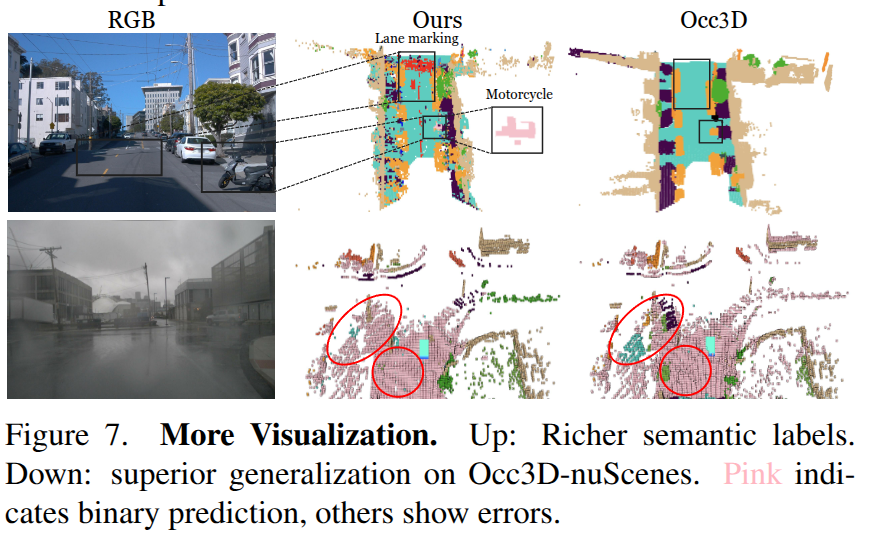

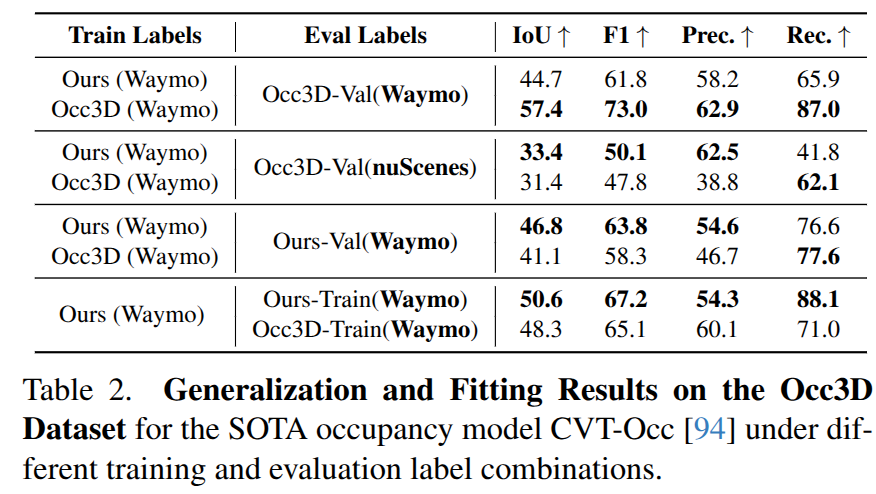

Experiments

GS-Occ3D:纯视觉三维占据重建

GS-Occ3D:纯视觉三维占据重建

382

382

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?