点击下方卡片,关注“自动驾驶之心”公众号

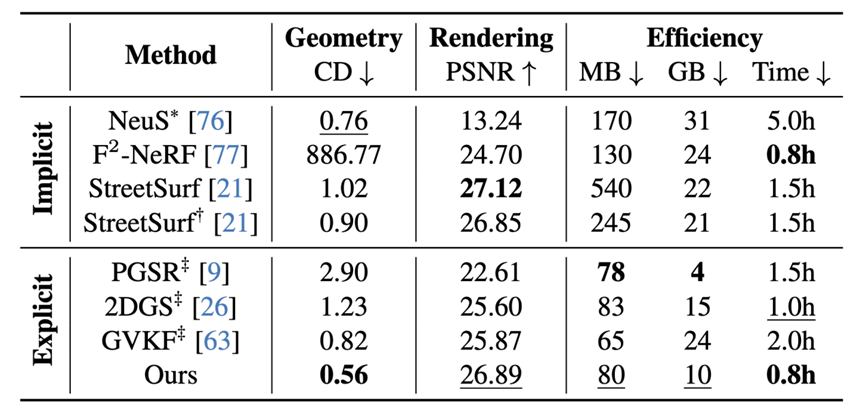

今天自动驾驶之心为大家分享清华大学&梅赛德斯奔驰最新的工作!GS-Occ3D:纯视觉规模化Occupancy重建,自动标注迈入新纪元!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群加入,也欢迎添加小助理微信AIDriver005

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Baijun Ye等

编辑 | 自动驾驶之心

导读

L4级自动驾驶的商业化浪潮已然到来。从特斯拉Robotaxi的落地运营,到小马智行、文远知行的成功上市,再到百度萝卜快跑的快速扩张,无不标志着自动驾驶正迈向大规模部署。其中,如何高效处理海量数据,构建可规模化的自动标注框架是核心挑战。具体而言,占据栅格(Occupancy)作为感知的核心,提供了关键的几何先验。然而,行业主流的占据栅格标注方法严重依赖激光雷达(LiDAR),这不仅成本高昂、难以扩展,也无法利用数量更庞大的消费级车辆的众包数据。

为解决这一问题,GS-Occ3D提出了一个低成本、可规模化的占据栅格重建新范式,通过基于八叉树的高斯面元方法来优化显式的几何表示,实现了低成本、高效的规模化自动标注。

GS-Occ3D 在Waymo实现了SOTA几何重建结果,在Occ3D-Waymo上验证了标签对下游占据栅格模型的有效性,并在 Occ3D-nuScenes上展示了其优越的零样本泛化能力。这凸显了大规模、基于视觉的占据栅格重建技术作为自动标注新范式的巨大潜力。

论文链接:https://arxiv.org/abs/2507.19451

项目主页:https://gs-occ3d.github.io/

研究动机与贡献

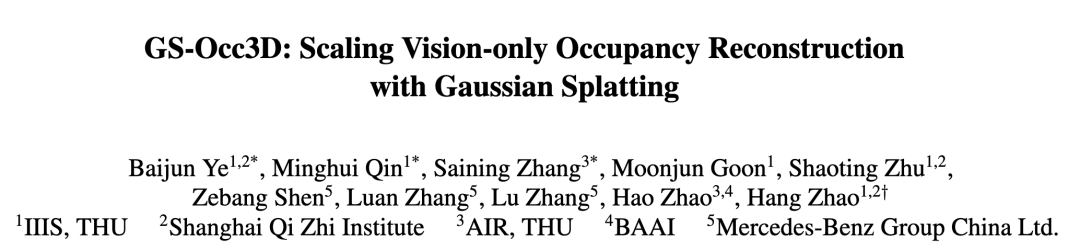

现有方法主要依赖于基于激光雷达(LiDAR)的占据栅格标注,这需要成本高昂的专业测绘车辆,从而极大地限制了其可扩展性。

相比之下,GS-Occ3D 引入了一个低成本、可规模化的占据栅格标注新范式,该框架能有效利用来自消费级车辆的大量众包数据进行自动标注。

然而,纯视觉范式面临诸多挑战。首先,纯视觉占据栅格重建本身就是一个严重的不适定问题,尤其是在消费级车辆带来的稀疏视角下,严重遮挡、物体的长时空复杂运动,以及不同尺度物体间的几何关系,都极大地增加了重建的难度。另一方面,以往的几何重建方法也存在明显局限,它们大多局限于以物体为中心、室内或相对简单的室外场景,难以适应真实世界中复杂多样的动态场景;并且,一些方法依赖于传统的网格(Mesh)表征,往往需要大量繁琐的后处理。因此,开发一种既无需激光雷达即可低成本获得占据栅格标签,又能实现规模化的自动标注的新范式,已成为该领域亟待突破的关键。

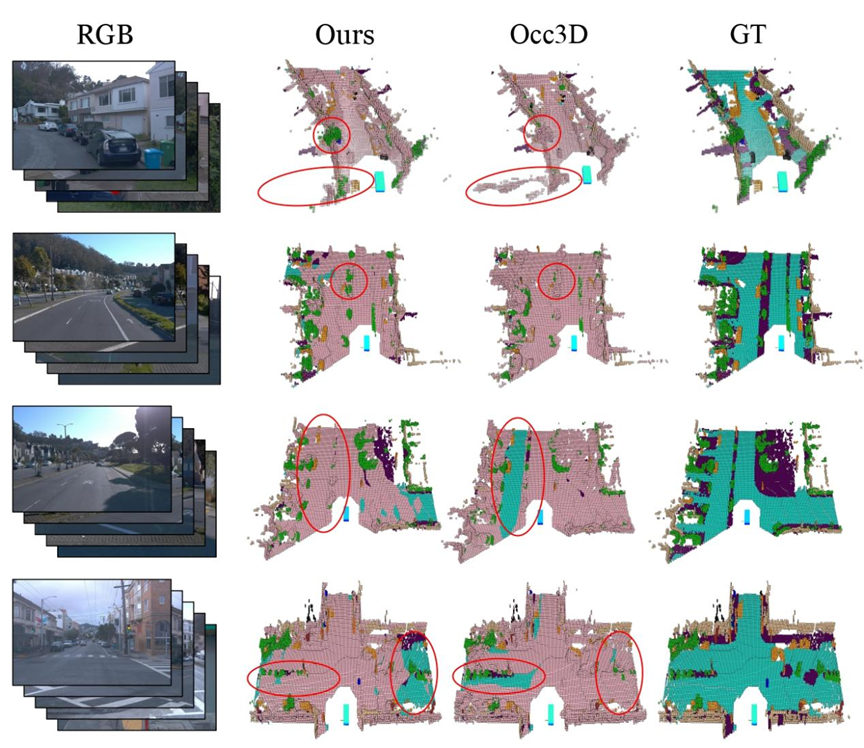

图1. 占据栅格范式对比。我们将预测的几何(粉色)与 Occ3D-Waymo 验证集的真值(其他颜色代表不同语义)进行叠加展示,为了直观展示预测不完整的区域。通过比较使用两种不同标签训练的模型,我们发现模型在几何泛化结果上能达到相当甚至更好的水平。

我们的方法实现了以低成本、可规模化的方式来获取高质量的占据栅格标签,贡献如下:

我们提出纯视觉占据栅格标签生成新范式,和之前依赖雷达的范式相比,具有语义丰富且方便获取,成本效益高,可规模化等优点;

我们的方法能有效地从沿长轨迹拍摄的全景街道视图中重建地面、背景和动态物体,实现了SOTA的几何重建结果,甚至超过了由激光雷达监督的基线模型。

我们首次使用纯视觉方法重建了整个 Waymo 数据集。我们在 Occ3D-Waymo 数据集上验证了标签对于下游感知模型的有效性,并在 Occ3D-nuScenes 数据集上展示了更优的零样本泛化能力。这证明了我们的方法在面向大规模自动驾驶应用时,具备高度的可扩展性与可靠性。

方法总览

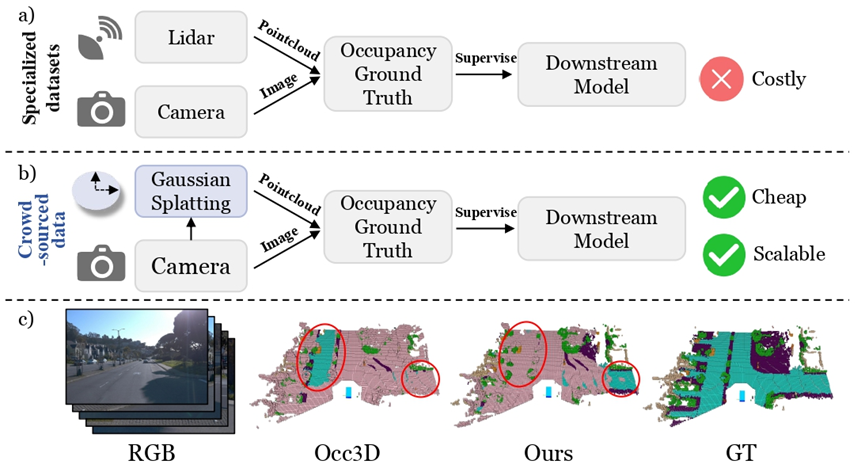

1.使用沿长轨迹拍摄的全景街道视图来生成稀疏点云和地面面元作为初始化。我们采用一种基于八叉树的高斯面元场景表示,该方法整合了地面、背景和动态物体,以实现纯视觉的规模化几何重建。此处展示的是一个上坡场景,其中的颜色代表高度。

2.针对纯视觉生成的点云,我们的标签生成流程首先通过逐帧划分和多帧聚合,为每帧定义合适的感知范围,同时提升点云密度(特别针对观测不完整的动态物体)。接着,对每一帧应用光线投射来确定体素的占据状态,并显式地处理相机视角的遮挡。

3.最终生成的纯视觉标签可用于训练下游的占据栅格模型,使这些模型能够泛化到未见过的场景,并具备几何推理能力。图中粉色部分表示预测的场景几何,其他颜色代表误差。

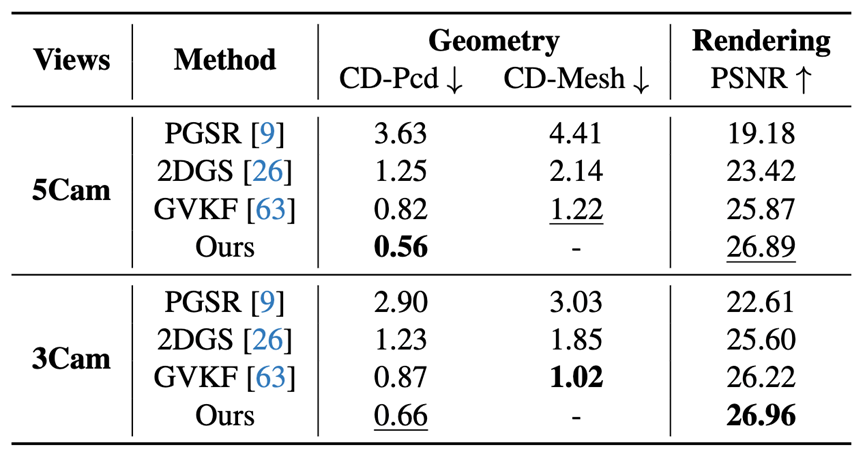

定量结果

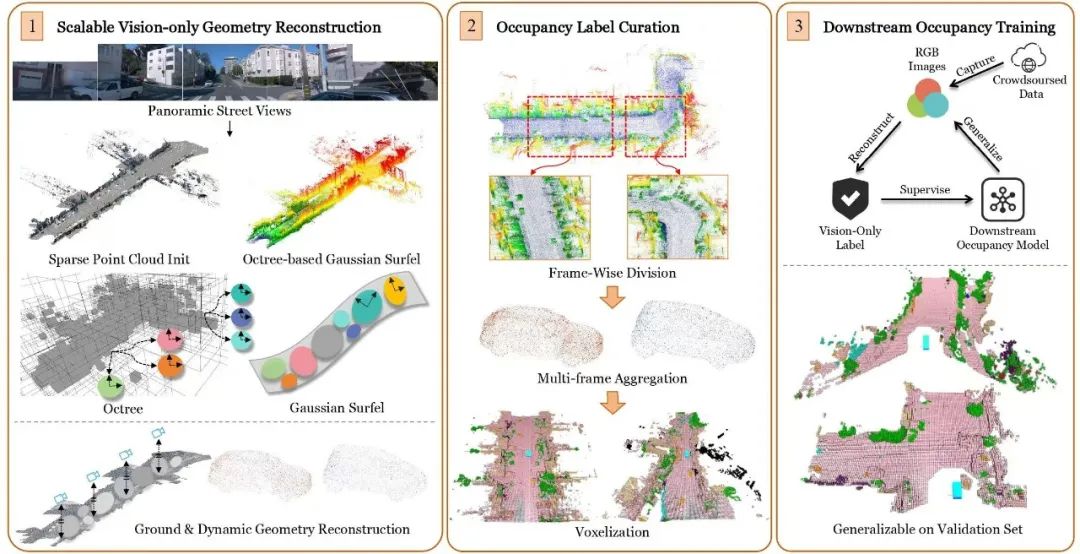

表1. Waymo数据集的SOTA几何重建结果。NeuS* 使用了1个稠密型和4个稀疏型激光雷达,StreetSurf† 使用了4个稀疏型激光雷达,而所有其他方法均为纯视觉方法。为了公平对比,‡ 表示使用了我们的地面高斯模型。MB代表模型存储大小,GB代表GPU显存占用,Time代表训练时间。

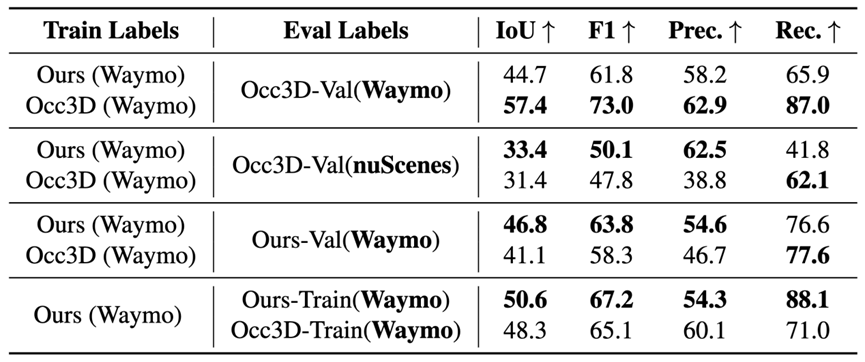

表2. 占据栅格泛化和拟合结果。

可比较且更优越的零样本占据栅格泛化结果:我们采用两种类型的标签训练SOTA模型CVT-Occ ,表2展示了在Occ3D验证集上的泛化结果。我们的方法展示了重建可泛化几何的能力,在 Occ3D-Waymo 数据集上取得了合理且整体上可媲美的结果。

尽管相机存在固有的局限性(例如 Waymo 的前视摄像头视角与 LiDAR 的360度覆盖范围的差异),我们的方法性能在 Occ3D-Val(Waymo)上略低,但结果仍在合理范围内。虽然我们和Occ3D在各自的验证集上表现更好,但我们在采用不同相机设置的 nuScenes 数据集上,展现出更优越的零样本泛化能力,在富含纹理及遥远的区域预测了更完整的几何结构。

考虑到 Occ3D 依赖于高端激光雷达数据,我们的结果更显难能可贵。我们的方法纯粹依赖相机输入,但在某些设定下,却能实现相当甚至更优的泛化性能。这不仅凸显了纯视觉方法的可扩展性,也展示了其在真实世界应用中达到甚至超越基于激光雷达的基线方法的巨大潜力。

无需先验,和LiDAR可比且互补。

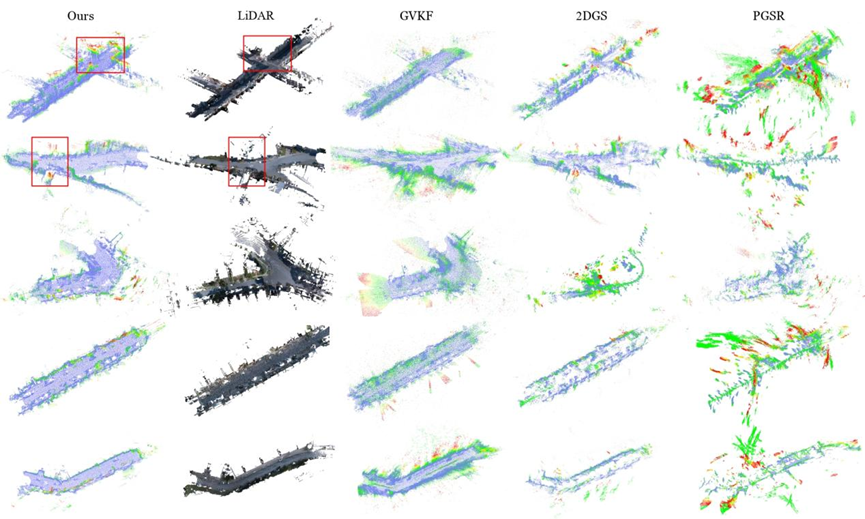

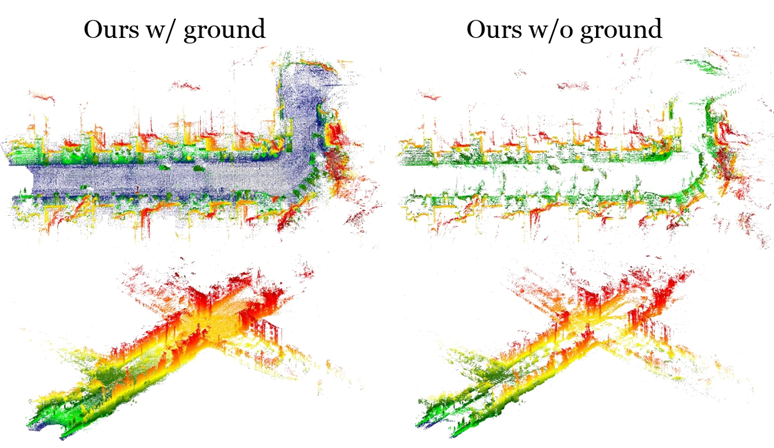

图3. Waymo 几何重建结果可视化。图中的颜色代表与激光雷达相比的倒角距离,颜色范围从蓝色(距离小)到红色(距离大)。与其他方法相比,我们的方法在弱纹理区域展现出更高的重建保真度;即使在没有几何先验的情况下,其结构的完整性也足以媲美激光雷达点云。

图4. 几何细节可视化。我们展示了图3中红色方框区域内的几何细节,其重建结果与激光雷达相比,既有可比性,又具互补性。第一行是上坡场景,而第二行是先下坡后上坡的场景。

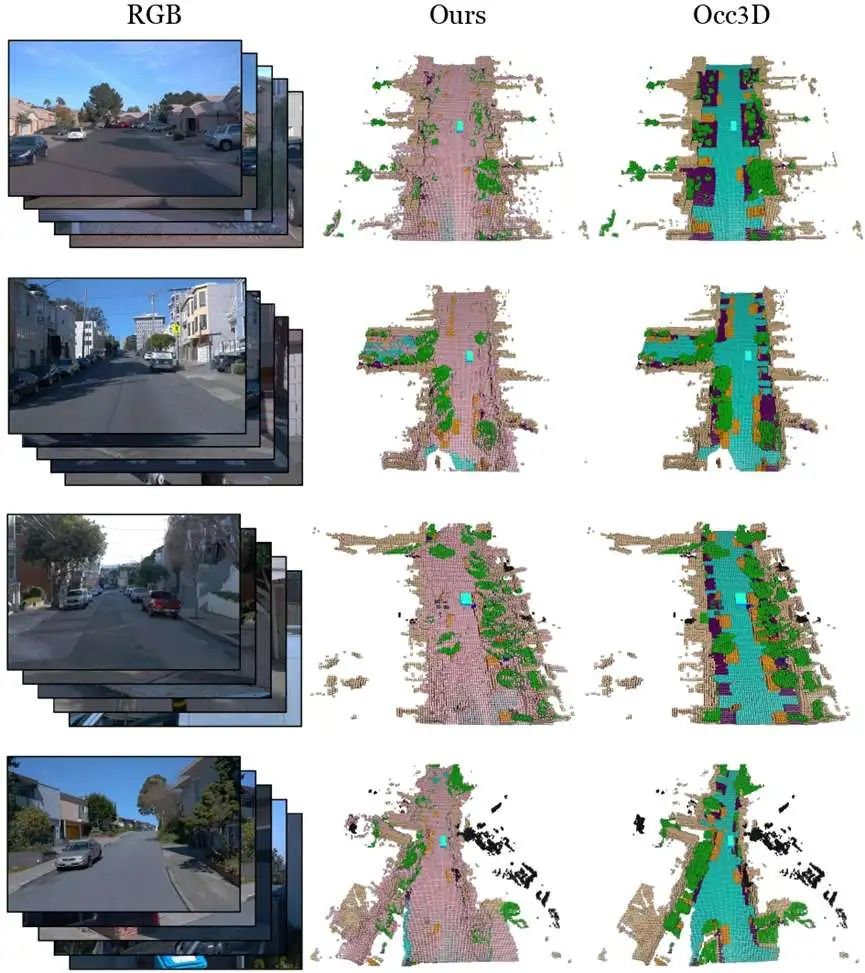

图5. 占据栅格标签可视化。我们的方法实现了在全局上可与 Occ3D 相媲美的几何结构,从而能够为无先验信息的占据栅格模型训练提供可靠的监督信号。

可比较且更优越的零样本占据栅格泛化能力。

图6. 占据栅格泛化结果。我们用SOTA占据栅格模型 CVT-Occ进行评估。该模型在分别使用我们的标签和 Occ3D 的标签进行训练后,取得了合理且整体上可媲美的结果。

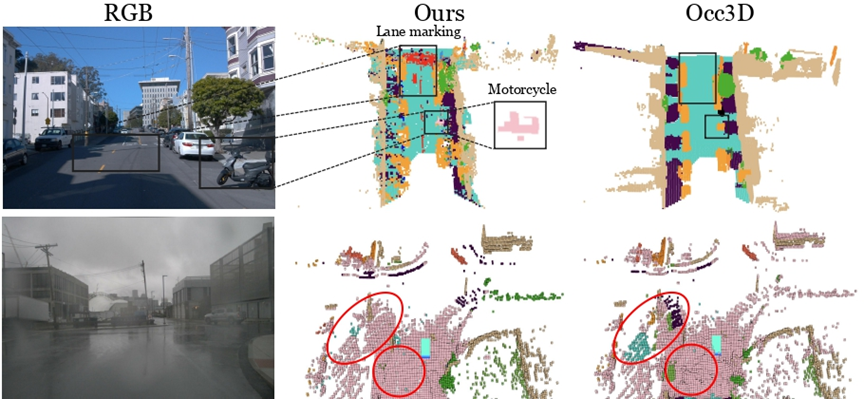

支持低成本丰富类别语义自动标注。

图7. 更多可视化结果。上图:更丰富且易获取的语义标签;下图:在 Occ3D-nuScenes 数据集上展现出更优的零样本泛化能力。图中粉色表示几何预测结果,其他颜色显示误差。

消融实验

我们受益于5摄像头的输入,而其他方法在增加更多视角时性能可能会下降。

直接重建点云的对于该任务更合适,也更具可扩展性。

地面重建效果显著。

表3. 消融实验定量结果。我们评估了在不同相机数量和不同表示方法下的实验结果。为确保公平,所有参与比较的方法都使用了我们的地面高斯模型。点云和网格的倒角距离均是相对于激光雷达真值进行计算的。

图8. 地面高斯消融实验。我们展示了地面高斯的有效性。颜色代表高度,范围从蓝色(低)至红色(高)。

实验分析

纯视觉标签相比于激光雷达标签的优劣:

优点:

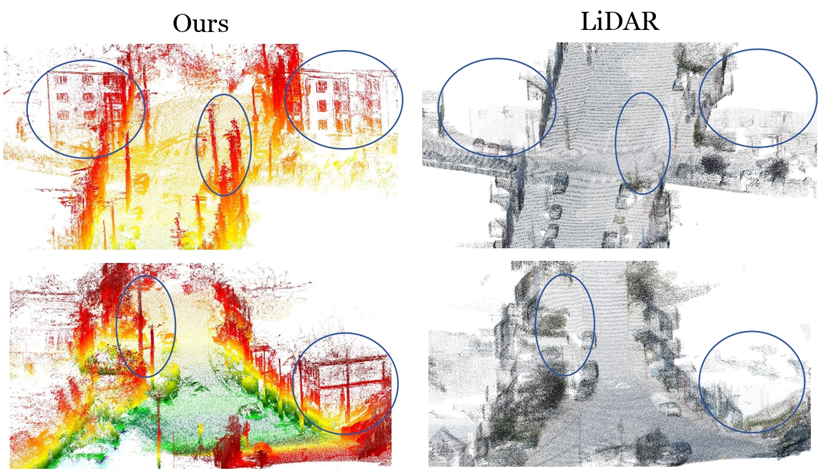

(1) 更广的覆盖范围:纯视觉几何重建可以弥补激光雷达在空间覆盖范围上的局限性,尤其是在大范围区域。在某些特定情况下,其性能甚至能超越激光雷达,例如在重建高层建筑时。

(2) 更优的零样本泛化能力:与激光雷达的标签相比,使用纯视觉标签训练的下游占据栅格模型能够泛化到更广泛的几何上,并具备更强的零样本泛化能力。

(3) 便宜且丰富的语义信息:图像本身就包含了颜色、纹理和物体类别等线索,而激光雷达的语义信息则需要耗费大量人力的标注或成本高昂的多传感器融合。通过预训练模型提供的丰富二维视觉语义,我们重建出了具有更丰富类别(多达66类,而 Occ3D 仅16类)的三维标签,其中包括了小物体以及被 Occ3D 遗漏的类别。图7展示了一些对激光雷达来说难以获取但对驾驶至关重要的语义信息。如图中高亮所示,与 Occ3D 不同,我们的方法能够区分摩托车,并识别车道线和人行横道。

(4) 在恶劣天气下潜力更大:尽管恶劣天气对两种传感器都有影响,但基于视觉的系统可以利用图像域中丰富的纹理和语义信息,并结合从大规模视觉数据中学到的先验知识,来更有效地重建质量下降的场景。图7可以看出,在雨天场景中,我们的泛化能力优于基于激光雷达的基线模型。

缺点:

(1) 相机视角固有的局限:Waymo仅提供了前视和侧视视角,缺乏后方视野的覆盖,这会导致不可避免的信息损失。

(2) 性能易受光照影响:在夜间或曝光异常等条件下,纯视觉方法的有效观测范围会显著缩减。

(3) 自车静止场景性能退化,需要先验:在自车静止的场景中,纯视觉方法通常难以重建几何结构。诸如 DUST3R、MAST3R 和 InstantSplat等方法,由于依赖 Waymo 激光雷达点云进行预训练,因此与纯视觉的设定不兼容。而一些更新的方法如VGGT,则可能优化这一问题。

结论

GS-Occ3D 是一个纯视觉规模化占据栅格重建新范式,它利用来自消费级车辆的众包数据进行自动标注,从而实现了低成本、可扩展的占据栅格标签生成。

首先,我们采用一种基于八叉树的高斯面元场景表示,来重建地面、背景和动态物体的几何结构,我们的纯视觉重建方法取得了SOTA几何重建效果。接着,我们重建了覆盖多种多样场景的完整 Waymo 数据集。这使得我们能够在 Occ3D-Waymo 数据集上验证标签对下游占据栅格模型的有效性,并在 Occ3D-nuScenes 数据集上展示出更优的零样本泛化能力。

我们凸显了大规模、纯视觉的占据栅格重建技术作为一种感知新范式的巨大潜力。我们希望这项工作能激励更多研究者去探索如何利用更先进的重建技术来赋能纯视觉标签的自动生成,以更好地服务于下游任务。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

GS-Occ3D:纯视觉占据重建新范式

GS-Occ3D:纯视觉占据重建新范式

1602

1602

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?