UFACTOR视觉演示

项目概述

ufactory_vision 是一个基于 UFACTORY(深圳市众为创造科技有限公司) 机械臂的视觉抓取演示项目。用户可以通过本项目快速实现基于视觉的物体检测和抓取。

硬件要求

示例脚本的硬件配置

| 机械臂型号 | 相机型号 | 末端执行器 |

|---|---|---|

| xArm 5/6/7或850 | Intel Realsense D435/D555 或 Luxonis OAK-D-Pro-PoE | UFACTORY 机械爪G1/G2 |

| Lite 6 | Intel Realsense D435 或 Luxonis OAK-D-Pro-PoE | Lite 6 真空吸头 |

- 基于 Intel Realsense D435 相机的配置:Readme

- 基于 Intel Realsense D555 相机的配置:Readme

- 基于 Luxonis OAK-D-Pro-PoE 相机的配置:Readme

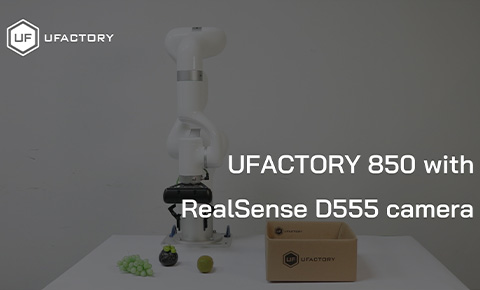

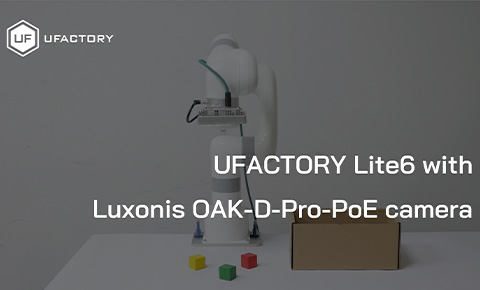

视频演示

- 定制850(1000M内置网线) + Realsense D555 + 内部网线走线 + UFACTORY 机械爪G2

- xArm6 + Realsense D435 + 外部USB走线 + UFACTORY 机械爪G1

- Lite6 + Luxonis OAK-D-Pro-PoE + 外部网线走线 + 真空吸头

许可证

本项目采用 BSD 3-Clause 许可证。详情请查看LICENSE文件。

致谢

我们的演示项目基于以下开源项目构建:

4504

4504

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?