前言

最近论文快deadline了,一直没空更新…今天复习一下多尺度特征融合的常用操作。

1. FPN 特征金字塔

论文:feature pyramid networks for object detection 论文链接

设计思路:

- 底层的特征语义信息比较少,但是目标位置准确。

- 高层的特征

语义信息比较丰富,但是目标位置比较粗略。

模型设计:自底向上Bottom-up,自顶向下Top-down,横向连接Lateral connection。

- 自底向上:特征图随着左半部分的网络的加深,尺寸会不断变小,语义信息会更加丰富,这里是将每个stage(尺寸不变的网络集合为一个stage)的最后一个特征图构成特征金字塔。

- 自顶向下:通过upsampling的方法,不断放大特征图,使得低层特征也包含丰富的语义信息。

- 横向连接:将上采样的结果和自底向上生成的相同大小的特征图进行融合。即:从左边过来的特征图,先经过1*1的卷积操作,然后与上面下来的特征图相加(element-wise addition),之后再经过3*3的卷积能得到本层的特征输出(消除上采样产生的混叠效应aliasing effect:插值生成的图像灰度不连续,在灰度变化的地方可能出现明显的锯齿状)。

FPN+RPN

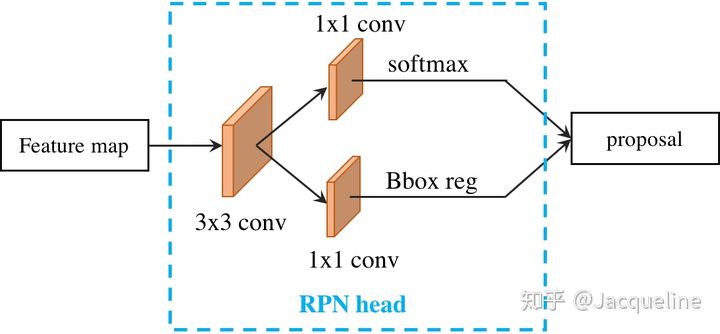

原先的RPN网络,输入的是经过主干网络提取的特征图(单尺度),设置的anchor有3种尺寸,3种宽高比,故有9种anchor:

加入了FPN后,RPN的输入是多尺度特征图,也就是每一层特征图后连接一个RPN head,因为已经有多尺度特征图了,就不需要设置另外3种尺寸,故有15种anchor:

FPN+ROI

ROI的作用是将输入的(检测框,整特征图)进行pooling,得到相同尺寸的目标特征图。使用了FPN之后,就有了多尺度特征图,考虑到实际目标有大有小,所以使用下公式判断将哪一层的特征图输入到ROI中:

本文介绍了多尺度特征融合技术在目标检测中的应用,包括特征金字塔网络FPN的设计思路及实现方式,以及FPN如何与RPN和ROI结合提高检测精度。此外还探讨了PANet在此基础上的改进。

本文介绍了多尺度特征融合技术在目标检测中的应用,包括特征金字塔网络FPN的设计思路及实现方式,以及FPN如何与RPN和ROI结合提高检测精度。此外还探讨了PANet在此基础上的改进。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

947

947

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?