一、本文介绍

🔥本文给大家介绍利用SSA(稀疏自注意力)模块改进YOLOv13网络模型。SSA通过稀疏注意力机制聚焦于非语义特征,有效提取与图像操控相关的细节,减少了不必要的计算和参数数量,从而提高了模型的实时检测能力。此外,SSA增强了模型对复杂背景和小物体的敏感性,提升了其鲁棒性和泛化能力,特别在目标遮挡、模糊等场景下表现突出。通过减少内存占用和计算量,SSA使得YOLOv13在资源有限的环境中更加高效,适用于大规模或实时图像处理任务。

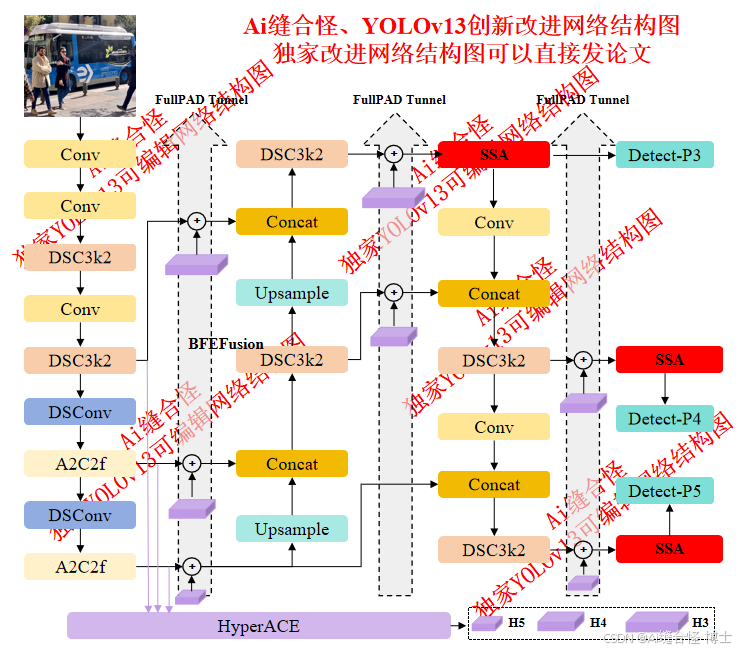

展示部分YOLOv13改进后的网络结构图、供小伙伴自己绘图参考:

🚀 创新改进结构图: yolov13n_SSA.yaml

专栏改进目录:YOLOv13改进包含各种卷积、主干网络、各种注意力机制、检测头、损失函数、Neck改进、小目标检测、二次创新模块、HyperACE二次创新、独家创新等几百种创新点改进。

全新YOLOv13创新改进专栏链接:全新YOLOv13创新改进高效涨点+永久更新中(至少500+改进)+高效跑实验发论文

本文目录

1.首先在ultralytics/nn/newsAddmodules创建一个.py文件

2.在ultralytics/nn/newsAddmodules/__init__.py中引用

🚀 创新改进1: yolov13n_HyperACE_SSA.yaml

🚀 创新改进3: yolov13n_DSC3k2_SSA.yaml

二、SSA稀疏自注意力模块介绍

摘要:非语义特征或语义无关特征——这类特征与图像上下文无关但对图像篡改敏感——被认定为图像篡改定位(IML)的证据。由于无法进行人工标注,现有研究依赖手工设计的方法来提取非语义特征。但手工设计的非语义特征会削弱IML模型在未知或复杂场景下的泛化能力。因此,IML的核心难题在于:如何自适应地提取非语义特征?非语义特征具有上下文无关且易受篡改的特性。具体而言,在图像内部,除非发生篡改,否则这些特征在不同图像块间保持一致。此时,图像块间的稀疏离散交互就足以提取非语义特征。然而,不同图像块间的语义差异显著,需要图像块间密集连续的交互才能学习语义表征。为此,本文提出稀疏视觉变换器(SparseViT),将ViT中密集的全局自注意力机制重构为稀疏离散形式。这种稀疏自注意力机

订阅专栏 解锁全文

订阅专栏 解锁全文

57

57

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?