一、本文介绍

🔥本文给大家介绍使用MOGA多阶门控聚合模块改进YOLOv11网络模型,可以显著提升其特征表达能力和计算效率。MogaBlock通过捕捉低阶、中阶和高阶的多阶交互特征,增强了模型在复杂场景和多目标检测中的表现,尤其在细粒度目标、遮挡和噪声环境下的鲁棒性。通过自适应的空间和通道特征聚合,它减少了信息冗余,提高了参数效率,同时通过门控机制有效过滤不重要的特征,提升了模型的检测精度和训练收敛速度。这使得YOLOv11在保持高效性的同时,能够在复杂应用中获得更准确的检测结果。

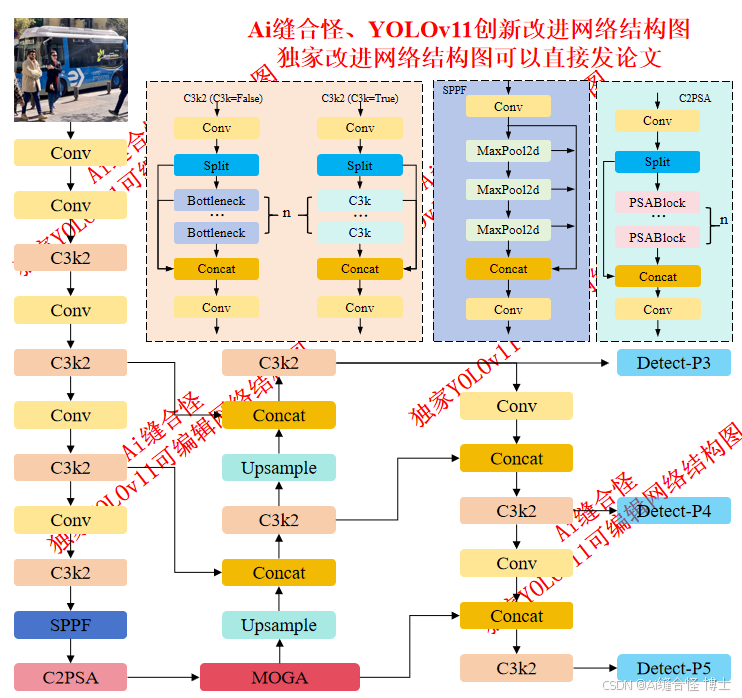

展示部分YOLOv11改进后的网络结构图、供小伙伴自己绘图参考:

🚀 创新改进结构图: yolov11n_MOGA.yaml

专栏改进目录:YOLOv11改进专栏包含卷积、主干网络、各种注意力机制、检测头、损失函数、Neck改进、小目标检测、二次创新模块、C2PSA/C3k2二次创新改进、全网独家创新等创新点改进

全新YOLOv11-发论文改进专栏链接:全新YOLOv11创新改进高效涨点+永久更新中(至少500+改进)+高效跑实验发论文

本文目录

1.首先在ultralytics/nn/newsAddmodules创建一个.py文件

2.在ultralytics/nn/newsAddmodules/__init__.py中引用

🚀 创新改进3: yolov11n_C3k2_MogaBlock.yaml

二、MOGA模块介绍

摘要:现代卷积神经网络(ConvNets)通过尽可能将卷积核上下文化为全局的方式,在计算机视觉任务中展现了巨大的潜力。然而,最近对深度神经网络(DNN)中的多阶博弈交互的研究揭示了现代卷积网络的表示瓶颈,在增加卷积核大小的同时,未能有效编码表现力强的交互特征。为了解决这一问题,我们提出了一种新的现代卷积网络架构,称为MogaNet,旨在纯卷积网络基础上进行判别性视觉表示学习,并且在复杂性与性能之间取得良好的平衡。MogaNet将概念上简单但有效的卷积和门控聚合封装成一个紧凑的模块,其中判别性特征被高效地收集并自适应地上下文化。MogaNet表现出卓越的可扩展性、显著的参数效率,并在多个下游视觉基准任务中(包括ImageNet分类、COCO目标检测、ADE20K语义分割、2D/3D人体姿态估计和视频预测)与最先进的ViT和ConvNet模型竞争。值得注意的是,MogaNet在ImageNet-1K上以5.2M和181M参数分别达到了80.0%和87.8%的准确率,超越了ParC-Net和ConvNeXt-L,同时分别节省了59%的FLOPs和17M参数。

订阅专栏 解锁全文

订阅专栏 解锁全文

1075

1075

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?