目录

1 引言

1 引言

1.1 文本摘要在现代信息处理中的意义

在信息爆炸的时代,人们每天面对海量的文本内容。无论是学术研究、新闻阅读还是业务文档的处理,快速获取核心信息的能力变得至关重要。文本摘要技术应运而生,它通过自动提取文本的关键内容,帮助用户在有限的时间内理解全文的要点。传统的摘要方法多数采用抽取式策略,即从原文中直接选择关键句子组织成摘要。而现代深度学习方法,特别是基于大语言模型的摘要技术,能够进行生成式摘要,产生高度凝练且自然流畅的总结文本。

讯飞星火大模型是科大讯飞推出的新一代人工智能模型,具有强大的自然语言理解和生成能力。本文介绍的系统正是基于讯飞星火API构建的文本摘要工具,它将大模型的能力与用户友好的图形界面相结合,使普通用户无需编程知识就能享受到先进的AI文本处理服务。

1.2 WebSocket协议在实时应用中的优势

在构建实时交互系统时,网络通信协议的选择至关重要。传统的HTTP协议采用请求-响应模式,每次通信都需要建立新的连接,这在频繁交互的场景下会产生大量的网络开销。而WebSocket协议在建立初始连接后,可以保持长连接状态,实现真正的双向通信。对于文本摘要这类可能耗时较长的任务,使用WebSocket允许服务器在处理过程中持续向客户端推送数据,客户端可以实时显示摘要的生成过程,而不是等待整个任务完成后一次性返回结果。这种设计显著提升了用户体验,使用户能够感受到系统的实时响应性。

1.3 系统的核心特性与应用场景

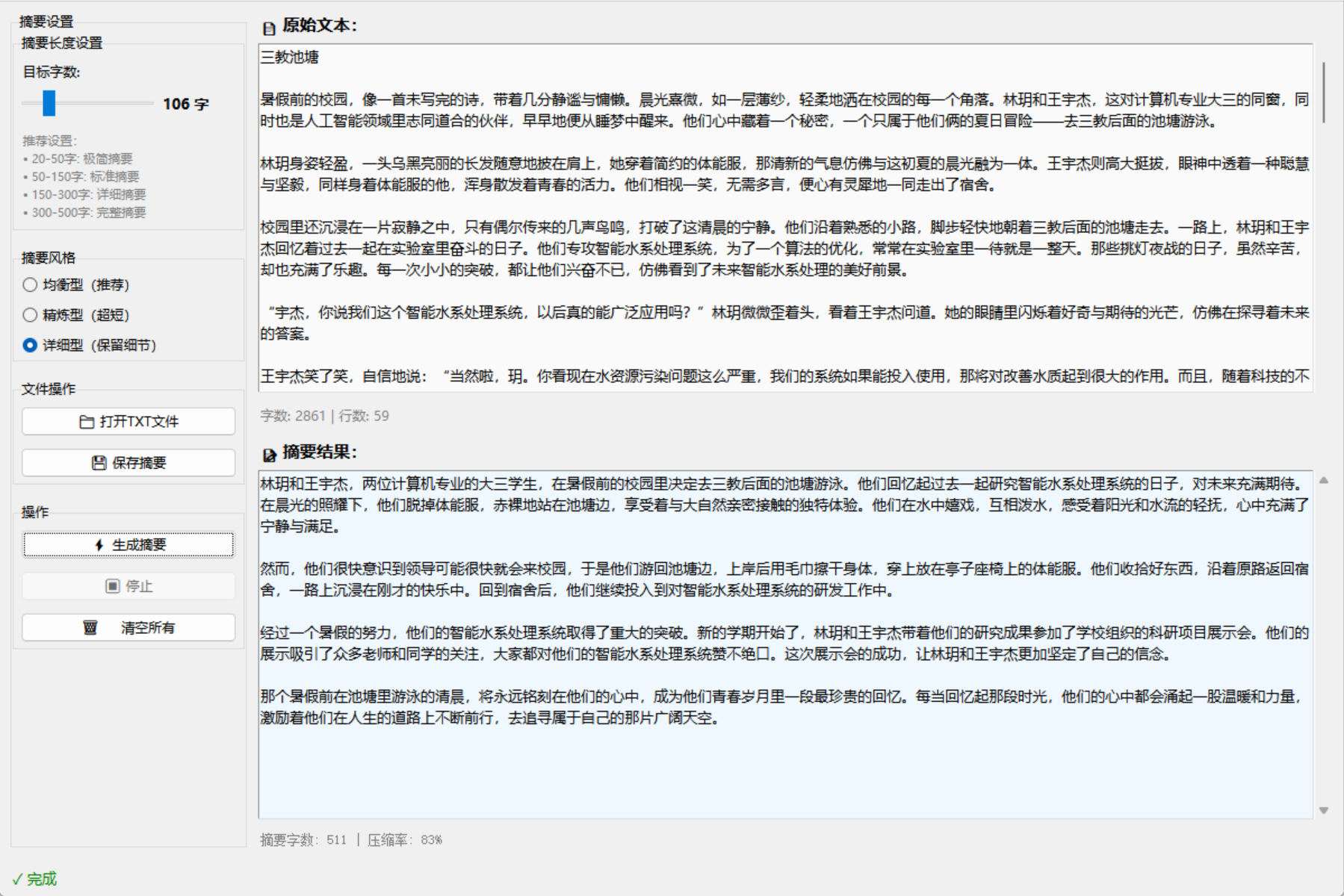

本文介绍的讯飞星火文本摘要系统具备多项独特的特性。首先,它支持自定义摘要长度,用户可以根据实际需求选择生成20到500字之间的摘要。其次,系统提供三种不同的摘要风格,包括精炼型、均衡型和详细型,满足不同用户的需求偏好。第三,系统完美处理中文文件路径和多种文本编码,这对于中文用户是至关重要的。最后,系统采用实时进度显示和流式内容接收的方式,使用户能够实时看到摘要的生成过程。这样的设计使系统适用于学术研究、新闻编辑、文档管理等多个领域。

2 系统整体设计与架构

2.1 技术栈与设计思想

构建一个现代的AI应用系统需要在多个技术选择之间取得平衡。本系统选择了Python作为开发语言,这得益于Python在AI和数据处理领域的生态优势。Tkinter作为GUI框架选择,虽然不是最现代的,但它具有无需额外安装、跨平台兼容性强等优点,特别适合快速构建桌面应用。在通信方面,系统使用WebSocket而非传统REST API,这是经过深思熟虑的决策。

WebSocket与REST API各有优劣。REST API的优点是无状态、易于扩展和缓存,但在处理长连接和实时推送时显得力不从心。WebSocket则完全相反,它维持长连接状态,能够实现低延迟的双向通信。对于文本摘要这类任务,选择WebSocket的原因是多方面的:一是可以实时接收摘要生成过程中的部分结果,提供更好的用户反馈;二是在网络不稳定的环境中,WebSocket的连接管理比频繁的HTTP请求更可靠;三是这符合现代API设计的发展趋势。

| 对比维度 | HTTP REST API | WebSocket |

|---|---|---|

| 连接模式 | 无状态请求-响应 | 长连接双向通信 |

| 实时推送 | 需要轮询或服务器推送扩展 | 原生支持 |

| 延迟 | 较高(建立连接开销) | 较低 |

| 复杂度 | 低 | 中等 |

| 适用场景 | 数据查询、CRUD操作 | 实时聊天、流式数据 |

| 扩展性 | 高 | 中等 |

2.2 系统模块的逻辑划分

从代码组织的角度看,整个系统围绕SparkSummarizationGUI这个单一类展开,这个设计虽然简化了架构,但也带来了一定的紧耦合。在这个类中,可以逻辑上划分为几个主要模块。首先是认证与连接模块,负责生成WebSocket连接URL并进行身份验证。其次是UI模块,包含用户界面的初始化和各个交互元素的管理。第三是文本处理模块,处理文件I/O和文本的读写。第四是API调用模块,负责与讯飞星火API的交互,包括消息构建、发送和接收。最后是业务逻辑模块,实现摘要风格选择、长度控制等功能。这种逻辑划分虽然没有物理上分离,但有助于理解系统的各个部分如何协作。

2.3 初始化流程与关键参数配置

系统的初始化从__init__方法开始。在这个方法中,首先设置窗口的基本属性,包括标题和窗口大小1200x800像素,这个尺寸的选择考虑到了现代屏幕的分辨率和用户的操作习惯。接着,代码配置了API密钥和服务器地址。这三个关键参数——app_id、api_secret和api_key——是与讯飞服务器通信的必要凭证。API地址采用wss协议(WebSocket Secure),表示这是加密的WebSocket连接。domain字段设置为"lite",表示使用讯飞星火的Lite版本模型,这个版本提供了成本和性能之间的良好平衡。

初始化还创建了若干状态变量。is_generating标志用于追踪摘要生成的状态,防止用户在生成过程中重复触发请求。summary字符串缓存用于在WebSocket回调中积累生成的摘要内容。summary_length是一个Tkinter的IntVar,用于绑定UI中的滑块组件。这种状态管理的设计使得系统能够在异步操作中保持一致的状态。

3 认证与连接机制的深度分析

3.1 WebSocket安全认证的原理

讯飞星火API采用基于签名的认证机制,这是一种常见的API安全方案。不同于简单的密钥验证,签名机制通过在特定的时间点对特定的数据进行加密,生成一个独一无二的签名,服务器通过验证签名来确保请求的真实性。这种设计有几个优势:首先,它防止了密钥在传输过程中被拦截;其次,签名绑定到特定的时间,使得重放攻击(使用旧的请求重新发送)变得困难;第三,签名还验证了请求未被篡改。

具体到本系统的实现,认证过程从create_websocket_url方法开始。这个方法的首要任务是生成一个RFC1123格式的时间戳。RFC1123是一个互联网标准的日期格式,具体形如"Fri, 20 Dec 2025 00:00:00 GMT"。生成这个时间戳的代码使用了Python标准库中的datetime和wsgiref.handlers模块。首先获取当前的UTC时间,然后通过format_date_time函数将其转换为RFC1123格式。这个时间戳随后会被用于签名计算,确保签名时间有效性。

from time import mktime

from wsgiref.handlers import format_date_time

from datetime import datetime

now = datetime.now()

date = format_date_time(mktime(now.timetuple()))

这段代码虽然看起来简洁,但其中的细节需要注意。datetime.now()返回的是本地时间,而不是UTC时间。mktime函数将时间元组转换为时间戳(秒数),format_date_time则将其转换为RFC1123格式。这个转换过程是必要的,因为WebSocket签名验证对时间的格式有严格要求。

3.2 HMAC-SHA256签名的计算过程

当时间戳生成后,系统需要基于这个时间戳和其他信息生成签名。这个过程涉及构建一个特定格式的"签名源字符串"。这个字符串包含三个关键信息:WebSocket主机名、当前时间和HTTP请求行。代码中的实现如下:

parsed_url = urlparse(self.api_url)

host = parsed_url.netloc

path = parsed_url.path

signature_origin = f"host: {host}\n"

signature_origin += f"date: {date}\n"

signature_origin += f"GET {path} HTTP/1.1"

这里首先解析了API URL来提取主机名和路径。URL的格式是wss://spark-api.xf-yun.com/v1.1/chat,其中spark-api.xf-yun.com是主机名,/v1.1/chat是路径。签名源字符串的格式严格遵循了讯飞的规范,这非常重要,因为服务器会基于同样的算法生成签名来验证请求。

有了签名源字符串之后,系统使用HMAC-SHA256算法对其进行加密。HMAC是带密钥的哈希消息认证码,SHA256是一个256位的加密哈希函数。使用api_secret作为密钥:

signature_sha = hmac.new(

self.api_secret.encode('utf-8'),

signature_origin.encode('utf-8'),

digestmod=hashlib.sha256

).digest()

这段代码中,api_secret.encode('utf-8')将密钥字符串转换为字节,signature_origin.encode('utf-8')将签名源字符串转换为字节,digestmod=hashlib.sha256指定使用SHA256算法。.digest()方法返回的是二进制形式的HMAC值。

3.3 Base64编码链与最终URL生成

HMAC计算得到的是二进制数据,无法直接在URL中传输,因为URL有编码限制。因此系统需要对其进行Base64编码,将二进制数据转换为可安全传输的ASCII字符串:

signature_sha_base64 = base64.b64encode(signature_sha).decode(encoding='utf-8')

随后,系统构建了"authorization原始字符串",这是一个遵循特定格式的字符串,包含了api_key、算法名称、包含的HTTP头和前面计算得到的签名:

authorization_origin = f'api_key="{self.api_key}", algorithm="hmac-sha256", headers="host date request-line", signature="{signature_sha_base64}"'

这个字符串还需要再经过一次Base64编码,成为最终的authorization参数:

authorization = base64.b64encode(authorization_origin.encode('utf-8')).decode(encoding='utf-8')

最后,系统将authorization、date和host这三个参数添加到API URL中,形成最终的WebSocket连接URL:

v = {

"authorization": authorization,

"date": date,

"host": host

}

url = self.api_url + '?' + urlencode(v)

urlencode函数将字典转换为URL查询字符串的形式,例如?authorization=xxx&date=yyy&host=zzz。这个URL包含了所有必要的认证信息,当客户端使用这个URL建立WebSocket连接时,服务器可以验证签名的正确性来确保请求的合法性。

这个认证过程虽然看起来复杂,但它的存在是必要的。双重Base64编码可能显得冗余,但这恰恰是标准的安全做法。第一次编码是为了将二进制HMAC值转换为可传输的格式,第二次编码是为了将包含特殊字符的authorization字符串转换为URL安全的格式。

4 用户界面设计与交互体验

4.1 Tkinter框架的选择与局限性

Tkinter是Python的标准GUI库,它被内置在大多数Python发行版中,这使得开发者无需额外安装就能创建跨平台的图形应用。在本系统中选择Tkinter的另一个重要原因是其学习曲线相对平缓,代码量也相对较少。虽然Tkinter在视觉效果上不如现代的Web框架(如React或Vue)或其他桌面框架(如PyQt或wxPython),但对于数据处理应用来说,这种视觉上的简朴是可以接受的,因为用户更关心的是功能而不是外观。

不过,Tkinter确实存在一些局限性。首先,它的组件库相对基础,一些高级功能需要通过创建自定义组件来实现。其次,在处理大量数据更新时,Tkinter的性能可能不如现代框架。第三,Tkinter的布局管理虽然功能完整,但相比其他框架较为繁琐。尽管如此,对于这个文本摘要应用来说,Tkinter是一个务实的选择,它将开发复杂度控制在一个合理的范围内。

4.2 左侧控制面板的精心设计

系统的左侧控制面板采用垂直布局,从上到下依次包含摘要长度设置、摘要风格选择、文件操作和操作按钮四个主要区域。这种纵向堆叠的布局遵循了直观的逻辑流程:首先用户配置摘要参数(长度和风格),然后加载或输入文本内容,最后触发生成操作。

摘要长度设置区域的核心是一个滑块(Scale)组件。这个滑块的范围被设置为20到500字,这个范围的选择基于实际应用中的需求。20字是一个极简的摘要,仅包含最核心的一两个句子。500字则足以提供一个相当详细的总结。滑块的值被绑定到summary_length这个IntVar变量,任何滑块的移动都会自动更新这个变量。与滑块相邻的是一个实时显示的标签,它显示当前选定的字数。这种设计提供了即时的视觉反馈,用户在调整滑块时可以实时看到选择的值。

self.length_slider = ttk.Scale(

slider_frame,

from_=20,

to=500,

variable=self.summary_length,

orient=tk.HORIZONTAL

)

self.length_slider.pack(side=tk.LEFT, fill=tk.X, expand=True)

滑块下方的提示文本给出了摘要长度的建议。这个提示的存在是出于可用性考虑。对于第一次使用系统的用户,可能不清楚选择多少字的摘要才是合适的。通过提供具体的建议——"20-50字为极简摘要,50-150字为标准摘要"等——系统引导用户做出更明智的选择。

摘要风格选择使用了三个单选按钮(Radiobutton),分别对应精炼型、均衡型和详细型。这三种风格的实现依赖于发送给大模型的系统提示(system prompt)的不同。精炼型风格会指示大模型使用约80%的目标字数并去除所有冗余信息,均衡型则是标准的摘要方法,详细型会使用约120%的字数并保留重要细节。这种多风格的设计使系统能够适应不同的用户偏好和应用场景。

4.3 右侧文本显示区域的信息呈现

右侧区域被分为两个相等的部分:原始文本区域和摘要结果区域。原始文本区域使用了ScrolledText组件,这个组件结合了文本框和滚动条的功能,使用户在处理长文本时能够方便地浏览内容。文本框的字体被设置为微软雅黑10号,这在中文文本的显示上提供了良好的可读性。背景色设置为#fafafa,一个略微灰一点的白色,这种设计减少了纯白背景对眼睛的刺激。

文本框被绑定了两个事件处理器。第一个是<<Change>>事件,这是一个自定义事件,虽然在这里的效果可能有限。第二个是<KeyRelease>事件,每当用户释放一个按键时触发。这个事件触发时,系统调用update_text_stats方法来更新文本统计信息。这个方法计算文本的字数和行数:

def update_text_stats(self, event=None):

text = self.source_text.get("1.0", tk.END)

char_count = len(text.strip())

line_count = len(text.split('\n'))

self.text_stats_label.config(text=f"字数: {char_count} | 行数: {line_count - 1}")

这里的"1.0"表示文本框的第一行第一列,tk.END表示文本的末尾。.strip()方法移除了首尾的空白字符,确保统计的是实际内容的字数。

摘要结果区域的设计与原始文本区域类似,但有一个关键的区别——它的state被设置为tk.DISABLED。这意味着用户无法直接编辑这个文本框中的内容,它是只读的。这是一个合理的设计决策,因为摘要结果应该是系统生成的,不应该被用户修改。只有在生成摘要的过程中,系统才会临时改变其为tk.NORMAL状态来插入文本。

在每个文本区域下方都有一个统计标签。对于源文本,它显示字数和行数。对于摘要,它显示摘要的字数和压缩率。压缩率的计算公式是100 - (摘要字数 / 源文本字数) * 100,这给出了一个百分比,表示摘要相对于原文的缩减程度。例如,如果原文是1000字,摘要是200字,压缩率就是80%,表示摘要将文本缩减到了原来的20%。

4.4 状态显示与用户反馈机制

窗口底部的状态栏是用户与系统交互的另一个关键部分。它包含三个主要元素:状态标签、进度标签和进度条。状态标签始终显示系统的当前状态,如"就绪"(绿色)、"正在连接..."(橙色)、"正在生成摘要..."(橙色)、"完成"(绿色)或"错误"(红色)。通过改变标签的文本和颜色,系统向用户传达了清晰的状态信息。

进度标签显示的是更详细的信息,如"⏳ 正在生成摘要..."或"⏸️ 用户中止"。这些emoji的使用增加了界面的可视化程度,使用户能够快速理解当前的状态。进度条(Progressbar)虽然在代码中被创建,但在实际的操作中使用了indeterminate模式,这意味着它会显示一个不断移动的条纹,而不是一个具体的百分比。这种模式适合不知道具体完成百分比的长时间操作。

5 文件I/O与文本处理

5.1 多编码的文件读取策略

在处理用户输入的文本文件时,系统需要面对一个现实的问题:不同用户使用的文本编码可能不同。在Windows系统上,中文文本常常使用GBK或GB2312编码,而在Unix/Linux系统上,UTF-8是标准编码。甚至在同一个系统上,用户可能混用多种编码的文本文件。因此,一个健壮的系统必须能够处理多种编码。

本系统的open_file方法采用了优雅的降级策略。它首先尝试以UTF-8编码打开文件,如果这失败了(抛出UnicodeDecodeError异常),则自动尝试GBK编码:

try:

with open(file_path, 'r', encoding='utf-8') as f:

content = f.read()

except UnicodeDecodeError:

with open(file_path, 'r', encoding='gbk') as f:

content = f.read()

这个策略的好处是它对用户完全透明。用户无需选择编码方式,系统会自动处理。UTF-8优先的选择是合理的,因为UTF-8是现代的国际标准,即使在中文文本中也越来越普遍。GBK作为备选,覆盖了Windows系统上常见的编码情况。

5.2 中文路径的完美支持

对于中文用户来说,中文文件名和中文路径是常见的。不过,处理中文路径并不总是直接的。在某些情况下,Python的标准库函数可能在处理非ASCII字符的文件名时遇到困难。本系统通过引入pathlib模块来解决这个问题:

from pathlib import Path

file_path = Path(file_path)

pathlib.Path是Python 3引入的现代路径处理方式。它提供了一个面向对象的接口来处理文件系统路径,比起传统的基于字符串的方法,它在处理复杂的路径操作和特殊字符(包括中文)时更加可靠。通过将文件路径转换为Path对象,系统确保了后续的文件操作能够正确处理中文路径。

5.3 摘要的保存与信息完整性

当用户生成了一个满意的摘要后,他们可能想要保存它以供后续查看或进一步处理。save_summary方法处理这个功能。有趣的是,这个方法不仅保存摘要本身,还保存了相关的元数据,包括生成时间、原文字数、摘要字数和压缩率。

content = f"""【摘要信息】

生成时间: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}

原文字数: {len(self.source_text.get('1.0', tk.END).strip())}

摘要字数: {len(summary)}

压缩率: {100 - int(len(summary) / max(len(self.source_text.get('1.0', tk.END).strip()), 1) * 100)}%

【摘要内容】

{summary}

"""

这个设计的妙处在于它为用户提供了完整的上下文信息。假设一个用户在三个月后打开这个保存的摘要文件,他/她可以立即看到摘要是何时生成的,原文有多长,以及这个摘要的压缩率是多少。这种设计使保存的摘要更加有价值,用户能够更好地理解这个摘要的来龙去脉。

保存过程中还使用了pathlib来处理文件路径:

file_path = Path(file_path)

with open(file_path, 'w', encoding='utf-8') as f:

f.write(content)

保存时始终使用UTF-8编码,这确保了在任何现代系统上都能正确打开这个文件。

6 核心摘要生成流程

6.1 异步设计与线程管理

文本摘要的生成可能需要数秒到数十秒的时间,具体取决于文本长度和网络延迟。如果这个操作在主线程中执行,整个用户界面会被阻塞,用户会看到一个无响应的窗口。为了避免这个问题,本系统使用了多线程编程。当用户点击"生成摘要"按钮时,系统不是直接调用API,而是在后台启动一个新的线程:

threading.Thread(

target=self.call_websocket_api,

args=(text,),

daemon=True

).start()

daemon=True表示这个线程是一个守护线程,当主程序退出时,这个线程会自动终止,即使它还在执行中。这个设置对于避免程序因为后台线程而无法正常退出是必要的。

在启动线程之前,系统禁用了"生成摘要"按钮并启用了"停止"按钮。这是一个重要的交互设计,它向用户表明操作已经开始,同时提供了一个中断操作的方式。

self.generate_btn.config(state=tk.DISABLED)

self.stop_btn.config(state=tk.NORMAL)

6.2 WebSocket连接与消息构建

在call_websocket_api方法中,系统首先创建了前面提到的认证URL,然后建立WebSocket连接。websocket.WebSocketApp是一个高级的WebSocket客户端,它提供了事件驱动的接口来处理连接、消息接收和错误。

系统定义了四个关键的回调函数。on_open在连接成功建立后立即调用,这是向服务器发送摘要请求的最佳时机。在这个回调中,系统根据用户选择的摘要风格,构建了相应的系统提示:

style = self.style_var.get()

if style == "concise":

system_prompt = f"请用大约{int(self.summary_length.get() * 0.8)}字的最精炼语言概括文本核心内容,去除所有冗余信息。"

elif style == "detailed":

system_prompt = f"请用大约{int(self.summary_length.get() * 1.2)}字详细总结文本,保留重要细节和上下文。"

else: # balanced

system_prompt = f"请用大约{self.summary_length.get()}字准确总结文本要点,保持简明扼要的风格。"

对于精炼型风格,目标字数被降低到用户选择的80%,同时指示模型去除冗余。对于详细型风格,目标字数被提升到120%,同时要求保留细节。对于均衡型,则直接使用用户选择的字数。这个灵活的提示设计使系统能够通过调整指令来改变大模型的行为。

构建消息时,系统遵循了一个标准的对话格式。首先是系统角色的消息,包含摘要指令。然后是用户角色的消息,包含待处理的文本:

messages = [

{

"role": "system",

"content": system_prompt

},

{

"role": "user",

"content": f"请总结以下文本:\n\n{text}"

}

]

这个消息格式与现代的大语言模型API兼容,它清楚地区分了系统指令和用户输入。

完整的API请求被构建为一个JSON对象,包含头部信息、参数配置和负载数据:

data = {

"header": {

"app_id": self.app_id,

"uid": "user123"

},

"parameter": {

"chat": {

"domain": self.domain,

"temperature": 0.5,

"max_tokens": min(self.summary_length.get() * 3, 8192),

"top_k": 4

}

},

"payload": {

"message": {

"text": messages

}

}

}

这个结构中,temperature参数控制了大模型输出的多样性。0.5是一个中等的值,它在创意和连贯性之间取得平衡。max_tokens参数设置了最大的输出令牌数,系统使用了一个公式min(self.summary_length.get() * 3, 8192)来计算这个值。之所以乘以3,是因为中文字符通常需要多个令牌来表示,这个乘数确保了系统有足够的令牌预算来生成完整的摘要。8192是一个上限,防止过度分配。top_k参数是另一个影响输出多样性的参数,值为4表示模型只考虑概率最高的4个候选词。

6.3 流式响应处理与实时更新

当WebSocket连接建立后,系统向服务器发送JSON格式的请求,然后进入一个等待响应的状态。不同于HTTP的一次性返回,WebSocket允许服务器多次推送响应。讯飞星火API利用这一特性,以流式的方式返回摘要,即每次只返回摘要的一个小片段。这种设计有两个主要好处:首先,用户可以实时看到摘要的生成过程,增强了交互性和透明度;其次,系统可以更早地开始处理响应,而不需要等待完整的摘要生成完毕。

在on_message回调中,系统接收并解析每一个服务器返回的消息:

def on_message(ws, message):

try:

data = json.loads(message)

code = data['header']['code']

if code != 0:

error_msg = f"请求错误: {code} - {data['header']['message']}"

self.root.after(0, lambda: self.handle_error(error_msg))

return

choices = data["payload"]["choices"]

status = choices["status"]

content = choices["text"][0]["content"]

self.summary += content

self.root.after(0, lambda c=content: self.update_summary_display(c))

if status == 2:

self.root.after(0, self.finish_generation)

ws.close()

except Exception as e:

self.root.after(0, lambda: self.handle_error(f"消息处理错误: {str(e)}"))

这个回调的逻辑相当直接。首先,它解析JSON消息。如果响应中的状态码不是0(0表示成功),则表示发生了错误,系统会调用错误处理器。否则,系统从响应中提取内容并将其添加到self.summary缓冲区。

一个细节需要注意的是self.root.after的使用。WebSocket的回调在后台线程中执行,不能直接修改UI(Tkinter的UI操作必须在主线程中进行)。self.root.after(0, callback)方法安排一个回调在Tkinter的主事件循环中尽快执行。通过这种方式,系统能够安全地从后台线程更新UI。

status字段表示这是否是最后一条消息。当status == 2时,表示摘要生成完毕。此时系统调用finish_generation方法进行清理,并关闭WebSocket连接。

6.4 异步安全的UI更新

update_summary_display方法负责在UI中展示新接收到的摘要片段:

def update_summary_display(self, content):

self.summary_text.config(state=tk.NORMAL)

self.summary_text.insert(tk.END, content)

self.summary_text.config(state=tk.DISABLED)

self.summary_text.see(tk.END)

这个方法首先临时将摘要文本框改为可编辑状态,然后插入新内容到末尾,最后再改回只读状态。这个改变状态的操作是必要的,因为文本框的初始状态是禁用的,无法直接插入文本。self.summary_text.see(tk.END)确保文本框自动滚动到最新的内容,这样用户在摘要不断增长时能够始终看到最新的部分。

7 高级功能与参数调优

7.1 三种摘要风格的实现与语言学基础

系统提供的三种摘要风格不仅仅是简单的长度变化,它们代表了不同的信息压缩策略和应用场景。精炼型风格(concise)专注于极致简洁,适用于用户需要快速了解核心观点的场景,比如快速浏览新闻标题或抓取报告的要点。均衡型风格(balanced)则是推荐的默认选项,它在保持简洁和保留细节之间取得平衡,适用于大多数通用场景。详细型风格(detailed)保留了更多的上下文和细节,适合学术研究或深度分析,用户可能需要理解文本的完整论证过程。

这三种风格在实现上的区别主要体现在两个方面。首先,目标字数不同——精炼型使用80%,均衡型使用100%,详细型使用120%。这确保了不同风格的摘要长度有显著的区别。其次,系统提示的措辞也不同。对于精炼型,提示明确要求"去除所有冗余信息",这会引导大模型在生成时更加严格地筛选信息。对于详细型,提示要求"保留重要细节和上下文",这会使大模型倾向于包含更多的补充信息。

从语言学的角度看,这三种风格对应了信息压缩的不同程度。极简摘要接近于一个标题或一句话的描述,标准摘要接近于传统的学术摘要,详细摘要接近于内容提要。通过调整系统提示和目标长度,系统实现了这些不同的风格,而无需改变底层的大模型。

7.2 动态长度控制与用户意图匹配

系统允许用户通过滑块在20到500字之间自由选择摘要长度。这个范围的下界和上界的选择都经过了考虑。20字是一个下界,因为任何更短的摘要可能太片段化,很难形成连贯的思想。500字是一个合理的上界,因为超过这个长度,摘要可能变成了缩短版的原文,而不是真正的摘要。这个可调节的长度选项给了用户最大的灵活性,他们可以根据实际情况选择合适的长度。

系统在实现中使用了一个公式来计算API请求中的max_tokens参数。这个参数限制了大模型的输出长度。使用min(self.summary_length.get() * 3, 8192)这个公式是有原因的。3这个乘数来自于一个经验规则:在中文处理中,一个汉字通常需要1到3个令牌来表示。通过乘以3,系统确保了token预算足够,大模型不会因为token限制而被迫截断输出。8192这个上限则来自讯飞星火Lite模型的最大token限制。

7.3 压缩率计算与质量评估

系统显示的压缩率公式是100 - (摘要字数 / 原文字数) * 100。这个指标虽然简单,但对于评估摘要的"浓缩程度"是有用的。一个高的压缩率(比如80%)表示摘要相对于原文要短得多,这在处理冗长文本时可能特别有用。一个较低的压缩率(比如30%)则表示摘要相对较长,可能保留了更多的原文信息。

不过,压缩率本身并不能直接衡量摘要的质量。一个高质量的摘要应该既能准确反映原文的核心内容,又能足够简洁。系统中计算压缩率的代码考虑了一个边界情况——当原文为空时,避免除以零错误:

compression_rate = 100 - int((summary_len / max(source_len, 1)) * 100)

这里使用了max(source_len, 1)来确保分母至少为1。这是一个小但重要的细节,它防止了程序在边界情况下的崩溃。

8 错误处理与系统稳定性

8.1 多层次的异常捕获与恢复

一个健壮的系统需要在多个层次上处理可能出现的错误。本系统的错误处理包括几个不同的层次。首先,在文件操作层次,系统捕获UnicodeDecodeError来处理编码问题,如前所述。其次,在WebSocket操作层次,系统定义了on_error回调来处理连接层面的错误。第三,在消息处理层次,系统在on_message中使用try-except块来捕获JSON解析或其他处理错误。最后,在初始化层次,系统检查必要的依赖是否已安装。

在启动时,系统检查websocket模块是否可用:

try:

import websocket

except ImportError:

messagebox.showerror(

"依赖缺失",

"请先安装websocket-client:\npip install websocket-client"

)

exit(1)

这个检查确保了用户在运行程序前知道需要安装哪些依赖。

8.2 WebSocket连接失败的处理

当WebSocket连接失败时,on_error回调被调用。系统处理这个错误的方式是向用户显示一个错误消息,并调用handle_error方法进行清理:

def on_error(ws, error):

error_msg = f"WebSocket错误: {str(error)}"

self.root.after(0, lambda: self.handle_error(error_msg))

handle_error方法负责将错误信息显示在摘要结果区域,重置UI状态,并显示一个弹出对话框提醒用户:

def handle_error(self, error_msg):

self.summary_text.config(state=tk.NORMAL)

self.summary_text.delete("1.0", tk.END)

self.summary_text.insert(tk.END, f"❌ 错误: {error_msg}", "error")

self.summary_text.config(state=tk.DISABLED)

self.status_label.config(text="✗ 错误", foreground="red")

self.generate_btn.config(state=tk.NORMAL)

self.stop_btn.config(state=tk.DISABLED)

self.progress_label.config(text="")

messagebox.showerror("错误", error_msg)

这个处理流程确保了即使出现错误,系统也会回到一个一致的状态,用户可以继续使用其他功能。

8.3 用户中止操作的优雅处理

用户有时可能想要在摘要生成过程中停止操作。系统提供了一个"停止"按钮来支持这个需求。当用户点击这个按钮时,stop_generation方法被调用:

def stop_generation(self):

self.is_generating = False

if self.ws:

self.ws.close()

self.generate_btn.config(state=tk.NORMAL)

self.stop_btn.config(state=tk.DISABLED)

self.status_label.config(text="已停止", foreground="red")

self.progress_label.config(text="⏸️ 用户中止")

这个方法首先设置is_generating标志为False,然后关闭WebSocket连接。关闭连接会触发on_close回调,但由于is_generating已经被设置为False,它不会执行完成清理。接着,方法重新启用"生成摘要"按钮,禁用"停止"按钮,并更新状态标签以反映用户的中止操作。

这个设计体现了一个重要的原则:操作应该被随时中止,而不是被迫等待完成。在涉及网络操作的应用中,这个原则特别重要,因为网络延迟可能导致用户长时间等待。

9 实际应用与部署指南

9.1 环境配置与依赖管理

使用本系统的第一步是确保Python环境已正确配置。系统需要Python 3.6或更高版本,因为它使用了f字符串等现代Python特性。除了Python标准库外,系统只有一个额外的依赖:websocket-client。这可以通过pip轻松安装:

pip install websocket-client

对于使用虚拟环境的开发者(这是推荐的做法),可以先创建一个虚拟环境,然后在其中安装依赖:

python -m venv venv

source venv/bin/activate # 在Windows上使用 venv\Scripts\activate

pip install websocket-client

使用虚拟环境的好处是隔离项目的依赖,避免与系统全局的Python包冲突。

9.2 API密钥的安全管理

系统的使用需要有效的讯飞星火API密钥。在代码中直接硬编码这些密钥是不安全的做法,尤其是在将代码上传到公共版本控制系统时。一个更安全的做法是从环境变量读取这些密钥。修改后的代码可能看起来像这样:

import os

from dotenv import load_dotenv

load_dotenv()

self.app_id = os.getenv('SPARK_APP_ID')

self.api_secret = os.getenv('SPARK_API_SECRET')

self.api_key = os.getenv('SPARK_API_KEY')

然后在项目根目录创建一个.env文件(记住将其添加到.gitignore以避免意外提交):

SPARK_APP_ID=your_app_id

SPARK_API_SECRET=your_api_secret

SPARK_API_KEY=your_api_key

这种做法将敏感信息与代码分离,提高了安全性。

9.3 系统使用场景与扩展方向

本系统的当前实现面向单用户的本地应用场景。随着功能的完善,可能存在以下的扩展方向。首先,系统可以扩展为多窗口应用,允许用户同时处理多个文档。其次,系统可以添加一个摘要历史功能,记录用户生成的所有摘要,允许用户查看和比较。第三,系统可以集成更多的AI模型,而不仅仅是讯飞星火,给用户选择的自由。第四,系统可以开发一个Web版本,使用Flask或FastAPI作为后端,这样用户就可以从浏览器访问。

对于企业级的应用,系统可以进一步扩展为一个文档管理系统,支持批量摘要生成、摘要模板定制等功能。还可以集成数据库来存储用户信息和摘要历史。在安全方面,可以添加用户认证、访问控制、操作日志等功能。

9.4 使用工作流程与最佳实践

典型的使用工作流程如下。用户首先启动程序,系统呈现一个空的界面。用户可以选择打开一个文本文件或直接在文本框中输入内容。一旦文本被输入,用户可以调整摘要长度滑块和选择一个摘要风格。然后,用户点击"生成摘要"按钮,系统开始连接到讯飞服务器并生成摘要。在这个过程中,用户可以在摘要结果区域实时看到摘要的生成过程。摘要生成完毕后,用户可以查看压缩率和其他统计信息,如果满意,可以点击"保存摘要"按钮将其保存到文件。

为了获得最佳的摘要质量,用户应该注意以下几点。首先,输入文本的质量直接影响摘要的质量。如果输入文本本身就是不清楚或混乱的,那么生成的摘要也可能会是这样。其次,摘要长度的选择应该基于使用场景。对于快速浏览,20-50字是合适的。对于相对完整的理解,100-200字是合适的。对于深度理解,300-500字是合适的。第三,对于特别重要的内容,用户应该生成多个不同风格的摘要,然后比较它们,以确保没有遗漏重要信息。

10 深度技术细节讨论

10.1 令牌与字符的映射关系

在与大语言模型交互时,一个常常被忽视但又至关重要的概念是"令牌"(token)。在OpenAI的GPT模型中,一个令牌通常对应约4个英文字符。但对于中文,令牌与字符的映射关系是不同的。讯飞星火对中文的分词方式意味着一个汉字可能被分解为1到3个令牌,具体取决于字符的常见度和模型的训练方式。

这就是为什么系统在计算max_tokens时使用了乘数3。假设用户选择生成一个150字的摘要,系统会设置max_tokens为450。这个宽松的预算确保了即使中文字符的令牌成本较高,大模型也不会因为令牌限制而被迫截断输出。

理解这个映射关系对于优化系统性能是有帮助的。如果系统在某个地方总是生成不完整的摘要,可能的原因就是max_tokens的设置不合适。通过调整这个乘数,开发者可以在性能和准确性之间进行权衡。

10.2 温度参数与输出的多样性

在API请求中,系统设置了temperature: 0.5。这个参数控制了大模型输出的"随机性"或"创意度"。在LLM中,温度是一个在0到1(有时甚至更高)之间的参数。当温度接近0时,模型趋向于每次都选择概率最高的下一个词,导致输出高度确定性但可能单调。当温度接近1时,模型的选择更加多样化,可能导致输出更加创意但也可能不连贯。

对于摘要生成这个任务,0.5是一个合理的选择。它不会导致输出过于僵化(这可能导致摘要读起来不自然),也不会导致过度创意(这可能导致摘要偏离原文的意思)。如果系统的用户反馈表明摘要的表述总是非常相似,可以考虑提高温度到0.7。相反,如果用户发现摘要有时包含与原文不符的内容,可以考虑降低温度到0.3。

10.3 Top-K采样与输出质量

另一个影响输出的参数是top_k: 4。这个参数使得模型在生成下一个词时,只考虑概率最高的K个候选词。在这个系统中,K被设置为4,意味着模型只考虑概率最高的4个词。

这个参数的作用是减少"幽灵词"的出现——即那些概率很低但仍然会被选中的词。通过限制候选词的数量,系统可以提高输出的一致性和相关性。对于摘要这个任务,一个相对较小的K值(如4)是合适的,因为摘要应该是相对固定和明确的,而不是高度发散的。

11 性能分析与优化建议

11.1 响应时间的瓶颈分析

系统的总响应时间可以分为几个阶段。首先是身份认证和连接建立,这通常需要1-2秒。其次是API请求的往返时间,这依赖于网络条件和讯飞服务器的负载。第三是大模型的推理时间,这取决于输入文本的长度和所请求的摘要长度。最后是数据传输和UI更新的时间。

在这些阶段中,大模型的推理时间通常是最长的。对于一个1000字的文本,生成一个100字的摘要可能需要5-10秒。对于更长的文本或更长的摘要,时间会相应增加。这就是为什么系统在后台线程中执行这个操作,并提供了一个停止按钮。

如果性能优化是一个优先级,可以考虑以下策略。首先,可以在客户端进行一个初步的文本处理,移除不必要的停用词或长的重复段落。其次,可以使用缓存来存储常见文本的摘要,避免重复处理。第三,可以提供一个"快速模式",它使用较短的最大令牌数和较低的生成质量标准,但会更快地返回结果。

11.2 内存使用与大文本处理

当处理非常大的文本(比如一本书的内容,可能有数十万字)时,系统的内存使用可能变成一个问题。当前的实现将整个文本加载到内存中,这对于大多数现代计算机来说应该不是问题,但对于极端的情况可能是。

一个可能的优化是实现分块处理。系统可以将大文本分成多个较小的块,分别生成摘要,然后将这些摘要进行二级摘要(生成摘要的摘要)。这种方法在处理长文档时是标准的做法,可以在保持质量的同时大幅减少处理时间和内存使用。

11.3 网络连接的鲁棒性

在不稳定的网络环境中,WebSocket连接可能会被中断。当前的实现在连接中断时会调用on_close回调,但没有自动重连机制。对于生产环境的应用,可以添加一个指数退避重连策略,即第一次重连延迟1秒,第二次2秒,第三次4秒,以此类推,直到达到最大延迟。这可以使系统在网络波动时更加稳定。

import time

class ReconnectWebSocket:

def __init__(self, url, callbacks, max_retries=5):

self.url = url

self.callbacks = callbacks

self.max_retries = max_retries

self.retry_count = 0

self.connect()

def connect(self):

try:

self.ws = websocket.WebSocketApp(

self.url,

on_message=self.callbacks['on_message'],

on_error=self.callbacks['on_error'],

on_close=self.on_close,

on_open=self.callbacks['on_open']

)

self.ws.run_forever()

except Exception as e:

if self.retry_count < self.max_retries:

delay = 2 ** self.retry_count

time.sleep(delay)

self.retry_count += 1

self.connect()

这样的实现可以使系统在暂时的网络问题时自动恢复。

12 安全性与隐私考量

12.1 数据传输的加密

系统使用了wss协议(WebSocket Secure),这意味着所有数据传输都经过TLS加密。这是业界标准做法,确保了在传输过程中用户的文本内容不会被第三方窃听。然而,需要注意的是,这个加密仅覆盖传输层。一旦数据到达讯飞的服务器,它可能被存储、日志记录或用于模型改进。用户应该意识到,通过这个系统处理的任何敏感信息都不应该包含机密内容。

12.2 API密钥的保护

如前所述,将API密钥硬编码在代码中是危险的。但即使使用环境变量,用户也应该小心。在分享代码时,确保.env文件不被包含。在配置CI/CD管道时,应该使用密钥管理服务(如AWS Secrets Manager或Azure Key Vault)而不是在代码或配置文件中存储密钥。

此外,定期轮换API密钥也是一个好做法。讯飞可能提供了一个API管理界面,用户可以在其中生成新的密钥并撤销旧的密钥。

12.3 本地数据的保护

系统保存的摘要文件默认以纯文本方式存储。虽然这使得摘要易于访问和分享,但它意味着任何获得该文件的人都可以读取其内容。对于包含敏感信息的摘要,考虑添加一个加密选项可能是有益的。Python的cryptography库可以用于此目的:

from cryptography.fernet import Fernet

# 生成密钥(仅需执行一次,然后保存)

# key = Fernet.generate_key()

# 要从保存的密钥加载

key = b'...' # 从安全的地方加载

cipher_suite = Fernet(key)

# 加密

encrypted_text = cipher_suite.encrypt(summary.encode())

# 解密

decrypted_text = cipher_suite.decrypt(encrypted_text).decode()

但这增加了系统的复杂性,用户需要管理加密密钥。这种权衡应该基于应用的具体需求来决定。

13 测试与质量保证

13.1 单元测试的设计

虽然系统的当前实现没有包含单元测试,但添加测试对于提高代码质量是有益的。关键的测试用例应该包括:URL签名的正确生成、API请求的正确构建、响应解析的正确处理、各种编码的文件读取、摘要统计的准确计算等。

例如,一个测试URL签名生成的函数可能看起来像这样:

import unittest

class TestSparkSummarization(unittest.TestCase):

def setUp(self):

self.app = SparkSummarizationGUI()

def test_websocket_url_generation(self):

url = self.app.create_websocket_url()

self.assertTrue(url.startswith('wss://'))

self.assertIn('authorization=', url)

self.assertIn('date=', url)

self.assertIn('host=', url)

def test_empty_text_handling(self):

# 测试空文本或过短文本的处理

self.app.source_text.insert("1.0", "短")

with self.assertRaises(Exception):

self.app.generate_summary()

if __name__ == '__main__':

unittest.main()

13.2 集成测试的场景

集成测试应该模拟真实的用户交互流程。一个完整的集成测试可能包括:打开一个文本文件、调整摘要参数、生成摘要、保存摘要,然后验证保存的文件内容的正确性。这种测试可以使用像Selenium这样的自动化工具来实现,但对于Tkinter应用,测试可能需要使用像pyautogui这样的屏幕控制库来模拟用户输入。

13.3 用户验收测试

最终,系统应该经过真实用户的验收测试。用户的反馈可能揭示一些在实验室环境中没有发现的问题或改进机会。收集用户反馈的方法包括问卷调查、可用性研究、社交媒体监控等。

14 总结与展望

14.1 系统的核心成就

本文详细介绍的讯飞星火文本摘要系统展现了现代AI应用开发的多个关键方面。从技术架构的角度,系统成功地整合了WebSocket通信、异步编程、大语言模型API调用等现代技术。从用户体验的角度,系统提供了直观的界面、实时的反馈和灵活的选项。从工程实践的角度,系统展现了错误处理、资源管理、安全考量的重要性。

系统实现了流式摘要生成,使用户能够实时看到摘要的生成过程,而不是被迫等待最终结果。系统支持多种摘要风格和灵活的长度控制,满足了不同用户的不同需求。系统完美处理了中文文本和多种文件编码,这在处理中文用户的应用中是至关重要的。

14.2 技术的学习价值

对于Python开发者,特别是那些想要学习现代AI应用开发的人,本系统提供了多个学习机会。首先,它展示了如何与第三方API(特别是通过WebSocket)集成。其次,它展示了在GUI应用中处理长时间运行的异步操作的正确方式。第三,它展示了如何处理实际应用中常见的问题,如文件编码、中文路径、错误处理等。

14.3 未来的发展方向

从当前的实现出发,系统可以沿着多个方向发展。在功能方面,可以添加对其他讯飞API(如机器翻译或语音转文字)的支持,使系统成为一个更全面的工具套件。在性能方面,可以实现分块处理大文本、自动重连等优化。在用户体验方面,可以添加摘要历史、书签、导出多种格式等功能。

在实际应用层面,系统可以被部署为一个企业级的文档处理平台,集成到企业的数据管理流程中。它可以用于自动生成新闻简报、学术论文摘要、合同总结等。随着大语言模型技术的继续发展,系统的摘要质量也会随之提升,无需更改应用代码。

14.4 AI应用开发的思考

本系统的开发也反映了现代AI应用开发的一些通用原则。首先,选择合适的技术栈是至关重要的。WebSocket虽然比REST API更复杂,但对于这个应用是最合适的。其次,将复杂的异步操作管理好是实现良好用户体验的关键。第三,即使是一个相对简单的应用,也需要考虑安全性、隐私、错误处理等方面。最后,用户的反馈和真实世界的使用场景应该指导开发的方向。

随着AI技术的普及,越来越多的应用将整合AI能力。本文介绍的系统是这一趋势的一个缩影。通过理解系统的设计和实现,开发者可以更好地应对这个AI驱动的时代。

2505

2505

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?