目录

一、从 GPT-5.1、Claude Opus 4.5、Gemini 3 看“多模态理解”的新起点

二、为什么 2025 年大家突然都在卷“视频 + 3D + 语音”?——来自市场和场景的双重挤压

四、3D 维度:Gaussian Splatting 引爆的“空间理解”军备竞赛

五、语音维度:从 Whisper v3 到新一代 ASR 榜单

六、如何在一个产品里把“视频 + 3D + 语音”真正接到最新大模型上?

七、从“多模态模型”到“多模态 Agent”:未来的战场不止是参数和榜单

结语:2025 年之后,多模态不再是“加个图片接口”那么简单

在 2025 年这波大模型更新潮里,有一个非常微妙但巨大的转折点:你会发现,大家嘴里说的“最强模型”,已经不再只是纯文本的“会聊天”,而是统一指向了“会看视频、懂三维、听得懂人话还能开口说”的那一批。OpenAI 推出 GPT-5.1 系列,主打更强的多模态理解和更复杂的推理;Anthropic 给 Claude 家族上了全新的 Claude Opus 4.5,自称是“当前世界上在编码、Agent 和电脑使用上最强的模型”;Google DeepMind 则用 Gemini 3 Pro/Gemini 3 Pro Image 打造了一个从文本、图像到视频、音频都能统一处理的多模态旗舰。(OpenAI)

与此同时,咨询公司和投行的报告里,一个新细分词频繁出现:多模态 AI。Grand View Research 估计 2024 年多模态 AI 市场大约 17.3 亿美元,到 2030 年可达 108.9 亿美元,复合增速在 36% 左右;其它机构给出的数字略有差异,但都一致指向一个结论:这是一个刚刚从科研小圈子起跳、即将进入“狂飙期”的赛道。(Grand View Research)

如果你把 GPT-5.1、Claude Opus 4.5 和 Gemini 3 Pro 放在一起,会发现一个有趣的共性:它们都不再满足于只看静态图片,而是要“看得懂视频里的时间、抓得住 3D 世界的空间、听得清人类真实的语音”。这背后是一场非常现实的“算力与场景的共谋”:视频是当代互联网最大的数据形态,3D 是下一代空间计算与 XR 的基础,语音则是所有自然交互系统最直接的入口。这三者和大模型一旦真正捏到一起,你手里拿的就不再是一个聊天机器人,而是一个“带眼睛、带耳朵、带空间感”的数字劳动力。

一、从 GPT-5.1、Claude Opus 4.5、Gemini 3 看“多模态理解”的新起点

在 2025 年以前,很多人讨论大模型的时候,脑海里其实还是一个“巨大的文本预测引擎”。而现在,在各家的最新版模型说明里,“多模态”和“Agent”几乎成了必备关键词。OpenAI 在 GPT-5.1 的介绍中,强调其在视觉、视频、空间和科学推理上的表现,目标是让 ChatGPT 更准确地理解图像和其他非文本输入,并且在对话中更自然地调用这些能力;同时推出的 GPT-5.1 Thinking 与 Instant 两个系列,一个偏重深度推理,一个偏重响应速度,共同支撑起多模态场景。(OpenAI)

Anthropic 在 2025 年 11 月发布 Claude Opus 4.5 时,直接把它称为“目前在编码、Agent 和电脑使用上最强的模型”,强调它在复杂代码生成、多步骤自动化工作流、电子表格和幻灯片操作上的能力;官方博客和媒体评测普遍提到,它在真实办公任务上比前代模型更稳定、更擅长长链路任务,甚至在内部两小时工程 take-home 测试里超过了所有人类候选者。(Anthropic)

Google 则通过 Gemini 3 系列明确要在“多模态 + 推理”上夺回话语权。Google 官方介绍中,把 Gemini 3 定位为“目前最智能的模型”,强调在开发者工具中的深度、可靠性以及相对前代 Gemini 2.5 Pro 超过 50% 的基准任务解决率提升;同时给出 Gemini 3 Pro 高达百万 Token 级的上下文窗口,用来支撑长视频、多文档甚至代码库级别的推理。Gemini 3 Pro Image(内部代号 Nano Banana Pro)则在图像生成和编辑上强调“更准确的文本渲染和世界知识”,为多模态产品线补上创作环节。(blog.google)

如果把这三家最新模型拉成一张简化的对比表,你会更直观地看到“多模态理解”的新起点长什么样。

表 1 代表性通用多模态基座模型(2025)

| 模型 | 发布机构 | 官方发布时间(2025) | 主要多模态范围 | 官方强调能力要点 |

|---|---|---|---|---|

| GPT-5.1 / GPT-5.1 Thinking & Instant | OpenAI | 11 月中旬逐步向付费用户开放 | 文本、图像、视频、语音 | 更强的多模态推理、更自然对话风格、可定制人格,支持复杂图表/视频理解和长链推理工作流 (OpenAI) |

| Claude Opus 4.5 | Anthropic | 11 月 24 日 | 文本、多种工具调用(含文件、表格等),图像支持在持续增强 | 对编码、Agent 和电脑使用“世界最强”,在深度研究、幻灯片与电子表格处理上显著提升,适合作为企业级数字员工 (Anthropic) |

| Gemini 3 Pro / Gemini 3 Pro Image | Google DeepMind | 11 月 18 日 | 文本、图像、视频、音频,强化代码与规划推理 | 相比 Gemini 2.5 Pro 在开发者基准上提升 50% 以上,提供百万级上下文和 Deep Think 模式,多模态视频理解与图像生成/编辑能力显著增强 (blog.google) |

【图 1:三大模型多模态能力雷达图示意】

这三大模型的“共同升级方向”其实就是今天这篇文章的主线:如果说 2023~2024 年的多模态还主要停留在“看图说话”的阶段,那么 2025 年的新一代旗舰模型,已经明显在围绕“视频 + 3D + 语音”这个组合做系统性强化——它们要的不是一两个 demo,而是从底层架构到工具生态都跟这些模态深度绑定。

二、为什么 2025 年大家突然都在卷“视频 + 3D + 语音”?——来自市场和场景的双重挤压

很多人会有一个直觉:视频太大、3D 太复杂、语音太嘈杂,这些东西丢给大模型是不是有点“吃力不讨好”?但资本市场和行业报告的态度恰好相反——它们用一连串的数字表明:真正能带来新一波增长的,很可能就是这三类模态交织出的复合场景。

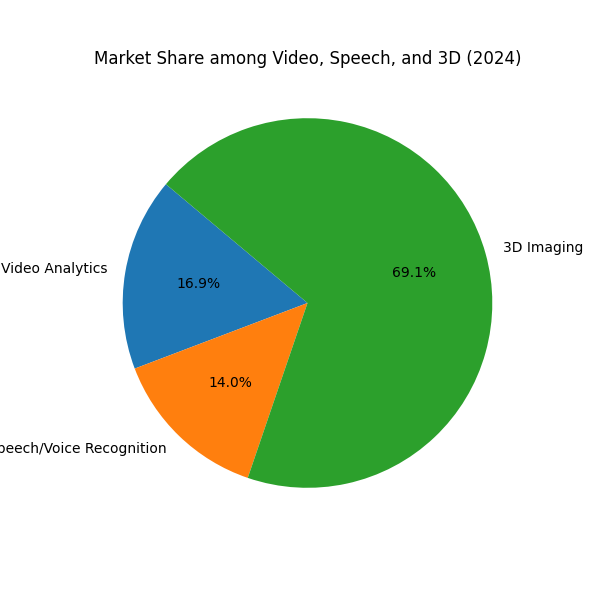

Grand View Research 把多模态 AI 的市场规模从 2024 年的约 17.3 亿美元测算到 2030 年的 108.9 亿美元,CAGR 约 36.8%;另外有研究机构预估 2025 年多模态 AI 市场约 23~25 亿美元,到 2034~2035 年有望冲到 400 亿到 550 亿美元区间,复合增速大致都在 36%~37% 的高位。(Grand View Research)

这意味着什么?意味着哪怕你只看宏观数字,单模态的增长空间已经开始受限,而多模态恰好是下一阶段的增量来源。下面这张表把几家机构的预测压在一起,你会更容易感受到这个趋势。

表 2 2024–2035 年全球多模态 AI 市场规模与增速(部分机构预测对比)

| 机构 | 基准年份与规模 | 目标年份与规模 | 预测复合增速(约) | 备注 |

|---|---|---|---|---|

| Grand View Research | 2024 年约 17.3 亿美元 | 2030 年约 108.9 亿美元 | 36.8%(2025–2030) (Grand View Research) | 强调视频、图像、语音等多种数据源融合在医疗、零售、交通等行业的应用 |

| Research Nester | 2025 年约 23.5 亿美元 | 2035 年约 555.4 亿美元 | 37.2%(2025–2035) (Research Nester) | 提到到 2035 年多模态 AI 将在自动驾驶、辅助诊断和智能制造中成为基础设施 |

| Precedence Research | 2025 年约 25.1 亿美元 | 2034 年约 423.8 亿美元 | 36.9%(2025–2034) (Precedence Research) | 强调零售和医疗行业是当前采用多模态 AI 的主要驱动力 |

| Global Market Insights | 2024 年约 16 亿美元 | 2034 年规模接近 400 亿美元 | 32.7%(2025–2034) (Global Market Insights Inc.) | 把多模态 AI 视为传统 AI 向“类人感知”演进的关键一跃 |

| SNS Insider | 2024 年约 16.4 亿美元 | 2032 年约 205.8 亿美元 | 37.3%(2025–2032) (SNS Insider) | 特别强调金融、客服和安防监控场景中的视频+语音融合分析需求 |

虽然各家机构给出的绝对数字略有差异,但增速非常一致,都认为这是一个“30%+ CAGR、十年后规模翻十几倍”的赛道。更重要的是,这些报告在细节里不断提到三个高频关键词:视频理解、三维空间感知、语音交互。这些能力分别对应着自动驾驶与智慧城市、XR 与空间计算、企业级客服与知识工作辅助等高价值场景,而这些场景本身又被 McKinsey 等机构列在 2025 年最重要的技术趋势交汇处,和算力、边缘计算、沉浸式现实技术一起,构成未来数年的创新主轴。(McKinsey & Company)

如果再把镜头拉回具体技术生态,你会发现,在视频、3D、语音这三个方向上,近两年都出现了非常明确的“质变时刻”:OpenAI 的 Sora、Google 的 Veo 2 把文本生成视频从玩具级 demo 推向接近专业制作的质量;3D Gaussian Splatting 被业内人士称为“空间计算的 JPEG 时刻”,重塑了 3D 扫描与实景重建的效率;Whisper large-v3、OWSM v3.1 以及各种基于大模型的 ASR 系统则把语音识别的准确率拉到可以覆盖大多数业务场景的水平。(斯坦福HAI)

这也是为什么 2025 年会出现一个很强的直觉:如果你的多模态故事还停在“看图说话”,那几乎可以视为“上一代产品”了;真正的增量,来自能把视频、3D 和语音统一整合的系统。

三、视频维度:从文本生成视频到视频理解基座

视频之所以是这场多模态大战的主战场,很大程度上是因为它天然包含了丰富的时间信息和语义密度。一个一分钟的视频,往往相当于几百张图片和几千字脚本的综合体。只要模型能够稳定地在时间维度上“看得懂”,你就拥有了一个远比静态图像更强大的“现实世界传感器”。

从 2024 年底到 2025 年,视频生成模型经历了几次标志性发布。OpenAI 的 Sora 在 2024 年年底正式面向部分用户开放,根据 Stanford AI Index 2025 报告的描述,它可以生成长达 20 秒的 1080p 视频,并面向 ChatGPT Pro 用户提供了更长时长和更高分辨率的版本。(斯坦福HAI) 另一方面,Google DeepMind 在 2024 年底推出的 Veo 2 被多篇评测认为在提示词遵从、物理一致性和 4K 视频质量上超越了同代竞争对手,尤其是在复杂摄影机运动、镜头焦段和电影感表现上表现突出。(Analytics Vidhya)

然而,真正让“视频 + 大模型”在 2025 年变成基础能力的,并不是炫目的 Demo,而是视频理解基准与通用模型的能力对齐。MVBench 这样的多模态视频基准提出了 20 种需要时间理解的任务,专门考察模型对动作顺序、因果关系、遮挡与长时间依赖的把握;相比只看单帧图片的评测,这一类 benchmark 让大模型必须在“理解一个几秒甚至几十秒的视频里到底发生了什么”这件事情上认真下功夫。(arXiv)

在最新一代通用模型里,GPT-5.1、Claude Opus 4.5 和 Gemini 3 Pro 都明确强调了“长视频理解”和“多步推理”的结合。OpenAI 在 GPT-5.1 的介绍里提到,它在视频基准上有显著提升,能够更可靠地结合视频和文本进行推理;Google 则强调 Gemini 3 在开发者工具中可以处理长上下文任务,对视频片段进行检索、总结和代码生成;部分第三方评测也在比较 GPT-5.1-Codex-Max 与 Gemini 3 Pro 在代码与多模态基准上的差异。(OpenAI)

下面这张表可以当作一个小小的“视频维度扫盲表”。

表 3 代表性视频生成与理解系统一览(截至 2025 年)

| 名称 | 类型 | 发布机构 | 关键能力点 | 与“视频 + 多模态理解”的关系 |

|---|---|---|---|---|

| Sora | 文本生成视频 | OpenAI | 支持最高 20 秒 1080p 视频生成,强调物理一致性和细节表现,面向 ChatGPT Pro/Plus 用户分级开放 (斯坦福HAI) | 更多用于内容创作,但也为多模态模型提供了“反向”监督信号,帮助理解复杂场景下的物体运动和镜头语言 |

| Veo 2 | 文本生成视频 | Google DeepMind | 能生成 4K 级别高质量视频,强调对复杂提示、摄影机语言和现实物理的遵从,在多项评测中被认为优于同代对手 (Analytics Vidhya) | 不仅是生成工具,更逐步与 Gemini 系列在多模态层打通,为视频搜索与理解提供强大的合成与对比数据 |

| MVBench | 视频理解基准 | 学术界 | 覆盖 20 类需要时间建模的视频任务,从动作识别到高层次理解,采用多选题形式 (arXiv) | 成为评估通用多模态模型视频理解能力的“通货”,迫使 GPT-5.1、Gemini 3 等在时间建模上持续投入 |

| GPT-5.1(含 Codex-Max) | 通用多模态 + 代码 | OpenAI | 在视觉、视频、空间推理上提升明显,可以结合视频、文本和代码完成复杂任务;Codex-Max 面向项目级编码和 Agent 场景 (OpenAI) | 越来越多地被用来做视频内容分析、字幕生成与自动剪辑脚本编写,是“视频理解 + 自动化工具链”的中枢 |

| Gemini 3 Pro | 通用多模态 | Google DeepMind | 提供百万级上下文窗口和 Deep Think 模式,支持长视频、多文档与代码库同时推理,在开发者基准上较 Gemini 2.5 Pro 提升 50%+ (Google DeepMind) | 被广泛定位为“长上下文视频与多文档理解”的基础设施,可以用于视频检索、语义切片和多源数据融合分析 |

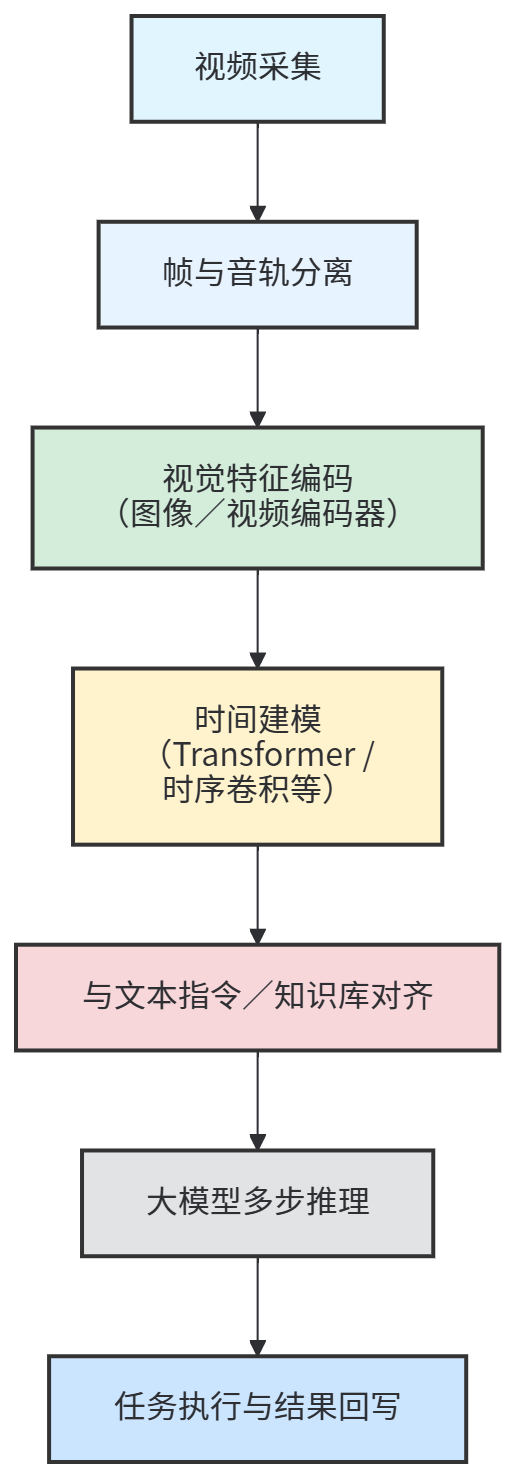

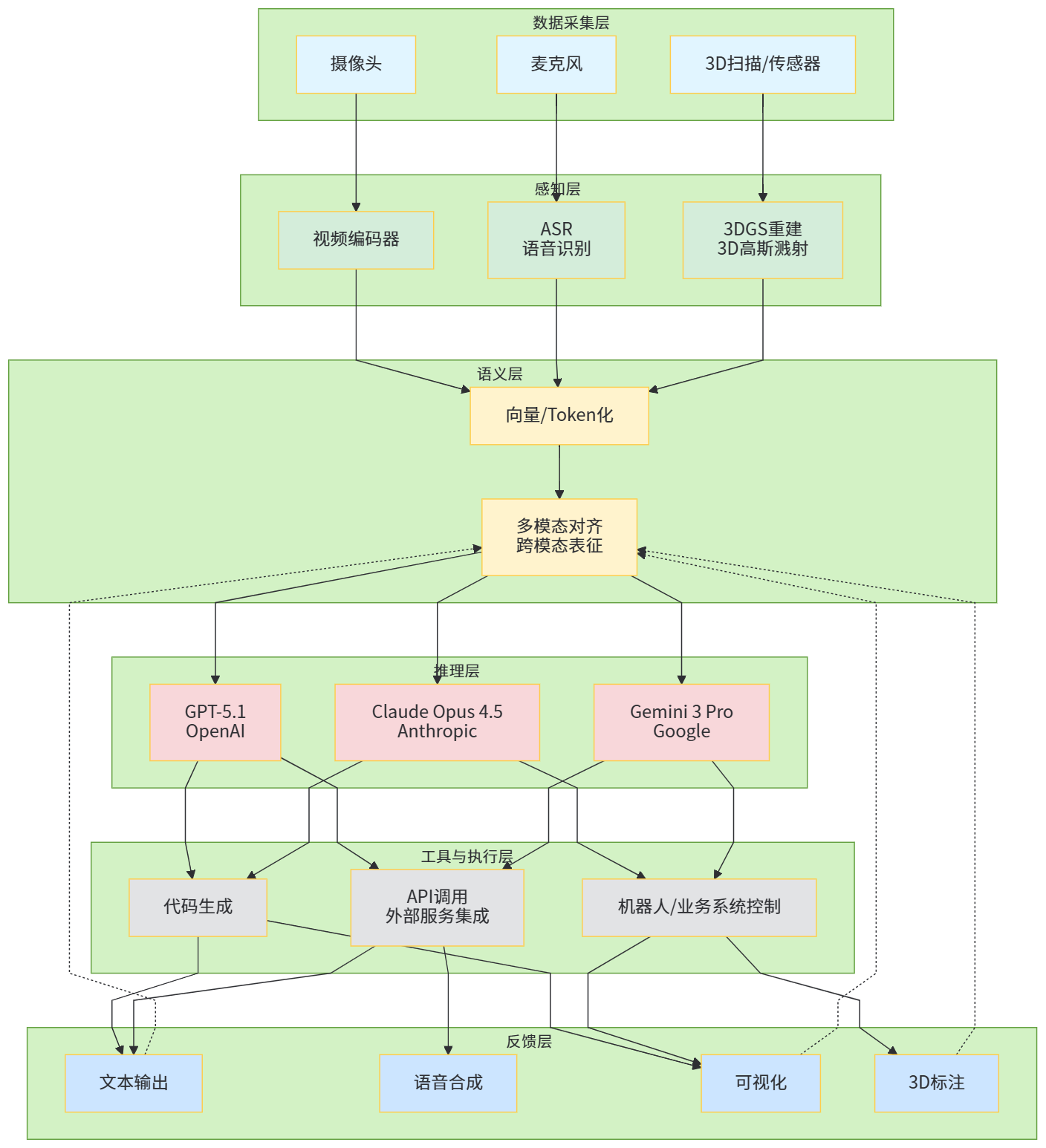

在工程实践中,围绕视频的多模态理解通常会形成一条相对稳定的流水线,从原始视频采集、关键帧与音频分离,到多尺度特征抽取、时间建模,再到与文本、代码、业务逻辑的融合。

在这条流水线里,GPT-5.1、Claude Opus 4.5 和 Gemini 3 Pro 更多扮演的是“高级统筹者”和“最后的推理单元”:它们通常不会自己直接处理原始视频,而是接收来自专门的视频编码器、ASR 模型或者稀疏描述,然后在一个统一的语义空间里完成跨模态推理和决策。这种分工让系统既能保留视频模态的丰富性和精准性,又能利用大模型强大的泛化与逻辑能力,是 2025 年多模态系统架构的主流做法。

四、3D 维度:Gaussian Splatting 引爆的“空间理解”军备竞赛

如果说视频让模型看到了“时间”,那么 3D 则让模型第一次真正“摸到空间”。过去几年里,3D 重建和渲染领域经历了一次堪比 ImageNet 之于图像的技术跃迁:3D Gaussian Splatting(3DGS) 这种新表示在 2023 年被提出之后,迅速成为高质量新视角合成和实时渲染的核心方案,被多个评测和从业者称为“空间计算的 JPEG 时刻”。(NIPS 论文)

媒体报道中提到,Niantic 等公司已经在自家 Scaniverse 应用里大规模采用 Gaussian Splatting 技术,实现更高保真度的 3D 扫描;Meta、Google、Snap 等巨头也在 AR/VR 平台里集成相关技术,用于构建更真实的虚拟环境。(The Verge) 这使得 3D 不再只是离线渲染和游戏引擎里的专业玩具,而逐渐变成一种可以被普通用户在手机上触达的“扫描→编辑→分享”的日常能力。

在学术侧,围绕 3DGS 的研究以惊人的速度推进。NeurIPS 2024、CVPR 2024 及之后的一系列论文,对高效人像新视角合成、稀疏视图重建、法线参与的高质量渲染、通用场景重建等方向做了大量探索;2025 年还有工作专门针对“单视图可泛化 3D 重建”,尝试从一张图片中重构可渲染的三维场景。(NIPS 论文)

我们可以用一张表来粗略梳理一下 3DGS 相关研究与应用的谱系。

表 4 3D Gaussian Splatting 相关研究与应用概览(节选)

| 类别 | 代表性工作 / 产品 | 核心贡献或能力 | 与多模态“视频 + 3D + 语音”的关系 |

|---|---|---|---|

| 基础方法 | 3D Gaussian Splatting(Kerbl 等)及后续改进 | 以高斯云而非网格表示场景,支持高质量新视角合成和实时渲染,成为 3D 重建的新范式 (NIPS 论文) | 为大模型理解真实世界的空间结构提供了高效的底层表示,可以把视频帧、深度信息和 3D 点云统一映射到一个可渲染的空间 |

| 实时人物与人-场景重建 | EVA-Gaussian、GPS-Gaussian+ 等 | 面向多视图人体和人-场景的实时新视角合成,在虚拟直播、XR 社交和数字人制作中非常关键 (开放评论) | 让“数字分身”从单纯的 2D 头像升级为真正的三维实体,为语音驱动、行为驱动的多模态交互提供了空间载体 |

| 单视图 3D 重建 | SVG3D 等基于 3DGS 的单幅图像重建方法 | 尝试从一张图片中恢复可投影的三维结构,为轻量级 3D 内容创作提供可能 (Nature) | 降低 3D 内容创作门槛,结合大模型对图像与文本的理解,可以在“拍一张照 + 说几句话”的交互下自动生成可用 3D 资产 |

| 商业应用与平台 | Niantic Scaniverse、Meta 与其他 XR 平台的 Gaussian Splatting 支持 | 把 3DGS 集成到消费级应用里,让用户通过手机完成高质量 3D 扫描和分享,被称为“空间计算的 JPEG 时刻” (The Verge) | 为 XR、多模态搜索和数字孪生提供了真实世界 3D 数据的采集入口,大模型可以在此基础上做语义理解和任务规划 |

当我们把 3D 与最新一代大模型一起看时,真正有趣的地方在于:大模型开始拥有了理解“空间”和“视角”的可能。在传统的文本模型里,空间知识往往通过描述性语句间接编码,比如“桌子上有一本书,书旁边有一杯水”之类;而在 3DGS 等三维表示配合视频/图像编码器的场景下,模型可以直接接触到一个可以自由旋转的三维场景,并在此基础上进行推理——例如“从门口视角看不到桌上的杯子,但从窗户方向可以看到”,这种遮挡和视角依赖性的推理在三维空间里要自然得多。

这也解释了为什么 XR、空间计算和多模态交互的论文和报告在 2022–2024 年间密集出现,Review 工作普遍认为 AI 驱动的自然交互已经成为 XR 的核心技术之一。(arXiv) 在 2025 年的现实工程里,把 GPT-5.1、Claude Opus 4.5 或 Gemini 3 Pro 摆在一个有 3DGS 支撑的 XR 场景中,就可以做出非常新颖的产品形态:用户戴着头显在虚拟空间走动,用语音和手势与一个“真的站在你面前、能理解空间布局”的 AI 助手对话,它不仅能告诉你“某个设备的故障原因”,还可以指着三维模型里具体的位置说“你把这个阀门顺时针旋转 30 度”。

五、语音维度:从 Whisper v3 到新一代 ASR 榜单

相较于视频和 3D,语音在很多人印象里似乎已经是一个“老技术”了:传统 ASR 系统早就能在电话客服、语音输入法里跑得不错。但在多模态大模型时代,语音的重要性反而被放大了——因为它不再只是“把声音转成字”,而是成为连接人类真实意图、情绪和语境的最自然接口。

从模型侧看,OpenAI 的 Whisper large-v3 是这一波语音基础模型升级中的一个关键节点。根据 Hugging Face 上的模型卡描述,large-v3 相比 large-v2 在多种语言上降低了 10%~20% 的错误率,并在长音频与嘈杂环境下有更稳健的表现。(Hugging Face) 另一条开放路线则是 CMU 等机构推出的 OWSM v3.1,它在多项评测基准上超过前代模型,并且在推理速度上提升了最多 25%,同时强调开放训练脚本和数据准备流程,以提高可重复性和透明度。(WAVLab)

更有意思的是,Hugging Face 的 Open ASR Leaderboard 这类排行榜已经把很多基于大模型架构的 ASR 系统纳入比较。例如,2025 年 10 月的一篇综述提到,NVIDIA 的 Canary Qwen 2.5B 在英语转录任务上以约 5.63% 的词错误率跑到榜首,这类系统通过引入更强的语言建模和上下文理解能力,在准确率上明显领先传统端到端 ASR。(Winsome Marketing)

我们可以把代表性语音模型整理成一张表,作为“语音维度”的快速全景。

表 5 代表性语音/ASR 基础模型与系统(节选)

| 模型 / 系统 | 发布方 | 核心特点 | 代表性指标 / 亮点 | 与 GPT-5.1、Claude Opus 4.5、Gemini 3 的关系 |

|---|---|---|---|---|

| Whisper large-v3 | OpenAI | 多语言通用语音识别模型,相比 large-v2 错误率降低 10%~20%,长音频与噪声鲁棒性更好 (Hugging Face) | 在多种公开数据集上的 WER 有显著下降,成为很多开源与商用语音管线的默认基座 | 常被用作 GPT-5.1 前端的语音转文本模块,配合 GPT-5.1 的语音对话接口,实现“听得懂”的多模态交互 |

| OWSM v3.1 系列 | CMU WAVLab | 开源 Whisper 风格模型,提供从 1 亿到 10 亿参数的多个版本,在多数评测基准上优于前代,同时推理速度提升可达 25% (WAVLab) | 展现出零样本上下文偏置等新兴能力,适合在需要透明训练流程场景中使用 | 常作为研究界构建多语种语音接口的基础,与通用大模型结合做语音助手、会议助手等 |

| NVIDIA Canary Qwen 2.5B | NVIDIA 等 | 基于大模型架构的 ASR 系统,在 Hugging Face Open ASR Leaderboard 英语榜单中以约 5.63% WER 领跑 (Winsome Marketing) | 在准确率上超过很多传统 ASR 引擎,但计算开销相对更高,体现了“准确率与速度”的典型权衡 | 可与 Gemini 3 或 Claude Opus 4.5 等模型组合,形成端到端语音 Agent,用于高价值电话场景 |

| 各家自研语音前端(如企业内 ASR 引擎) | 多家云厂商与独立团队 | 通常针对特定语言、领域做优化,例如医疗、金融、客服等行业,并与自家大模型打通 | 在特定领域词汇和口音上的表现往往优于通用模型 | 与 Claude Opus 4.5 和 GPT-5.1 的企业版集成后,可以实现高准确率的行业语音助手和流程自动化 |

在多模态理解的最终形态里,语音与视频、3D 之间并不是简单的“互不干涉”。一个典型的场景是这样的:用户戴着 XR 头显走进工厂车间,对着一台设备说“帮我检查一下这台机器最近有没有异常”,系统先用语音前端把这句话转成文本,送入 GPT-5.1 或 Gemini 3 Pro 等大模型解析意图,同时调取设备实时视频流及对应的 3D 结构模型;然后,模型一边根据语音意图在空间中定位“一台机器”,一边在视频画面里查找异常噪音和震动模式,最终给出一个带空间标注的诊断结果,并用自然语言反馈给用户。这种交互如果没有稳定的语音前端和强大的语言理解,就根本无从谈起。

六、如何在一个产品里把“视频 + 3D + 语音”真正接到最新大模型上?

说到这里,我们其实已经回答了一半“为什么 2025 年大家都在卷视频 + 3D + 语音”:因为市场、技术和应用都指向这里。但对工程师和架构师来说,更扎心的问题是:我如果现在要做一个多模态产品,要怎么把 GPT-5.1、Claude Opus 4.5 或 Gemini 3 Pro 真正接起来?

在大量 AI 工程实践中,一个比较主流的工程模式,是把通用大模型当作“多模态中枢”,而把视频编码器、3D 引擎、语音前端等看作一系列可替换的“感知插件”。系统可以被抽象成下面这样一条较长但清晰的链路。

在这套架构里,GPT-5.1、Claude Opus 4.5 和 Gemini 3 Pro 各自擅长的方向略有不同。GPT-5.1 与 GPT-5.1-Codex-Max 组合在长链路编码和 Agent 流程上非常强势,适合构建需要大量自动写脚本、调 API 的系统;Claude Opus 4.5 在代码和“用电脑”这个维度上拥有极强的表现力,适合作为“桌面级数字员工”,通过浏览器、Office 文档等完成复杂任务;Gemini 3 Pro 则在长上下文和开发者工具上表现突出,可以做跨长视频、多文档和代码库的统一分析。(OpenAI)

为了更直观,我们可以构造一张“落地视角”的小表,专门看看在几个典型行业里,“视频 + 3D + 语音 + 最新大模型”是如何组合的。

表 6 典型行业场景中的“视频 + 3D + 语音 + 大模型”组合方式

| 行业 / 场景 | 视频角色 | 3D 角色 | 语音角色 | 通用大模型(GPT-5.1 / Claude Opus 4.5 / Gemini 3)的角色 |

|---|---|---|---|---|

| 智能制造 & 工业运维 | 实时监控设备状态、检测异常动作或安全隐患,支持视频检索和事后回溯 | 用 3DGS 或 CAD 模型构建数字孪生,支持对设备结构和维护步骤的空间标注 | 工程师通过语音下达巡检、诊断与操作指令,系统以语音反馈结果 | 解析语音意图,融合视频与 3D 信息进行推理,生成结构化工单、维护步骤和安全提示,并可自动生成 PLC 脚本或操作清单 (NVIDIA Developer) |

| 自动驾驶 & 智慧城市 | 多传感器视频流用于道路环境理解和事件检测 | 通过 3D 地图和点云构建高精度环境模型 | 司机或调度员可通过语音发出指令或查询任务状态 | 把语音请求与视频/3D 感知结果结合,做路径规划、异常事件解释和策略生成,例如 GPT-5.1/Gemini 3 结合车端感知模块 (Grand View Research) |

| XR 培训与远程协作 | 录制或实时传输培训过程视频 | 使用 Gaussian Splatting 或其他 3D 表示重建培训环境 | 学员以语音提问,培训师或 AI 助手语音答复 | 在空间中理解学员位置与视角,通过大模型生成个性化讲解、步骤提示和考试题目,例如 Gemini 3 Pro 结合 XR 场景 (arXiv) |

| 客服与销售 | 录制用户使用产品的视频,分析行为与问题 | 在 3D 模型上标注产品结构,辅助解释复杂功能 | 通过电话或 App 内语音与用户对话 | 基于语音内容与产品使用视频分析用户意图,生成解决方案或推荐方案,Claude Opus 4.5/GPT-5.1 等负责自动生成话术和售后工单 (Anthropic) |

| 医疗影像与远程诊疗(受严格监管限制) | 通过内镜、超声等设备的视频进行辅助分析 | 结合 3D 解剖模型可视化病灶位置 | 医生与患者语音沟通病情与方案 | 在严格合规前提下,作为辅助工具对视频和 3D 模型做初步分析,并用自然语言生成报告草稿,但最终决策由医生做出 (Grand View Research) |

如果你从工程实现角度看,会发现一个有趣的现象:真正棘手的其实并不是单一模态本身,而是如何在统一的语义层里把所有模态对齐,并在大模型里进行一致的推理。 这就要求我们在架构上特别注意几个点:第一,所有来自视频、3D、语音的特征,在进入 GPT-5.1、Claude Opus 4.5 或 Gemini 3 之前,都要尽可能统一成一种“模型容易消费”的表示,比如文本描述、离散 Token 或低维语义向量;第二,在推理过程中,要让大模型“知道这些信息来自哪里”,例如通过特殊标记区分“这是 3D 空间坐标推理”还是“这是语音情绪分析”;第三,工具调用(Tool Use)与代码生成要深度整合,让模型可以在多模态信息的基础上真正“动手”,而不是仅仅输出一段解释性文字。

七、从“多模态模型”到“多模态 Agent”:未来的战场不止是参数和榜单

把视角拉回到开头提到的 GPT-5.1、Claude Opus 4.5 和 Gemini 3,我们会发现一个明显的趋势:它们都在有意识地从“模型”走向“Agent 平台”。OpenAI 在介绍 GPT-5.1 时强调的是更好的推理和更自然的对话体验,同时也持续扩展 Agent、工作流与自定义人格的能力;Anthropic 在 Claude Opus 4.5 的发布中,把重点放在“更强的编码和电脑使用能力”和“更可靠的多步骤工作流管理”上,很多评测都在讨论它在自动构建和维护 Agent 方面的优势;Google 则在 Gemini 3 中推出了 Deep Think 模式和开发者工具集成,为更复杂的自动化 Agent 工作流打地基。(OpenAI)

当这些模型与视频、3D、语音深度捆绑之后,战场自然从“谁在某个基准上多 2 分”转移到“谁真正在现实世界里更能干活”。这里至少有几个值得特别关注的方向。其一是多模态安全与对抗。Anthropic 在 Claude Opus 4.5 的系统卡中展示了大量关于 Agentic Coding 安全测试的数据:在 150 个恶意编码请求上实现了 100% 的拒绝率,但在某些恶意任务上拒绝率仍不足 90%,这说明在多模态 Agent 时代,如何防止模型在复杂视频/3D/语音场景中被诱导做危险动作,还是一个开放问题。(The Verge)

其二是评测方法的升级。Stanford AI Index 2025 等报告已经开始把 Sora 这类视频生成模型纳入新的技术性能章节,引入更多多模态和安全向的评测维度;在语音侧,Open ASR Leaderboard 等开源基准也在不断扩充任务和语言;在 3D 侧,Gaussian Splatting 相关论文和工业实践形成了一个紧密互动的共同体,技术演进速度被业内拿来和生成式 AI 做类比。(斯坦福HAI)

其三是跨模态长链路任务的标准化。无论是 GPT-5.1 的 Thinking 模式,还是 Gemini 3 的 Deep Think 模式,亦或是 Claude Opus 4.5 在编码和工具使用上的增强,本质上都是在回答同一个问题:在一个需要多次观测视频、反复查看 3D 模型、持续与用户语音对话的场景中,Agent 应该如何合理地规划和执行动作?这不是单个 benchmark 能说明白的,而更像是一个相当长的“剧本”——评测者需要写出一整套逼真的场景,让 Agent 在限制条件下自主完成任务。

未来几年,很可能会出现越来越多专门针对“视频 + 3D + 语音 + Agent”的复合基准:例如完成一次 XR 设备安装指导,从根据 3D 模型生成安装步骤,到通过视频识别用户当前安装进度,再通过语音互动纠正错误;或者完成一次远程设备巡检,从语音接单开始,到远程视频巡视和 3D 标注,再到生成巡检报告和维护计划。届时,我们评价 GPT-5.1、Claude Opus 4.5 和 Gemini 3 的标准,可能不再是“谁在某个单项上更强”,而是“谁在完整剧情里更像一个靠谱的同事”。

结语:2025 年之后,多模态不再是“加个图片接口”那么简单

回到文章标题的那句话——“为什么 2025 年大家都在卷‘视频 + 3D + 语音’?”——现在你大概已经有了自己的答案。因为这是一个同时被技术、市场和产品逻辑三重推动的必然结果:视频是现实世界最丰富的数据载体,3D 是下一代空间计算与 XR 的基础设施,语音是人类最自然的交互方式;而 GPT-5.1、Claude Opus 4.5、Gemini 3 这些最新一代通用多模态模型,恰恰提供了一个可以把这三者统一起来的推理与决策大脑。

在未来很长一段时间里,“多模态能力”会逐渐从一个 Marketing 关键词变成一个工程上的刚性要求:没有视频理解,你很难在自动驾驶、安防和内容平台上竞争;没有 3D 空间感知,你在 XR、数字孪生和工业场景里的天花板会非常低;没有高质量的语音接口,你就很难真正释放面向非技术用户的泛用 AI 价值。而如果你要在这些领域里站稳脚跟,就几乎无法绕过 GPT-5.1、Claude Opus 4.5 和 Gemini 3 这样的最新旗舰模型——它们已经把“视频 + 3D + 语音”的组合写进了自己的产品基因里。

对正在写 优快云、搭 Side Project 或在公司里推进多模态项目的你来说,也许最实际的一点是:不要再把多模态理解当成“给聊天机器人加一个看图接口”,而要从“我能不能做出一个真的看得懂视频、理解三维空间、听得懂人话的数字合伙人”这个目标往回推。 当你沿着这个目标反推架构和技术选型时,很多“为什么 2025 年大家都在卷视频 + 3D + 语音”的疑问,就会自然变成一条条具体可执行的工程路线图。

232

232

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?