目录

一、多智能体系统的前世今生:从 DAI 到 Agentic AI

二、LLM 推动的 “卷土重来”:从单一 Agent 到 Agent 社会

九、未来趋势:从 “Agent 社会” 到复杂系统与社会模拟

近两年,如果你稍微关注一下 “Agentic AI”“多智能体系统” 这些关键词,就会发现它们的身影几乎无处不在:从学术界关于 LLM 多智能体的大型综述论文,到 GitHub 上 AutoGen、AutoGPT、crewAI 等框架的疯狂涨星,再到 Gartner、各类市场研究机构关于 “Agentic AI 市场 CAGR 35%+、2030 年后规模上千亿美元” 的预测,仿佛所有人都在说:未来不是一个大模型单打独斗,而是一群模型作为 “智能体社会” 一起协作。(arXiv)

但是,真的让一群 AI 合作就一定更靠谱吗?多智能体系统(Multi-Agent Systems, MAS)其实一点都不新,从上世纪八九十年代的分布式人工智能(Distributed AI)到 2000 年之后的工业 MAS 平台,再到今天基于大语言模型(LLM)的多 Agent 编排,技术栈和应用场景都发生了翻天覆地的变化。(arXiv) 本文试着从历史、框架、真实数据和工程落地的角度,系统梳理 “多智能体系统卷土重来” 背后的逻辑,并用来自论文、市场报告和 GitHub 的真实数字,帮你判断:在你的业务里,让一群 AI 合作,到底值不值得。

一、多智能体系统的前世今生:从 DAI 到 Agentic AI

如果把 “一个大模型 + 一堆工具” 看作是 2023 年之后的主流范式,那么多智能体系统其实早在这一波浪潮之前几十年就已经在学术界生根发芽。多智能体系统最朴素的定义,就是一组在同一环境中互动、既可能合作也可能存在冲突的自主智能体,它们通过通信和协作解决单一智能体难以完成的复杂问题。(arXiv)

在八九十年代,分布式人工智能(DAI)与 MAS 主要聚焦于理论与基础机制:如何让多个智能体在共享或部分共享的环境中进行协调、谈判、形成联合意图(joint intentions),以及如何在没有全局控制器的情况下实现鲁棒的全局行为。(arXiv) 进入 2000 年以后,多智能体系统开始在更接地气的场景中崭露头角,例如建筑与土木工程中的协同调度、能源系统中的需求响应、以及交通系统中的去中心化信号控制。(PMC)

为了让历史脉络更清晰,我们可以把多智能体和 Agentic AI 相关里程碑放在一张简单的时间线里,注意这里只摘选与 “多智能体 + Agent” 密切相关的节点,并非完整 AI 发展史。

表1 多智能体与 Agentic AI 的时间线概览(节选)

| 时间 | 关键里程碑 | 说明与来源 |

|---|---|---|

| 1950s–1960s | 图灵测试、ELIZA | 为 “机器能否像人一样交互” 提供了最早的概念背景。(维基百科) |

| 1980s | Distributed AI 与 “Intelligent Agents” 概念走红 | 多智能体与 DAI 社区形成,对自主 Agent 的结构与通信进行系统化研究。(arXiv) |

| 1990s | Joint intentions、协同规划等 MAS 理论 | 在工业协同、调度等场景中探索 MAS 的协调与资源分配机制。(PMC) |

| 2010s | SURTRAC 等去中心化交通信号控制系统 | 以交叉口为 Agent、采用分布式调度的城市交通控制系统落地。(ri.cmu.edu) |

| 2018–2022 | 能源、交通等领域的大规模 MAS 应用综述 | 出现大量系统性评估 MAS 在能耗优化、资源调度方面效果的论文。(MDPI) |

| 2023 起 | LLM-based Agents & Multi-Agents 爆发 | 大模型具备强泛化和规划能力,多智能体从规则与强化学习转向 LLM 驱动。(arXiv) |

| 2024–2025 | 系统性 LLM-MA、Agentic AI 综述与市场报告 | 多篇综述聚焦 LLM 多智能体,市场研究机构预测 Agentic AI 市场 35%+ CAGR。(arXiv) |

从这张表可以看出,多智能体系统并不是因为大模型才突然出现的,而是先在高度结构化的场景,例如交通、能源、物流等领域,通过基于规则或强化学习的 Agent 实现了分布式控制,然后才在 LLM 出现后长出 “会聊天、会写代码、会理解自然语言任务” 的全新形态。大模型的到来,让 Agent 不再局限于预定义策略,而是具备了自然语言理解与复杂推理的能力,从而可以把传统 MAS 难以接入的业务流程和知识抽象也纳入多智能体协作的范围。

二、LLM 推动的 “卷土重来”:从单一 Agent 到 Agent 社会

真正让 “多智能体卷土重来” 的,是一系列关于 LLM-based Multi-Agents 的综述工作和开源项目,把原本分散在各个应用中的尝试抽象成了一个清晰的研究与开发范式。2024 年 Guo 等人在 IJCAI 发表的《Large Language Model based Multi-Agents: A Survey of Progress and Challenges》对 126 篇相关论文进行了系统性梳理,覆盖了从任务求解(problem solving)、世界模拟(world simulation)到多智能体沟通机制和评测基准等多个方面,并配套维护了一个 GitHub 仓库对 LLM-MA 论文进行持续分类更新。(arXiv)

随后,Li 等人从工作流与基础设施视角,对 LLM 多智能体的整体架构进行了进一步梳理,强调了 Agent 池(agent pool)、任务分解器、调度器与执行 Agent 之间的协同关系,指出目前主流系统在任务分解、记忆管理和评测方法上仍存在明显短板。(SpringerLink) Tran 等人的《Multi-Agent Collaboration Mechanisms: A Survey of LLMs》则把注意力集中在协作机制本身,从参与者结构、合作/竞争/混合(coopetition)关系、中心化与分布式结构、角色分工与通信协议等维度构建了一个多维度的协作框架。(arXiv) 与此同时,Zhang 等人则更广义地讨论了多 AI Agent 协作系统在复杂任务执行中的潜力与挑战,强调通过多 Agent 协作可以显著降低复杂任务的执行难度并提升效率。(ACM Digital Library)

这些工作共同传达了一个强烈的信号:在大模型时代,多智能体不再只是交通信号灯或微电网中的抽象 “Agent”,而是可以被看作一群具备语言理解、工具使用、代码生成和一定程度元认知能力的 “大模型角色”,它们通过自然语言进行对话、规划和互相评审,从而在世界模拟、软件开发、数据分析甚至科学研究等复杂领域中,形成一种类似 “人类团队” 的协作形态。(PMC)

为了把这些研究工作放在一个更清晰的坐标系里,我们可以用一张表来对比几篇代表性的 LLM 多智能体综述。

表2 LLM 多智能体相关代表性综述(节选)

| 论文 | 发表时间与场合 | 主要关注点 | 覆盖范围亮点 |

|---|---|---|---|

| Large Language Model based Multi-Agents: A Survey of Progress and Challenges | 2024 年,IJCAI Survey Track & arXiv(arXiv) | 对 126 篇 LLM-MA 论文进行系统梳理,总结典型场景(任务求解、世界模拟等)、Agent 画像与通信机制,以及常用数据集与评测基准。 | 强调 LLM-MA 相比单 Agent 的优势与挑战,配套维护 GitHub 论文库,有助于追踪论文数量随时间的增长趋势。(GitHub) |

| A Survey on LLM-based Multi-Agent Systems: Workflow, Infrastructure, and Challenges | 2024 年,期刊文章(SpringerLink) | 从工程视角拆解 LLM-MA 的整体工作流,包括 Agent 池构建、任务分配、执行与反馈循环。 | 更关注系统工程与基础设施层面,如调度、资源管理与复现场景,对实际搭建多 Agent 平台的开发者非常友好。 |

| Multi-Agent Collaboration Mechanisms: A Survey of LLMs | 2025 年,预印本与会议投稿(arXiv) | 专注于 LLM 多智能体中的协作机制,从参与者类型、协作/竞争关系、组织结构与协调策略等维度构建框架。 | 为后续设计更复杂的协作协议(如角色辩论、博弈式决策)提供了理论模板,帮助理解多 Agent 之间 “怎么合作才有效”。 |

| A Survey of Multi-AI Agent Collaboration: Theories, Frameworks and Applications | 2025 年,ACM 会议(ACM Digital Library) | 广义地讨论多 AI Agents 协作系统在复杂任务中的作用,涵盖传统 MAS 与 LLM 驱动 Agent。 | 提出多 AI Agent 协作系统能够显著降低复杂任务执行难度、提高效率,并强调协调机制与可解释性的重要性。 |

从这些综述可以看出,LLM 多智能体的研究重点大致从三个主轴展开:一是如何利用大模型的通用能力赋予每个 Agent 某种专长和个性;二是如何在系统级别组织与协调大量 Agent,使其在复杂任务中既不过度冗余又具有足够的冗余容错;三是如何通过评测基准、世界模拟和真实应用验证 “一群大模型合作” 是否真的比 “一个大模型超努力” 更有性价比。

三、为什么 “一群 AI 合作” 在很多场景里确实更靠谱?

判断多智能体是否 “更靠谱”,不能只看概念,还要看真实的数据和落地案例。在传统 MAS 领域,已有大量实证工作显示,在交通、物流、能源等典型复杂系统中,引入多智能体往往可以带来可观的性能提升,尤其在需要分布式决策与局部自治的环境中更为明显。能源优化综述表明,多智能体系统在需求响应、人类行为模拟和无线传感器网络管理等方面的应用,已经成为能耗优化研究中的重要方向之一。(MDPI) 在土木工程与资源分配领域,Binyamin 等的综述则总结了 MAS 在复杂工程问题分解中的优势。(PMC)

更直观的数据来自交通与物流场景。Jia 等人在 2025 年的研究中提出了一种时空多智能体强化学习框架,用于大规模交通信号控制,实验结果表明与基线方法相比,这一框架可以在不同路网规模下将车辆等待时间平均降低约 25%。(MDPI) 在多模式交通仿真研究中,Elbery 等人只控制了约 10% 的交通流量,就实现了总旅行时间 40% 的节省、燃料消耗 18% 的降低以及平均延误 46% 的减少,这些改善都源自于基于多智能体的细粒度交通控制与路由优化。(scitepress.org) 在物流与路径规划方面,Moreno 等人的多智能体优化研究则显示,通过智能体驱动的布线路径优化,可以将总行驶距离减少约 38%,相应地把总成本从 116.50 欧元降至约 71.21 欧元,司机数量也从三人减至两人。(MDPI)

这些数字本身已经构成了对 “多智能体是不是只是概念游戏” 的有力回应。我们可以把几个典型场景中的具体收益整理成一张表,更直观地感受一下多智能体在现实系统中的作用。

表3 典型多智能体应用场景及量化收益(节选)

| 场景 | 研究与年份 | 指标与结果 | 说明 |

|---|---|---|---|

| 大规模交通信号控制 | Jia 等,多智能体深度强化学习框架,2025(MDPI) | 平均车辆等待时间降低约 25% | 使用多智能体时空强化学习协调多路口信号,相比传统基线实现显著排队时间下降。 |

| 多模态交通网络优化 | Elbery 等,大规模 Agent-Based 多模态建模,2019(scitepress.org) | 总旅行时间节省约 40%,燃料消耗降低约 18%,平均延误减少约 46% | 仅控制约 10% 的车辆,就通过 Agent 化的信号控制与路由策略实现了显著系统级收益。 |

| 物流与路由优化 | Moreno 等,多智能体仿真与优化,2025(MDPI) | 总行驶距离减少约 38%,成本从 116.50 欧降至约 71.21 欧 | 基于 Agent 的调度系统在配送网络中优化路径与车辆分配,减少司机数量并降低成本。 |

| 能源优化与负载管理 | González-Briones 等,能源优化 MAS 综合评述,2018(MDPI) | 在需求响应、建筑能耗与 WSN 管理等子领域持续取得能耗降低与效率提升 | 虽然具体百分比因场景而异,但论文系统回顾了 MAS 在多个能源子领域带来的节能效果。 |

| 资源分配与调度 | Binyamin 等,资源分配与调度中的 MAS,2022(PMC) | 在建筑施工、项目调度等场景中提升资源利用率并降低延误 | MAS 将大型工程问题分解给多个智能体,使得协同调度问题更易求解。 |

这些结果之所以重要,是因为它们说明在高度复杂、动态且具有空间分布特性的系统中,试图构建一个单一、全知全能的中心控制器往往既不现实也不鲁棒,而让一群具有局部视角与自治能力的智能体在一定规则下协作,反而更符合系统本身的结构。这也是为什么在大模型时代,当我们开始考虑 “让 Agent 们自己规划任务、相互审查代码、一起读论文写报告” 时,多智能体的思想会如此自然地回归。

四、大模型多智能体的典型架构与协作模式

在大模型时代,多智能体系统的核心不再只是 “多少个 Agent、怎么发消息” 这样的问题,而是如何利用 LLM 的通用能力组织一群具有明确角色和边界的智能体,让它们在复杂任务上形成一种可控制、可监控、可评测的协作工作流。以微软的 AutoGen 框架为例,它本质上提供了一套构建 “多 Agent 对话与协作” 的编程框架,使得开发者可以以 Python 对象的形式定义 Agent,指定其背后调用的 LLM、可用工具和人类参与方式,并通过对话脚本的方式定义 Agent 间的协作模式。(GitHub Microsoft)

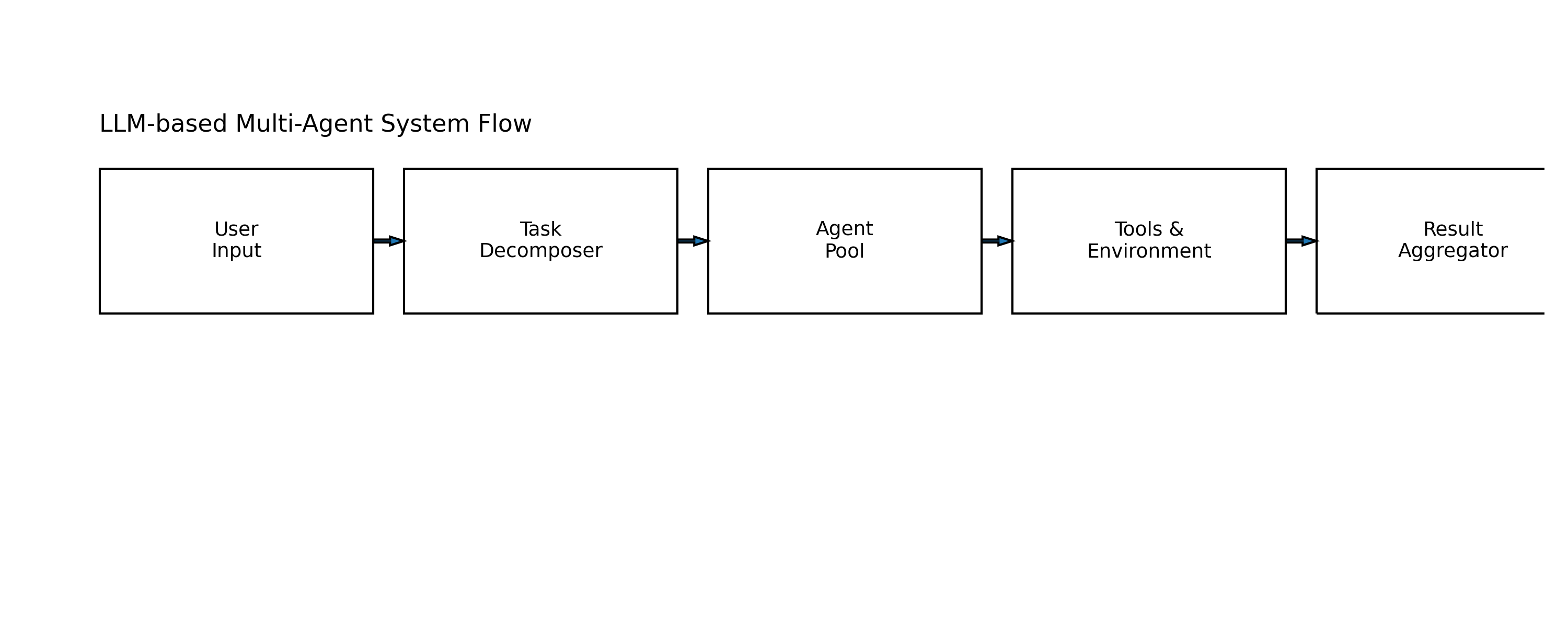

结合 Guo 等人和 Li 等人的综述,我们可以抽象出一个相对通用的 LLM 多智能体架构,大致由以下几个核心部件构成:首先是任务入口与调度层,负责接收来自用户或上游系统的自然语言任务、结构化请求或外部事件,并将其分解为可由 Agent 处理的子目标;其次是 Agent 池,每个 Agent 通常都拥有一个具体角色,例如 “规划者”“代码执行者”“检索与证据收集者”“评审者”“集成与报告生成者”等,它们可能共享同一个基础 LLM,也可能结合不同模型或工具;然后是内外部记忆系统,用于在长链路对话与多回合协作过程中存储中间结论、检索外部知识、记录环境状态;最后则是评估与安全层,用于检测协作过程中可能出现的幻觉、工具误用、目标漂移等问题,并在必要时引入人类反馈或中断执行。(arXiv)

如果把协作模式再细化一点,可以从角色结构、决策方式与通信机制三个维度进行区分。角色结构方面,既可以采用传统的软件工程分工,如 PM Agent、Developer Agent、Reviewer Agent,也可以采用更细粒度的专家角色,例如专门负责日志分析、风险评估或对齐检查的 Agent。决策方式上,有的系统采用集中式协调者 Agent 进行任务分发与结果整合,有的系统则倾向于采用去中心化协作,让多个 Agent 通过辩论、投票或博弈过程共同决定最终行动。通信机制则可以从简单的顺序对话,到引入共享黑板、事件总线甚至显式的消息路由中间件,支持更复杂的异步协作。

我们可以用一张表把当前研究中常见的 LLM 多智能体协作范式做一个概念上的对比,帮助在工程实践中做出更有针对性的设计选择。

表4 常见 LLM 多智能体协作范式概览

| 协作范式 | 典型特征 | 典型工作 & 框架 | 适用场景 |

|---|---|---|---|

| 角色分工式协作(Role-based Collaboration) | 明确划分不同 Agent 的角色与职责,通过中心调度或工作流引擎分配任务。 | AutoGen 多 Agent 模式、CrewAI 的 “Crew” 编排,以及多个代码/数据分析 Agent 系统中的 PM–Dev–Reviewer 模式。(GitHub Microsoft) | 软件开发、数据分析、文档撰写等流程清晰、可拆分的任务。 |

| 辩论与博弈式协作(Debate / Deliberation) | 多个 Agent 从不同视角对方案进行辩论或博弈,通过投票或裁决器决定最终行动。 | Cognitive architectures for language agents、Chain-of-Agents 等强调推理与审辩的工作。(PMC) | 需要多角度论证、对安全性和可靠性要求较高的决策任务,如安全评估、法律与合规审查。 |

| 自组织与涌现式协作(Emergent Collaboration) | Agent 集合在较少显式规则下通过交互自发形成结构与分工,强调社会模拟与行为涌现。 | LLM-MA 综述中总结的世界模拟与社会模拟类系统,例如虚拟城镇居民、多主体对话社区。(arXiv) | 社会模拟、行为研究、虚拟世界构建等需要观察涌现行为的研究场景。 |

| 层次化规划与执行(Hierarchical Planning & Execution) | 高层 Agent 负责长期规划与任务分解,底层 Agent 负责具体行动与工具调用。 | 多数工作流型 LLM-MA 系统、部分代码与测试 Agent 框架中的规划–执行–评审三层结构。(SpringerLink) | 长周期、多步骤的复杂任务,例如端到端应用开发、长周期运营优化与 A/B 实验编排。 |

当你在工程实践中考虑 “要不要用多 Agent” 时,先判断你的问题是否更像是一个需要分工协作的项目,而不是单一函数调用;如果答案是肯定的,那么在上述几种协作范式中挑选一种或组合几种,往往会比简单堆更多的 “System Prompt + Tools” 更有结构感,也更容易演化和维护。

五、开源多智能体框架生态与 GitHub 真实数据

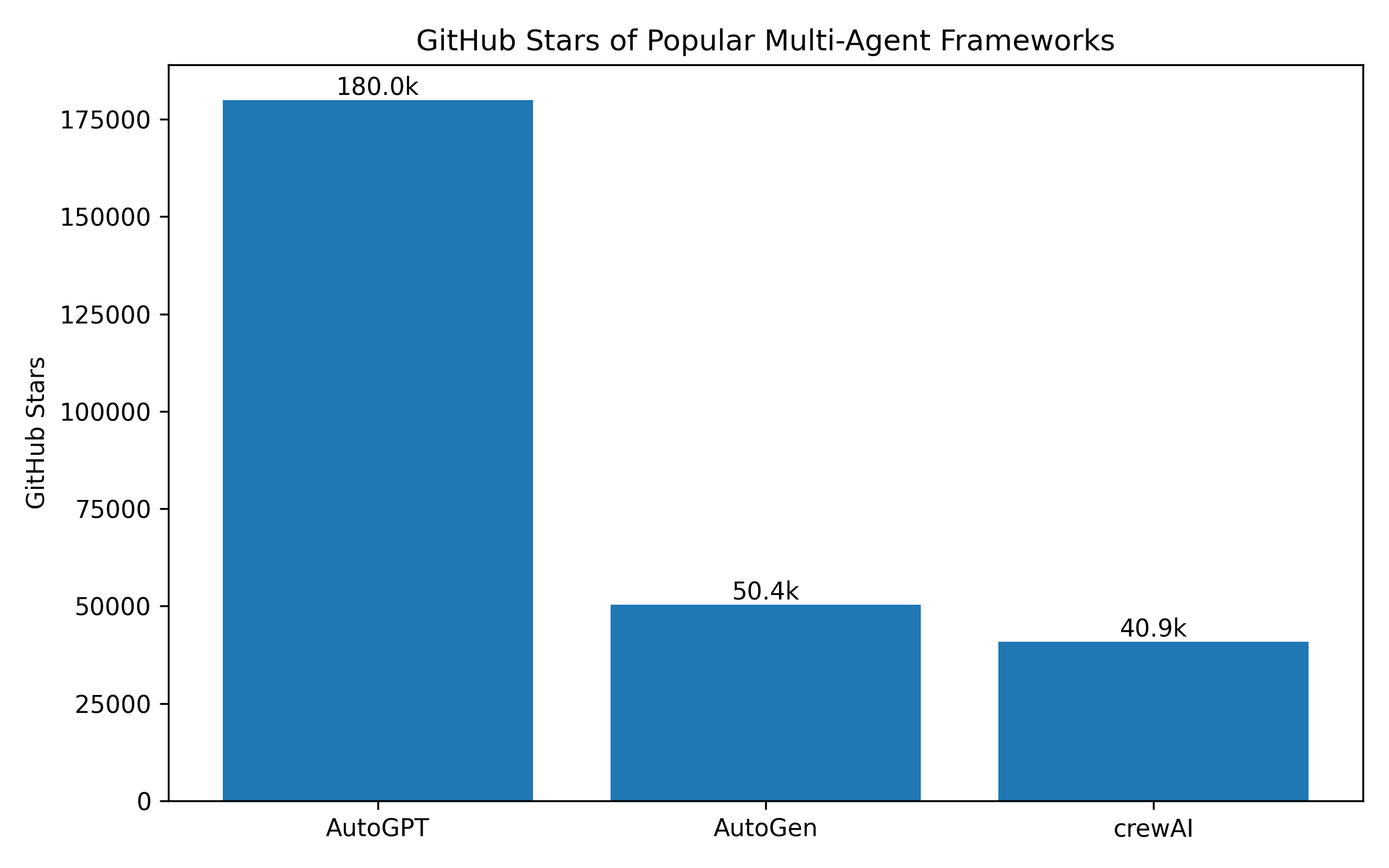

要把概念落地为可运行的系统,开源框架的生态状况是非常关键的一环。当前围绕 LLM 多智能体的开源框架非常丰富,其中讨论度和使用度较高的包括微软的 AutoGen、早期引爆 “自主 Agent” 概念的 AutoGPT,以及强调 “角色扮演团队” 的 crewAI 等。

AutoGen 被微软官方描述为 “用于构建 AI Agents 并促进多 Agent 协作的开源编程框架”,可以让多个 Agent 相互对话,通过 LLM、工具调用以及人类参与的不同组合模式来解决任务。(GitHub Microsoft) 根据 2025 年 10 月的更新讨论,AutoGen 项目在两年间完成了 98 次发布、3776 次提交和 2488 个 Issue 处理,在 GitHub 上获得了约 5.04 万颗星。(GitHub) AutoGPT 则是 2023 年最早引爆 “自主任务执行” 话题的项目之一,在其 GitHub 仓库中可以看到到 2025 年时 Star 数已达到约 18 万,Fork 数约 4.62 万。(GitHub) CrewAI 作为一个强调角色扮演与团队协作的多智能体框架,在 GitHub 主仓库上拥有约 4.09 万颗星,官方站点则以 “40k+ Stars”“60% 的财富 500 强公司使用 CrewAI” 来介绍其生态影响力。(GitHub)

为了更直观地对比这些框架的生态状况和定位,我们可以把核心信息整理为如下表格,并在文末给出对应的 Python 绘图代码,把这些 Star 数可视化为英文标签的柱状图。

表5 代表性 LLM 多智能体开源框架对比(基于公开数据)

| 框架 | 主要定位与特征 | GitHub Star(约) | 典型使用场景与生态 |

|---|---|---|---|

| AutoGPT | 早期自主 Agent 平台,强调从自然语言目标出发自动生成子任务并循环执行;以 “展示 GPT-4 能力极限” 的实验性框架起家。(GitHub) | 约 180k Star,46.2k Fork(截至 2025 年)(GitHub) | 激发了第一波 Agentic AI 讨论,大量衍生项目与插件围绕其生态形成,适合探索自主任务执行与工作流原型。(NocoBase) |

| AutoGen | 面向研究与工程的多 Agent 编程框架,支持可配置 Agent、对话模板、多轮协作与人类在环;强调 “像 PyTorch 之于深度学习” 的 Agentic Infra。(GitHub Microsoft) | 约 50.4k Star(社区更新讨论给出的数据,2025 年 10 月)(GitHub) | 广泛用于科研原型和企业内部的多 Agent 应用开发,如代码审查助手、文档分析流水线等,同时被诸如 Q-Star RL Agent 框架与 Azure “Dream Team” 方案所采用。(GitHub) |

| crewAI | 强调角色扮演与团队编排的多 Agent 框架,用 “Crew” 的概念描述一组协作 Agent,通过角色设定与工具集成实现业务流程自动化。(GitHub) | 约 40.9k Star(GitHub)、官网宣称 “40k+ Stars”(GitHub) | 在营销自动化、内容生产、科研助理等领域形成了活跃的社区,同时也出现了不少实战复盘与踩坑经验分享。(Medium) |

六、产业侧的多智能体落地:市场规模与采用数据

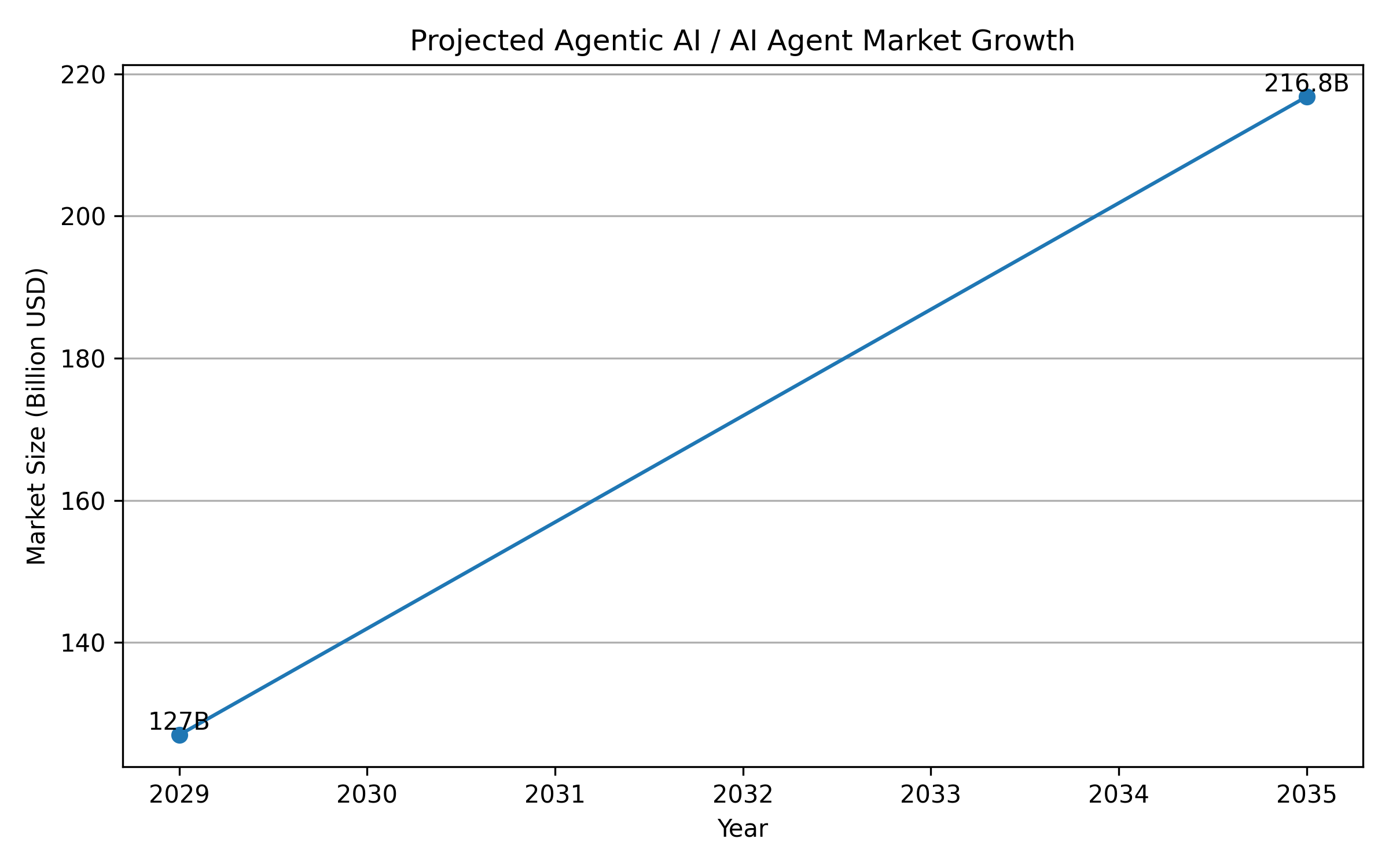

除了学术论文与 GitHub Star 数,产业侧的数据也在悄悄说明多智能体系统正在从概念走向主战场。xCubeLabs 在 2025 年的一篇文章中引用 Gartner 的预测,指出到 2027 年将有超过 50% 的企业采用基于 Agent 的建模来增强决策能力,同时 “AI in multi-agent systems” 市场被预计将在未来几年维持超过 35% 的复合年增长率。([x]cube LABS) GlobalCloudTeam 在 2025 年的一份关于多智能体系统的分析中则提到,更广义的 AI Agent 市场有望在 2035 年达到约 2168 亿美元的规模,并维持大约 35% 的 CAGR,多智能体系统被视作这一增长中的关键组成部分。(GlobalCloudTeam)

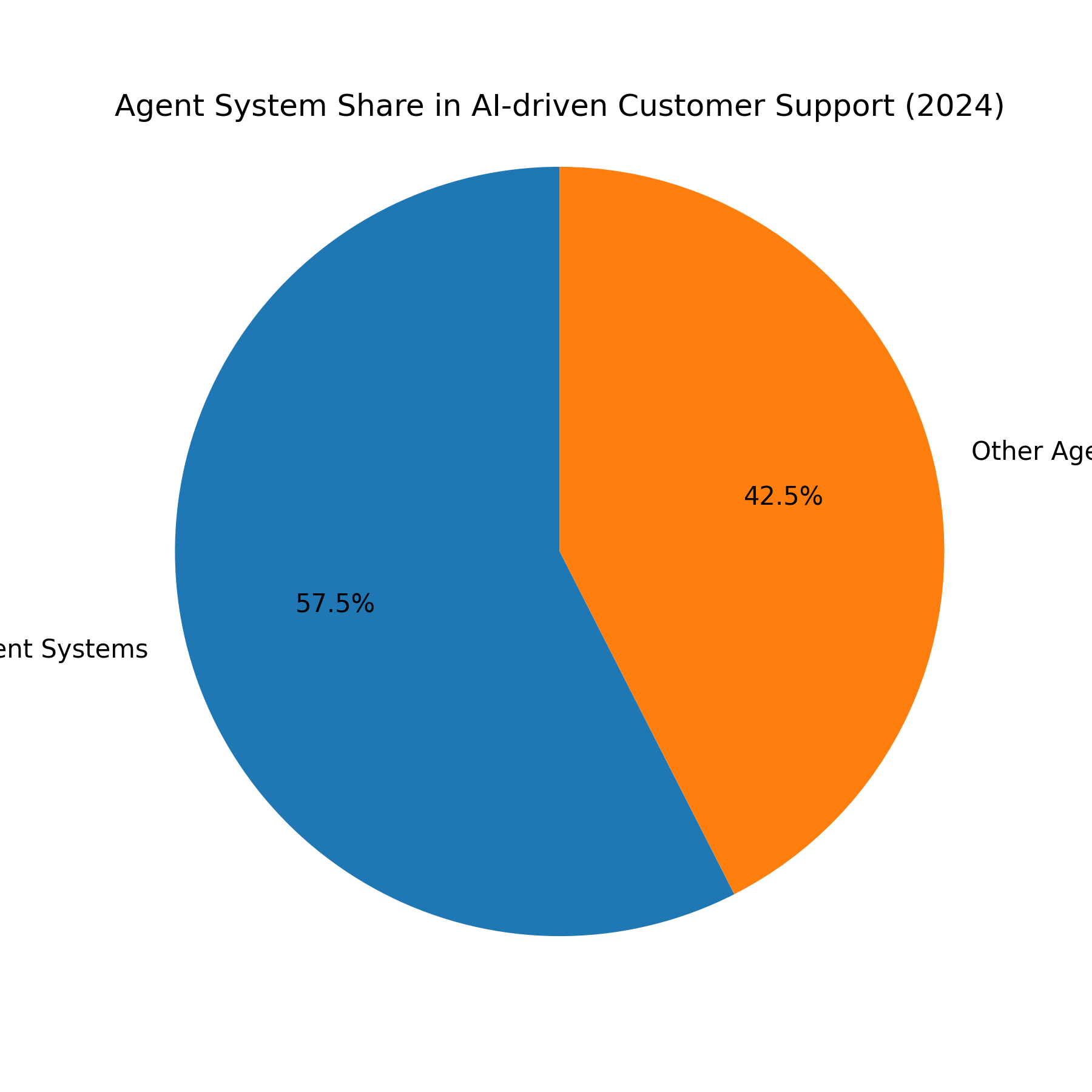

在更细分的垂直市场上,AI 驱动客服 Agent 市场的结构也在发生变化。2024 年的一份市场研究报告显示,在 “AI-driven customer support agents” 市场中,以 Multi-Agent Systems 为代表的多智能体系统细分,在按 Agent 系统类型划分的市场中占据了约 57.5% 的份额,而传统的单 Agent 系统则占据剩余份额。(Market.us) 同一报告还指出,在该市场按行业划分的结构中,银行、金融服务与保险(BFSI)领域占据了约 34.6% 的份额,这在一定程度上反映了多智能体系统在复杂、高合规性要求业务中的吸引力。(Market.us) Precedence Research 对 “Agentic AI in Enterprise Operations” 市场的分析同样强调,在按自治类型(autonomy type)划分的结构中,“协作型多智能体系统”(collaborative multi-agent systems)预计将在预测期内保持显著的增长势头。(Precedence Research)

为了便于在文章中引用这些市场数据,可以把关键数字整理到如下表格中,并在文末使用 Python 代码生成相应的市场占比图和增长趋势图,图内统一使用英文标注。

表6 多智能体与 Agentic AI 市场相关数据(节选)

| 指标 | 数值与时间点 | 场景与来源 | 解释 |

|---|---|---|---|

| 企业采用 Agent-Based Modeling 的比例(预测) | 预计 2027 年超过 50% 的企业将采用基于 Agent 的建模提升决策能力。([x]cube LABS) | xCubeLabs 引用 Gartner 报告,位于 “Multi-Agent System: Top Industrial Applications in 2025” 一文中。 | 表明 Agentic AI 与多智能体方法正从实验室走向主流企业决策流程。 |

| AI in Multi-Agent Systems 市场 CAGR | 未来几年复合年增长率预计超过 35%。([x]cube LABS) | 同一篇文章与相关市场分析报告。 | 说明多智能体本身已被视作独立市场细分,而不仅仅是技术特性。 |

| AI Agent 市场规模与增长 | 预计到 2035 年 AI Agent 市场规模约 2168 亿美元,CAGR 约 35%。(GlobalCloudTeam) | 多智能体作为该市场的重要组成部分,被视作推动增长的关键技术。 | 提示在 Agentic AI 的整体浪潮中,多智能体是 “顺风船”。 |

| AI-driven Customer Support Agents 中的 MAS 份额 | 2024 年,多智能体系统段(Multi-Agent Systems segment)占据该市场约 57.5% 份额。(Market.us) | 按 Agent 系统类型划分的客服 Agent 市场。 | 意味着在复杂客服与自动化服务场景中,多 Agent 已占据主流。 |

| 客服 Agent 市场中 BFSI 行业份额 | 同一研究中,BFSI 行业约占客服 Agent 市场的 34.6%。(Market.us) | 行业维度上的市场分布。 | 金融等强监管行业率先大规模采用多智能体,某种程度上佐证了其在复杂环境中的可靠性。 |

将这些真实的市场数字与前文交通、能源、物流中多智能体带来的性能提升结合起来,可以得到一个比较清晰的图景:在一类类复杂、动态且具有高决策密度的系统中,多智能体已经不仅仅是一个 “技术选项”,而是逐步成为系统架构与商业模式的基础假设之一。

七、现实中的坑:一群 AI 合作也会集体翻车

说多智能体好处的时候,往往容易忽略一个现实:当你把一个大模型系统拆成一群协作 Agent 时,你同时也放大了幻觉、工具滥用、协调失效与成本失控等问题。一些业内博客和实践复盘已经开始坦率地记录这些翻车故事。例如,有作者在对比开源 Agent 框架时就提到,他用 CrewAI 搭了一个 “研究小组”,三个 Agent、五个工具看起来分工明确,但实际运行时负责抓取网页的 Agent 会莫名其妙放弃抓取,负责摘要的 Agent 偶尔忘记调用引用工具,而协调 Agent 在处理较长文档时则直接放弃了任务。(Medium)

这些 “美好流程在现实中瓦解” 的案例很容易让人怀疑多智能体是否真的值得投入,不过如果把视野拉回到学术综述和系统性研究中,会发现这些问题其实早已被系统归纳为多智能体系统的核心挑战。Guo 等人的 LLM-MA 综述中反复强调,如何在多 Agent 协作中控制幻觉传播、确保互评过程不被错误放大,是当前最关键的开放问题之一;(arXiv) Li 等人则指出,目前很多 LLM-MA 系统在基础设施层面严重缺乏观测与调试能力,导致一旦 Agent 链路变长,很难诊断到底是哪一个 Agent 或哪一次工具调用导致了失败。(SpringerLink) 在传统 MAS 领域,类似的问题则表现为联合策略搜索困难、对局部观测高度敏感,一旦通信或感知出现噪声,整体性能就可能出现不可预期的波动。(PMC)

我们可以把这些 “集体翻车” 的根因,连同研究中总结出来的典型挑战一起整理成一个表格,用于在工程实践中做风险对照。

表7 多智能体系统中的典型挑战与失败模式(结合传统 MAS 与 LLM-MA)

| 挑战或失败模式 | 在传统 MAS 中的表现 | 在 LLM 多智能体系统中的新变体 | 相关研究与实践来源 |

|---|---|---|---|

| 协调开销与通信瓶颈 | Agent 数量增加时,协调所需的通信与同步开销急剧上升,导致系统响应时间变长甚至不稳定。(arXiv) | 多个 LLM Agent 之间大量自然语言对话与工具调用,带来高昂的 Token 成本与延迟;缺乏高效的中间状态压缩与摘要机制时,系统容易 “话越说越多、越说越乱”。(arXiv) | 传统 MAS 综述、LLM-MA 综述以及多 Agent 交通控制实践中均有类似讨论。 |

| 幻觉放大与错误共识 | 在部分可观测环境中,多个 Agent 可能基于不完整信息形成错误的共享信念,导致协作策略偏离真实环境。(ResearchGate) | 多个 LLM Agent 之间可能借由互相引用错误结论而形成 “幻觉共识”,且由于语言表达具有说服力,人类更不易察觉。(arXiv) | “Large Language Models Miss the Multi-Agent Mark”等工作明确指出 LLM 在多 Agent 设置下并不总能可靠协调。(arXiv) |

| 工具滥用与计划漂移 | Agent 调用错误的动作或在环境中执行不适当的操作,导致整体效率下降甚至系统不稳定。(PMC) | LLM Agent 在自动规划与工具使用时,可能反复调用不必要的工具、忘记调用关键工具,或在长链路执行中偏离原始目标。(Medium) | Agent 实践复盘与代码生成类 Agent 综述中多次提到 “工具风暴” 与目标漂移问题。 |

| 评估困难与指标缺失 | 多智能体系统的性能受环境设置、Agent 策略与交互结构共同影响,很难用单一指标全面衡量。(MDPI) | LLM-MA 系统往往缺乏统一的基准与协议,不同工作在任务定义、提示设计和 Agent 数量等方面差异巨大,导致实验结果难以比较和复现。(arXiv) | 多篇综述都把评测与基准构建列为首要开放问题之一。 |

| 安全与对齐风险 | 各 Agent 若被错误配置或遭受攻击,可能在分布式系统中放大安全漏洞或对抗行为。(PMC) | 当多个 LLM Agent 在复杂任务上协作时,单个 Agent 的越权行为或 Prompt 注入攻击可能通过协作链路传播,引发系统级风险。(PMC) | 关于 Agentic AI 在安全与治理方面的讨论越来越多,特别是当 Agent 涉及自动决策与执行时。 |

从工程视角来看,承认并正视这些挑战,比幻想 “多智能体可以自动解决所有问题” 更重要。只有认识到多 Agent 带来的可靠性提升与系统复杂度增加是并存的,我们才能在设计架构时有意识地引入监控、调试与人类在环机制,避免从 “一个不稳定 Agent” 升级成 “一群不稳定 Agent”。

八、工程视角:如何设计一个更靠谱的多智能体系统?

从前面的论述可以看出,多智能体在复杂任务中的优势主要来源于三个方面:分治与专业化、分布式鲁棒性以及与外部复杂环境结构的自然匹配。要把这些优势真正变成系统层面的收益,而不是新的复杂性负担,需要在工程设计层面做一些具体而细腻的取舍。

首先是角色建模与任务分解的问题。Li 等人关于 LLM-MA 工作流的综述指出,很多系统的失败根源在于任务分解过于粗糙或过于细碎,两种极端都会导致 Agent 难以发挥专长,要么互相抢活、要么陷入无休止的协调。(SpringerLink) 因此在实际设计中,与其一开始就造一个 “十几个人类岗位” 的 Agent 大团队,不如先从三到四个角色清晰、信息边界明确的 Agent 开始,例如:负责需求理解与任务规划的 Planner Agent、负责检索与证据收集的 Researcher Agent、负责执行与代码/工具调用的 Executor Agent,以及负责复核和对齐的 Reviewer Agent。这样的结构既能够体现专业化,又不会让协调开销失控。

其次是环境建模与状态管理。Guo 等人指出,很多 LLM-MA 系统把环境(包括数据库、外部 API、文档集合)和 Agent 内部的记忆、计划混在一块,导致 Agent 很难区分 “世界发生了什么” 与 “我想做什么”,从而在长链路任务中产生规划漂移。(arXiv) 在工程实践中,一个常用的做法是引入显式的 “世界状态存储” 与 “Task Board”,前者记录客观状态,例如数据库的变化、外部系统的响应;后者记录任务结构与当前进度,例如子任务列表、每个子任务的负责人 Agent 和当前状态。这样一来,每个 Agent 在决策时都可以明确区分自己是基于世界状态还是基于任务板进行推理。

第三是通信协议与可观测性。传统 MAS 研究强调显式的通信协议与消息格式,而很多 LLM-MA 系统则直接使用 “自然语言对话” 作为唯一协议,这虽然在开发体验上非常轻松,但在调试与监控时往往会变得非常痛苦。参考 AutoGen 等框架的实践,可以把 Agent 间的对话拆成 “人类可读的自然语言 + 机器可解析的结构化元数据” 两部分,例如在消息中显式标注这是 “计划更新”“工具调用请求” 还是 “异常报告”,并在日志系统中对这些结构化信息进行汇总与可视化。(GitHub Microsoft)

最后是评测与持续改进。前文提到的多篇综述都强调,缺乏统一的评测协议是当前多智能体研究最大的痛点之一。(arXiv) 在工程上,一个相对可行的策略是:为每一个重要任务定义一组 “多维指标”,例如准确性、覆盖度、用时与成本;在每次 Agent 流水线执行后记录这些指标,并将其与基线(如单 Agent 系统或传统自动化脚本)进行对比。借助这种长期的数据沉淀,可以逐步判断 “一群 AI 合作” 到底有没有在你的具体场景中带来实质收益,而不是仅仅停留在概念上的兴奋。

九、未来趋势:从 “Agent 社会” 到复杂系统与社会模拟

从更长远的视角来看,多智能体系统与 Agentic AI 的结合,会把 AI 从 “单点智能工具” 推向一种更接近复杂系统的形态。除了前文提到的任务求解和运营优化场景外,越来越多的工作开始把 LLM 与 Agent-Based Modeling(ABM)结合起来,用于模拟复杂社会、经济与技术系统中的行为与反馈。例如,有研究探讨如何利用 LLM 驱动的 Agent 取代传统专家权重机制,在多准则决策中通过多 Agent 协作生成更贴近现实的权重分配;(journalwjarr.com) 也有工作指出,面对类似 “Corrupted Blood” 网上事件这样的复杂社会涌现现象,只有 Agent-Based 模型才能捕捉其中的非线性与多样化行为,从而为预测 AI 对社会的影响提供更可靠的工具。(有效利他主义论坛)

另一方面,一些研究则对目前 LLM 在多智能体环境中的表现持更加谨慎的态度。例如 2025 年的《Large Language Models Miss the Multi-Agent Mark》指出,在许多需要复杂协调与共享信念的设置中,现有大模型驱动的 Agent 组合并没有表现出超越传统算法的稳定优势,反而暴露出对提示设计敏感、易受对抗性干扰以及难以在长期任务中保持一致性的缺点。(arXiv) 这提醒我们,多智能体并不是一个可以一劳永逸解决所有问题的魔法公式,而是一个需要和传统控制理论、博弈论、分布式系统工程共同打磨的复杂系统工程方向。

对工程实践者来说,或许更务实的态度是:把多智能体视为一种在特定复杂任务上具有优势的架构模式,而不是 “必须使用的新潮技术”;在那些自然适合分工协作、环境高度分布式、需要多视角审查的任务中,多 Agent 往往能提供可靠性和可扩展性上的优势;而在简单直线型任务或强实时任务中,一个优化良好的单 Agent 或传统系统仍旧是更稳妥的选择。

结语:什么时候该让一群 AI 合作?

回到本文标题提出的问题:“多智能体系统卷土重来:让一群 AI 合作是不是更靠谱?” 从本文梳理的历史与数据可以看到,在交通、能源、物流等复杂系统里,多智能体早已用实实在在的 25% 等级的等待时间降低、40% 的旅行时间节省、数十个百分点的能耗与成本下降证明了自己。(MDPI) 在 LLM 时代,这种优势正逐步扩展到知识密集与决策密集的行业,市场报告中不断抬升的采用比例和增长曲线,则表明多智能体已经从学术边缘走向商业核心。([x]cube LABS)

然而,多智能体并非万灵药。它所带来的协作能力与鲁棒性,是以系统复杂度、调试难度与安全风险为代价换来的。如果没有清晰的角色划分、完善的状态管理、合理的通信协议和充分的监控与评测,单 Agent 的问题并不会因为 Agent 数量的增加而自动消失,反而可能以更复杂的形态出现。真正靠谱的多智能体系统,往往不是 “把所有东西 Agent 化” 的结果,而是在充分理解业务结构和系统约束后,有节制、有设计地引入多 Agent 协作,让它们在最适合的地方承担最有价值的职责。

如果你正准备在项目里尝试多智能体,不妨从一个小范围、可观测、可对比基线的场景开始,例如把原本单 Agent 的 “代码审查 + 测试生成” 流水线拆成规划、实现与复核三个专长 Agent;或者把复杂报告写作拆成数据搜集、结构规划与语言润色三个角色。结合本文汇总的真实论文数据与市场数字,再配合文末的可视化代码,你可以用更定量的方式回答那个关键问题:在你的具体场景里,让一群 AI 合作,到底是不是更靠谱。

624

624

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?