✅作者简介:热爱数据处理、建模、算法设计的Matlab仿真开发者。

🍎更多Matlab代码及仿真咨询内容点击 🔗:Matlab科研工作室

🍊个人信条:格物致知。

🔥 内容介绍

马尔可夫决策过程(Markov Decision Process, MDP)是强化学习的核心问题建模框架,它描述了一个智能体在环境中进行决策并获得奖励的过程。求解MDP,即找到一个最优策略,使得智能体能够最大化其累积奖励。深度Q网络(Deep Q-Network, DQN)作为一种基于深度学习的强化学习算法,为有效求解高维状态空间和动作空间的MDP问题提供了强大的工具。本文将深入探讨基于DQN求解MDP问题的控制策略,涵盖算法原理、改进方法以及实际应用中的挑战与前景。

一、 MDP问题的基本框架

一个MDP可以定义为一个五元组(S, A, P, R, γ),其中:

-

S表示状态空间,包含所有可能的系统状态;

-

A表示动作空间,包含智能体在每个状态下可执行的所有动作;

-

P(s'|s, a)表示状态转移概率,表示在状态s下执行动作a后转移到状态s'的概率;

-

R(s, a)表示奖励函数,表示在状态s下执行动作a后获得的立即奖励;

-

γ表示折扣因子 (0 ≤ γ ≤ 1),用于衡量未来奖励的相对重要性。

MDP的目标是找到一个最优策略π*(s),该策略能够最大化从初始状态开始的期望累积折扣奖励:

V*(s) = max<sub>π</sub> E<sub>π</sub>[Σ<sub>t=0</sub><sup>∞</sup> γ<sup>t</sup>R(s<sub>t</sub>, a<sub>t</sub>) | s<sub>0</sub> = s]

其中,V*(s)表示状态s下的最优值函数,它代表从状态s开始遵循最优策略所能获得的最大期望累积奖励。

二、 DQN算法原理

DQN算法的核心思想是利用深度神经网络逼近最优Q函数Q*(s, a),该函数表示在状态s下执行动作a所能获得的最大期望累积折扣奖励。DQN通过经验回放机制和目标网络来解决传统Q学习算法中的非平稳目标和相关样本问题。

具体来说,DQN算法的主要步骤如下:

-

初始化: 初始化深度神经网络Q(s, a; θ),其中θ表示网络参数。

-

经验回放: 将智能体与环境交互产生的经验元组(s, a, r, s')存储在一个经验回放池中。

-

采样和训练: 从经验回放池中随机采样一批经验元组,并利用以下目标函数更新网络参数:

L(θ) = E<sub>(s, a, r, s')</sub>[(r + γ max<sub>a'</sub>Q(s', a'; θ<sup>-</sup>) - Q(s, a; θ))<sup>2</sup>]

其中,θ<sup>-</sup>表示目标网络的参数,它定期从Q网络复制参数。

-

策略执行: 根据ε-greedy策略选择动作,即以概率ε随机选择动作,以概率1-ε选择使Q(s, a; θ)最大的动作。

-

重复步骤2-4: 不断地与环境交互、存储经验、更新网络参数,最终逼近最优Q函数。

三、 DQN算法的改进

为了提高DQN算法的性能和稳定性,研究者们提出了许多改进方法,例如:

-

Double DQN (DDQN): 通过使用两个网络分别估计最大动作值和选择动作来减少过高估计问题。

-

Dueling DQN: 将Q函数分解为状态值函数V(s)和优势函数A(s, a),提高了学习效率和样本效率。

-

Prioritized Experience Replay: 优先回放重要的经验元组,提高学习效率。

-

Distributional DQN: 学习Q函数的分布而不是其期望值,提高了算法的鲁棒性。

-

Noisy Net: 在网络中加入噪声,提高探索能力。

四、 实际应用中的挑战与前景

尽管DQN及其改进算法在许多MDP问题上取得了显著成果,但在实际应用中仍面临一些挑战:

-

高维状态和动作空间: 对于具有非常高维状态和动作空间的问题,DQN的学习效率可能较低,甚至无法收敛。

-

样本效率: DQN需要大量的样本才能有效学习,这在某些应用场景中可能难以实现。

-

超参数调整: DQN算法的性能对超参数非常敏感,需要仔细调整。

-

泛化能力: DQN模型的泛化能力可能有限,难以适应新的环境或任务。

未来研究方向包括:更有效的函数逼近方法、更先进的探索策略、更鲁棒的训练方法以及结合其他强化学习算法的混合方法。 例如,将DQN与模仿学习或规划算法结合,可以有效提高样本效率和泛化能力。 此外,将DQN应用于更复杂的现实世界问题,如机器人控制、自动驾驶和资源调度等,也具有广阔的前景。

五、 结论

DQN算法为求解高维MDP问题提供了一种有效的控制策略。 通过不断改进算法和探索新的应用场景,DQN及其改进算法将在强化学习领域发挥越来越重要的作用,推动人工智能技术的进一步发展。 然而,仍然需要解决一些挑战,才能充分发挥DQN的潜力,并将其应用于更广泛的实际问题中。 未来的研究方向应集中于提高算法的样本效率、泛化能力和鲁棒性,并探索其与其他强化学习算法的有效结合。

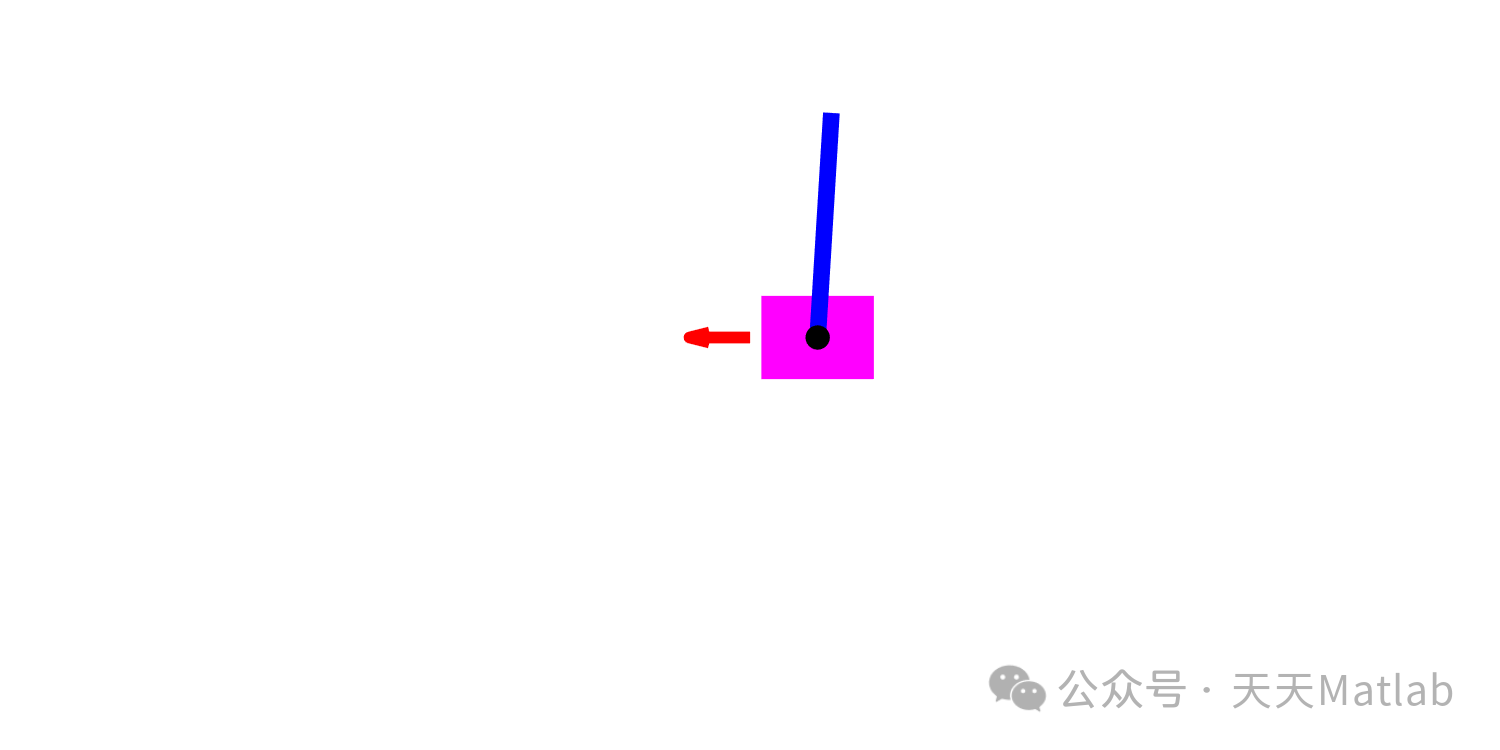

⛳️ 运行结果

🔗 参考文献

🎈 部分理论引用网络文献,若有侵权联系博主删除

本主页优快云博客涵盖以下领域:

🌈 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位

🌈 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

1431

1431

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?