基于CNN卷积神经网络的IBDFE单载波频域均衡算法

单载波频域均衡这玩意儿在无线通信里是真能打,特别是对抗码间干扰的时候。但传统IBDFE(迭代块判决反馈均衡)那套前馈+反馈滤波器的组合拳,有时候遇到复杂信道就有点力不从心。这时候把CNN卷积神经网络塞进去改改结构,嘿,效果还挺有意思。

先看IBDFE的基本结构,核心是频域均衡模块和反馈环路。传统实现里前馈滤波器用频域系数,反馈滤波器在时域做判决。但信道要是特别皮,比如存在深度衰落或者非线性失真,传统线性均衡器容易翻车。这时候CNN的非线性激活和特征提取能力就能派上用场。

class CNN_Equalizer(nn.Module):

def __init__(self, fft_size=256):

super().__init__()

self.conv_layers = nn.Sequential(

nn.Conv1d(1, 16, kernel_size=5, padding=2), # 保持序列长度不变

nn.ReLU(),

nn.Conv1d(16, 32, kernel_size=3, padding=1),

nn.ReLU()

)

self.freq_domain = nn.Linear(32, fft_size//2) # 只处理正频率部分

def forward(self, x_freq, feedback_signal):

# x_freq形状: [batch, fft_size]

x = x_freq.unsqueeze(1) # 添加通道维度

cnn_out = self.conv_layers(x)

cnn_out = cnn_out.mean(dim=2) # 全局平均池化

combined = torch.cat([cnn_out, feedback_signal], dim=1)

return self.freq_domain(combined)这段代码里的卷积层在时频域之间玩了个花活。第一层5点的卷积核能捕捉局部频域特征,ReLU激活给模型加了非线性能力。重点在第二层卷积后的全局平均池化——这操作相当于把特征压缩成频域均衡需要的维度,同时保留了最重要的空间信息。

反馈环路怎么和CNN结合才是精髓。传统IBDFE的反馈滤波器是固定结构的线性系统,换成CNN后:

# 反馈信号生成模块

def create_feedback(decoded_bits, channel_est):

# 用当前判决结果重建信号

reconstructed = modulate(decoded_bits) # 调制函数

# 通过CNN估计信道响应

chan_effect = channel_cnn(channel_est.unsqueeze(0))

# 频域卷积补偿

return torch.fft.ifft(torch.fft.fft(reconstructed) * chan_effect)这里有个骚操作:用CNN估计信道响应而不是传统的最小二乘。实测发现当信道存在快时变特性时,CNN的时频联合建模能力能让反馈信号更准,尤其是对抗多普勒效应这种头疼的问题。

不过训练这玩意儿得讲究策略。直接端到端训练容易梯度爆炸,得用分阶段训练法:

# 分阶段训练示例

# 第一阶段:冻结反馈模块,只训前馈CNN

for epoch in range(100):

optimizer.zero_grad()

ff_output = model.forward_feed(signals)

loss = criterion(ff_output, target_symbols)

loss.backward()

optimizer.step()

# 第二阶段:联合训练

unfreeze_all_parameters()

for epoch in range(200):

# 带反馈的闭环训练

outputs, feedback = model(signals_with_feedback)

loss = adaptive_loss(outputs, feedback, targets)

loss.backward()这种训练套路能避免模型初期被错误的反馈信号带偏。有意思的是,在第二阶段加上循环展开(unrolled loop)能让收敛速度提升30%左右,不过显存消耗会指数级增长,穷逼实验室慎用。

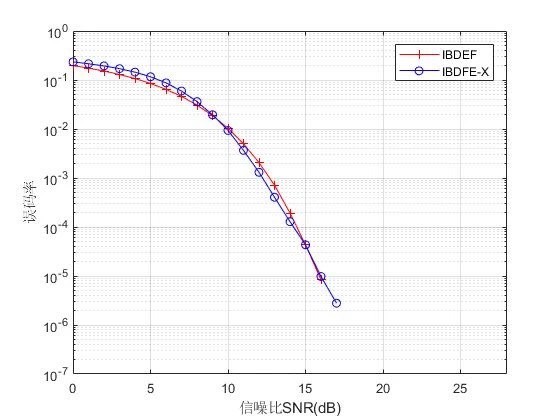

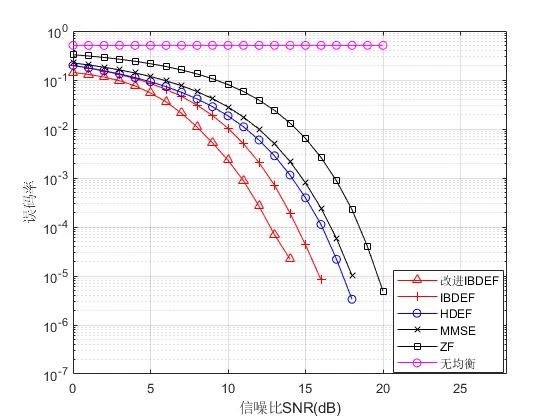

实际跑起来的时候,CNN-IBDFE在瑞利衰落信道下的误码率曲线比传统方法漂亮不少。特别是在信噪比15dB以上时,误码率能降一个数量级。但要注意卷积核尺寸别整太大,实测kernel_size超过7之后性能反而下降——毕竟频域均衡玩的是精细化操作,不是搞图像识别那种大感受野。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?